수행능력 기반 평가에서 합격선 설정 방법: AMEE Guide No. 85 (Med Teach, 2014)

How to set standards on performance-based examinations: AMEE Guide No. 85

DANETTE W. MCKINLEY & JOHN J. NORCINI

서론

Introduction

[합격선 설정Standard setting]은 [일반적인 수행 수준을 충족시키기 위해 필요한 지식과 기술의 수준]을 정의하거나 판단한 다음, [해당 수행능력 기준performancd standard에 해당하는 시험 점수 척도]에서 점수를 식별하는 과정이다. 표준 설정 절차는 직업 또는 교육 영역에 대한 역량의 개념 정의를 제공하고 개념을 운영하기 위해 사용된다. 역량의 개념적 정의를 고려할 때 역량에 기반한 의료교육에서 개발된 기준을 생각해보는 것이 도움이 된다. [이정표 또는 벤치마크] 개발에서 제공되는 기술 정보는 performance standard을 정의하는 데 도움이 될 수 있다.

Standard setting is the process of defining or judging the level of knowledge and skill required to meet a typical level of performance and then identifying a score on the examination score scale that corresponds to that performance standard. Standard setting procedures are employed to provide a conceptual definition of competence for an occupation or educational domain and to operationalise the concept. When considering the conceptual definition of competence, it is helpful to think about the criteria developed in competency-based medical education. The descriptive information provided in the development of milestones or benchmarks (Holmboe et al. 2010) can be helpful in defining the performance standard.

[표준 설정 프로세스]는 [역량]에 대한 [개념적 정의]를 [통과 점수]라고 불리는 [조작적 버전]으로 변환하도록 설계되었다. [합격점수가 적절하다]는 검증은 [시험점수 해석의 타당성]을 뒷받침하는 증거를 수집하는 데 있어 또 다른 중요한 요소이다. 시험에 대한 합격 점수를 결정하기 위한 다양한 접근법이 개발되고 연구되었다.

The standard setting process is designed to translate a conceptual definition of competence to an operational version, called the passing score (Kane 1994; Norcini 1994). Verification that the passing score is appropriate is another critical element in collecting evidence to support the validity of test score interpretation (American Educational Research Association et al. 1999; Kane 2006). Various approaches to determining passing scores for examinations have been developed and researched.

본 가이드에서는 일반적으로 수행능력 기반 평가와 함께 사용된 방법에 대한 개요를 제공합니다. 다양한 평가 목적을 고려하는 것은 표준 설정 방법에 대한 논의를 위한 맥락을 제공하고, 이어서 보건 전문 교육에서 일반적으로 설정되는 다양한 유형의 표준에 대한 설명을 제공할 것이다. 표준 설정 프로세스에 대한 단계별 가이드가 제공됩니다.

In this Guide, an overview to the methods that have been typically used with performance-based assessments will be provided. A consideration of various assessment purposes will provide context for discussion of standard setting methods, followed by a description of different types of standards that are typically set in health professions education. A step-by-step guide to the standard setting process will be presented.

평가목적

Assessment purposes

교육에서, 훈련생들이 노력 분야에서 수행하는데 필요한 지식, 기술 및 태도를 얻고 있는지 여부를 평가하는 것이 종종 필요하다. "충분한 지식, 기술 및 태도"가 존재하는지 여부를 결정하기 위해, 평가 프로그램의 일부로 다양한 방법이 일반적으로 사용된다(Dijkstra et al. 2010). 보건 전문 교육에서는 지원자, 학생, 졸업생 및 실무자의 지식, 기술, 태도 및 능력을 평가하는 많은 접근법이 있다. 한동안 보건 전문 교육자들은 [적절하지 않더라도] 의사의 역량을 평가하기 위해 [사용 가능한 평가 방법]을 사용했다(Norcini & McKinley 2007). 예를 들어, 의사가 의료 팀과 효과적으로 의사소통할 수 있는 것이 중요하지만, 이러한 측면에 대한 평가는 [필기 시험]을 통해 적절하게 테스트되지 않는다. 여러 평가 방법이 개발 및 구현되었으며, [실제 상황에서 기대되는 수행performance와 연계된 성과에 기반한 평가]로 이동했습니다. 보건 전문가 교육에서 "실제" 환자의 불만을 묘사하도록 훈련된 일반인(SP)이 자주 사용된다. 이러한 유형의 평가는 수험자가 알고 있는 것이 아닌 자신이 할 수 있는 일(예: 신체검사를 올바르게 수행, 환자와 의사 소통)을 보여줄 수 있는 기회를 제공한다(Miller 1990).

In education, it is often necessary to evaluate whether trainees are attaining the knowledge, skills, and attitudes needed to perform in the field of endeavour. In order to determine whether “sufficient knowledge, skills and attitudes” are present, different methods are typically employed as part of a programme of assessment (Dijkstra et al. 2010). In health professions education, there are many approaches to assessing the knowledge, skills, attitudes and abilities of applicants, students, graduates, and practitioners. For some time, health professions educators used any available assessment method to evaluate the competencies of a doctor, even if they were not appropriate (Norcini & McKinley 2007). For example, although it is important for a doctor to be able to communicate effectively with the healthcare team, assessment of this aspect is not appropriately tested through the use of written examinations. Several methods of assessment have been developed and implemented, with a movement towards assessment based on performance that is tied to what is expected in practice. In the education of health professionals, standardised patients (SPs), lay people trained to portray complaints of “real” patients, are frequently used (e.g. Patil et al. 2003). This type of assessment provides examinees the opportunity to show what they can do (e.g. correctly perform a physical examination, communicate with a patient), rather than what they know (Miller 1990).

[수험생들이 무엇을 하는지 평가하는 방법]을 개발하는 데 있어서, 다른 방법, 또는 심지어 양식들의 조합도 사용되었다. 많은 의료 분야에서 차트 검토와 360도 평가를 포함한 다양한 직장 기반 평가의 사용이 도입되었다 (Norcini & Burch 2007). 이러한 평가는 일반적으로 품질 개선 척도로 사용되며 동료 검토, 실무 결과 평가, 환자 또는 고객 만족도 척도를 포함한다(Norcini 2003).

In developing methods that assess what examinees do, other methods, or even combinations of modalities, have also been used (Nestel et al. 2006). In many healthcare professions, the use of various workplace-based assessments, including chart reviews and 360 degree evaluations, have been instituted (Norcini & Burch 2007). These assessments are usually employed as quality improvement measures, and involve peer review, evaluation of practice outcomes, and patient or client satisfaction measures (Norcini 2003).

이용 가능한 다양한 도구들은 적어도 부분적으로 다른 평가 목표를 충족하도록 개발되었다. 평가 목표에는 다음을 결정하는 것이 포함될 수 있다.

- 의대에 입학할 자격이 있는 사람(예: 입학 시험)

- 코스 요건이 충족되는지 여부(예: 강의실 시험)

- 학생이 다음 단계의 교육으로 진급할 준비가 되어 있는지 여부(예: 연말 시험)

- 수험자가 전문직에 진출할 준비가 되어 있는지 여부(예: 면허 및 인증 시험)

- 응시자가 전문성의 증거를 보였는지 여부(예: 인증 유지)

The varieties of instruments that are available have been developed, at least in part, to meet different assessment goals. Assessment goals may include determining

- who is eligible to enter medical school (e.g. admissions testing);

- whether course requirements are satisfied (e.g. classroom testing);

- if a student is ready to advance to the next level of training (e.g. end-of-year testing);

- whether the examinee is ready to enter a profession (e.g. licensure and certification testing); or

- whether the examinee has shown evidence of expertise (e.g. maintenance of certification).

일반적으로 [평가에서 얻은 점수]는 "적절한 지식, 기술 및 판단력을 사용하여 [실천 영역]을 정의하는 [encounters의 영역]에 걸쳐 [효과적인 전문 서비스]를 제공할 수 있는" 학생의 능력을 나타낸다고 가정한다. 점수는 종종 학생(또는 졸업생)이 직업에 들어가거나 계속 연습할 수 있는 지식과 기술을 충분히 습득했는지에 대한 결정(또는 해석)에 사용된다. 이러한 방식으로, 시험 점수는 사람들을 두 개 이상의 그룹으로 분류하는 데 사용된다(예: 시험 합격 또는 불합격). 시험 점수는 누가 추가적인 교육적 도움을 필요로 하는지, 시험 응시자가 다음 단계의 훈련을 계속할 것인지, 또는 시험 응시자가 관심 영역에서 숙달했는지에 대한 결정을 내리는 데 사용될 수 있다.

The assumption is usually made that scores obtained from assessments provide an indication of a student's ability to “use the appropriate knowledge, skills, and judgment to provide effective professional services over the domain of encounters defining the area of practice” (Kane 1992, p. 167). Scores are often used to make decisions (or interpretations) regarding whether students (or graduates) have sufficiently acquired the knowledge and skills to enter, or continue practice in, a profession. In this manner, test scores are used to classify people into two or more groups (e.g. passing or failing an examination). Test scores can be used to make decisions about who needs additional educational help, whether the test-taker will go on to the next level of training, or whether the test-taker has achieved mastery in the domain of interest.

Kane(1992)은 [역량]을 [개인이 그 실천 영역에서 발생하는 다양한 상황을 처리할 수 있는 정도]로 정의했습니다(165쪽). 교육, 면허, 자격증 취득에서 평가는 지원자의 숙련도를 결정하는 데 사용된다. 예를 들어, 객관 구조화 임상 검사(OSCE)와 같은 수행능력 척도performance measures가 개발되면, 적절한 수행능력을 나타내는 특성의 정의를 포함하여, [도메인 기반 평가]와 관련된 원칙을 사용할 수 있다(Pell et al. 2010). 시험이 객관식 항목으로 구성되든, 과제 수행으로 구성되든, 목표가 한 개인과 같은 평가를 받는 다른 사람을 비교하는 것인지, 아니면 숙련도를 결정하는 것인지를 고려하는 것이 중요하다. 가이드의 다음 섹션에서는 이러한 다양한 목적과 관련된 표준 유형에 대해 설명합니다.

Kane (1992) defined competence as the extent to which the individual can handle the various situations that arise in that area of practice (p. 165). In education, licensure, and certification, assessments are used to determine the proficiency of candidates. For example, when performance measures such as the objective structured clinical examination (OSCE) are developed, principles associated with domain-based assessment, including definition of characteristics denoting adequate performance, can be employed (Pell et al. 2010). Whether the test consists of multiple-choice items or task performance, it is important to consider whether the goal is to compare an individual with others taking the same assessment, or to determine the level of proficiency. In the next section of the Guide, we discuss types of standards related to these different purposes.

합격선Standard의 종류

Types of standards

표준은 상대적(때로는 표준 참조라고 함) 또는 절대적(때로는 기준 참조라고 함)으로 분류할 수 있다(Livingston & Zieky 1982). 서로 평가를 받는 사람들의 비교를 바탕으로 제정되는 기준은 상대적인 기준이다. 예를 들어 합격점수가 합격자 수나 비율을 기준으로 정해지면 상대적인 기준이 된다. 이러한 유형의 표준 설정은 일반적으로 사용 가능한 자리가 제한된 취업 또는 교육 프로그램 입학을 위한 선택에서 사용된다. 고부담 시험(예: 졸업, 자격증, 자격증)의 경우, 시험 응시자 집단의 능력이 시간에 따라 달라질 수 있고, 평가 내용도 시점에 따라 달라질 수 있기 때문에, 상대적인 표준은 일반적으로 사용되지 않는다. 미리 결정된 합격 점수를 교육용(교실) 시험과 함께 사용할 경우, 해당 수업의 학생들의 능력과 주어진 시험의 난이도는 고려되지 않는다(Cohen-Schotanus & van der Vleuten 2010). 수험능력과 시험 난이도는 합격점수의 적절성에 대한 증거에 악영향을 미칠 수 있는 요인이다. 상대적 표준 설정 방법과 관련된 불이익을 피하기 위해, 절대적 표준 설정 접근법이 자격 증명 검사(즉, 면허증 또는 인증)에서 더 일반적으로 사용된다.

Standards can be categorised as relative (sometimes called norm-referenced) or absolute (sometimes called criterion-referenced) (Livingston & Zieky 1982). Standards that are established based on a comparison of those who take the assessment to each other are relative standards. For example, when the passing score is set based on the number or percentage of examinees that will pass, the standard is relative. This type of standard setting is typically used in selection for employment or admission to educational programmes where the positions available are limited. With high stakes examinations (e.g. graduation, certification, licensure), relative standards are not typically used, because the ability of the groups of test takers could vary over time and the content of the assessment may also vary over time. When pre-determined passing scores are used with educational (classroom) tests, the ability of the students in the class and the difficulty of the test given are not considered (Cohen-Schotanus & van der Vleuten 2010). Examinee ability and test difficulty are factors that could adversely affect evidence of the appropriateness of the passing score. To avoid the disadvantages associated with the relative standard setting method, absolute standard setting approaches are more commonly used in credentialing examinations (i.e. licensure or certification).

합격하기 위해 정확하게 답해야 하는(또는 수행해야 하는) 시험 재료의 양을 결정하여 설정한 기준이 절대 기준이다. 예를 들어 객관식 시험의 75%를 맞혀야 합격할 수 있다면 그 기준은 절대적이다. 절대적인 기준을 사용할 경우, 모든 수험생이 시험에 합격하거나 불합격하는 결과를 초래할 수 있다.

Standards set by determining the amount of test material that must be answered (or performed) correctly in order to pass are absolute standards. For example, if the examinee must answer 75% of the items on a multiple-choice test correctly in order to pass, the standard is absolute. When absolute standards are used, it is possible that decisions made will result in all examinees passing or failing the examination.

표준 설정 및 성능 기반 평가

Standard setting and performance-based assessments

수행능력 기반 평가에는 몇 가지 표준 설정 방법이 사용되었다. 상대적인 기준은 원하는 결과에 기초하여 설정되며(예: 상위 75명의 지원자를 학교에 입학시키는 것) 따라서 더 쉽게 결정되기 때문에, 본 가이드는 절대적인 표준 설정 방법에 초점을 맞출 것이다(비교는 표 1 참조). 이러한 방법에는 시험 자료나 시험 수행에 대한 검토가 포함되며, 결과적인 합격 점수는 주제 전문가 그룹의 판단에서 도출될 수 있다. 절대 표준 설정Absolute standard setting 접근법은 [시험 중심] 또는 [시험자 중심]이라고 한다.(Livingston & Zieky 1982).

- 시험 중심적인 방법을 사용할 때, 심사위원들은 시험 내용에 초점을 맞춘다. 앙고프(1971), 에벨(1972), 네델스키(1954) 방법은 시험 중심 표준 설정 방법의 예이다.

- 이와는 대조적으로 수험생 중심의 방법을 사용할 때, 심사위원은 수험생들의 성적에 초점을 맞춘다. 이러한 방법에는 대조군, 경계선 그룹 및 경계선 회귀 방법이 포함된다(Livingston & Zieky 1982; Wood et al. 2006). 수험생 중심 방법에서 judge의 임무는 심사 결과가 표준을 충족하는 데 필요한 지식과 기술을 가진 사람을 묘사하는지 여부를 결정하는 것이다(예: 최소 역량).

Several standard setting methods have been used with performance-based assessments. Because relative standards are set based on the desired result (e.g. admitting the top 75 candidates to a school) and are, therefore, determined more easily, this Guide will focus on absolute standard setting methods (See Table 1 for comparisons). These methods involve review of examination materials or examinee performance, and the resulting passing scores can be derived from the judgments of a group of subject matter experts. Absolute standard setting approaches have been referred to as either test-centred or examinee-centred (Livingston & Zieky 1982).

- When using test-centred methods, the judges focus on exam content. The Angoff (1971), Ebel (1972), and Nedelsky (1954) methods are examples of test-centred standard setting methods.

- In contrast, when using examinee-centred methods, judges focus on the performance of examinees. These methods include contrasting groups, borderline group, and borderline regression methods (Livingston & Zieky 1982; Wood et al. 2006). The judges’ task in examinee-centred methods is to determine whether the performance they review depicts someone possessing the knowledge and skills needed to meet the standard (e.g. are minimally competent).

객관식 문제(MCQ)를 포함하는 시험과 관련된 시험 중심 및 수험자 중심 접근법의 측면은 이전 AMEE 가이드(Bandaranayake 2008)에서 제시되었으며, 이러한 접근법 중 일부를 OSCE에 적용하는 방법이 여기에 제시된다. 구체적으로, 우리는 앙고프, 경계선 그룹, 경계선 회귀, 대조 그룹 및 시뮬레이션된 OSCE 데이터를 사용한 표준 설정의 절충 방법에 대한 지침을 제공할 것이다. 가이드의 나머지 부분은 표준설정연구 준비, 표준설정연구 실시, 합격점수 생성, 표준실행 및 유지의 4가지 섹션으로 구분된다.

Aspects of test-centred and examinee-centred approaches, related to examinations containing multiple choice questions (MCQs), were presented in a previous AMEE guide (Bandaranayake 2008), and the application of some of these approaches to the OSCE are presented here. Specifically, we will provide guidance for the use of the Angoff, borderline group, borderline regression, contrasting group, and compromise methods of standard setting using simulated OSCE data. The remainder of the Guide is divided into four sections:

- preparing for the standard setting study,

- conducting the standard setting study,

- generating the passing score, and

- implementing and maintaining standards.

표준 설정 스터디 준비

Preparing for the standard setting study

합격 점수를 결정하는 것은 일반적으로 평가 목적과 평가된 영역에 익숙한 그룹에 의해 수행된다. 이 그룹이 만나기 전에 완료해야 할 여러 단계가 있습니다. 첫째, 패널리스트를 모집할 필요가 있다. 객관성을 높이고 그럴듯한 합격 점수를 얻기 위해

- 패널은 시험 내용 영역과 시험의 목적에 대해 잘 알고 있어야 한다(Jaeger 1991; Raymond & Reid 2001).

- 또한, 그들은 시험 받는 학생들의 자격에 익숙해야 한다.

- 마지막으로, 평가 방법에 대한 경험이 필수적이다.

- 임상 숙련도에 대한 판단을 내리는 패널리스트는 해당 분야의 전문가여야 하며, 시험 통과에 따른 결과를 쉽게 이해할 수 있기 때문에 다양한 교육 단계에서 교육생들의 기대에 익숙해야 한다.

Determining the passing score is typically accomplished by a group familiar with the assessment purpose and the domain assessed. Before this group meets, there are a number of steps that should be completed. First, panellists need to be recruited. To increase objectivity and to derive plausible passing scores,

- panellists should be knowledgeable about the examination content area and the purpose of the test (Jaeger 1991; Raymond & Reid 2001).

- In addition, they should be familiar with the qualifications of the students being tested.

- Finally, experience with the assessment method is essential.

- Panellists who make judgments about clinical proficiency should be experts in the profession and should have familiarity with expectations of trainees at various stages of education, because they will readily understand the consequences associated with passing the test.

OSCE는 종종 임상 및 커뮤니케이션 기술을 시험하기 위해 사용되므로 OSCE에 평가자로 참여한 교직원이나 행정에 사용되는 자료(예: 점검표) 개발에 도움을 준 교직원은 표준 설정 회의에서 패널로 모집하는 데 이상적일 수 있다.

- 예를 들어 의사의 의사소통 기술에 대한 표준을 설정하기 위해 의료팀의 다른 구성원(예: 간호 직원, 표준화된 환자 트레이너)을 심사위원으로 고려할 수 있다. 그들은 임상 환경에서 의사의 예상 성과를 잘 알고 있기 때문에 표준 설정 프로세스의 적절한 참여자가 될 수도 있다.

- 성별, 전공(예: 소아과, 일반 의학) 및 전문 활동(예: 교수진 대 개업 의사)에 기초한 패널리스트의 [적절한 혼합]이 고려되어야 한다.

- 이는 합격 점수가 직업에 들어갈 지원자를 식별할 때 특히 중요하다(예: 면허증).

Because OSCEs are often used to test clinical and communication skills, faculty members who have participated in the OSCE as examiners or those who have assisted in the development of materials used in the administration (e.g. checklists) would be ideal for recruiting as panellists in the standard setting meeting.

- To set standards for communication skills of physicians, for example, other members of the health care team could be considered (e.g. nursing staff, standardised patient trainers) as judges. Because they are familiar with the expected performance of physicians in clinical settings, they would also be appropriate participants in the standard setting process.

- A suitable mix of panellists based on gender, discipline (e.g. paediatrics, general medicine), and professional activity (e.g. faculty vs. practicing physician) should be considered.

- This is particularly important when the passing score identifies those candidates who will enter a profession (e.g. licensure).

패널리스트가 많을수록, 결과적인 합격 점수는 안정적일 가능성이 높다(Jaeger 1991; Ben-David 2000). 다만 대규모 그룹 경영에 대한 배려도 중요하다. 필요한 패널리스트의 수는 심사 결정과 관련된 결과, 표준 설정 회의를 완료하기 위한 합리적인 시간대를 검토하기 위한 수행 횟수 및 회의에 사용할 수 있는 자원과 같은 여러 요인에 의해 균형을 이루어야 합니다. 표준 설정 미팅은 적게는 4명, 많게는 20명의 패널리스트로 수행될 수 있습니다. 그룹이 크면 미팅 조정자는 더 많은 자료를 다룰 수 있도록 더 작은 그룹에 패널 목록을 할당할 수 있습니다. [결정 요인]은 미팅에 사용할 수 있는 자원(예: 공간, 진행자 수)입니다.

The more panellists there are, the more likely it is that the resulting passing score will be stable (Jaeger 1991; Ben-David 2000). However, consideration of management of a large group is also important. The number of panellists needed should be balanced by a number of factors: the consequences associated with examination decisions, the number of performances to review a reasonable time frame for completion of the standard setting meeting, and the resources available for the meeting. Successful standard setting meetings can be conducted with as few as four panellists or as many as 20. Having a large group will provide the meeting facilitator with the opportunity to assign panellists to smaller groups so that more material can be covered. The deciding factor will be resources (e.g. space, number of facilitators) available for the meeting.

회의를 조직하는 다음 단계는 패널리스트를 교육하는 데 사용할 자료를 준비하는 것입니다. 패널리스트 교육은 매우 중요하다. 수행능력 표준performance standard 에 대한 명확한 이해(예: 교정조치가 필요한 학생, 지도 실습 준비 졸업생, 비지도 실습 준비 전문가)를 개발하는 것이 필수적이다. performance standard 에 대한 이해를 증진시키기 위해, 전형적으로 [역량 기반 커리큘럼]의 일부인 기준은 매우 유용할 수 있다. 이러한 유형의 정보는 특정 맥락에서 그리고 보건 전문가 경력의 특정 단계에서 성과 표준을 구성하는 지식, 기술 및 능력을 설명하는 데 도움이 될 수 있다(Frank et al. 2010).

The next step in organising the meeting is preparing materials to be used in training the panellists. Panellist training is very important; developing a clear understanding of the performance standard (e.g. student in need of remediation, graduate ready for supervised practice, practitioner ready for unsupervised practice) is essential (Ben-David 2000; Bandaranayake 2008). To promote understanding of the performance standard, criteria that are typically part of a competency-based curriculum can be very useful. This type of information can assist in the delineation of the knowledge, skills, and abilities that comprise the performance standard in a particular context, and at a particular stage in a health professional's career (Frank et al. 2010).

교육을 지원하기 위해 시험 자료를 오리엔테이션의 일부로 사용할 수 있습니다. 예를 들어, OSCE의 표준 설정에 대한 오리엔테이션의 일부로서 패널리스트는 일부 스테이션을 수험생처럼 완수해볼 수 있다. 이를 통해 수험생의 입장에서 시험을 경험할 수 있다. 다음으로, performance standard를 정의하는 특성에 대한 논의가 이루어질 것이다. 마지막으로, 패널리스트는 선택한 방법을 연습할 수 있는 기회가 주어질 것이다.

To support training, examination materials may be used as part of the orientation. For example, as part of the orientation to standard setting for an OSCE, panellists could complete some of the stations as examinees. This allows them to experience the examination from the perspective of the examinee. Next, a discussion of the characteristics defining with the performance standard would be conducted. Finally, the panellists would be afforded the opportunity to practice the method selected.

가이드의 다음 섹션에서는 OSCE를 예로 들어 성능 평가에 대한 합격 점수를 설정하는 데 사용할 수 있는 방법을 제시한다. 이러한 방법은 일반적으로 OSCE 및 표준화된 환자 검사의 합격 점수를 얻는 데 사용됩니다. 각 섹션에서는 OSCE 또는 표준화된 환자 검사와 함께 사용되는 방법에 대한 연구를 인용한다. OSCE의 합격 점수를 도출하기 위한 세부 지침을 제공하기 위해, 우리는 5개의 OSCE 스테이션을 사용하여 50명의 학생을 위한 연말 시험을 위한 데이터를 생성했다. 50개 항목으로 구성된 객관식 시험을 위한 데이터도 생성되었다. 이 시뮬레이션 데이터 세트는 OSCE 시험을 위한 합격 점수를 개발하는 데 사용할 수 있는 여러 가지 방법을 설명하는 데 사용될 것이다.

In the next section of the Guide, we present methods that can be used to set passing scores for performance assessments, using the OSCE as an example. These methods are commonly used to derive passing scores for OSCE and standardised patient examinations (Norcini et al. 1993; Boulet et al. 2003; Downing et al. 2006). In each section, research regarding the method as used with OSCEs or standardised patient examinations is cited. In order to provide detailed guidelines for deriving passing scores for an OSCE, we generated data for an end-of-year examination for 50 students, using five OSCE stations. Data for a multiple-choice examination consisting of 50 items was also generated. This simulated data set will be used to illustrate a number of methods that can be used to develop passing scores for an OSCE examination.

표준 설정 미팅 진행 : 수정된 Angoff

Conducting the standard setting meeting: modified Angoff

체크리스트 항목

Checklist items

[수정된 앙고프]를 체크리스트의 각 항목에 대한 표준을 설정하기 위해 사용하는 연구가 몇 가지 수행되었다(예: 다우닝 외 2003, 2006). 이 과정을 위해서는 체크리스트와 평점 제공 양식 등 모든 패널리스트에 대한 사례 자료를 준비해야 한다. 미팅 진행자는 등급을 표시하는 방법(플립 차트, 프로젝터)이 필요하며, 데이터 입력을 위한 양식을 준비하고 가능하면 각 사례 체크리스트에 대한 스프레드시트를 설정해야 합니다. 이를 통해 간단한 데이터 분석을 통해 문항, 심사자, 사례의 평균을 계산할 수 있습니다. 이 방식을 사용할 때, 패널리스트는 체크리스트의 항목을 검토하며, 과제는 [OSCE 체크리스트에 대해서, 기술된 조치를 정확하게 수행할 수 있는 performance standard을 충족하는 수험자(예: 최소 능력자)의 비율을 추정하는 것]이다.

Several studies have been conducted where the modified Angoff was used to set standards for each item in a checklist (e.g. Downing et al. 2003, 2006). For this process, it is necessary to prepare case materials for all panellists, including checklists and a form for providing ratings. The meeting facilitator will need a way to display the ratings (flip chart, projector) and should prepare forms for data entry and, if possible, set up spreadsheets for each case checklist. This will permit simple analyses of the data, calculating averages for items, judges, and cases. In these studies, panellists review the items on the checklist, and the task is to estimate the percentage of examinees meeting the performance standard (e.g. minimally competent) who will correctly perform the action described in the OSCE checklist.

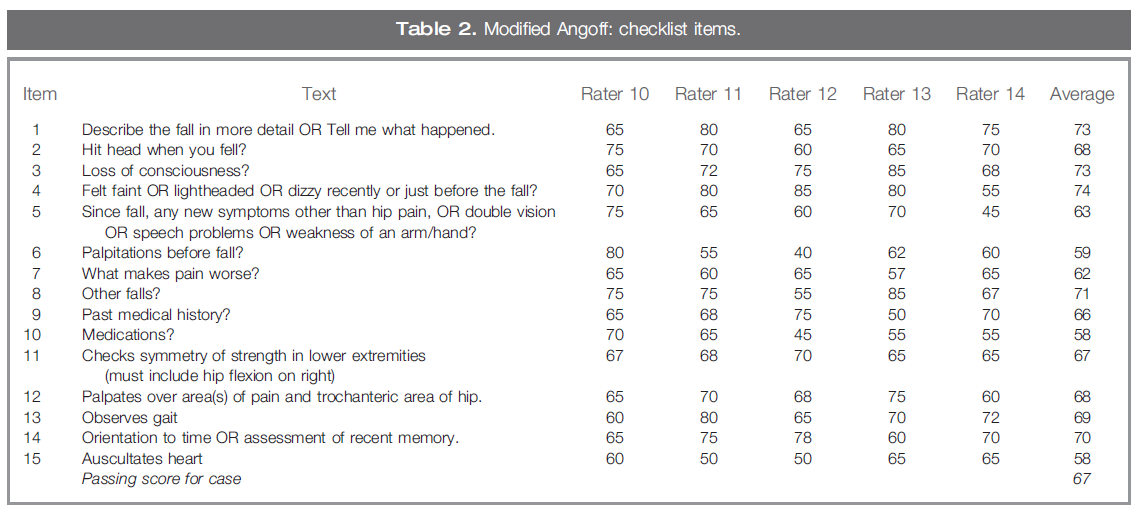

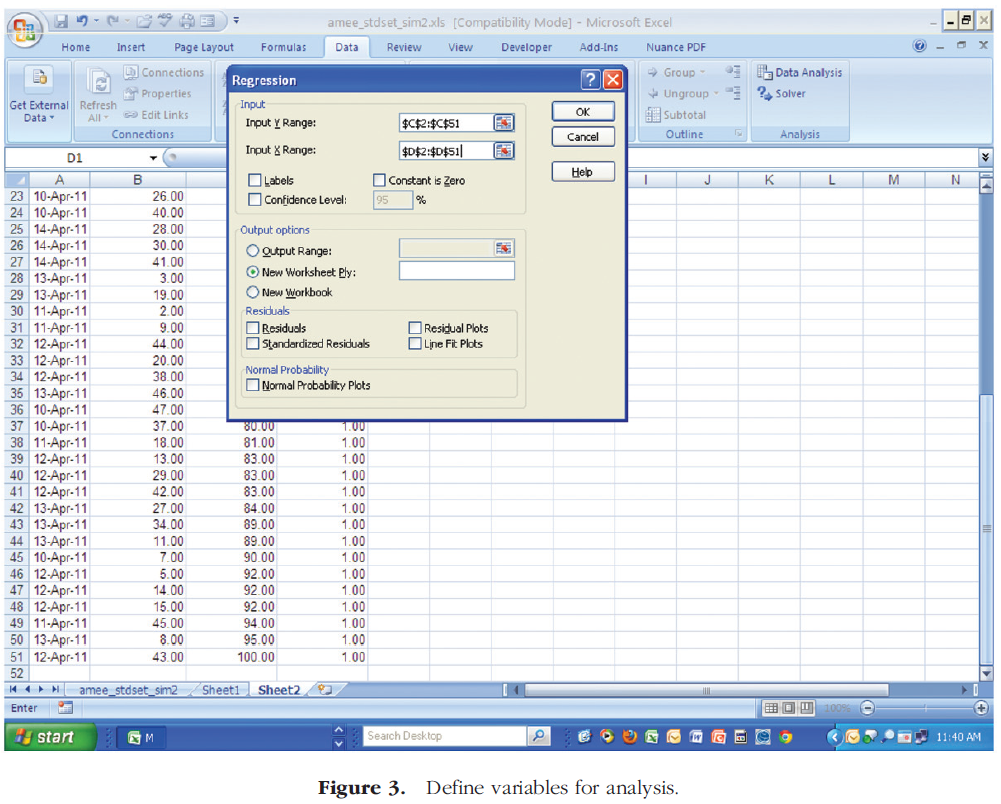

표 2는 고령 환자의 낙상 사례에 대한 샘플 체크리스트를 보여준다. 성능 표준에 대한 논의와 사례 자료의 발표에 이어, 패널리스트는 그룹으로 처음 5개의 체크리스트 항목을 검토할 것을 권고한다. 이 예제에서 항목 3에 대한 평가자 10과 13의 등급 사이에는 큰 차이가 있습니다. 정의와 등급 과제에 대한 합의에 도달하는 것을 목표로, [15% 이상의 불일치]에 대한 논의가 촉진될 것이다. 불일치 항목이 [15% 이상]이면 회의 후 점검항목에 내용 관련 문제가 있는지 검토해야 한다. 이 항목은 합격 점수 결정에서 제거되어야 할 수 있으며, 패널리스트가 토론한 내용은 해당 결정을 내리는 데 유용할 수 있습니다. 15% 이상의 불일치는 토론을 통해 해결할 수 없는 항목이 있을 수 있지만, 이러한 항목이 많으면 안 됩니다. 그룹 등급 및 토론 후 패널리스트는 나머지 체크리스트 항목을 독립적으로 진행할 수 있습니다.

Table 2 shows a sample checklist for a case of a fall in an elderly patient. Following a discussion of the performance standard, and presentation of case materials, it is recommended that the panellists review the first five checklist items as a group. In the example, there is a large difference between the ratings of raters 10 and 13 on item 3. Discussion of discrepancies of 15% or more would be facilitated, with the goal of reaching consensus on the definition and the rating task. If there are items with discrepancies of 15% or more, they should be reviewed after the meeting to determine if there is a content-related problem with the checklist item. This item may need to be removed from determination of the passing score, and any discussion the panellists have can be useful in making that decision. There may be some items where discrepancies of 15% or more cannot be resolved through discussion, but there should not be many of these items. After group rating and discussion, panellists can proceed through the remaining checklist items independently.

이 예제에 사용된 표에는 모든 패널 목록의 평균 등급이 표시됩니다. 사례case의 합격 점수를 도출하기 위해 모든 항목과 패널리스트의 평균 등급을 계산했다. 이 예에서 합격 점수는 67%입니다. 수험생이 체크리스트 항목 중 67% 이상을 정확하게 채우면 합격점을 받을 수 있다. 다음은 수정된 Angoff 방법을 사용하여 [단일 사례에 대한 합격 점수를 결정하는 단계]입니다. 이 프로세스는 OSCE 관리에 포함된 스테이션에 대한 모든 체크리스트에서 반복된다. 패널리스트가 등급 지정 프로세스를 완료하면 데이터 입력을 시작할 수 있습니다. 각 경우에 대한 스프레드시트를 사용하여 데이터 입력을 용이하게 할 수 있습니다. items과 judges의 평균을 계산하면 각 사례에 대한 컷 점수가 생성됩니다. 평가 결과의 점수 및 보고에 따라, 합격 점수는 [사례별 합격 점수case passing scores를 평균]하거나 또는 [OSCE 콘텐츠 영역(예: 이력 검사, 신체 검사, 커뮤니케이션)을 평균]하여 OSCE에 대해 계산할 수 있다.

The table used for this example shows the average rating across all panellists. To derive the passing score for the case, the average rating across all items and panellists was calculated. In this example, the passing score would be 67%. If examinees correctly complete 67% or more of the items on the checklist, they would achieve a passing score for that case. These are the steps associated with using the modified Angoff method to determine the passing score for a single case. This process would be repeated with all checklists for stations included in the OSCE administration. Once panellists have completed their rating process, data entry can begin. Data entry can be facilitated by using a spreadsheet for each case. Calculating the mean across items and judges produces a cut score for each case. Depending on the scoring and reporting of assessment results, passing scores can be calculated for the OSCE by

- averaging case passing scores, or

- OSCE content domains (e.g. history taking, physical examination, communication).

경우들

Cases

수정된 Angoff는 체크리스트 항목 수준에서 판단을 수집하여 사용되었지만, 패널리스트가 사례 또는 스테이션 수준에서 판단을 내리는 것이 더 일반적이다. 이 접근법의 한 가지 근거는 [체크리스트의 항목이 상호 연관되어 있다]는 것이다. [특정 질문을 하거나, manoeuvre를 수행할 가능성]은 신체검사에서 [다른 질문이나 다른 발견]에 달려 있다. 앙고프가 사례 수준에서 실시될 경우 패널들의 과제는 OSCE 스테이션의 [점검표 내 개별 항목]이 아니라, [사례의 내용]에 따라 수행 기준을 충족할 수험생 비율을 추정하는 것이다. 또는 패널리스트에게 점검표 항목을 검토하고 [성능 표준을 충족하는 수험생(예: 최소 자격)이 충족할 것 같은 item의 비율]을 추정하도록 요청할 수 있다.

Although the modified Angoff has been used by gathering judgments at the checklist item level, it is more common to have panellists make their judgments at the case or station level. One rationale for this approach is that the items in a checklist are inter-related; the likelihood of asking a question or performing a manoeuvre is dependent on asking other questions or other findings in a physical examination (Ben-David 2000; Boulet et al. 2003). If the Angoff is conducted at the case level, the panellists’ task is making an estimation of the percentage of examinees who will meet the performance standard based on the content of the case, rather than the individual items within the checklist for the OSCE station (e.g. Kaufman et al. 2000). Alternately, the panellists can be asked to review the checklist items and estimate the percentage of items for which the examinees meeting the performance standard (e.g. minimally qualified) will get credit.

사례 자료는 패널리스트에 의해 검토되며, 데이터 입력 준비도 유사합니다. 그러나 표준 설정 프로세스의 일부로 분석할 사례 수에 따라 단일 스프레드시트를 사용할 수 있습니다. 표 3은 앞에서 언급한 시뮬레이션을 위한 샘플 스프레드시트 형식을 제공하며, 50명의 학생을 대상으로 한 연말 시험을 위한 5개의 OSCE 스테이션이 있다. 이 예제의 경우 5명의 심판이 있습니다. 다시 한 번 수행기준에 부합하는 수험생의 특성을 논의하고, 시험자료를 제시하고 검토하며 패널들이 채점 과제를 시작한다. 그 방법을 연습하는 것은 필수적이다. 우리의 예를 사용하면, 여섯 번째 사례가 패널들 간의 연습과 토론에 사용될 것이다. 이 경우 등급은 합격 점수를 생성하는 데 사용되지 않습니다. 모든 학생의 사례 점수(백분율 점수percent correct metric)는 표의 마지막 열에 표시됩니다. 만약 시간이 허락한다면, 패널리스트로부터 등급을 제출받은 이후에, 모든 학생들에 대해서 [스테이션에서 어떻게 수행했는지에 대한 정보]를 줄 수 있다. 그런 다음 패널리스트는 추정치estimates을 변경할 수 있습니다. Judges과 Stations의 평균을 계산하면 OSCE의 합격 점수를 얻을 수 있다.

Case materials are reviewed by the panellists, and the preparation for data entry is similar. However, a single spreadsheet may be used, depending on the number of cases to be analysed as part of the standard setting process. Table 3 provides a sample spreadsheet format for the simulation we mentioned earlier, with five OSCE stations for an end-of-year test of 50 students. For this example, there are five judges. Once again, the characteristics of the examinees meeting the performance standard are discussed, test materials are presented and reviewed, and panellists begin the rating task. Practicing the method is essential. Using our example, a sixth case would be used for practice and discussion amongst panellists. The ratings from this case would not be used to generate the passing score. The case scores (in percent correct metric) for all students are presented in the last column of the table. If time permits, panellists could provide their ratings and then be given information on how all students performed on the stations. They can then change their estimates. Calculating the mean across judges and stations provides the passing score for the OSCE.

표준 설정 미팅 실시: 경계 그룹

Conducting the standard setting meeting: borderline group

수정된 Angoff 접근법(체크리스트 항목 및 사례 수준)이 OSCE 및 표준화된 환자 검사의 합격 점수를 결정하는 데 일반적으로 사용되지만, 패널리스트는 항목별 학점을 받거나 사례를 정확하게 관리할 수 있는 [수험생의 비율을 추정하는 것이 어렵다]고 생각할 수 있다. OSCE와 함께 자주 사용되는 [시험 자료보다는 수험생 성과에 초점을 맞추는 방법]이 [경계선 그룹 방식]이다. 경계선 그룹 방법은 "경계선" 수험자의 특성(예: 지식, 기술 및 능력)을 식별해야 한다. ["경계선" 수험생]은 지식과 기술이 적절하지 않지만, 부적절하지도 않은 수험생이다. 평가 자료(또는 실제 시험자 성과)는 패널리스트에 따라 명확한 실패, 경계선 또는 명확한 합격으로 분류됩니다. 그런 다음 [통과 점수]는 [경계선 그룹의 중위수(즉, 50번째 백분위수) 점수]로 설정된다(예: Rothman & Cohen 1996).

While both modified Angoff approaches (checklist items and case level) are commonly used to determine passing scores in OSCE and standardised patient examinations, panellists may find the task of estimating the percentage of examinees meeting the performance standard who will receive credit for items or who will correctly manage the case challenging (Boulet et al. 2003). A method that focuses on examinee performance rather than examination materials that is frequently used with OSCEs is the borderline group method. The borderline group method requires the identification of the characteristics (e.g. knowledge, skills, and abilities) of the “borderline” examinee. The “borderline” examinee is one whose knowledge and skills are not quite adequate, but are not inadequate (Livingston & Zieky 1982). Assessment materials (or actual examinee performances) are categorised by panellists as clear fail, borderline, or clear pass. The passing score is then set at the median (i.e. 50th percentile) score of the borderline group (e.g. Rothman & Cohen 1996).

OSCE에서 사용된 이 방법의 수정 중 하나는 [OSCE 시행 중에 수집된 판단을 사용]하는 것이다. 이 수정안에서는 심판 패널이 사용되지 않으며, 대신 관찰자는 각 스테이션에 대한 합격 점수를 도출하는 데 사용되는 정보를 제공한다. 전문가(예: 의사, 교수진)가 OSCE 관측소 점수를 매기는 데 사용되는 경우, 본 성과를 "경계선"으로 간주할지 여부를 질문할 수 있다. 이 접근 방식은 [시험이 진행되는 동안 심사관의 판단을 모아서 시간을 절약]할 수 있다. 시험관이 성적이 경계선으로 간주되는 수험생을 식별하면 '경계선'으로 분류된 모든 수험생의 중간 점수를 찾아 합격 점수를 계산할 수 있다.

One modification to this method that has been used with OSCEs is to use the judgments gathered during the OSCE administration (e.g. see Reznick et al. 1996). In this modification, a panel of judges is not used; instead, observers provide information used to derive the passing score for each station. If experts (e.g. physicians, faculty members) are used to score the OSCE stations, they can be asked whether the performance they have seen would be considered “borderline.” This approach can save time by gathering examiners’ judgments while the examination is being administered. Once examiners have identified examinees whose performance is considered borderline, the passing score can be calculated by finding the median score of all examinees who were classified as “borderline.”

이 접근 방식을 설명하기 위해 표 4에 제시된 수정된 Angoff 접근 방식에 사용된 것과 동일한 데이터 세트를 사용할 것이다. 50명의 학생들이 시험을 보았고, 시험관들은 관측된 성능이 각 역에서 "명백한 실패", "경계선", "명백한 통과" 또는 "우수"인지 여부를 나타내는 등급을 제공했다. 50명의 학생들 중, 9명은 OSCE 역에서 "경계선" 공연을 보여준 것으로 생각되었다. 측점에 대한 합격 점수를 도출하기 위해 중앙값(즉, 50번째 백분위수) 점수가 계산되었다. 이 예제의 경우 합격 점수는 스프레드시트 소프트웨어를 사용하여 식별되었습니다. MEDIAN (C23, C26, C29, C36, C37, C42, C42, C43, G2, G6); 여기서 "C"와 "G"는 OSCE 점수가 위치한 열을 나타내며 숫자는 경계선 수험자의 점수를 나타내는 행을 나타낸다. 이 예에서는 중위 점수가 64%이므로 64% 이상의 점수를 받은 수험생이 해당 스테이션을 통과하게 됩니다.

To illustrate this approach, we will use the same data set used for the modified Angoff approach, which is presented in Table 4. Fifty students were tested, and examiners provided a rating indicating whether the observed performance was a “clear fail,” “borderline,” “clear pass,” or “superior” at each station. Of the 50 students, nine were thought to have demonstrated “borderline” performance at the OSCE station. To derive the passing score for the station, the median (i.e. 50th percentile) score was calculated. For this example, the passing score was identified using spreadsheet software: MEDIAN (C23,C26,C29,C36,C37,C42,C43,G2,G6); where “C” and “G” indicate the columns where OSCE scores are located and the numbers indicate the rows for the scores of the borderline examinees. In this example, the median score is 64%, so examinees with scores of 64% or higher would pass the station.

이 접근법의 수정은 캐나다 의학 평의회Medical Council of Canada 에 의해 사용되며, 6점 등급 척도가 사용된다: 열등, 열등, 국경 불만족, 국경 만족, 양호 및 우수. [경계선 불합격]과 [경계선 합격]으로 평가된 수험생의 평균 스테이션 점수는 스테이션에 대한 합격 점수를 도출하기 위해 계산된다. 이 [수정 경계선 그룹 방법]은 스테이션에 대해 "경계선" 등급을 받은 수험생이 충분히 있을 때 잘 작동한다. 그러나 합격점수의 안정성은 [경계선 불만족]과 [경계선 만족]으로 분류된 수험자 수에 따라 달라진다. 만약 적은 수의 수험생만이 "경계선"으로 평가된다면, 그들의 스테이션 점수의 평균을 바탕으로 합격 점수를 계산하는 것은 안정적이지 않을 것이다. 즉, 두 개 또는 세 개의 점수에서 도출된 컷 점수와 관련된 신뢰성은 매우 낮을 가능성이 높다.

A modification of this approach is used by the Medical Council of Canada (Smee & Blackmore 2001), where a six-point rating scale is used: inferior, poor, borderline unsatisfactory, borderline satisfactory, good, and excellent. The mean station score for those examinees rated borderline unsatisfactory and borderline satisfactory is calculated to derive the passing score for the station. This Modified Borderline Group Method works well when there are enough examinees who were rated “borderline” for the station. However, the stability of the passing score is dependent on the number of examinees in the borderline unsatisfactory and borderline satisfactory categories. If few examinees are rated “borderline”, then calculating the passing score based on the mean of their station scores are not likely to be stable. That is, the reliability associated with a cut score derived from two or three scores is likely to be very low.

이러한 잠재적 단점을 극복하기 위해 Wood 등이 [회귀 접근법]을 연구하였다. OSCE 점수의 전체(모든 응시자) 범위를 사용하는 것은 소수의 수험생만 참여한 경우에 특히 유용할 수 있다. 경계선으로 분류된 수험생의 수가 매우 적을 수 있기 때문에, 결과적인 합격 점수는 모든 점수를 사용했을 때보다 정확도가 떨어질 수 있다. 이 수정된 방법에서

- [체크리스트 점수]는 종속 변수이며,

- [등급rating]은 독립 변수입니다.

회귀 분석의 목적은 스테이션에서 "경계선"으로 분류된 수험생의 체크리스트 점수를 예측하는 것이다.

To overcome this potential disadvantage, a regression approach was studied by Wood et al. (2006). Using the entire range of OSCE scores can be particularly useful if only a small number of examinees have participated. Because the number of examinees classified as borderline could be very small, the resulting passing score could be less precise than if all scores were used (Wood et al. 2006). In this modification,

- the checklist score is the dependent variable;

- the rating is the independent variable.

The goal of the regression analysis is to predict the checklist score of the examinees classified as “borderline” for the station.

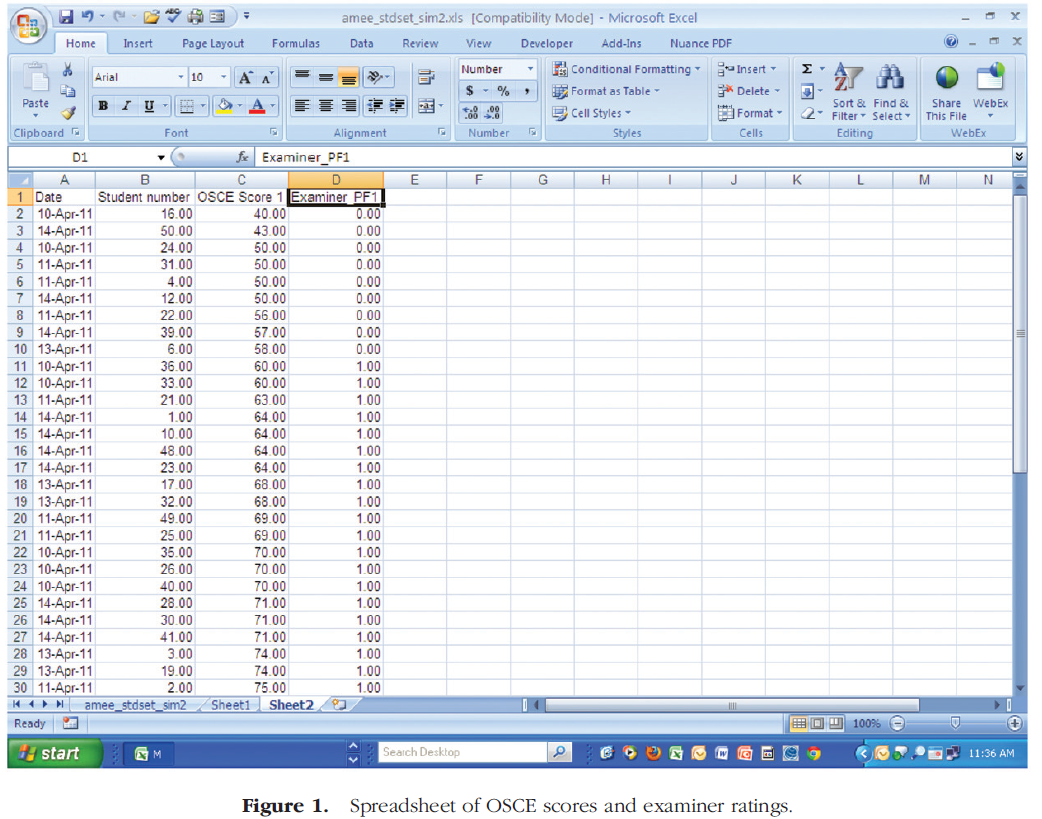

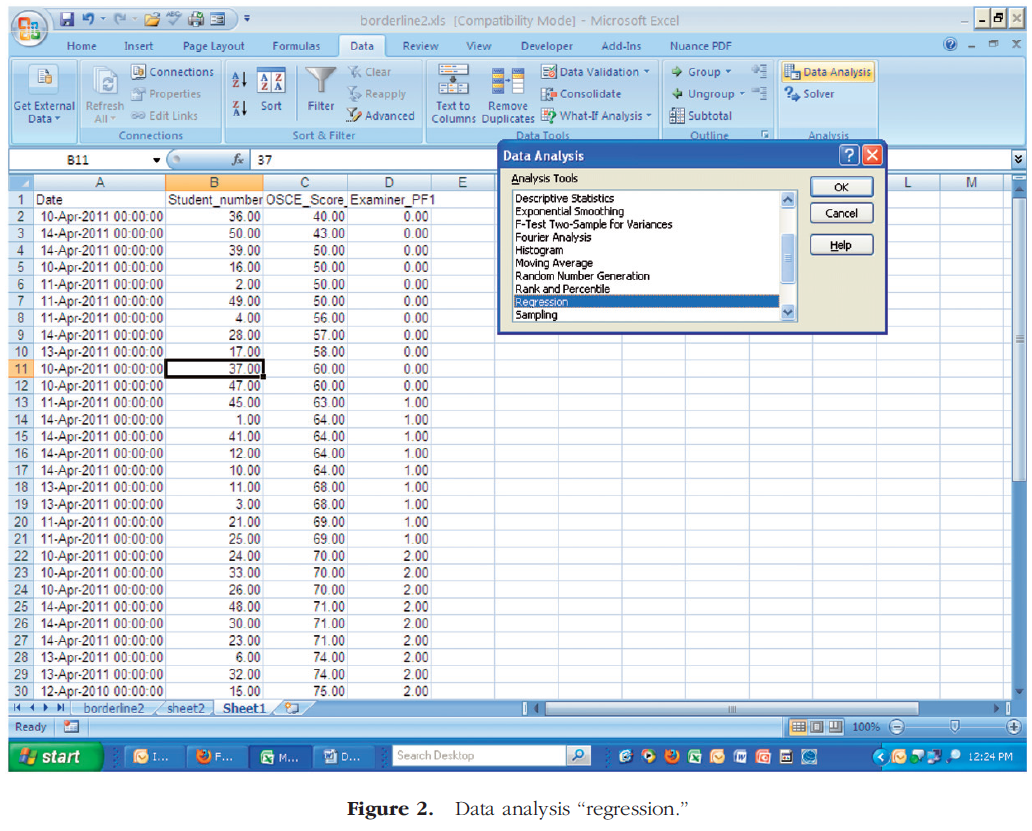

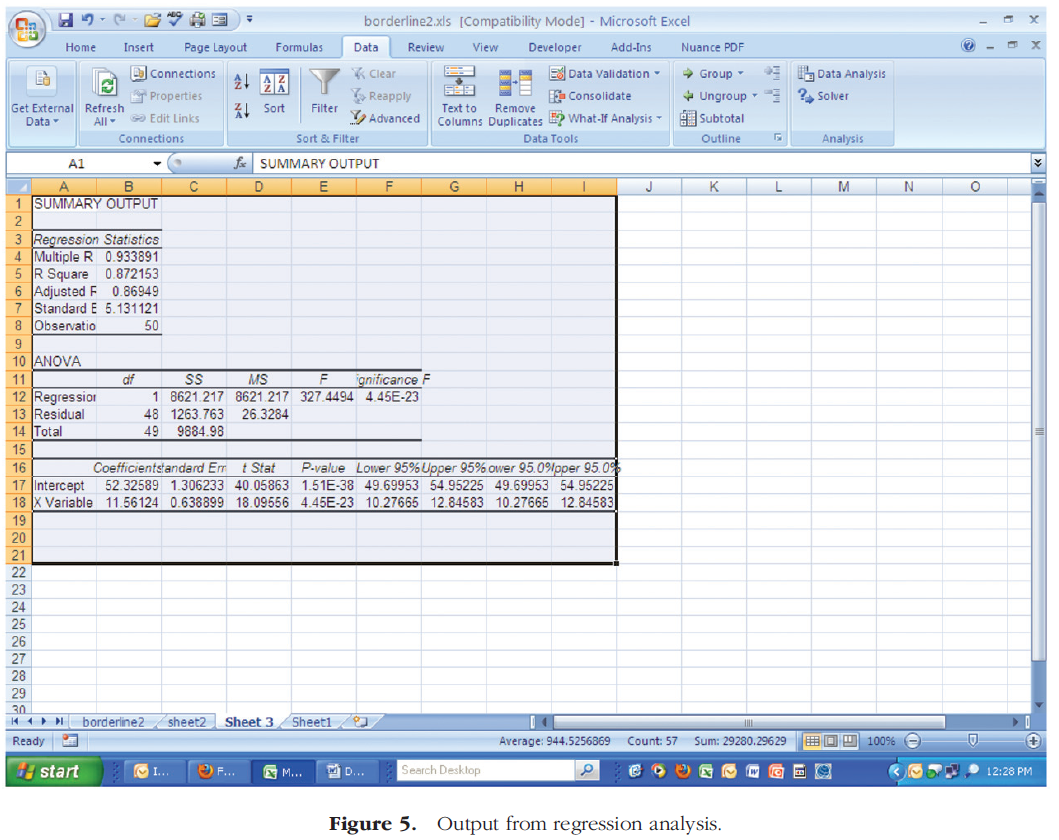

경계 회귀 분석 방법은 간단하며 Microsoft Excel 워크시트를 사용하여 수행할 수 있습니다. 이 방법에 대한 자세한 내용은 그림 1-5에 나와 있으며, 7가지 단계를 설명합니다.

The borderline regression method is straightforward, and can be done using a Microsoft Excel worksheet. Details on the method are provided in Figures 1–5, which depict a series of seven steps.

- 1단계: OSCE 점수 및 검사자 등급에 대한 스프레드시트를 준비합니다.

- 2단계: "데이터" 탭을 클릭하고 팝업 창이 나타나면 "데이터 분석"을 선택합니다. 선택할 분석 도구는 "회귀"입니다.

- 3단계: "입력 Y 범위"를 식별합니다. 예측되는 항목입니다. 이 경우 C열의 OSCE 점수입니다.

- 4단계: "입력 X 범위"를 식별합니다. 점수 예측에 사용할 항목입니다. 이 경우 D열의 "검사자 PF1"이 제공하는 등급이 선택된다.

- 5단계: 분석 결과의 위치를 확인합니다. 이 예제에서는 스프레드시트에 "시트 3"이라는 이름을 지정했습니다. 회귀 분석 창(오른쪽 위)에서 확인을 클릭합니다.

- 6단계: 회귀 분석("요약 출력")의 출력은 "시트 3"에 있습니다.

- 7단계: 합격 점수를 도출하는 공식은 다음과 같습니다.

- 통과 점수 = (정격* " × 변수 1") + 가로채기.

- 이 예에서 합격 점수는 75.4 = (2 × 11.561) + 52이다.326

- 여기서 2는 등급의 중위수이고, 11.561은 "× 변수 1"이며, 52.326은 절편이다.

- 통과 점수 = (정격* " × 변수 1") + 가로채기.

- Step 1: Prepare a spreadsheet of OSCE scores and examiner ratings.

- Step 2: Click on the tab labelled “Data,” and when the pop-up window appears, select “Data Analysis.” The analysis tool you will select is “Regression.”

- Step 3: Identify the “Input Y Range” – what will be predicted. In this case, it is the OSCE scores in Column C.

- Step 4: Identify the “Input X Range” – what will be used to predict scores. In this case, the ratings provided by “Examiner PF1” in Column D will be selected.

- Step 5: Identify the location for analysis results. In the example, we gave the spreadsheet the name “Sheet 3.” Click OK in the “Regression” window (upper right side).

- Step 6: The output from the regression (“Summary Output”) is in “Sheet 3.”

- Step 7: The formula for deriving the passing score is:

- passing score = (median of ratings* “ × Variable 1”) + Intercept.

- For this example, the passing score would be 75.4 = (2 × 11.561) + 52.326

- where 2 is the median of the ratings, 11.561 is the “ × Variable 1”, and 52.326 is the intercept.

검토 결과, 스테이션의 평가자가 특히 가혹하다는(또는 관대하다는) 결론으로 이어지는 경우, 합격 점수는 추정의 표준 오차(요약 출력에 "표준 오차"로 표시됨)에 의해 조정될 수 있다.

The passing score could be adjusted by the standard error of estimation (labelled “Standard Error” in the Summary Output), if review leads to the conclusion that the examiner at a station was particularly harsh (or lenient).

표준 설정 미팅 수행: 대조 그룹

Conducting the standard setting meeting: contrasting groups

[대조 그룹 방법]을 사용하려면 패널리스트가 검사자의 작업을 검토하고, 수행능력을 [허용되는 것] 또는 [허용되지 않는 것]으로 분류해야 합니다. 교육에서, 시험 외부 정보는 수험자를 이러한 범주로 분류하는 데 사용된다(햄블턴 외 2000) 유사한 내용의 다른 조치들이 있을 때, [두 그룹의 수험생]을 확인한다. 그런 다음 성능 표준이 확립된 테스트의 점수를 사용하여 [분포(그룹별로 하나씩)를 생성]하고, [분포를 비교]하여 [중복 정도를 결정]한다. 이는 '유능하다'고 평가되는 각 항목별, 점수 수준별 수험생 비율을 표로 표시해 이뤄진다. 합격 점수는 수험생의 약 50%가 유능하다고 판단되는 지점이다.

The Contrasting Groups method requires panellists to review examinee work and classify the performance as acceptable or unacceptable (Livingston & Zieky 1982). In education, information external to the test is used to classify the examinees in these categories (Hambleton et al. 2000). When other measures with similar content are available, two groups of examinees are identified. Then, scores from the test on which performance standards are being established are used to generate distributions (one for each group), and the distributions are compared to determine their degree of overlap. This is done by tabulating the percentage of test-takers in each category and at each score level who are considered “competent”. The passing score is the point at which about 50% of the test-takers are considered competent.

보건 전문 교육에서 검사 프로그램의 경우, OSCE에서 측정한 것과 동일한 기술을 평가하는 외부 조치를 찾기 어렵다. 의료 교육에서 가장 일반적으로 사용되는 변형은 패널이 [관심 측정(즉, OSCE 또는 표준화된 환자 검사)]에 대해, [패널이 검토한 수행능력]이 [수행능력 표준과 관련된 특성]을 충족하는지 여부를 결정하도록 하는 것이다. [대조 그룹 방법]을 변형한 한 가지 예는 수행능력을 "competent"으로 평가하는 심사위원 수를 시험 점수로 회귀시켜 합격 점수를 도출하고, 패널리스트의 50%가 성과를 유능하다고 평가하는 지점에서 합격 점수를 설정했다.

For examination programmes in health professions education, it is difficult to find an external measure that assesses the same skills as those measured in the OSCE. The variation most commonly used in medical education is to have panellists decide whether the performance they review on the measure of interest (i.e. the OSCE or standardised patient examination) meets the characteristics associated with the performance standard. One example of a variation on this approach derived the passing score by regressing the number of judges rating the performance as “competent” to the test scores, and set the passing score at the point at which 50% of the panellists rated the performance as competent (Burrows et al. 1999).

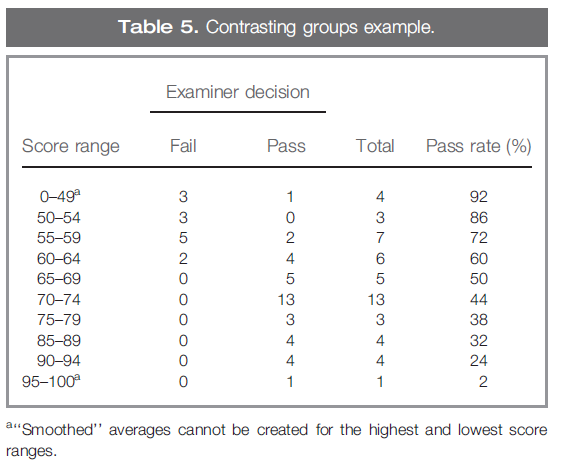

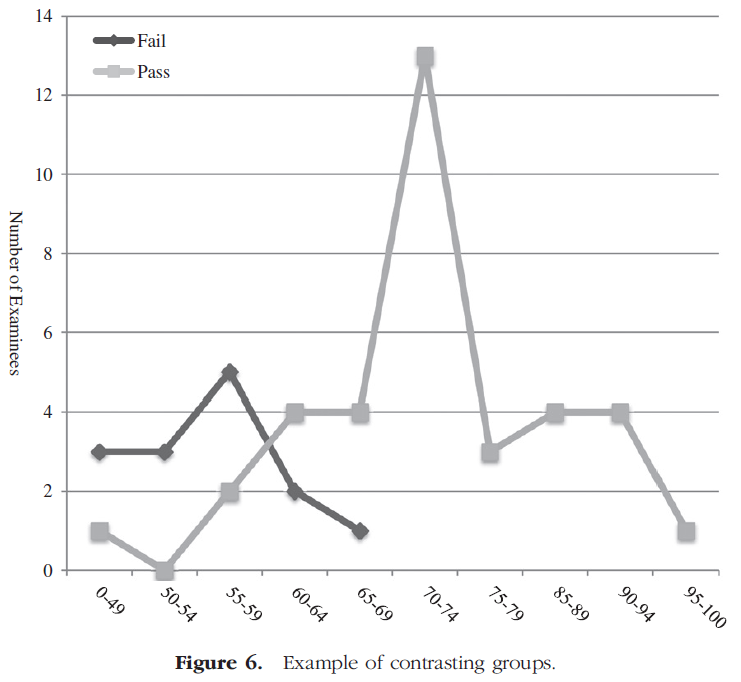

[대조 그룹 방법]의 또 다른 [변형]에서, 패널들은 시험 점수에 대한 지식 없이, 시험에서 수험자들의 성과를 판단했다. 그런 다음 통과 점수는 [두 점수 분포의 교차점]으로 식별되었다. 이전 예제를 사용하여 이 접근 방식의 사용을 설명하겠습니다. 50명의 학생들이 시험을 보았고, 시험관은 관찰된 성과가 "실패" 또는 "합격"으로 간주되는지 여부를 나타내는 등급을 제공했다. 표 5는 시험관이 "실패" 또는 "합격"으로 평가한 수험자의 점수 범위와 개수가 포함된 데이터 세트를 보여준다. "Examiner's Decision"이라는 라벨이 붙은 칸 외에, 해당 범위 내의 점수를 가진 총 응시자 수가 제공된다. 이 예에서 심사관의 등급은 점수 범위와 별개입니다. 대신, 점수는 다른 평가자가 작성한 체크리스트를 기반으로 한다고 가정하십시오. 그 결과는 평가자가 확인한 수험생들이 가장 낮은 점수 범위에서도 합격으로 고려했음을 보여준다. 'Pass rate'이란 칸은 합격점을 점수 범위 바로 위에 설정했을 경우 합격할 수 있는 수험생 비율을 표시한 것이다.

In another variation of the contrasting groups method, panellists judged the performance of examinees on the test of interest without knowledge of their test scores (Clauser & Clyman 1994). The passing score was then identified as the intersection of the two score distributions. We will illustrate the use of this approach using our earlier example. Fifty students were tested, and the examiner provided a rating indicating whether the observed performance was considered “failing” or “passing.” Table 5 shows the data set with score ranges and counts of examinees rated “fail” or “pass” by the examiner. In addition to the columns labelled “Examiner's Decision,” the total number of examinees with scores within that range is provided. In this example, the examiner's ratings are separate from the score range; instead, imagine that the scores are based on a checklist completed by another rater. The results show that the rater identified examinees considered passing even in the lowest part of the score range. The column labelled “Pass rate” is an indication of the percentage of examinees that would pass if the passing score was set just above the score range.

예를 들어 합격 점수를 50%로 맞추면 46명의 수험생이 합격하고 합격률은 92%가 된다. 그림 6은 점수 분포의 중첩을 보여줍니다. Clauser & Clyman(1994)이 연구한 접근 방식을 고려할 때, 교차점은 65%의 권장 합격 점수를 생성할 것이다. 65% 이상 수험생은 합격하고 64% 이하 수험생은 불합격한다.

For example, if the passing score was set at 50% correct, 46 examinees would pass, and the pass rate would be 92%. Figure 6 illustrates the overlap in the score distribution. Considering the approach studied by Clauser & Clyman (1994), the point of intersection would generate a recommended passing score of 65%. Examinees with score of 65% or higher would pass, and those with score of 64% or lower would fail.

시험 수준 합격 점수 결정

Determining examination level passing scores

성과 기반 평가에서 수행된 [각 과제]에 대해 합격 점수를 도출하는 방법을 검토했지만, 종종 [시험 수준]의 합격 점수가 필요하다.

- 수험생이 시험한 [각 과제나 기술]에서 합격점을 받아야 하는 경우 기준은 접속적conjunctive이다.

- 모든 직무 또는 기술에 걸친 성과를 고려할 경우, 표준은 보상적compensatory 이다.

Although we have reviewed methods that would derive passing scores for each task performed in the performance-based assessment, a passing score at the examination level is often needed.

- If examinees must receive a passing score on each task or skill tested, the standard is conjunctive.

- If performance across all tasks or skills is considered, the standard is compensatory (Haladyna & Hess 1999; Ben-David 2000).

각 작업의 통과를 요구할 것인지 아니면 성능을 전반적으로 고려할 것인지를 결정할 때 고려해야 할 몇 가지 요소가 있습니다.

- 첫째, 수험생 수행능력은 과제마다 서로 다를variable 가능성이 높다. 즉, 각 수험생의 성적에 불일치가 있을 가능성이 높다. 수험자는 하나의 과제에서 다른 과제보다 더 나은 수행능력을 보여줄 것이다.

- 또한 개별 과제에 대한 신뢰도reliability는 모든 과제에 대한 신뢰도reliability보다 훨씬 낮을 가능성이 높다.

- [결합적conjuctive 표준]은 더 많은 수의 학생이 불합격하게 될 가능성이 높기 때문에, 시험에 불합격하는 결과와 재학생 또는 반복학습의 [로지스틱스]를 고려해야 한다(Ben-David 2000).

- [보상적compensatory 표준] 설정에는 검사 점수를 도출하기 위해 모든 작업에 걸쳐 성능을 평균(또는 합계)하는 작업이 포함됩니다. 보상적 표준은 수험생들이 한 과제의 낮은 성적을 다른 과제의 더 나은 성과로 보상할 수 있도록 한다. [과제(또는 기술)가 서로 상관관계가 있는 정도]에 따라 보상적 결정과 연결적 결정에 대한 지원을 제공할 수 있다(Ben-David 2000).

When deciding whether to require passing each task or considering performance overall, there are several factors to consider.

- First, examinee performance is likely to be variable from task to task. That is, there is likely to be inconsistency in the performance of each examinee. On some tasks, an examinee will have a better performance than on others.

- In addition, the reliability of the individual tasks is likely to be much lower than the reliability across all tasks.

- Because conjunctive standards are likely to result in a higher number of students failing, the consequences of failing the examination and the logistics of resitting or repeating instruction must be considered (Ben-David 2000).

- Compensatory standard setting involves averaging (or summing) performances across all tasks to derive the examination score. Compensatory standards allow examinees to compensate for poor performance on one task with better performance on another. The degree to which the tasks (or skills) correlate with each other can provide support to the compensatory vs. conjunctive decision (Ben-David 2000).

또 다른 방법은 성적이 [수험생에게 어떻게 보고되는지]를 고려하는 것이다. 이 결정은 표준 설정 프로세스를 관리하는 사람들이 파생된 합격 점수를 어떻게 사용할지 결정해야 하기 때문에 중요하다.

- 접속 모델에서는 수험생이 시험에 합격하기 위해서는 과제별 점수를 맞추거나 초과해야 한다.

- 보상 모델의 경우 과제별 평균 합격 점수를 사용하여 시험 수준 합격 점수를 설정할 수 있습니다.

[OSCE 스테이션]의 경우, 업무 전반에 걸쳐 의사결정을 내릴 수 있지만(보상적), 각 기술(예: 의사소통, 임상적 의사 결정)을 통과해야 시험에 합격할 수 있다. 수험생에게 제공되는 피드백에 대한 고려는 시험 수준 합격 점수를 설정하는 데 보상, 접속 또는 조합이 사용될 것인지를 결정하는 데 중요한 역할을 할 것이다.

Another option is to consider how performance is reported to examinees. This decision is important because those managing the standard setting process will need to decide how the derived passing scores will be used.

- In the conjunctive model, examinees must meet or exceed the score for each task in order to pass the examination.

- For the compensatory model, the average passing score across tasks can be used to set the examination-level passing score.

With OSCE stations, it may be that decisions can be made across tasks (compensatory) but each skill (e.g. communications, clinical decision-making) must be passed in order to pass the examination. Consideration of the feedback provided to the examinees will play an important role in determining whether compensatory, conjunctive, or a combination will be used to set the examination level passing score.

절충 방법

Compromise methods

[표준 설정 패널 목록]의 결과가 합격 점수를 결정하는 데 가장 중요한 요소이지만, 시험에 적용될 최종 합격 점수를 결정하는 데 추가 정보가 종종 사용된다. 고려되는 정보의 한 가지 유형은 합격 점수에 대한 합격-불합격 비율이다. 호프스티(1983년), 뷰크(1984년) 및 드 그루이테르(1985년)가 제안한 타협적 접근법은 패널리스트들에게 합격 점수와 합격(또는 불합격) 비율을 모두 고려하도록 명시적으로 요청한다. 각 접근 방식은 심판들이 "허용되는" 통과 점수와 통과 비율을 구성하는 것에 대한 의견을 가지고 있다고 가정한다.

Although results from the standard setting panellists are the most important elements in determining the passing score, additional information is often used to determine the final passing score that will be applied to examinations (Geisinger 1991; Geisinger & McCormick 2010). One type of information that is considered is the pass–fail rate for the passing score. The compromise approaches proposed by Hofstee (1983), Beuk (1984), and De Gruijter (1985) explicitly ask the panellists to consider both the passing score and the passing (or failing) rate. Each approach assumes that the judges have an opinion about what constitutes an “acceptable” passing score and passing rate.

호프스티는 [선택된 합격 점수]는 [모든 가능한 합격 점수] 중 하나일 뿐이라고 제안했다. 또한 가능한 모든 불합격률을 표시할 수 있습니다. 패널이 이러한 데이터를 고려했는지 확인하기 위해 설정 중인 표준(예: 최소 역량, 숙련도 등)이 논의되고 심사 과정의 세부 사항이 검토되며 패널은 다음 4가지 질문에 답해야 합니다.

Hofstee suggested that the chosen passing score was only one out of a universe of possible passing scores. In addition, it is feasible to plot all possible failure rates. To ensure that panellists have considered these data, the standard that is being set (e.g. minimal competence, proficiency, etc.) is discussed, the details of the examination process are reviewed, and the panellists are asked to answer four questions:

- 수용가능한 최저 합격률은 얼마인가? (최소 불합격률, fmin)

- 수용가능한 최고 합격률은 얼마인가? (최대 불합격률; fmax)

- 합격으로 간주되는 최저 합격 백분율 정답 점수는 얼마입니까? (최소 합격 점수; kmin)

- 합격으로 간주되는 최고 합격 백분율 정답 점수는 얼마입니까? (최대 합격 점수; kmax)

- What is the lowest acceptable percentage of students who fail the examination? (Minimum fail rate; fmin)

- What is the highest acceptable percentage of students who fail the examination? (Maximum fail rate; fmax)

- What is the lowest acceptable percent correct score that would be considered passing? (Minimum passing score; kmin)

- What is the highest acceptable percent correct score that would be considered passing? (Maximum passing score; kmax)

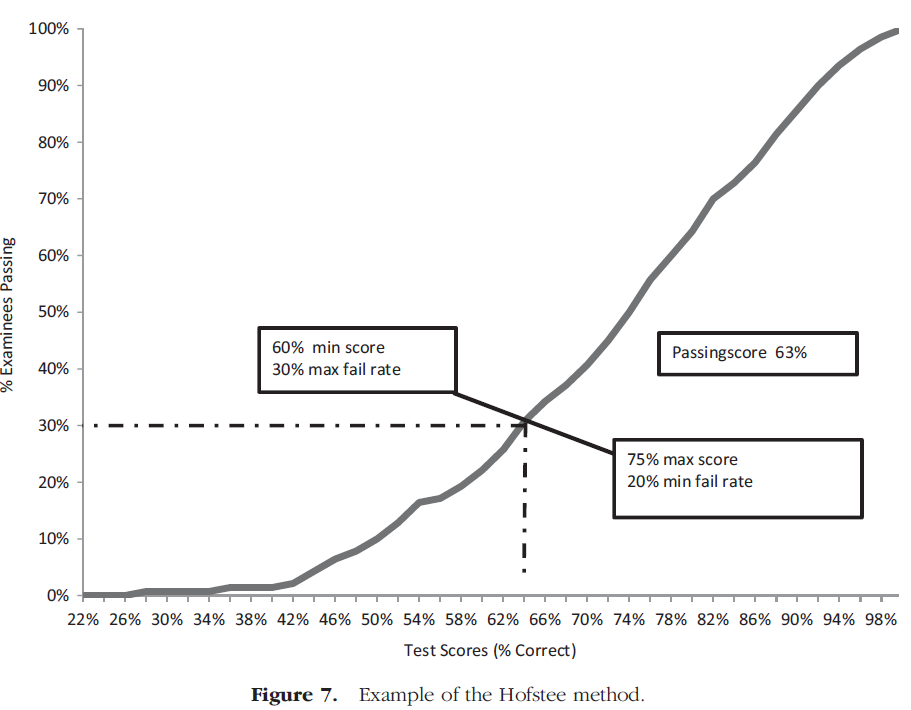

네 개의 데이터 점은 모든 심판에서 평균을 내어 계산됩니다. 표준 설정 패널의 네 가지 판단에 따라 시험에서 모든 합격점수에 합격할 수 있는 수험자의 비율이 그래프로 표시되고 네 가지 데이터 포인트가 표시됩니다. 그림 7은 Hofstee 방법의 적용 예를 보여줍니다. 이 예제에서는 140명의 학생이 50개 항목의 연말 시험을 치렀습니다.

The four data points are calculated by averaging across all judges. The percentage of examinees that would pass for every possible value of the passing score on the test is graphed and the four data points are plotted, based on the four judgments of the standard setting panel. Figure 7 provides an example of application of the Hofstee method. In this example, 140 students took a 50-item end-of-year test.

차트의 곡선은 시험에서 백분률 점수에 기반한 예상 불합격률을 나타냅니다. 강사들은 위에 나타난 네 가지 질문을 받았다.

The curve in the chart shows the projected failure rate based on percent correct scores on the test. Instructors were asked the four questions that appeared above:

- 수용가능한 학생들의 최저 합격률은 얼마인가? 평균: 20%

- 수용가능한 학생들의 최고 합격률은 얼마인가? 평균: 30%

- 합격으로 간주될 수 있는 최저 허용 백분율 정답 점수는 얼마입니까? 평균: 60%

- 합격으로 간주될 수 있는 최고 허용 백분율 정답 점수는 얼마입니까? 평균: 75%

- What is the lowest acceptable percentage of students who fail the examination? Average: 20%

- What is the highest acceptable percentage of students who fail the examination? Average: 30%

- What is the lowest acceptable percent correct score that would be considered passing? Average: 60%

- What is the highest acceptable percent correct score that would be considered passing? Average: 75%

심사위원의 정보를 사용하여 두 가지 포인트를 표시합니다. 즉, 허용 가능한 최저 불합격률과 허용 가능한 최고 정답률 점수의 교차점과 허용 가능한 최저 정답률 점수의 교차점입니다(그림 7 참조). 이 두 점은 정확한 점수와 예상 고장률로 정의되는 곡선과 교차하는 선을 생성합니다. 통과 점수는 교차점에서 x축까지의 점선을 따라(올바른 점수 백분율) 찾습니다. 실패율은 교차점에서 Y축까지의 점선을 따라(실패율) 구합니다.

Using the information from the judges, two points are plotted: the intersection of the lowest acceptable fail rate and the highest acceptable percent correct score; and the intersection of the highest acceptable fail rate and the lowest acceptable percent correct score (see Figure 7). These two points create a line that intersects the curve that is defined by percent correct score and projected failure rate. The passing score is found by following the dotted line from the intersection to the x-axis (percent correct scores). The fail rate is found by following the dotted line from the intersection to the y-axis (percent fail).

Beuk(1984)는 Hofstee 방법을 수정하여 최종 합격 점수를 도출할 때 패널리스트들이 각각의 판단을 어느 정도까지 고려해야 하는지를 보고해야 한다고 제안했다. 즉, 패널들은 그들의 결정이 어느 정도 [수험생 중심적]이거나 [시험 중심적]인지에 대한 질문을 받는다. [합격 점수]와 [합격 비율]의 [평균]과 [표준 편차]가 계산된다. 평균 합격률과 평균 합격 점수가 표시됩니다. 이 두 점이 교차하는 점이 차트에서 식별됩니다. 절충안은 합격률의 표준 편차와 합격 점수의 표준 편차의 비율을 사용하는 것으로 구성된다. 점수의 분포가 기울기를 기준으로 생성된 선과 교차하는 점이 합격 점수를 구성한다. De Gruijter(1985)는 패널리스트에게 이 두 가지 판단에 대한 불확실성 수준에 대한 추가 질문을 제기할 것을 추가로 제안했다. 뵈크와 드 그뤼테르의 방법은 의학 교육에 대한 문헌에 보고되지 않았지만, 호프스티의 방법은 많은 연구자들에 의해 사용되어 왔다.

In a modification of Hofstee method, Beuk (1984) suggested that the panellists report to what extent each of their judgments should be considered in deriving the final passing score. That is, panellists are asked the degree to which their decisions are examinee-oriented or test-oriented. The means and standard deviations of both the passing scores and acceptable pass rates are computed. The mean passing rate and mean passing score are plotted. The point on the chart where these two points intersect is identified. The compromise consists of using the ratio of the standard deviation of pass rate to the standard deviation of passing score. The point where the distribution of scores intersects the line generated based on the slope constitutes the passing score. De Gruijter (1985) further suggested that an additional question be posed to panellists, that of the level of uncertainty regarding these two judgments. Beuk's and De Gruijter's methods have not been reported in the literature for medical education, but the Hofstee method has been used by a number of researchers.

쉰들러 외 연구진은 외과 임상실습생의 합격 점수를 설정하기 위한 호프스티 접근법의 사용에 대해 보고했다. 개별평가(객관식, OSCE, 실습 성적, 프로페셔널리즘 등급) 대신 임상실습생 전체에 대한 합격점수를 설정하는 것이 목표였기 때문에 표준설정위원회는 [호프스티 방식]의 사용이 적절하다고 판단했다. 서로 관련되어 있는 평가를 여러 개 사용하면 프로페셔널리즘이 부족하더라도, 보상적인 기준이 마련될 것이라는 결론을 내렸다. 패널리스트는 호프스티 방식의 네 가지 질문에 답하기 전에 루브릭과 시험 자료를 채점하고, 예년에 불합격한 학생뿐만 아니라 모든 학생에 대한 점수 분포를 검토했다. 저자들은 판사들 사이에 높은 수준의 동의가 있었고, 도출된 합격률이 이전의 사무직 데이터에 적용되었을 때 합리적이라는 것을 발견했다.

Schindler et al. (2007) reported on the use of the Hofstee approach to set passing scores for a surgery clerkship. Because the goal was to set a passing score for the clerkship as a whole instead of individual assessments (multiple-choice examinations, OSCEs, clerkship grades, ratings of professionalism) the standard setting panel determined that the use of the Hofstee method was appropriate. The use of multiple, related assessments led the group to conclude that compensatory standards would be set, although a breech in professionalism could result in failing. Panellists reviewed score distributions for all students as well as those who had failed in previous years, along with scoring rubrics and examination materials before they responded to the four questions in the Hofstee method. The authors found that there was a high level of agreement amongst the judges, and that the pass rate derived was reasonable when applied to previous clerkship data.

표준 설정 방법 선택

Selecting a standard setting method

많은 방법들이 이용 가능한 상황에서, 어떤 방법이 "최고의" 방법인지 결정하는 것은 어려워 보일 수 있다. 표준 설정 방법을 선택할 때 [실용적인 고려 사항]이 있습니다. 이 방법은 [정보에 기초한 판단]을 허용해야 한다. 수행능력 데이터에 비추어 [전문가의 판단을 허용하는 과정]이 바람직하다. 선택한 방법은 평가 목표와 밀접하게 일치해야 합니다. 그 방법은 과정에 참여하는 사람들의 사려 깊은 노력이 요구되어야 하며, 그것은 연구에 기초해야 한다. 마지막으로, 방법은 참가자들에게 설명하기 쉬워야 하며, 구현하기 쉬워야 한다.

With many methods available, it may seem difficult to decide which the “best” method is. When selecting a standard setting method, there are practical considerations to be made. The method should permit judgments that are based on information; processes that permit expert judgment in light of performance data are preferable. The method chosen should be closely aligned with the goal of assessment. The method should require thoughtful effort of those participating in the process, and it should be based on research. Finally, the method should be easy to explain to participants, and easy to implement.

[합격선 설정 연구]는 [권장합격점수]를 생성하며, [시험목적]과 [합격선 설정 프로세스]에 맞는 수행수준에 해당해야 한다는 점을 명심해야 한다. 예를 들어,

- 시험이 [추가 훈련이나 교정조치가 필요할 수 있는 학생]의 식별에 사용되는 경우, [합격]은 [다음 단계의 학습에 준비가 된 학생] 그룹을 나타내며, [불합격]은 [과정을 반복해야하는 그룹]을 식별한다. 이 경우 성과 수준은 독립적 실무 역량에 해당하는 수준만큼 높지 않을 수 있다.

- 만약 시험이 [졸업할 준비가 된 사람]을 선별하여 [감독하 진료]를 하는 환경에 들어가는 데 사용된다면, 시험을 [통과]한 사람들은 [감독하 진료에 들어갈 준비와 관련된 특징]을 가지고 있다. 이 시험들을 통과한 결과는 다른 의미를 가지며, 합격 점수의 최종 결정은 이러한 차이를 고려하게 될 것이다.

최선의 방법을 식별할 수는 없지만, 이 가이드에 기술된 실제 고려사항뿐만 아니라 테스트의 목적에 기초하여 선택해야 한다.

It is important to keep in mind that the standard setting study will generate a recommended passing score and that the score should correspond to a level of performance that meets the purpose for the test and the standard setting process. For example,

> if the test is used for identification of students who may need additional training or remediation, then passing denotes the group of students ready for the next phase of study, while failing identifies the group who may repeat the course. In this case the level of performance may not be as high as the level that corresponds to competence in independent practice.

> If the test is used to represent those who are ready to graduate, and enter a setting with supervised practice, those who pass the test possess the characteristics associated with readiness to enter supervised practice. The result of passing these tests has different meanings and the final determination of the passing score will take these differences into account.

While it is not possible to identify the best method, the selection should be based on the purpose of the test, as well as practical considerations delineated in this guide.

표준 구현

Implementing the standard

표준 설정 연구는 "권장" 합격 점수를 생성하기 때문에 [합격선 설정 프로세스의 결과를 구현하기 전]에 고려해야 할 추가적인 문제들이 있다. 내려야 할 중요한 결정 중 하나는 합격 점수가 [보상]점수가 될 것인가 아니면 [결합]점수가 될 것인가 하는 것이다.

- OSCE 및 표준화된 환자 검사의 경우 일반적으로 여러 스테이션이 포함된다. 평가가 사례별로 평균(또는 합산)되는 경우, 합격 점수는 유사한 방식으로 생성되어야 한다(예: 사례들의 평균 또는 합산). 이 예에서 합격선은 [보상적]인 것으로 간주됩니다. 합격 점수를 충족하거나 초과한 사람은 합격할 것이며, 한 스테이션에서 저조한 성능은 다른 스테이션에서 더 나은 성능을 통해 보상될 수 있습니다.

- 또는 각 사례/스테이션에 대해 합격 점수를 얻을 수 있으며, 평가를 통과하기 위해 정해진 수의 사례를 통과해야 한다는 추가 요구사항이 있을 수 있다. 이 경우 합격선은 [결합적conjuctive]일 것이다. 사례는 종종 임상 및 대인관계 기술을 모두 측정하기 때문에 이러한 기술 각각에 대해 합격 점수를 생성할 수 있으며, 합격 요건은 각 기술 영역에서 합격 점수를 충족하거나 초과해야 한다. 이 접근법도 [결합적]인 것으로 간주될 것이다.

Since the standard setting study will generate a “recommended” passing score, there are additional issues to be considered before implementing the results of the standard setting process. One important decision to make is whether the passing score will be compensatory or conjunctive.

> For OSCEs and standardised patient examinations, several stations are typically included. If the assessment is averaged (or summed) across cases, the passing score should be generated in a similar fashion (i.e. averaged or summed across cases). In this example, the standard would be considered compensatory; those who meet or exceed the passing score will pass, and poor performance at one station can be compensated by better performance at another station.

> Alternately, a passing score could be derived for each case/station, and an additional requirement could be that a set number of cases have to be passed in order to pass the assessment. In this case, the standard would be conjunctive. Because cases often measure both clinical and interpersonal skills, passing scores could be generated for each of these skills, and the requirement to pass would be to meet or exceed the passing score in each skill area. This approach would also be considered conjunctive.

합격-불합격 결정이 [보상적 결정]인지 또는 [결합적 결정]인지를 결정할 때, 이 영역에서 수행된 연구를 고려하는 것이 중요하다. 서로 다른 과제에 대한 성과는 상당히 가변적일 수 있으며(Traub 1994), 단일 사례에 대한 성과는 시험자의 능력을 신뢰할 수 있는 지표가 될 가능성이 낮다(Linn & Burton 1994).

- 개별 스테이션에 기초한 [결합적 합격선]은 불합격율을 높이고 측정 오류로 인해 잘못된 결정을 내릴 수 있습니다.

- 스킬 영역에 기반한 [결합적 합격선]에서도 불합격율이 높아지겠지만, [영역별 보상 없이] 영역별 합격점수를 충족하도록 요구하는 것이 타당하다.

When deciding whether the pass–fail decision will be compensatory or conjunctive, it is important to consider the research done in this area. Performance on different tasks can be quite variable (Traub 1994), and performance on a single case is not likely to be a reliable indicator of an examinee's ability (Linn & Burton 1994).

- Conjunctive standards based on individual stations will result in higher failure rates, and can result in incorrect decisions due to measurement error (Hambleton & Slater 1997; Ben-David 2000).

- While higher failure rates will also result from conjunctive standards based on skill area, it is reasonable to require that the passing score be met for each area without compensation in each area.

벤-데이비드(2000)는 보상적 및 결합적 합격선에 대한 결정을 내리는 데, [평가에 의해 측정된 구조]에 대한 고려가 필수적이라고 제안한다. [평가의 목적]과 [결과에 대한 피드백]은 의사결정에 포함시켜야 할 중요한 기준이다. 예를 들어, 수험생들이 신체검사 기동을 개선해야 하지만, 병력청취와 의사소통 능력이 충분하다는 것을 알게 하는 것은 매우 유용할 것이다. 이 경우 측정된 기량을 바탕으로 별도의 합격 점수를 정하는 것이 합리적일 것이다.

Ben-David (2000) suggests that consideration of the construct measured by the assessment is essential in making a decision about compensatory and conjunctive standards. The purpose of the assessment and the feedback given regarding the results are important criteria to include in making a decision. For example, it would be very useful to have examinees know that they need to improve their physical examination manoeuvres, but that their history taking and communication skills are adequate. In this case, it would be reasonable to set separate passing scores based on skills measured.

시험 결과를 [수험생과 다른 이해관계자에게 보고하는 형식]도 고려 대상이다. OSCE가 연말 평가로 관리되는 경우, 낙제 학생(및 강사)은 기술 향상에 노력을 집중할 수 있도록 강점과 약점의 영역에 대해 알고 싶어할 수 있다. 심지어 합격한 학생들도 그들이 개선할 수 있는 부분이 있었는지 알고 싶을 것이다. 피드백을 제공하는 것은 특히 낙제 수험생들에게 중요하다.

Another consideration is the format of reporting the results of the examination to test-takers and other stakeholders. If the OSCE is administered as an end-of-year assessment, students who fail (and their instructors) may want to know about areas of strength and weakness, so that they can concentrate their efforts on skill improvement. Even students who pass may want to know whether there were any areas in which they could improve. Providing feedback is important, particularly for failing examinees (Livingston & Zieky 1982; American Educational Research Association et al. 1999).

마지막으로, [합격자 비율]에 대한 고려가 필수적이다. 생성된 결정의 결과를 이해하는 것은 의사결정자들이 프로세스를 이해하고 지지하도록 보장하는 데 필수적이다. 표준설정회의 중 권장합격점수를 생성하는 것은 실현가능하지 않으므로, 이해관계자(예: 교직원, 부서장)와의 회의를 실시하여 연구결과를 알리고, 시사점(즉 합격 인원)을 제시해야 한다.

Finally, consideration of the percentage of examinees passing is essential. Understanding the consequences of the decisions generated is vital to ensuring that decision makers comprehend and endorse the process. It is not likely that it will be feasible to generate the recommended passing score during the standard setting meeting, so a meeting with stakeholders (e.g. faculty members, head of departments) should be conducted to inform them of the results of the study, and to present the implications (i.e. number passed).

합격선 유지

Maintaining the standard

회의를 수행하고 합격 점수를 생성하고 승인한 후에는, 다음 테스트 사이클에서 합격 점수를 어떻게 생성할 것인지 고려해야 합니다. 수험생의 성적과 시험 난이도가 행정마다 달라질 수 있기 때문에, 같은 합격점수도 시간이 지나면 같은 효과를 내지 못할 수 있다. 시험자료가 개정되면 다시 한 번 표준설정회의를 진행하는 것이 필수다. 시험자료가 변경되지 않더라도 수험생의 성적과 난이도는 물론 합격점수 시행의 결과(즉 합격률 변화)를 모니터링하는 것이 중요하다.

- 시험이 쉬워지고(즉, 수험생이 더 높은 점수를 얻는 것) 합격 점수가 그대로 유지되면 합격률이 높아질 가능성이 높다.

- 반대로 시험이 어려워지면 합격률이 떨어질 가능성이 높다.

정기적으로 시험과 관련된 변화를 고려하여 표준 정의와 합격 점수를 재검토하는 것이 좋다. 시험이 다음 수준의 훈련으로 진행되거나 독립적인 실무에 들어가는 것을 의미하는지 여부에 관계없이 수험자 자격을 결정하는 데 사용되는 경우 시험 성과를 모니터링하는 것이 필수적이다.

Once the meetings have been conducted and the passing score has been generated and endorsed, it is time to consider how the passing score will be generated for the next testing cycle. Because the performance of examinees and the difficulty of the test can change from administration to administration, the same passing score may not have the same effect over time. If test materials are revised, it is essential to conduct the standard setting meeting once again. Even if the test materials are not changed, it is important to monitor the performance of examinees and difficulty of the test, as well as the consequences of implementing the passing score (i.e. changes in passing rates).

- If the test becomes easier (i.e. examinees obtain higher scores) and the passing score remains the same, the passing rate is likely to increase.

- Conversely, if the test becomes more difficult, the passing rate is likely to decrease.

Revisiting the definition of the standard as well as the passing score in light of changes associated with the test on a regular basis is advised. Monitoring test performance is essential if the test is used for determining examinee qualifications, whether it means going on to the next level of training or entering independent practice.

결론들

Conclusions

[객관식 시험]과 [수행능력 기반 시험]에 대해 합격선 설정에 대한 광범위한 연구가 있지만, "올바른" 합격점수와 "최고의" 방법은 없다. 방법에 따라 결과가 달라집니다. 검사 목적과 표준 설정 작업에 사용할 수 있는 리소스에 따라 방법 선택이 달라집니다. 제시된 방법, 제공된 지침 및 사례들은 방법의 선정, 표준 설정 회의 준비, 회의의 실시 및 얻은 데이터의 분석, 표준의 구현 및 유지에 관한 결정을 알리기 위한 정보를 제공하기 위한 것이다.

Although there is extensive research on standard setting with both multiple-choice and performance-based tests, there is no “right” passing score, and no “best” method. Different methods yield different results. Selecting a method depends on the purpose of the examination and the resources available for the standard setting effort. The methods presented, the guidelines provided, and the examples given are meant to provide information to inform decisions regarding selection of a method, preparation for a standard setting meeting, conducting the meeting and analysing the data obtained, and implementing and maintaining the standard.

Med Teach. 2014 Feb;36(2):97-110. doi: 10.3109/0142159X.2013.853119. Epub 2013 Nov 20.

How to set standards on performance-based examinations: AMEE Guide No. 85

PMID: 24256050

Abstract

This AMEE Guide offers an overview of methods used in determining passing scores for performance-based assessments. A consideration of various assessment purposes will provide context for discussion of standard setting methods, followed by a description of different types of standards that are typically set in health professions education. A step-by-step guide to the standard setting process will be presented. The Guide includes detailed explanations and examples of standard setting methods, and each section presents examples of research done using the method with performance-based assessments in health professions education. It is intended for use by those who are responsible for determining passing scores on tests and need a resource explaining methods for setting passing scores. The Guide contains a discussion of reasons for assessment, defines standards, and presents standard setting methods that have been researched with performance-based tests. The first section of the Guide addresses types of standards that are set. The next section provides guidance on preparing for a standard setting study. The following sections include conducting the meeting, selecting a method, implementing the passing score, and maintaining the standard. The Guide will support efforts to determine passing scores that are based on research, matched to the assessment purpose, and reproducible.

'Articles (Medical Education) > 평가법 (Portfolio 등)' 카테고리의 다른 글

| 객관식 시험 자료의 사후 분석 - 고부담 시험 모니터링 및 개선: AMEE Guide No. 66 (Med Teach, 2012) (0) | 2022.09.09 |

|---|---|

| 객관식 시험의 사후 분석 AMEE Guide No. 54 (Med Teach, 2011) (0) | 2022.09.09 |

| 평가자의 합격선설정과정에 대한 이해와 수행능력을 지원하기 위한 피드백(Med Teach, AMEE Guide No. 145) (0) | 2022.09.07 |

| 교육적 평가의 타당화: 시뮬레이션 등을 위한 프라이머(Adv Simul (Lond). 2016) (0) | 2022.08.19 |

| 테크놀로지-강화 평가: 오타와 합의문과 권고(Med Teach, 2022) (0) | 2022.08.18 |