테크놀로지-강화 평가: 오타와 합의문과 권고(Med Teach, 2022)

Technology enhanced assessment: Ottawa consensus statement and recommendations

Richard Fullera, Viktoria C. T. Goddardb, Vishna D. Nadarajahc , Tamsin Treasure-Jonesd, Peter Yeatese , Karen Scottf , Alexandra Webbg, Krisztina Valterh and Eeva Pyoralai

배경

Background

2011년 이전의 오타와 기술 강화 평가(TEA) 합의 성명 이후, 기술 향상은 평가 관행을 혁신할 수 있는 이전에는 상상할 수 없었던 가능성을 실현했습니다(Amin et al. 2011). 테크놀로지와 교육의 인터페이스가 직원, 학습자 및 기관을 연결하는 학습, 교육 및 평가에 대한 새로운 접근 방식을 개발함에 따라 흥미로운 새로운 지평이 계속 드러나고 있다(Alexander et al. 2019). 이러한 연결성은 점점 더 쉽게 액세스할 수 있는 '빅 데이터'와 결합되어 개인화된 평가와 시기적절한 피드백을 제공할 수 있는 실질적인 기회를 제공합니다.

Since the previous Ottawa Technology Enhanced Assessment (TEA) consensus statement of 2011, technology enhancements have realised previously unimagined possibilities to innovate assessment practices (Amin et al. 2011). Exciting new horizons continue to be revealed as the interface of technology and education develops new approaches to learning, teaching, and assessing, connecting staff, learners, and institutions (Alexander et al. 2019). This connectivity, coupled with increasingly accessible ‘big data,’ presents real opportunities to deliver personalised assessment and timely feedback.

그러나 평가에서 (새로운) 테크놀로지를 무비판적으로 채택하는 것은 (평가 보안 및 시스템 장애에 걸친 우려에서 학문적 무결성을 포함하여 학습자와 교수진에 미치는 영향에 이르기까지) 상당한 위험을 초래한다(Andreou et al. 2021). 혁신의 기회 또는 테크놀로지의 오용 및 잘못된 적용 가능성(예: 의사 결정을 촉진하기 위한 분석 사용)은 교육이 제공되는 환경에서 학습자, 교수진 및 조직에 복잡한 [학문적 및 윤리적 딜레마]를 가져옵니다.

However, uncritical adoption of (new) technologies in assessment brings substantial risk, from concerns spanning assessment security and systems failure through to their impact on learners and faculty, including academic integrity (Andreou et al. 2021). Opportunities for innovation, or the potential for misuse and misapplication of technology (for example, the use of analytics to drive decision making), bring complex academic and ethical dilemmas for learners, faculty, and organisations in settings where education is delivered.

우리는 테크놀로지를 비교적 '새로운' 구인construct으로 인식할 수도 있지만, 역사적으로 [사용 및 경험을 통해 테크놀로지를 적용할 수 있는 '규칙'을 생성하는 동시에, 테크놀로지 업그레이드 및 혁신의 역동적이고 가속화하는 지형과 씨름하면서] 혁신은 교육에 도전해 왔습니다. 테크놀로지 변화의 속도는 교육 개혁보다 훨씬 더 빠르며, 영원한 '따라잡기catch up' 감각을 만들어낸다. 이러한 지속적인 도전은 이러한 변화와 함께 교육자들이 평가 관행을 혁신하고자 할 때 '정치, 교육학, 실천'의 3원적 인터페이스에 반영된다(Shum and Luck in 2019).

Whilst we might recognize technology as a relatively ‘new’ construct, innovations throughout history have challenged education as we generate ‘rules’ for its application through use and experience, whilst grappling with an increasingly dynamic, accelerating landscape of technology upgrades and innovation. The pace of change in technology continues to be much quicker than educational reform, creating a perpetual sense of ‘catch up.’ This continual challenge is reflected in the triadic interface of ‘politics, pedagogy, and practices’ as educators seek to innovate assessment practices alongside these changes (Shum and Luckin 2019).

2020년 오타와 회의 이후 코로나19 범유행으로 인한 글로벌 혼란이 사회 모든 부문에 영향을 미치고 있다. 교육은 학습자의 세대 간 집단(학전부터 지속적인 전문적 발달까지)에 영향을 미쳐 기관이 원격/온라인 교육을 신속하게 채택하고 적응해야 한다(아리스토브니크 외 2020; 클렐란드 외 2020; 고든 외 2020; 라힘 2020; 파로키 외 2021; 그래프톤-클라케 외 2021). 평가는 특별한 과제를 보았지만 보건 전문 교육(HPE)에서 창의적이고 혁신적인 솔루션을 제공하기 위해 테크놀로지를 채택했다(Fuller et al. 2020; Hegazy et al. 2021). 예를 들어, TEA에서 '온라인 OSCE'(객관적 구조 임상 검사)(Hytönen et al. 2021; Roman et al. 2022)와 같은 새로운 담론이 등장했지만, 이는 우수한 평가 관행과 OSCE의 목적에 대한 정의나 정렬이 부족할 수 있다(Boursicot et al. 2020, 2021). 학습 분석과 같은 다른 제안된 기술 솔루션은 상당한 잠재력을 보여주지만, 현재 중요한 증거 기반이 부족하다(Sonderlund et al. 2019; Archer and Prinslo 2020). 결과적으로, 교육을 혁신하기 위한 테크놀로지 사용을 뒷받침하기 위해 더 큰 연구가 필요하다는 주장이 제기되었고(Ellaway et al. 2020), 이것은 이 새로워진 TEA 합의문을 탐구하는 데 유용한 배경을 제공한다.

Since the Ottawa conference of 2020, global disruption caused by the Covid-19 pandemic continues to impact every sector of society. Education has affected a cross-generational cohort of learners (from pre-school to continuing professional development), necessitating institutions to rapidly adopt and adapt to remote/online education (Aristovnik et al. 2020; Cleland et al. 2020; Gordon et al. 2020; Rahim 2020; Farrokhi et al. 2021; Grafton-Clarke et al. 2021). Assessment has seen particular challenges but has embraced technology to deliver creative, innovative solutions in Health Professions Education (HPE) (Fuller et al. 2020; Hegazy et al. 2021). Whilst new discourses have emerged in TEA, for example, the ‘online OSCE’ (Objective Structured Clinical Examination) (Hytönen et al. 2021; Roman et al. 2022), these may lack definition or alignment to good assessment practice and the purpose of the OSCE (Boursicot et al. 2020, 2021). Other proposed technology solutions, such as learning analytics show significant potential, but currently lack a critical evidence base (Sonderlund et al. 2019; Archer and Prinsloo 2020). Consequently, calls have emerged for a greater scholarship to underpin the use of technology to innovate education (Ellaway et al. 2020), and this provides a helpful backdrop to explore this refreshed TEA consensus statement.

과거를 통해 미래를 볼 수 있을까? 2011년 컨센서스와 새로운 10년을 위한 새로운 프레임워크로부터의 교훈

Looking back to the future? Lessons from the 2011 consensus and a refreshed framework for a new decade

이전의 Ottawa TEA 컨센서스에 의해 예측된 많은 [테크놀로지 혁신]은 이제 평가의 게이미피케이션에서 증가하는 추세와 함께 일상적인 교육 관행(가상 학습 환경, 컴퓨터 기반 평가, 시뮬레이션 및 마네킹 포함)으로 인식될 수 있다(Wang et al. 2016; Prochazkova et al. 2019; Tsoy et al. 2019; Tu.tie et al. 2020; Roman et al. 2022). 또한 지난 10년간 [모바일 기술]의 급속한 확산은 학습자가 임상 작업장에서 정보를 검색할 수 있는 기회를 제공했지만 학생, 임상 교사, 의료 전문가, 환자와 보호자 사이에 긴장을 조성했다(Scott et al. 2017; Harrison et al. 2019; Folger et al. 2021).

Many of the technology innovations forecasted by the previous Ottawa TEA consensus may now be perceived as everyday education practice (including virtual learning environments, computer-based assessment, simulation, and mannequins) with growing trends in the gamification of assessment (Wang et al. 2016; Prochazkova et al. 2019; Tsoy et al. 2019; Tuti et al. 2020; Roman et al. 2022). Furthermore, the rapid spread of mobile technology over the past decade has provided learners opportunities to retrieve information in the clinical workplace but has also created tensions between students, clinical teachers, health care professionals, and patients and carers (Scott et al. 2017; Harrison et al. 2019; Folger et al. 2021).

그러나 [자원과 테크놀로지의 한계]는 [일부 기관이 새로운 테크놀로지를 필요로 하는 교수, 학습 및 평가 관행을 구현할 수 없음을 의미함]을 인식하는 것이 중요하다. 게다가, 모든 학생들이 최신 테크놀로지에 접근할 수 있는 것도 아니다. 이러한 요인들은 테크놀로지 강화 학습에 대한 접근성을 매개로 이미 고착화된 [저자원 환경과 고자원 환경] 간의 격차를 확대한다(Aristovnik et al. 2020). 이전의 합의 이후, 더 넓은 사회에서 등장한 많은 광범위한 '하드웨어' 솔루션은 학습을 평가하는 방법을 근본적으로 변화시켰다. 예를 들면 OSCE(Judd 등 2017; Daniels 등)에서의 태블릿 기반 표시와 직장에서의 스마트폰 지원 평가(Mooney 등 2014; Joynes 및 Fuller 2016)와 같은 것이 있다.

However, it is important to recognise that resource and technology limitations mean that some institutions have been unable to implement teaching, learning, and assessment practices that require new technology. In addition, not all students have access to the latest technology. These factors widen an already established disparity between lower and higher-resourced environments through access to technology-enhanced learning (Aristovnik et al. 2020). Since the previous consensus, many of the broader ‘hardware’ solutions that have emerged in wider society have radically changed how we can assess learning, e.g. tablet-based marking in OSCEs (Judd et al. 2017; Daniels et al. 2019) and smartphone assisted assessment in the workplace (Mooney et al. 2014; Joynes and Fuller 2016).

[테크놀로지 '도구tools']에 초점을 맞추는 것은 유혹적이지만,이전 오타와 프레임워크의 핵심 개념 중 일부는 구현과 연구 질문의 최전선에 남아 있으며, 특히 다음과 관련된다.

- 온라인 환경에서 [기존 평가 과제와 관행을 복제]하기 위한 기술 적용('변환transmediation') 또는

- 시험 및 채점 [속도를 높이는 테크놀로지-지원 평가 도구 사용]의 효율성 향상('보조기구prosthesis').

Whilst it is tempting to explore a focus on technology ‘tools,’ some of the key concepts from the previous Ottawa framework remain at the forefront of implementation and research questions, particularly relating

- to the application of technology to replicate the existing assessment assignments and practices in an online environment (‘transmediation’) or

- to the efficiency in the use of technology-assisted assessment tools that speed up examinations and grading (‘prosthesis’).

TEA는 실생활에서 필요한 지식, 기술 및 행동의 조합 또는 학생의 역량에 대한 진정한authentic 평가를 제공하기 위해 제안되었다(Gulikers et al. 2004). 그러나 [의도하지 않은 구조에 대한 의도하지 않은 평가] 또는 [결과적으로 학습자의 참여와 행동에 영향을 미치는 실제 관행으로부터의 deviation]으로 인해서, [TEA를 통한 진정한 평가]에 대한 위험은 여전히 높다. 2011년 프레임워크는 또한 고비용 및 충실도 평가 기술 관행의 일부 과제에 초점을 맞췄습니다. 특히 학습자와 기관 간의 디지털 불평등의 출현과 이해로 인해 현재 더욱 어려워지고 있습니다(UNESCO 2018). 10년간의 혁신과 연구에도 불구하고 평가의 진실성과 학습의 영향을 둘러싼 몇 가지 핵심 질문이 우리의 생각의 최전선에 남아 있다.

TEA has been suggested to provide authentic assessments (Gulikers et al. 2004) of students' competencies or combinations of knowledge, skills, and behaviours required in real life. However, the risks to authentic assessment through TEA remain high, either through unintentional assessment of unintended constructs, or deviation from real-life practices that consequently affect learner engagement and behaviours. The 2011 framework also focused on some of the challenges of high cost and high-fidelity assessment technology practices—now particularly challenged by the emergence, and understanding, of digital inequity amongst learners and institutions (UNESCO 2018). Despite ten years of innovation and scholarship, some of the key questions posed, surrounding the authenticity of assessment and the impact of learning remain at the forefront of our thinking.

이러한 교훈을 바탕으로, 이 새로워진 프레임워크는 평가가 이루어지는 더 넓은 환경에서 평가, 기술 및 교육 관행에 걸친 광범위한 범위에서 도출된다. 2010-2020년(Auxier et al. 2019)을 형성한 확립된 (교육) 테크놀로지과 능동적 학습의 실천을 뒷받침하는 새로운 테크놀로지 및 이론을 모두 반영한다.

Drawing on these lessons, this refreshed framework draws from broad scoping across assessment, technology, and educational practices in the wider environment in which assessment takes place. It draws on a reflection of both the established (educational) technology that shaped the 2010–2020 decade (Auxier et al. 2019), emergent technologies, and theories that underpin the practice of active learning.

2020년 오타와 컨퍼런스 및 후속 공개 컨설팅 및 워크숍의 직접 워크숍 피드백에 민감한 합의 프레임워크는 다음의 세 가지 핵심 단계로 나뉜다.

- (1) 기술 채택 준비,

- (2) 평가 라이프사이클에 적용(대표적 사례 연구 포함)

- (3) TEA의 평가와 확산을 위한 프로세스

Sensitised by feedback from in-person workshops in the 2020 Ottawa Conference and subsequent open consultation and workshops, the consensus framework is divided into three key stages, spanning

- (1) readiness for technology adoption,

- (2) its application to the assessment lifecycle (supported by illustrative case studies), and

- (3) processes for evaluation and dissemination of TEA.

1단계: 평가 개선을 위한 기술 채택 준비 상태 평가

STAGE 1: Assessing readiness to adopt technology to enhance assessment

기술은 최근 HPE의 학습 및 평가에 대한 많은 COVID 관련 과제에 대한 공통적인 해결책으로, 학회 및 저널 플랫폼에 걸쳐 개별 기관 반응을 보여주는 전체 범위의 학술 커뮤니케이션(예: Khalaf et al. 2020; Jaap et al. 2021)이 있다. 그러나 다른 저자들은 코로나 이전에 존재했던 교육 관행에 대한 많은 우려가 이러한 접근 방식을 통해 해결될 가능성이 낮다고 강조했다(Ellaway et al. 2020). 게다가, 테크놀로지는 형편없는 평가 관행의 영향과 위험을 증가시킬 수 있다. 자동화된 프로세스는 '버튼을 누르면' 상당한 오류가 발생할 수 있으며(예: 부정확한 점수 보고를 통해) 평가 프로세스 주변의 학습자와 교직원의 신뢰에 장기적인 손상을 줄 수 있습니다.

Technology has been a common solution to many of the recent COVID-related challenges to learning and assessment in HPE, with a whole range of scholarly communications illustrating individual institutional responses across conference and journal platforms (e.g. Khalaf et al. 2020; Jaap et al. 2021). However, other authors have highlighted that many of the concerns around educational practice that existed pre-COVID are unlikely to have been resolved through these approaches (Ellaway et al. 2020). Moreover, technology may increase the impact and risk of poor assessment practises. Automated processes may ‘at the push of a button’ generate a substantial error (e.g. through inaccurate score reporting), causing long-lasting damage to learner and faculty trust around assessment processes.

이전 섹션에서 확인한 바와 같이, 평가에서 테크놀로지를 무비판적으로 도입한다는 것은 [잠재적 편익]이 다양한 [잠재적 단점(학업적, 재정적, 제도적)]으로 상쇄될 수 있다는 것을 의미한다. 테크놀로지 도입에 있어 가장 중요한 것은 '평가'를 통해 차선의 평가 관행을 파악하고 해결할 필요가 있다는 것입니다.

As identified in the previous section, non-critical adoption of technology in assessment means potential benefits could be offset by a range of potential disadvantages (academic, financial, and institutional). Critical to the adoption of technology is the need to ‘assess assessment,’ to ensure that any sub-optimal assessment practices are identified and resolved.

이 오타와 합의의 핵심 권고 사항 중 하나는 '기술은 제쳐두고' TEA와 관련된 네 가지 중요한 영역을 조사하는 것입니다.

- 기존 평가 관행의 품질

- TEA 도입의 목적

- 디지털 형평성에 관한 당면 과제

- 테크놀로지를 채택할 수 있는 제도적 역량

One of the key recommendations of this Ottawa consensus is to ‘put aside the technology’ and investigate four critical areas associated with TEA:

- The quality of existing assessment practice

- The purpose of introducing TEA

- Engagement with digital equity challenges

- Institutional capacity to adopt technology

목적에 맞는 평가?

Assessment fit for purpose?

[기존 평가 프로세스에 대한 검토는 TEA 채택 준비의 핵심]이며, 다음에 초점을 맞춰야 합니다.

- 단순히 평가 '도구'뿐만 아니라,

- 보다 광범위한 평가 프로그램과 그것의 이론적 기반

- 평가 제공에 사용된 기존 테크놀로지(예: 강의실 데스크톱 또는 개인용 노트북 컴퓨터 또는 모바일 장치) 를 포함하여

- 평가를 수행할 수 있는 환경(캠퍼스/임상 실습/학습자의 개인 공간)

A review of existing assessment processes is central to readiness for adoption of TEA, and should focus

- not just on assessment ‘tools,’

- but the wider programme of assessment, its theoretical underpinning and

- environments in which assessment may be undertaken (campus/clinical practice/learners’ personal space)

- including any existing technology used to deliver assessment (e.g. classroom desktop or personal laptop computers, or mobile devices).

광범위한 전문가, 목적 적합 규격 및 지침이 이 평가 검토를 지원해야 한다(Norcini et al. 2018; Boursicot et al. 2021; Heeneman et al. 2021; Torre et al. 2021). 시작시에 '평가를 평가하는 것assessing assessment'는 평가가 기존 형식에서 목적에 적합한지 확인하는 데 도움이 될 뿐만 아니라 테크놀로지 채택 전에 해결할 수 있는 잠재적 함정을 식별하는 데 도움이 된다. 또한 평가 관행의 개선을 탐구할 기회를 마련하거나 이 검토의 다음 권고사항에 중심이 될 새로운 개발을 식별한다.

A broad range of expert, fit-for-purpose specifications and guidance should support this assessment review (Norcini et al. 2018; Boursicot et al. 2021; Heeneman et al. 2021; Torre et al. 2021). ‘Assessing assessment’ at the outset helps not just ensure that assessment is fit for purpose in its existing format but identifies potential pitfalls that can be resolved in advance of technology adoption. It also establishes opportunities to explore the enhancement of assessment practices or identifies new developments that will be central to the next recommendation of this review.

TEA를 채택하는 목적은 무엇입니까?

What is the purpose of adopting TEA?

TEA 도입에 앞서 가장 중요한 질문은, 모든 교육 테크놀로지와 마찬가지로, 이 테크놀로지가 학생들의 학습과 이를 지원하는 교수진의 능력을 어느 정도까지 향상시킬 것인가이다(Fuller and Joynes 2015). TEA의 목적이 단지 동일한 평가의 종이 버전을 '대체'하는 것이라면, 평가가 기술에 의해 '향상'될 것이라는 주장은 이미 잃어버린 것과 마찬가지다. 또한 비용이 많이 드는 실수이거나, 더 나쁜 것일 가능성이 높으며, '허영 프로젝트'로 인식될 경우 평판 훼손이 더 오래 지속된다. 대신, 교육자로서, 우리는 과정 내용, 학습 활동, 제안된 평가 및 원하는 과정 결과 간의 정렬을 살펴봄으로써 모든 잘 이론화된 교육 발전을 안내하는 원칙으로 돌아가야 한다(Biggs and Tang 2011; Villaroel et al. 2019). 학습자들은 그들이 배우기 위해 하는 일에 의미를 부여한다. 따라서 교수진은 특정 평가 방법을 구현하는 데 초점을 맞추기보다는 학습 성과 달성을 촉진하는 학습 활동과 평가 과제를 의도적으로 설계해야 한다.

The overriding question ahead of the introduction of TEA should be, as with all educational technology, to what extent will the technology enhance students’ learning and faculty’s ability to support this? (Fuller and Joynes 2015). If the purpose of TEA is only to ‘replace’ a paper version of the same assessment, the argument that the assessment would be ‘enhanced’ by technology is already lost, and could likely be an expensive mistake or worse, have longer lasting reputational damage if perceived as a ‘vanity project.’ Instead, as educators, we need to return to the principles that guide all well-theorised educational developments, looking at alignment between course content, learning activities, the proposed assessment, and the desired outcomes of the course (Biggs and Tang 2011; Villarroel et al. 2019). Learners build meaning on what they do to learn. Thus, faculty should intentionally design learning activities and assessment tasks that foster the achievement of learning outcomes, rather than focussing on implementing specific assessment methods.

[교육학에서 informed된 접근 방]식을 사용하면 팀은 테크놀로지 투자가 (일회성 맞춤형 요소든 프로그램적 접근 방식이든) 자신의 코스에 가장 유의미한 부분이 어딜지 살펴볼 수 있습니다. 그럼에도 불구하고, 단편적인 투자는 거의 지속 가능하지 않으며 학습자와 교수진이 커리큘럼의 단일 영역에서 여러 도구를 사용하는 방법을 배우도록 요청받을 위험이 있다는 점에 주목할 필요가 있다. 고부담 평가를 수반하는 경우, 학습자에게 상당한 인지 부하로 이어질 수 있다(Davies et al. 2010). 새롭고 유망한 테크놀로지가 등장할 때, 평가를 강화하기 위해 이를 도입하려는 결정은 거의 즉시 이루어지지 않으며, 잠재적으로 혁신을 지연시킨다. 그러나 동일한 우려 사항은, (테크놀로지가) 단순히 평가 측면에서 수행되고 있는 것을 '대체'하는 것을 넘어 practice를 발전시키는 데 실패했다는 것입니다.

Using an approach informed by pedagogy will enable teams to look at where investment in technology will be the most meaningful to their courses, either as a one-off bespoke element or as a programmatic approach. Nevertheless, it is worth noting that piecemeal investment is rarely sustainable and risks learners and faculty being asked to learn how to use multiple tools in a single area of a curriculum. If they involve high-stakes assessments, this can lead to a significant cognitive load on learners (Davies et al. 2010). When new and promising technology emerges, decisions to introduce it to enhance assessment are rarely immediate, potentially delaying innovation. However, of equal concern is a failure to evolve practices beyond merely ‘replacing’ what is, and has always been, done in terms of assessment.

주어진 기관에서 TEA의 목적을 고려할 때, 주목할 만한 교육적 설계를 위한 더 넓은 기회가 있다. 소규모 또는 대규모 평가 변경을 가져올 때, 예를 들어, [몰입형 설계의 도입]과 심지어 [평가의 공동 제작]을 통한 과정의 광범위한 전환 측면에서 이점을 활용할 수 있으므로 교육자와 학습자 모두가 그 결과에 투자하고 참여할 수 있습니다. 이것은 학습자들로 하여금 [평가가 자신들과 '함께' 하는 것이 아니라 '그들에게' 행해지는 것이라고 느끼게 만드는] 것을 줄여준다. 평가에 테크놀로지를 도입함으로써, 평가 프로세스를 통해 수집된 데이터를 사용하여 [어떤 학습과 피드백이 이루어지고 있는지 살펴볼 수 있는 기회]도 강화됩니다. 그럼에도 불구하고 이것은 TEA 도입의 긍정적인 부산물이지 도입의 동력이라고 보아서는 안 된다.

Within considerations of the purpose of TEA in any given institution, there are wider opportunities for an educational design that are worth noting. When bringing in either small or large-scale assessment change, it is possible to leverage benefits from the process in terms of wider course transformation through, for example, the introduction of immersive design and even co-production of assessment so that both educators and learners are invested and engaged with the result (Holmboe 2017; Cumbo and Selwyn 2022). This moves away from the perennial challenge of learners feeling that assessment is something that is done ‘to’ them, rather than done ‘with’ them. Through the introduction of technology in assessment, there are also enhanced opportunities to use the data which are gathered through the assessment processes to explore what learning and feedback is taking place. Nevertheless, this should be seen as a positive by-product of the introduction of TEA and not the driving force for its introduction.

TEA 프로세스를 개발하는 데 존재하는 광범위한 기회 내에서, 우리는 또한 그러한 도입이 가져오는 도전을 인식해야 한다. 차세대 학습자가 개인 생활에서 모바일 기기를 유창하게 사용하기 때문에 학습 및 평가에서 새로운 기술을 쉽게 수용하는 이른바 '디지털 네이티브'라는 신념을 수용하는 것을 피해야 할 필요성이 지속적으로 제기되고 있다(Tapscott 1998; Prensky 2001; Bennett et. 2008; Jones 2010; Jones et. 2010). 학습자와 교수진의 테크놀로지 몰입도는 높아졌지만, 이는 주로 [사회적/개인적 공간]에 존재한다. [일상생활에서 디지털 기술을 사용하는 것]과 [학습에서 디지털 기술을 사용하는 것] 사이의 격차는 이전 연구에서 보고되었다(Selwyn 2010; Pyörä et al. 2019). 따라서 HPE는 여전히 모든 학습자와 교육자가 필요로 하는 지원에 초점을 맞춰 TEA를 효과적으로 만들어야 합니다.

Within the broader opportunities that exist in developing TEA processes, we must also be cognisant of the challenges such introduction brings. There is a continued need to avoid embracing the myth that the next generation of learners are so-called ‘digital natives’ who easily embrace the use of new technology in learning and assessment because they use mobile devices fluently in their personal lives (Tapscott 1998; Prensky 2001; Bennett et al. 2008; Jones 2010; Jones et al. 2010). Whilst learners and faculty have increased technology immersion, this primarily exists in their social/personal spaces; gaps between their use of digital technology in their daily life and in learning have been reported in previous studies (Selwyn 2010; Pyörälä et al. 2019). HPE therefore still needs to focus on the support that all learners and educators will need, to make TEA effective.

또한 TEA의 도입은 이미 큰 성취 격차를 더 벌릴 위험도 있다. 한 기관의 다른 [학습자 그룹 간] 또는 [기관 간]에서 발생할 수 있다(Rahim 2020; Hegazy et al. 2021). (이전 교육을 통해 또는 HPE 내에서) 더 나은 IT 시스템, 지원 및 연결성에 [이미 접근하고 있는 사람들]은 [기본적 인프라에서 불안정을 겪거나 박탈에 직면한 사람들]보다 TEA를 도입/채택하는 것이 더 쉽다는 것을 알게 될 것이다(Aristovnik et al. 2020). 기관들과 교육자들은 필연적으로 그들 자신의 지역적 과제에 집중하게 될 것이지만, TEA의 도입으로 제기되는 더 큰 질문 중 하나는 [디지털 형평성]을 촉진하는 기술 변화를 어떻게 바꿔나가고 주도할 수 있는가 하는 것이다.

There is also a risk that the introduction of TEA will widen the already large attainment gaps, between different groups of learners in an institution or between/across institutions (Rahim 2020; Hegazy et al. 2021). Those already with access to better IT systems, support, and connectivity (either through their previous education or within HPE) will find TEA easier to introduce/adopt than those who face instability or deprivation in the basic infrastructure (Aristovnik et al. 2020). While institutions and educators will inevitably be focused on their own local challenges, one of the larger questions posed by the introduction of TEA is how we could steer and drive technology change that promotes digital equity.

TEA에서 디지털 형평성의 중요성은?

The importance of digital equity within TEA?

개별 프로그램 수준에서 TEA는 모든 학습자가 필요한 테크놀로지와 온라인 테크놀로지에 대한 [동등한 접근성]을 갖도록 하기 위해 모든 학습자의 [디지털 형평성]을 보장해야 한다(Alexander et al. 2019). 따라서 온라인 평가를 구현할 때 학습자(및 교수진) 간의 기술적 차이를 제한하기 위해 디지털 형평성을 보장하는 전략이 필요하다. 전략은 학습에 사용되는 장치의 카파시티, 학습(즉, 장치 생성), 운영 체제(예: iOS, Android) 및 필요한 액세서리(예: 카메라, 마이크)를 고려해야 한다. 이 전략은 학생들의 디지털 역량이 특정 업무와 기술과 관련이 있다는 점을 감안하여 각 [온라인 평가에 필요한 디지털 역량]을 포함해야 한다(Bennett et al. 2008). TEA에 대한 디지털 형평성 보장은 한 기관의 프로그램 내에서 학습자 또는 전국적으로 기관 면허/전문 평가를 받기 위해 앉아 있는 피평가자에게 [평가 동등성]을 보장하는 중요한 단계이다(Wilkinson and Nadarajah 2021).

At an individual programme level, TEA needs to ensure the digital equity of all learners to ensure they have the required skills and comparable access to online technology (Alexander et al. 2019). When implementing online assessments, a strategy that ensures digital equity is therefore needed to limit the technological differences between learners (and faculty). Strategies need to consider the capacity of devices used for learning (i.e. the generation of devices), operating systems (e.g. iOS, Android), and accessories required (e.g. camera, microphone). The strategy ought to include the digital capabilities students need for each online assessment, given that students’ digital capabilities relate to specific tasks and technologies (Bennett et al. 2008). Ensuring digital equity for TEA is a crucial step to ensuring assessment equivalence for learners within a programme in one institution or for candidates sitting for licencing/professional assessments across institutions nationally (Wilkinson and Nadarajah 2021).

[디지털 형평성]은 학생들의 기존 기기와 디지털 역량 내에서 작동하는 온라인 평가와 새로운 테크놀로지를 구매해야 하는 학생들을 위한 능력과 비용에 이르는 기기를 나열하는 기기 사양을 통해 강화될 수 있다. BYOD(Bring Your Own Device) 평가의 성공적인 성장은 공동 생성 및 학습자 연결을 촉진하는 학습자가 보유한 커뮤니티 기반 기술의 신중한 사용에 의존했습니다(Sundgren 2017). 가정 내 온라인 평가를 포함하는 프로그램은 학습자의 고속 인터넷 연결의 용량과 안정성을 고려해야 한다.

Digital equity can be enhanced through online assessments that operate on students’ existing devices and within their digital capabilities, and a device specification that lists devices ranging in capability and cost for students who need to purchase new technology. The successful growth of BYOD (Bring Your Own Device) assessments relied on the deliberate use of community-based technologies, held by learners, that facilitate co-creation and learner connectivity (Sundgren 2017). A programme involving in-home online assessments needs to consider the capacity and stability of learners’ high-speed internet connectivity.

그러나, 세계 다른 지역에 위치한 기관들 간의 형평성을 보장하는 TEA의 능력에 대한 더 광범위한 질문이 있으며, 이는 여기서 만들어진 권고안이 [저자원 기관]을 뒤처지게 하지 않도록 하기 위해 명시적인 논의가 필요하다. 유네스코는 디지털 접근성에는 두 가지 차원이 있다고 언급했다.

- 기술적(장치의 연결과 용량을 위한 인프라) 차원

- 사회경제적(저렴성과 학생의 디지털 능력) 차원

[테크놀로지에 대한 불평등한 접근]과 그에 따른 TEA는 [지역사회 간 및 지역사회 내의 기존 소득 및 자원 불평등]과 관련이 있으며 이를 악화시킬 수 있다(UNESCO 2018). 인터넷 사용률이 높은 지역 내에서도 소외된 지역사회는 기회를 놓칠 수 있다. 예를 들어 뉴욕에서는 25%의 가정이 인터넷 접속이 없다(Mozilla 2017). 개별 기관만으로는 이러한 문제를 해결할 수 없을 것 같지만, TEA에서 기술 사용이 잘 될 때, 그리고 더 중요한 것은, 다른 프로그램이 비용이 많이 드는 실수를 하지 않도록 돕기 위해 다양한 기술 솔루션을 시험해 볼 수 있는 사람들이 결과를 공유하는 것이 중요합니다.

However, there are broader questions around the ability of TEA to ensure equity between institutions situated in different parts of the globe, and these need explicit discussion to ensure that recommendations made here do not leave lower resourced institutions behind. UNESCO noted that there are two dimensions to digital accessibility:

- technical (infrastructure for connectivity and capacity of devices) and

- socio-economic (affordability and students’ digital capabilities).

Unequal access to technologies and subsequently to TEA is linked to and can exacerbate, existing inequalities of income and resources between and within communities (UNESCO 2018). Even within areas of high internet use, marginalised communities may be missing out on opportunities; for example, in New York, 25% of homes have no internet access (Mozilla 2017). While individual institutions are unlikely to be able to solve these issues alone, it is vital that those who are able to trial different technological solutions share their results when the use of technology in TEA goes well—and even more importantly, when it goes less well, to help other programmes avoid making costly mistakes.

프로그램, 인력, 제품 및 프로세스?

Programmes, people, products, and processes?

성명서 작성자 및 워크숍 참석자 중 많은 사람의 경험에 비추어 보았을 때, 테크놀로지 채택을 준비할 때 [의도된 결과]보다는 [테크놀로지 자체]에 초점을 맞추는 경우가 많다. 이 접근 방식이 위험한 이유는 테크놀로지는 활성화자enabler가 아니라 [그 자체가 평가 향상의 초점이자 동인]이 된다는 것입니다. 이러한 접근 방식은 또한 개인적인 선호와 이전의 경험에 기초하여 특정 기술 제공자, 제품 또는 솔루션에 과도하게 초점을 맞추는 결과를 초래할 수 있다. 이를 방지하기 위해 본 권고안은 TEA를 채택할 때 포괄적인 팀 기반 접근법으로 '4P' 접근법(프로그램, 인력, 프로세스 및 제품)을 제안한다.

Based on the experiences of many of the statement’s authors and workshop attendees, considerations regarding readiness to adopt technology are often focused on the technology itself rather than the intended outcome. The risk of this approach is that the technology becomes the focus and driver of assessment enhancement rather than the enabler. This approach may also result in an over-focus on a particular technology provider, product, or solution based on personal preferences and previous experiences. To avoid this, this recommendation proposes a ‘4P’ approach (Programmes, People, Processes, and Products) as a comprehensive team-based approach when adopting TEA.

프로그램

Programmes

첫 번째로 [맥락과 교육적 요구]의 프레임에 넣어야 한다. 평가 Blueprint는 현재 구현 격차, 기술 솔루션(있는 경우), 리스크 평가 및 필요한 리소스를 포함하도록 더욱 확장될 수 있습니다. 위험 평가에는 규제 준수에 대한

- 로컬(새로운 형식/승인 일정을 변경/도입하는 과제)과

- 외부(해당되는 경우 국가 및/또는 규제 요건에 대한 지속적인 준수) 및

- 자원(기반시설, 하드웨어 또는 소프트웨어 업그레이드)이 포함되어야 한다.

the first area of consideration should frame the context and educational need. Assessment blueprints can be further expanded to include

- current implementation gaps,

- technological solutions (if any),

- risk assessment, and

- resources needed.

Risk assessments should include

- the impact on regulatory compliance locally (challenges of switching/introducing new formats/approval timelines) and

- (compliance) externally (where appropriate, continued compliance with national and/or regulatory requirements), and

- resources (upgrading infrastructure, hardware, or software).

사람

People

성공적인 구현을 이루려면, 변화 관리의 우선 순위는 항상 사람에게 집중됩니다(Er et al. 2019). 평가 강화와 관련하여 참여해야 할 인력은 [교수진, 전문 지원 인력(예: 시험장, IT) 및 학생] 등 세 그룹으로 구성됩니다. 이 계약에는 개선과 관련된 새로운 스킬과 관련된 교육 및 파일럿 개발 후 피드백을 제공할 수 있는 기회가 포함되어야 합니다. 마찬가지로, 학습자와 전문 지원 인력의 참여는 끝이 아니라 [프로젝트의 시작]에 참여해야 합니다. 학생들은 평가 향상과 협력하거나 공동 개발을 위해 성공적으로 협력할 수 있다(Er. et al. 2019, 2020).

Priorities for change management always focus on people, as their buy-in, participation, and feedback are crucial for successful implementation (Er et al. 2019). In the context of enhancing assessments, there are three groups of people to engage with: faculty, professional support staff (e.g. exam office, IT), and students. It is critical that this engagement includes training related to any new skill sets related to the enhancement and opportunities to give feedback after pilot developments. Similarly, the engagement of learners and professional support staff should be genuine, with their involvement at the start of the project rather than the end. Students can be successfully co-opted to partner with or co-develop the assessment enhancements (Er et al. 2019, 2020).

과정

Processes

평가를 효율적으로 구현하기 위해 관련 이해 관계자들 간에 공유해야 하는 [내부 프로세스]가 있습니다. 그러나 평가를 위해 테크놀로지가 사용되거나 추가될 때, 종종 파편적이거나 직접적인 '잘라서 붙여넣기 접근법'(전환)을 하는 함정에 빠질 수 있다. [평가 데이터 관리]는 특히 이러한 프로세스의 변화에 민감할 수 있습니다. 다양한 레벨에서 [평가 데이터 거버넌스, 보안, 전송 및 보고]에 대한 테크놀로지 향상의 영향을 검토하면 데이터 [상호 운용성]을 지원하고, 테크놀로지 평가의 실패 위험을 줄일 수 있습니다.

To implement assessments efficiently, there are internal processes that should be shared across relevant stakeholders. However, when technology is used or added for assessments, process change pitfalls often include piecemeal or direct ‘cut and paste approaches’ (transmediation). Assessment data management can be particularly susceptible to changes in such processes. A review of the impact of the technology enhancement on assessment data governance, security, transfer, and reporting at different levels can help enable data interoperability and reduce risks of technology assessment failure.

상품들

Products

기술 제품의 선택은 [업무 범위, 접근성, 기관의 지불가능성]에 따라 달라집니다. 전자에 기반한 평가는 제품을 개발하기 위해 외부 조직과 구매, 구축 또는 파트너 관계를 결정하는 것으로 이어질 수 있습니다. 모든 제품을 선택할 때, 기존의 제도적 기술(예: MS Office와 같은 일상적 제품의 모든 능력을 더 잘 활용할 수 있는 기회)과 이미 개인 및 전문 학습을 지원하기 위해서 이용할 수 있는 광범위한 테크놀로지를 갖춘 '현대 전문 학습 도구 키트'의 개념을 신중하게 고려할 필요가 있다. (Hart 2021).

The selection of the technology product depends on its alignment to the scope of work, accessibility, and affordability to the institution. An evaluation based on the former can lead to the decision to buy, build or partner with an external organisation to develop the product. In the selection of any product, careful consideration needs to be given to the utilisation of existing institutional technology (e.g. opportunities to better leverage the full abilities of everyday products, such as MS Office) and the concept of the ‘modern professional learner’s toolkit’ with an extensive range of technology already available to support personal and professional learning (Hart 2021).

2단계: '평가 라이프사이클' 내 기술 적용

STAGE 2: Applying technology within the ‘assessment lifecycle’

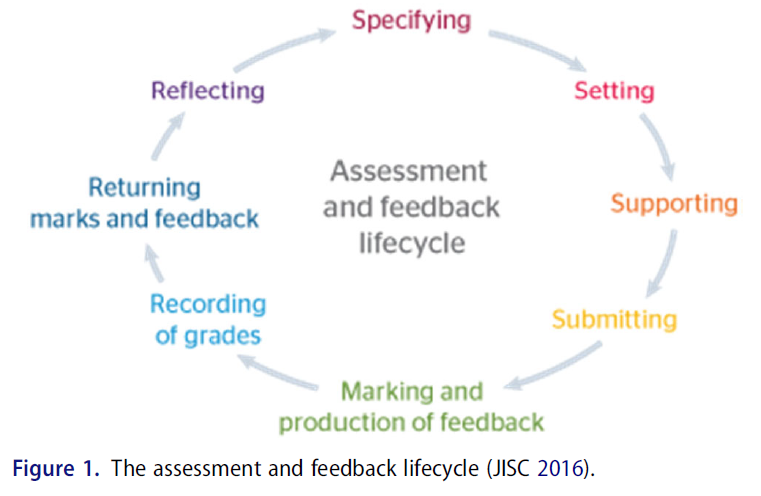

이 논문은 다른 최근의 오타와 합의 진술과 함께 기술을 통한 평가 향상을 안내하는 핵심 원칙의 프레임워크를 제공한다. 보다 광범위한 고등교육 평가 라이프사이클 모델을 지원으로 채택하는 것은 의도적인 것으로, 이 합의의 다중 교육 맥락에 대한 적용 가능성을 극대화한다. 라이프사이클은 평가의 이해관계와 목적에 관계없이 평가에 관련된 모든 핵심 프로세스에 대해 쉽게 식별할 수 있는 '헬리콥터 뷰'를 제공합니다. 라이프사이클 프로세스는 반복적이며, 평가 설계, 스케줄링 및 전달을 무결성 및 행동, 조정 및 학생 진행 추적(JISC 2016)을 둘러싼 주요 학문적 프로세스까지 포괄하는 품질 개선 접근 방식을 가능하게 합니다. 그림 1에 나타난 바와 같이:

In keeping with other recent Ottawa consensus statements, this paper provides a framework of core principles to guide the enhancement of assessment with technology. Adopting a broader Higher Education assessment lifecycle model as support is intentional, maximising the applicability of this consensus to multiple educational contexts. The lifecycle provides a readily identifiable ‘helicopter view’ of all key processes involved in assessment, whatever the stakes and purpose of the assessment. The lifecycle process is iterative, enabling a quality improvement approach that spans assessment design, scheduling, and delivery through to key academic processes surrounding integrity and conduct, moderation, and student progress tracking (JISC 2016). As demonstrated in Figure 1:

이 라이프사이클 접근 방식은 [평가 '도구']에서 [우수한 평가의 시스템과 프로그램], 특히 프로그램 평가에서 볼 수 있는 [전체론적 접근 방식]으로 HPE의 초점 변화를 반영한다(Heeneman et al. 2021). 의료 교육에서 라이프사이클은 OSCE와 같은 복잡한 평가 개입의 설계 및 전달에도 성공적으로 적용되었다. TEA의 컨텍스트에 적용되는 라이프사이클은 [5가지 핵심 초점]과 적용 대상을 제공합니다.

- 평가의 Authenticity 향상(대원칙)

- 학습자를 평가에 참여시킵니다.

- 설계 및 스케줄링을 강화한다.

- 평가 전달 및 학습자 성과 기록을 최적화한다.

- 학습자 진행 과정 및 교수진 활동을 트래킹한다 —종방향 학습 및 지속적인 평가 지원.

This lifecycle approach reflects the changing focus in HPE from assessment ‘tools’ to systems and programmes of good assessment, particularly the holistic approach seen in programmatic assessment (Heeneman et al. 2021). Within medical education, the lifecycle has also been successfully applied to the design, and delivery, of complex assessment interventions, such as the OSCE. Applied to the context of TEA, the lifecycle provides five key foci, and targets for application:

- Advancing authenticity of assessment (an overarching principle)

- Engaging learners with the assessment

- Enhancing design and scheduling

- Optimising assessment delivery and recording of learner achievement

- Tracking and learner progress and faculty activity—supporting longitudinal learning and continuous assessment.

합의된 직접 워크숍의 피드백과 이론 정보를 바탕으로 한 실천 혁신 보고서의 가치에 따라, 이러한 원칙은 합의된 저작자로부터 도출된 일련의 모범 사례로 보완된다. 언제든지 교육 혁신을 도입하는 것이 도전이라는 것을 인식하면서(그리고 이러한 예들은 전염병 시대/대유행 시대에는 더욱 그렇다), 영감을 주는 동시에 잠재적 템플릿으로 기능하는 것을 목표로 하며, 위에서 설명한 기준에 따라 정의된 TEA의 기존 우수 관리 사례에 대한 [사례 연구]를 제공한다. 모든 예가 모든 맥락에서 작동하는 것은 아니지만, 독자들이 자신의 환경에서 작동하도록 적응될 수 있는 모든 사례 연구와 지원 문헌의 요소를 찾을 수 있기를 바란다. 형평성에 관한 합의의 모범 사례 조언에 따라, 사례 연구는 의도적으로 이러한 목적을 위한 하나의 '최고의' 기술을 의미하지 않는다. 각 위치에서 작동하는 실제 하드웨어 및 소프트웨어는 기존 기관 인프라와 투자에 의존하며, 이는 맥락에 관계없이 교육자가 전 세계적으로 작업하는 범위를 제한합니다.

Following feedback from consensus in-person workshops, and the value of theory-informed, practice innovation reports, these principles are supplemented by a series of good practice exemplars are drawn from the consensus authorship. Recognising that introducing educational innovation at any time is a challenge (and arguably more so in peri/post-pandemic times), these exemplars aim to serve both as inspiration and a potential template, providing case studies of existing good practice in TEA as defined by the criteria outlined above. Not all the examples will work in all contexts, nevertheless, it is hoped that readers will be able to find elements of all the case studies and supporting literature that could be adapted to work in their own environments. Following the consensus’ best practice advice in relation to equity, case studies deliberately do not imply one ‘best’ technology for this purpose. The actual hardware and software that works in each location depend upon existing institutional infrastructures and investment, confines under which educators work globally, regardless of context.

원칙 1: 평가의 진정성 제고

Principle 1: Advancing assessment authenticity

커리큘럼의 적절한 단계 및 관련 역량과 일치하는 ['진짜Authentic' 평가] 과제의 설계는 학습자 참여 및 품질 평가의 초석입니다. 기술이 이러한 과제를 추가로 개발하기 위해 사용될 때(예: 가상 현실 시뮬레이션의 도입) 학습자 참여 및 기술 혁신의 잠재적 이점은 [의도하지 않은 다른 구조(테크놀로지 친숙성/네비게이션 요구 포함)]의 도입으로 상쇄될 수 있다. 교육 연구는 'Authentic' 과제에 대한 참여와 평가가 진정으로 고립 상태에서 과제를 숙달하는지, 아니면 실천과 진정한 학습자 개발에 더 통합적으로 적용하는지 여부를 계속 조사한다(Wiliam 2021). 따라서 HPE에서의 TEA 개발은 [교육적, 기술적, 임상적]으로 '진정성 인터페이스authenticity interface'를 어떻게 연결하는지 비판적으로 검토할 필요가 있다.

The design of ‘authentic’ assessment tasks, aligned with the appropriate stage of a curriculum and relevant competencies, is a cornerstone of learner engagement and quality assessment. When technology is used to develop these tasks further (e.g. introduction of virtual reality simulation), the potential benefits of enhanced learner engagement and innovation may be offset by the unintentional introduction of different constructs (including familiarity/navigation requirements of the technology). Educational research continues to examine whether engagement in, and assessment of, ‘authentic’ tasks truly leads to mastery of the task in isolation, or more integrative application to practice and true learner development (Wiliam 2021). The development of TEA in HPE, therefore, needs to critically examine how it bridges the ‘authenticity interface’ of pedagogy, technology, and clinical practice.

[교육학적]으로, 평가의 초점은 [학습의 평가]만을 유일한 초점으로 가지고 있다가 [학습을 위한 평가]라는 더 큰 표현으로, 더 나아가 '지속 가능한 평가sustainable assessment'로 계속 전환되고 있다(Boud 2000). 목표는 학생들의 [오늘날 성적]에 대한 점수를 주는 것뿐만 아니라 그들의 [미래 학습과 자기 조절 학습 기술]의 성장을 지원하는 것, 그들이 스스로 [학습 목표를 설정하고 그들의 지식, 기술 및 행동을 모니터하는 능력]이다. [지속가능한 평가]는 학생이 교육 환경뿐만 아니라 미래의 직장 생활 전반에 걸쳐 자신의 성과를 평가하는 능력을 배워야 한다고 강조한다(Boud 2000; Boud and Soler 2016).

Pedagogically, the focus of assessment continues to shift from a sole focus of the assessment of learning to a greater representation of assessment for learning and thus to ‘sustainable assessment’ (Boud 2000). The goal is not only to give grades on the students’ performance today but to support their future learning and growth of self-regulated learning skills, the ability to set goals for their learning, and monitor their knowledge, skills, and behaviour. Sustainable assessment emphasises that the student should learn the ability to assess their own performance not only in their educational settings but throughout their future working lives (Boud 2000; Boud and Soler 2016).

TEA에서, 이것은 우리가 평가 도구의 측정과 테크니컬한 개발에 초점을 덜 맞추고, 진정한 학습/직장 맥락에서 학생 학습을 촉진하는 질적이고 인격화된personified 평가에 더 큰 초점을 맞추어야 한다는 것을 의미한다. 평가 도구와 더불어서, [평가의 결과]로 [메타인지 기능과 학생 참여를 고려하는 대안적alternative 학습 분류법]을 사용하면 Authentic tools의 선택과 설계에 정보를 제공할 수 있다. Higher and Continuous Education의 광범위한 경험과 평가에 대한 접근 방식은 다음과 같은 대안적인 평가 형식을 위한 추가적인 유용한 리소스입니다.

- 오픈 북 및 테이크아웃 평가(예: Sambell 및 Brown 2021),

- 교사가 학생의 진도를 추적하는 동시에 학습자가 학습 진도와 계획 개선에 대한 판단을 내릴 수 있는 능력을 개발할 수 있도록 지원하는 평가 도구(말레카 및 Boud 2021).

In TEA, this means that we should ensure less focus on the measurement and technical development of assessment tools, and a greater focus on the qualitative and personified assessment fostering student learning in authentic learning/workplace contexts. The use of alternative learning taxonomies that consider metacognitive function and student engagement as a result of the assessment, alongside assessment tools, can inform the selection and design of authentic tools (Marzano and Kendall 2007; Villarroel et al. 2018). The wider experiences of, and approaches to, assessment in Higher and Continuing Education are an additional useful resource for alternative assessment formats including

- open book and takeaway assessments (e.g. Sambell and Brown 2021), and

- assessment tools that help teachers track their students' progress whilst allowing learners to develop their own capacity to make a judgement about their learning progress and plan improvement (Malecka and Boud 2021).

[테크니컬하게], TEA는 교육 테크놀로지 개발에 inform하는 핵심 원칙을 활용하여, '네비게이션' 문제는 최소화하고, 학습자와 교직원을 설계의 중심에 두어야 합니다(Divami 2021). 평가가 다음의 특징을 갖도록 설계되어야 한다.

- 기회적 (예: 광범위한 환경에서 WBA를 지원하기 위한 스마트폰 사용)

- 몰입적 (예: 학습자가 자체 및 그룹 평가 기회를 만들 수 있음)

- 연결적 (학습 조직 내 개인화 및 연결성 향상—예: 전공의의 성찰을 촉진하기 위한 스마트폰 앱/코칭 그룹)

Technically, TEA should leverage key principles that inform educational technology development, minimising ‘navigation’ issues and place learners and faculty at the heart of design (Divami 2021). Design should allow the assessment to be

- opportunistic (e.g. the use of smartphones to support WBA in a wide range of settings),

- immersive (e.g. allowing learners to create their own self- and group assessment opportunities), and

- connected (allowing personalisation and connectivity within learning organisations—e.g. smartphone apps/coaching groups to promote reflection by residents) (Konings et al. 2016).

[임상적]으로 TEA가 기술 지원 의료에 대한 현재 및 새로운 접근 방식과 효과적으로 상호 작용할 수 있는 상당한 기회가 있습니다. HPE 평가에서 현재 교육 테크놀로지는 많은 경우에 ([개인, 그룹 및 인구의 관리를 강화하기 위해 테크놀로지가 어떻게 사용되는지에 맞추는 기회보다는]) 전달delivery에만 초점을 맞추고 있다. 예를 들어, 평가 기회를 안내하기 위해 다음과 같은 간단한 프레임워크를 제안합니다.

Clinically, there are significant opportunities for TEA to interface effectively with current and emerging approaches to technology-enabled healthcare. Much of the current focus of educational technology in HPE assessment focuses on delivery, rather than an opportunity to align to how technology is used to enhance the care of individuals, groups, and populations. For example, we suggest the following simple framework to guide assessment opportunities:

장치 증강 치료

Device augmented care

많은 의료 시스템에서 [종이 없는 의료 시스템]과 클라우드 기반 '공유 진료shared care'의 출현은 온라인 상담, 커뮤니케이션 및 의사 결정에 필요한 빠른 [업스킬링]을 강조한다(Greenhalgh et al. 2016; Darnton et al. 2021). 학부생과 전문가 모두를 위한 침상 진단 및 치료 절차로서의 침상 초음파의 출현과 성장은 TEA 개발의 목표를 제공한다(McMenamin et al. 2021).

In many health systems, the advent of paperless healthcare systems and cloud-based ‘shared care’ (e.g. Philips 2021) spotlight the rapid upskilling needed for online consultation, communication, and decision making (Greenhalgh et al. 2016; Darnton et al. 2021). The advent and growth of bedside ultrasound as a bedside diagnostic and therapeutic procedure for undergraduates and professionals alike provides targets for TEA development (McMenamin et al. 2021).

환자 및 전문가에 대한 기대 및 보건 기술 사용능력

Expectations, and health technology literacy, of patients and professionals

빠르게 변화하는 치료 속도는 HPE 학습자와 전문가의 글로벌 커뮤니티가 [끊임없이 변화하는 가이드라인, 프로시저 및 약물을 사용하여 치료를 제공한다]는 것을 의미하며, 이를 위해서는 [온라인 리소스에 대한 적시 액세스]와 [지속적인 전문 개발CPD]이 필수적이다. 환자 치료의 일환으로 [그러한 자원에 '언제, 왜, 어떻게' 접근하는지를 입증하는 것]이 평가의 중요한 대상이 되어야 한다.

A rapidly changing pace of care means the global community of HPE learners and professionals will deliver care using constantly changing guidelines, procedures, and drugs, where timely access to online resources and continuing professional development are essential. Demonstrating ‘when, why, and how’ such resources are accessed as part of patient care should be a critical target for assessment.

상태 분석 및 리스크 커뮤니케이션

Health analytics and risk communication

[빅 데이터와 딥 머신 러닝]의 사용은 건강에 점점 더 기여하고 알고리즘과 의사 결정을 안내하며 진단에 기여한다(Rajpurkar et al. 2022). [공유된 환자-전문가 상담 모델] 내에서 [위험 커뮤니케이션, 디지털 사용능력 및 의사 결정]을 통합하는 평가를 설계하면 AI의 기회와 한계에 대한 지속적인 논의를 수용하면서 매우 정통한 평가 작업에 대한 기회를 제공한다(원칙 5).

The use of big data and deep machine learning increasingly contribute to health, guiding algorithms and decision making, and contributing to diagnosis (Rajpurkar et al. 2022). Designing assessments that integrate risk communication, digital literacy, and decision making within shared patient-professional consultation models provide opportunities for highly authentic assessment tasks, accepting the ongoing debate about the opportunities and limitations of AI (Principle 5).

원칙 2: 학습자를 평가에 참여시킵니다.

Principle 2: Engaging learners with assessment

이상적인 교육 프로그램에서, 학습자는 (중요하다고 인식할 때뿐만 아니라) [언제나] 학습 프로그램 전반에 걸쳐 평가에 완전히 참여합니다. 합의 전반에 걸쳐 제시된 각 모범 사례 연구의 헤드라인 원칙은 비동기성과 연결의 기회가 주어지면 학습자 참여를 TEA를 통해 더 잘 촉진할 수 있다는 것을 강화한다. [능동적인 학습자 참여]는 [심층 학습]과 [성취 및 활동 측정 및 모니터링을 위한 기술 사용(예: 가상 학습 환경을 통한)]과 강하게 연관되어 있으며, 평가 성과에서 [초기 및 지속적인 학습자 참여의 중요성]을 강조한다(Korhonen 2021). 이 첫 번째 사례 연구에서 Webb와 Valter는 평가에 대한 참여와 창의성을 개선하고 재사용 가능한 학습 리소스를 개발하며 학습자 그룹을 연결하는 단순하고 쉽게 사용할 수 있는 기술의 힘을 입증합니다.

In an ideal educational programme, learners would always be fully engaged with assessment throughout their programmes of study (not just when they perceive it matters). The headline principle for each of the good practice case studies presented throughout the consensus reinforces that learner engagement can be facilitated better through TEA given the opportunities for asynchronicity and connectivity. Active learner engagement is strongly associated with deeper learning (Villarroel et al. 2019) and achievement and the use of technology (e.g. through virtual learning environments) to measure and monitor activity highlights the importance of both early, and sustained learner engagement in assessment outcomes (Korhonen 2021). In this first case study, Webb and Valter demonstrate the power of simple, readily available technology to improve participation and creativity in assessment, develop reusable learning resources, and connect groups of learners:

사례 연구 1

Case Study 1

유튜브 세대를 위한 평가: [학생이 만든 해부학 비디오]에 대한 사례 연구(Alex Webb & Chrisztina Valter, 호주 국립 대학교)

Assessment for the You-Tube generation: a case study on student-created anatomy videos (Alex Webb & Krisztina Valter, Australian National University)

맥락

Context

우리는 선생님이 제공한 5가지 옵션 목록에서 선택한 [해부학 주제에 대한 2000단어 개별 에세이 평가]를 현대화하려고 했다.

We sought to modernise a 2000-word individual essay assessment on anatomy topics chosen from a list of five options provided by the teacher.

우리가 달성하려고 했던 게 뭐죠?

What were we trying to achieve?

우리는 주제에 대한 학생 질문을 자극하고 일반적으로 사용 가능한 기술을 사용하는 자체 지식 표현의 구성을 촉진하기 위해 평가 과제를 다시 설계했다. 또한 이 과제가 학생들의 선택권을 부여하고, 학습을 재미있게 하며, 학생들이 창의적으로 할 수 있도록 하며, 학생들이 동료들과 쉽게 공유할 수 있는 결과물을 생산할 수 있는 기회를 제공하는 것도 중요했다. 게다가, 우리는 더 적은 시간 안에 더 즐겁게 채점를 할 수 있기를 바랐습니다!

We re-designed the assessment task to stimulate student interrogation of the topic and construction of their own knowledge representations utilising commonly available technology. It was also important that the task empowered student choice, made learning fun, allowed students to be creative, and provided an opportunity for students to produce outputs that could easily be shared with peers. In addition, we hoped to make marking more enjoyable in less time!

우리가 한 일

What we did

학생들은 5명으로 구성된 스스로 선택한 그룹의 해부학적 주제에 대한 5-7분짜리 재미있는 교육 비디오를 만들어야 했다. 각각의 비디오는 선생님들에 의해 채점되었다. 비디오는 평가와 수정을 위해 전체 코호트에 제공되었다.

Students were tasked to create a 5–7-min entertaining educational video on an anatomy topic of their choice in self-selected groups of five. Each video was graded by the teachers. The videos were provided for the whole cohort for evaluation, and for their revision.

영향의 지속적인 평가

Ongoing evaluation of impact

대다수의 학생들이 이 활동을 즐겼으며(93%) 이 활동을 통해 주제에 대한 이해도(90%)가 향상되는 것으로 나타났다. 주제를 연구하고 지식을 통합할 수 있는 기회가 학습에 도움이 되는 핵심 요소였습니다. 하지만, 시간과 새로운 기술을 배우는 것은 그들의 학습에 방해가 되었다. 교사들에게는, 채점하고 피드백을 제공하는 것이 더 효율적이고 즐거웠습니다.

The majority of students enjoyed the activity (93%) and found that it improved their understanding of the topic (90%). The opportunity to research the topic and consolidate their knowledge were key factors aiding their learning. However, time and learning a new technology detracted from their learning. For teachers, marking and providing feedback were more efficient and enjoyable.

테이크홈 메시지

Take home message

비디오를 만드는 과정은 학생들이 동료들과 쉽게 공유할 수 있는 그들 자신의 학습을 돕기 위해 해부학적 개념에 대한 그들 자신의 표현을 구성하기 위해 팀으로 일할 수 있는 재미있고 자극적인 기회를 제공했다.The process of creating videos provided students with a fun and stimulating opportunity to work as a team to construct their own representations of anatomical concepts to aid their own learning, which can be easily shared with peers.

이 사례는 학습자가 평가 과정에 참여하는 강력한 사례로, '하면서 배우는 것을 선호하는' 세대를 위한 평가 적응에 있어 최상의 원칙(Marzano와 Kendall 2007)과 학습자가 학습하기 위해 하는 일에 의미를 구성한다는 원칙(Biggs와 Tang 2011)을 보여준다. 이러한 작업(평가 지분 범위에 적응할 수 있음)은 [공동 제작 콘텐츠 생성]의 추가적인 이점을 가지고 있으며, 그 결과 다음 코호트에 대한 교육 및 평가 참여를 향상시키는 데 사용될 수 있는 [리소스 뱅크]가 생성된다. 건강 인문학적 관점에서, 이러한 과제들은 또한 학생들이 평가를 통해 창의적 역량을 발휘할 수 있게 한다.

The case study is a powerful example of learner engagement with the assessment process, demonstrating the best principles in adapting assessment for a generation who ‘prefer to learn by doing’ (Marzano and Kendall 2007) and the principle that learners construct meaning on what they do to learn (Biggs and Tang 2011). Such tasks (which can be adapted to a range of assessment stakes) have the additional benefit of co-produced content creation, resulting in a bank of resources that can then be used to enhance teaching and assessment engagement for the following cohort. From a health humanities perspective, such tasks also enable students to demonstrate their creative capacities through assessment.

[디지털 및 지리적 형평성 관점]에서 TEA는 국경을 넘어 교육자와 학습자 간에 낮은 [저부담 평가 포맷]을 공유할 수 있는 무한한 가능성을 제시합니다. 단순하고 확립된 기술의 사용은 종종 학습자가 (컴퓨터나 노트북이 아닌) 비교적 [기본적인 스마트폰 장치]만을 접근/보유하는 것으로도 충분하다. 인구와 관련된 장치의 보급을 고려할 때 2014년에 전세계적으로 실현 가능한 것으로 간주되었다. 현재 테크놀로지는 모든 모바일 장치에서 현재 보편화된 필기, 오디오 또는 'STT' 기능을 통해 [무엇이 잘 진행되고 있는지, 무엇을 개선할 수 있는지, 어떻게 다음 단계로 나아갈 수 있는지]에 대한 생각을 순간적으로 요청하고 기록할 수 있는 기회를 제공할 수 있습니다(Tuti et al. 2020). 이러한 기회는 실제로 학습자 주도적이고 실행 가능한 피드백의 확립된 이론적 원칙을 기반으로 평가와 학습 행동을 긍정적으로 형성할 수 있는 기술의 힘을 열어줍니다(Sadler 2010; Boud and Molloy 2013).

From a digital and geographical equity perspective, TEA presents endless possibilities to share low-stakes assessment formats between educators and learners across borders. The use of simple, established technology often requires learners only to access/hold a relatively basic smartphone device (rather than a computer or laptop); something which was considered to be feasible worldwide in 2014, given the prevalence of devices in relation to the population (International Telecommunication Union 2014 in Fuller and Joynes 2015). Technology can present opportunities to engage learners differently with feedback; offering quicker ways to request and record in the moment thoughts on what is going well, what can be improved, and how to progress to the next level, through written, audio, or ‘speech to text’ functions now common in all mobile devices (Tuti et al. 2020). Such opportunity really opens up the power of technology to positively shape both assessment and learning behaviours, building on established theoretical principles of learner-driven, actionable feedback (Sadler 2010; Boud and Molloy 2013).

원칙 3: 평가 설계 및 스케줄링 개선

Principle 3: Enhancing design and scheduling of assessment

지난 10년간의 많은 기술 발전은 특히 품질 또는 유효성 렌즈를 통해 볼 때 HPE 평가에 대한 접근 방식의 상당한 개발을 가능하게 했다(St-Onge et al. 2017). 소프트웨어는 이제 개인, 기관, 컨소시엄 및 국가 수준에서 [지식 시험 문제은행(예: 단일 모범 답안 형식)]의 창설을 지원하기 위해 일상적으로 사용된다. 평가 문항을 설계하고 공유하기 위해 평가 컨소시엄 내에서 [원격 작업]하는 것은 상당한 비용 절감과 효율성을 제공하며, 항목의 정교한 [태깅]은 테스트 생성과 해당 구성 정렬에서 틀림없이 더 나은 품질을 가능하게 한다(Kickert et al. 2022). 문항의 개발, 수정 및 은행 업무와 관련된 상당한 비용은 현재 [자동 문항 생성]의 잠재력에 의해 도전받고 있다(Lai et al. 2016).

Many of the technological developments of the last decade have enabled considerable development of approaches to HPE assessment, particularly when viewed through a quality, or validity lens (St-Onge et al. 2017). Software is now used routinely to support the creation of knowledge test item banks (e.g. for single best answer formats) at the individual, institutional, consortia, and national levels. Working remotely within assessment consortia to design and share assessment items presents substantial cost savings and efficiencies, and sophisticated tagging of items allows arguably better quality in the creation of tests and their constructive alignment (Kickert et al. 2022). The substantial costs associated with the development, emendation, and banking of items are now being challenged by the potential of automatic item generation (Lai et al. 2016).

성과 평가에서 TEA의 사용은 임상 실습에서 보다 학습자 중심의 기회주의적 성과 평가 문화를 개발할 수 있는 기회를 제공하는 WBA(Work Based Assessment) 형식을 사용하는 데 특히 영향을 미쳤다. 프로그램 수준 [WBA의 기관 및 국가 모델]은 [테크놀로지 기반 플랫폼과 테크놀로지 기반 포트폴리오]를 사용하여 환자 치료 시에 평가(기회)를 잡아낸다. 이러한 발전의 대부분은 'BYOD(Bring Your Own Device)' 모델(Sundgren 2017)을 사용하여 이루어졌지만, 기회의 불평등을 방지하고 섹션 배경에서 강조했듯이 이러한 접근 방식을 지원할 수 있는 충분한 인프라를 확보할 수 있도록 주의를 기울여야 합니다.

The use of TEA within performance assessment has been particularly impactful using Work Based Assessment (WBA) formats, presenting opportunities to develop more learner-centred, opportunistic cultures of performance assessment in clinical practice. Institutional and national models of programme level WBA operate using technology-based platforms and technology-based portfolios (van der Schaaf et al. 2017; NHS eportfolios 2021), with the use of mobile devices to capture assessment at the point of patient care (Joynes and Fuller 2016; Harrison et al. 2019; Maudsley et al. 2019). Much of this advancement has been facilitated using ‘Bring Your Own Device’ (BYOD) models (Sundgren 2017) but care needs to be taken to avoid inequity of opportunity and to ensure sufficient infrastructure to support these approaches as highlighted in Section Background.

학습자의 개인과 코호트 수준 [진전을 일상적으로 포착하는 평가 관리 시스템]의 성장은 평가에 대한 새로운 접근 방식을 설계하기 위해 [대규모 데이터 세트]를 의미 있게 사용할 수 있게 했다. 평가 프로그램(Pell et al. 2012)에서 [보더라인과 저성과자의 결과를 종단적으로 추적하는 작업]은 평가 품질에 미치는 영향을 점점 더 입증하는 [데이터 중심 순차적 테스트sequential testing 형식]의 구현을 지원했다. [적응형 지식 시험 시스템]을 지원하는 작업은 잠재적으로 고도로 개인화된 응용 지식 테스트 및 피드백의 출현을 보여준다(Collares and Cecilio-Fernandes 2019).

The growth in assessment management systems that routinely capture individual, and cohort level progress of learners has enabled meaningful use of large data sets to design newer approaches to assessment. Work to track the longitudinal consequences of borderline and underperformance in programmes of assessment (Pell et al. 2012) has supported the implementation of data-driven Sequential Testing formats (Pell et al. 2013; Homer et al 2018), which are increasingly demonstrating impact on assessment quality. Work supporting adaptive knowledge testing systems demonstrates the emergence of potentially highly personalised applied knowledge testing and feedback (Collares and Cecilio-Fernandes 2019).

[온라인 테스트에 대한 대규모 글로벌 경험](그리고 단일 모범 답안 형식의 전통적인 사용을 통한 '클로즈드 북' 형식 테스트의 과제)은 오픈 북 테스트 형식과 기술이 가져올 수 있는 기회에 대한 새로운 관심을 불러일으켰다. 이전에는 HPE 내에서 지배적인 평가 형식은 아니었지만, 의학 교육 및 특히 더 광범위한 교육에서 Open Book 또는 'Take home/take away' 테스트 형식의 사용에 대한 실질적인 증거가 있다. 이런 시험이 '클로즈드 북' 형식을 대체하는 것에 대한 방대한 실무 경험이 쌓이기 시작한 것이다. 주장하건대, 이것은 개별적으로 또는 그룹으로 연구와 합성이 필요한 복잡한 문제(예: 많은 보건 문화, 특히 복잡한 임상 결정을 위해 일하는 다학제 팀의 사용에 맞춰 조정)를 설계하고 학습자가 해결해야 하는 매우 정통한 평가 접근 방식을 제시한다. 테크놀로지는 '책'(예: 모바일 기기)을 재정의할 수 있는 실질적인 레버리지를 제공합니다. 사례 연구 2에서 입증되었듯이, [학습자가 어떻게 검색 전략을 개발 및 운영하고, 다른 사람과 협업/연결하여 문제를 해결하는지]를 모니터링하고 이해할 수 있는 잠재력은 '저부담' 평가를 위한 새로운 기회를 제공합니다.

Large scale, global experience of online testing (and the challenges of ‘closed book’ format testing, e.g. through traditional use of Single Best Answer formats) have renewed interest in Open Book test formats and the opportunities that technology may bring (Zagury-Orly and Durning 2021). Whilst previously not a dominant assessment format within HPE, there is substantial evidence about the use of Open Book or ‘take home/take away’ test formats within both medical education (Westerkamp et al. 2013; Durning et al. 2016; Johanns et al. 2017), and particularly within wider education (Bengtsson 2019; Spiegel and Nivette 2021), with extensive practical experience on replacement of closed book formats (Sambell and Brown 2021). Arguably, this presents a highly authentic approach to assessment which challenges faculty to design, and learners to solve, complex problems that require research and synthesis, either individually or in groups (e.g. aligning to the use of multi-disciplinary teams working in many health cultures, particularly for complex clinical decisions). Technology presents a real lever to redefine the ‘Book’ (e.g. a mobile device). The potential to monitor and understand how learners develop and operate search strategies and collaborate/connect with others to solve problems provides new opportunities for ‘lower stakes’ assessments, as demonstrated in Case Study 2.

사례 연구 2

Case Study 2

오픈 북 온라인 평가: 보건 전문 프로그램에 걸친 제도적 구현 사례 연구(국제 의학 대학, 말레이시아)

Open Book Online Assessments: A case study of institutional implementation across health professions programmes (International Medical University, Malaysia)

맥락

Context

그 대학은 2018년에 건강 전문 프로그램에 대한 온라인 평가 시스템(OAS)을 시행했다. OAS는 문제 개발, 시험 후 분석을 통한 지식 기반 및 OSCE 평가 전달, 학습 결과에 기반한 개별 학생 보고서를 제공한다는 점에서 포괄적이었다. COVID-19 팬데믹의 초기 단계에서 OAS는 학생과 교직원을 위한 오프사이트 온라인 시험 플랫폼으로 수정되었다.

The university implemented an online assessment system (OAS) for its health professions programmes in 2018. The OAS was comprehensive in that it allowed for question development, delivery of knowledge-based and OSCE assessments with post-exam analysis, and individual student reports based on learning outcomes. During the early phase of the Covid-19 pandemic, the OAS was modified to be an offsite online test-taking platform for students and staff, as the physical campus space was unable to be used for assessments due to national lockdown restrictions.

우리가 이루려고 했던 것은

What we were trying to achieve

OAS에 프록토링 기능이 없었기 때문에, 오프사이트 온라인 평가를 활성화할 수 없었고, 이러한 적응에서 새로운 문제가 발생했다. 코로나 19로 인한 교수 및 학습 활동의 변경과 비-프록토링 평가가 학생 진행에 미치는 위험을 고려하여, 우리는 저부담 시험에 대한 기존 평가 형식을 사용하여 온라인 비-프록토링non-proctored 시간 기반 오픈 북 평가를 구현했다. 오픈북 시험은 학습 결과에 대해 청사진으로 작성된 지식 응용 항목 형식을 사용했다.

A new challenge emerged from this adaptation as we were unable to invigilate the offsite, online assessment as no proctoring feature existed in the OAS. Given the modifications to teaching and learning activities due to Covid-19 and the risks of non-proctored assessment on student progression, we implemented an online, non-proctored time-based open book assessment using existing assessment formats for low stakes exams. Open book assessments used knowledge application item formats which were blueprinted against learning outcomes.

영향의 지속적인 평가

Ongoing evaluation of Impact

오프사이트 온라인 테스트를 실시한 1차 구현에서는 학생의 데이터 용량 및 기기 제한, 기술 지원 능력, 교직원과 학생 간의 부정행위에 대한 우려에 대한 주요 우려가 강조되었습니다. 이로 인해 [기기 또는 데이터 카파시티]가 있는 학생을 위한 추가 조항과 (외부 보호 소프트웨어 대신) 사내 온라인 활성화의 도입을 포함한 추가 개선이 이루어졌다. 후속 분석 결과, 이러한 개선으로 개별 학생과 코호트 평가 성과는 적응 전 평가와 강하게 상관관계가 있는 것으로 나타났다(Er et al 2020).

The first round of implementation with offsite online test taking highlighted major concerns around data capacity and device limitation of students, ability to provide technical support, and concerns of cheating amongst faculty and students. This led to further improvements including additional provisions for students with device or data capacity and the introduction of in-house online invigilation (instead of external proctoring software). Subsequent analysis showed that, with these improvements, individual student and cohort assessment performance correlates strongly with pre-adaption assessments (Er et al 2020).

테이크홈 메시지

Take home message

오프사이트 온라인 오픈북 평가로 전환할 때, 교수진은 처음에는 오픈북 평가의 사용과 진행에 따른 학생 역량에 미치는 영향에 대해 더 우려했다. 대신, 발생된 문제는 현장검사에서 외부검사로의 테크놀로지 변화와 관련이 있었다. 위기 상황에서 적응할 수 있는 기회를 잡은 것도 유익했지만, 첫 시행 후 평가를 적응시켜 더 개선하는 것도 마찬가지로 중요하다.

When shifting to offsite online open book assessments, faculty were initially more concerned about the use of open book assessments and their impact on student competencies as they progressed. Instead, issues that arose were related to technological shifts from an onsite to an offsite examination. It was beneficial to take the opportunity to adapt during a crisis, but it is also equally important to adapt the assessment after its first implementation to improve it further.

지속적인 코로나 팬데믹에 대응하여, 온라인 테스트를 하는 것이 거의 wholesale로 전환된 덕분에 테스트에 필요한 리소스(공간, 인력)와 테스트 타이밍 및 배치를 개선할 수 있는 기회도 새롭게 볼 수 있었다. 저부담 시험 및 특히 학습 형식에 대한 평가의 경우, 웹과 발터는 비물리적 환경에서 평가와 함께 학습자 참여의 기회를 보여준다. [대규모 시험장을 예약하고 여러 프로그램을 계획하는 제약]은 테크놀로지를 [지능으로 사용]함으로써 통해 해방되었지만, 동시에 학습자 불안과 감정에 대한 물리적 평가 환경의 중요성에 대한 증거가 새롭게 등장했다(Harley et al. 2021). 이러한 평가의 설계, 준비 및 전달에 있어 학습자와 교직원에 대한 지원의 중요성은 아무리 강조해도 지나치지 않으며(Tweed et al. 2021), 여기에 더 넓은 교육 자원을 게시할 수 있는 기회를 제공한다(Wood 2020a, 2020b).

The near wholesale switch to online test delivery in response to the ongoing Covid pandemic has also allowed a fresh look at resources needed for testing (space, staffing) and opportunities to improve the timing and deployment of testing. For lower stakes tests, and particularly assessment for learning formats, Webb and Valter demonstrate the opportunities for learner engagement with assessment in non-physical settings. The constraints of booking large exam halls and scheduling multiple assessments within, and across, programmes are liberated through the intelligent use of technology, with emerging evidence about the importance of the physical assessment environment on learner anxiety and emotion (Harley et al. 2021). The importance of support for learners and faculty in the design, preparation, and delivery of such assessments cannot be overstated (Tweed et al. 2021), with the opportunity to signpost wider education resources there (Wood 2020a, 2020b).

원칙 4: 평가 전달 및 학습자 성과 기록 최적화

Principle 4: Optimising assessment delivery and recording of learner achievement

이 합의의 향후 반복에서 2020-2021년을 돌아보고 평가에 대한 COVID-19의 가장 큰 영향을 검토하는 것은 흥미로울 것이다. 그러나 이 단계에서 TEA의 가장 가시적인 영향은 [평가 전달delivery]에 있었다. 온라인 지식 테스트의 성장은 효과적인 대량 온라인 테스트의 출현을 목격했다. 여기서 테크놀로지는 시험과 자동 채점의 전달을 지원하는 데 사용된다. 정교한 평가 관리 시스템(문제은행도 제함공)은 공인된 합격선 설정 방법(예: Ebel, Angoff)의 자동 적용을 지원합니다. 또한 테크놀로지는 VSA(Very Short Answer) 질문을 포함한 대체 지식 테스트 형식의 전달 및 자동 채점을 가능하게 하여, 응시자가 자유 텍스트를 사용하여 답변할 수 있도록 하고 머신 러닝 알고리즘을 사용하여 대부분의 채점을 수행할 수 있도록 했다(Sam et al. 2018).

It would be interesting to look back at 2020–2021 in future iterations of this consensus and review the biggest impact Covid-19 had on assessments—but at this stage, the most visible impacts of TEA have been on assessment delivery. The growth of online knowledge testing has seen the emergence of effective mass, online testing where technology is used to support the delivery of testing and automated marking. Sophisticated assessment management systems (which also provide item banking) support the automated application of recognised standard setting methods, e.g. Ebel, Angoff. Technology has also enabled the delivery and automated marking of alternative knowledge testing formats including VSA (Very Short answer) questions, allowing candidates to answer using free text, and the use of machine learning algorithms to undertake most of the marking (Sam et al. 2018).

또한 [평가 관리 시스템Assessment Management System]은 수행능력 평가에서 채점 및 자동화된 합격선 설정(예: 경계선 방법 사용)을 제공하며, 특히 OSCE는 모바일 장치를 사용한 채점 등을 통해 학습자에게 피드백을 포착할 수 있다. ['버추얼' OSCE]의 부상은 [고품질의 방어 가능한 평가]를 만들어내는 데 필요한 [복잡한 로지스틱스]를 포함하여, 무엇것을 완전히 가상 형식을 사용하여 진정한 평가를 할 수 있는지(또는 할 수 없는지)를 재개념화할 수 있는 기회를 보여주었다(Boursicot et al. 2020). 이러한 경험의 대부분은 TEA를 테크놀로지 강화 의료(예: 온라인/가상 환자-전문가 상담의 일상적인 사용)와 연계할 필요성에 초점을 맞추는 데 도움이 되었다. 원칙 3에서 강조했듯이, WBA 전달을 용이하게 하기 위한 모바일 장치의 사용은 점진적으로 증가했지만, [프로페셔널리즘 평가에 대한 테크놀로지의 영향]은 덜 확산되었다. 예를 들면 여기에는, [360/멀티 소스 피드백의 완전한 온라인 시스템]에서부터, [피드백을 즉시 제공하거나 학습자의 웰빙 또는 행동에 대한 우려를 즉시 제기]하는 테크놀로지 연결의 힘에 대한 적극적인 연구 등이 있다(JISC 2020).

Assessment Management Systems also supports the delivery of marking and automated standard setting (e.g. using Borderline Methods) in performance assessment, notably OSCEs, e.g. through scoring using mobile devices, which can also capture feedback to learners. The rise of ‘virtual’ OSCEs has demonstrated opportunities to further reconceptualise what can (and cannot) be authentically assessed using a fully virtual format, including the complicated logistics needed to return a high-quality, defensible assessment (Boursicot et al. 2020). Arguably, much of this experience has helped focus on a need to align TEA with technology-enhanced healthcare (e.g. the routine use of online/virtual patient-professional consultations). As highlighted in Principle 3, the use of mobile devices to facilitate the delivery of WBA has grown progressively, but less well-disseminated has been the impact of technology on delivering professionalism assessment, e.g. from fully online systems of 360/multi-source feedback, through to active research into the power of technology connectivity to instantly provide feedback or immediately raise concerns about a learner’s well-being or behaviour (JISC 2020).

평가에 테크놀로지를 사용하는 것은 평가 품질 분석, 사후 측정 기준 및 점수 보고에도 강력한 이점을 제공했다(Boursicot et al. 2021). [테크놀로지 기반 포트폴리오]는 [연계된 다양한 'artefacts'(즉, 성과 자체, '점수', 평가자 피드백 및 후보 반영)]을 통해 [누적적이고 종단적인 학습 성과를 기록할 수 있는 기회]가 생기고, 이는 진정으로 지속 가능한 평가에 영향을 미칠 수 있는 강력한 저장소를 제공합니다. 평가 및 피드백 증거의 포괄적인 저장소는 평가 프로그램 및 프로그램 평가 접근법에서 학습자 진행에 대한 효과적인 의사 결정의 중심이다. [TEA의 결과로 포착된 광범위한 데이터]는 OSCE 내의 검사자 행동과 의사 결정에 대한 강력한 통찰력을 제공하여 사례 연구 3에서 입증한 바와 같이 테크놀로지가 OSCE 품질을 더욱 향상시킬 수 있는 방법에 대한 추가 연구(비디오와 같은 간단한 기술을 사용)를 생성합니다.

The use of technology within assessment has also provided powerful benefits to the analysis of assessment quality, post-hoc metrics, and score reporting (Boursicot et al. 2021). The opportunities to record cumulative and longitudinal learner achievement through a range of linked ‘artefacts’ (i.e. the performance itself, the ‘score,’ assessor feedback, and candidate reflection) within a technology-based portfolio presents a powerful repository to influence truly sustainable assessment. A comprehensive repository of assessment and feedback evidence is central to effective decision-making about learner progression in programmes of assessment and programmatic assessment approaches. The extensive data captured as a result of TEA provides powerful insights into examiner behaviour and decision making within the OSCE, generating further research (using simple technology, such as video) into how technology might further augment OSCE quality, as demonstrated in Case Study 3.

사례 연구 3

Case study 3

[분산형 OSCE의 품질보증]을 강화하기 위한 방법으로서의 비디오 기반 Examiner Score 비교 및 조정(VECA) (Peter Yeates, Keele Medical School, UK)

Video-based Examiner Score Comparison and Adjustment (VESCA) as a method to enhance quality assurance of distributed OSCEs (Peter Yeates, Keele Medical School, UK)

맥락

Context

응시자의 숫자 때문에 대부분의 기관은 각각 다른 검사 그룹을 가진 여러 개의 OSCE(객관 구조 임상 검사) 병렬 회로를 운영한다. 이러한 서로 다른 '시험관-단체'들이 모두 같은 기준으로 학생들을 판단하는 것은 타당성 사슬에 매우 중요하다. 기존 문헌은 검사자-코호트 효과가 응시자의 점수에 중요한 영향을 미칠 수 있다고 제안하지만, 이러한 효과의 측정은 일반적으로 다른 검사자-코호트가 판단하는 후보 간 교차점이 없기 때문에 어렵다(즉, 완전히 네스팅된 설계).

Owing to candidate numbers, most institutions run multiple parallel circuits of Objective Structured Clinical Exams (OSCEs), with different groups of examiners in each. It is critical to the chain of validity that these different ‘examiner-cohorts’ all judge students to the same standard. Whilst existing literature suggests that examiner-cohort effects may importantly influence candidates’ scores, measurement of these effects is challenging as there is usually no crossover between the candidates which different examiner-cohorts judge (i.e. fully nested designs).

우리가 달성하려고 했던 것은 무엇인가?

What were we trying to achieve

우리는 OSCE에서 완전히 네스팅된 평가자 코호트의 일반적인 문제를 극복하기 위해 기술 지원 방법을 개발하는 것을 목표로 했다.

We aimed to develop a technology-enabled method to overcome the common problem of fully nested examiner-cohorts in OSCEs.

우리가 한 일

What we did

우리는 '비디오 기반 시험자 점수 비교 및 조정(VESCA)'이라는 3단계 절차를 개발했다. 여기에는 다음이 포함된다.

- (1) OSCE의 모든 스테이션에서 학생들의 자원봉사 샘플을 비디오로 촬영한다.

- (2) 또한 모든 검사관examiner에게 스테이션-특이적 비교군comparator 비디오 점수를 매기도록 요청합니다(모든 검사관-코호르트가 동일한 비디오 점수를 매김).

- (3) 비디오 기반 점수에 의해 제공되는 연결을 사용하여 많은 면 래쉬 모델링을 사용하여 검사자-코호트 효과를 비교하고 조정한다.

We developed a three-stage procedure called ‘Video-based Examiner Score Comparison and Adjustment (VESCA).’ This involved

- (1) videoing a volunteer sample of students on all stations in the OSCE;

- (2) asking all examiners, in addition, to live examining, to score station-specific comparator videos (collectively all examiner-cohorts scored the same videos);

- (3) using the linkage provided by video-based scores to compare and adjust for examiner-cohort effects using Many Facet Rasch Modelling.

영향의 지속적인 평가

Ongoing evaluation of impact

카메라를 배치하려면 학생의 성과를 방해받지 않고 볼 수 있도록 세심한 최적화가 필요했고 침입을 완화했습니다. 비디오 스코어링은 OSCE에 추가적인 시간 요구 사항을 부과했지만 데이터는 인터넷을 통한 지연 스코어링의 동등성을 지원하여 실현 가능성을 향상시켰다. 학생들은 일반적으로 표준화를 강화하기 위한 절차를 환영했다. 점수 조정은 링크 비디오 수 또는 심사관 참여율의 변동에 대해 허용될 정도로 강력했다. 시험관-코호트 효과는 학생 점수의 표준 편차 이상을 설명하면서 때때로 상당했다. 그에 따라 점수를 조정하면 상당한 소수 학생들의 합격/불합격 결정에 영향을 미치거나 그들의 순위를 크게 바꿀 수 있다.

Camera placement required careful optimisation to provide unobstructed views of students’ performances whilst mitigating intrusion. Scoring videos imposed additional time demands on the OSCE but data supported equivalence of delayed scoring via the internet thereby enhancing feasibility. Students generally welcomed procedures to enhance standardisation. Score adjustments were acceptably robust to variations in the number of linking videos or examiner participation rates. Examiner-cohort effects were sometimes substantial, accounting for more than a standard deviation of student scores. Adjusting scores accordingly could influence the pass/fail decisions of a substantial minority of students or substantially alter their rank position.

테이크홈 메시지

Take home message

VESCA는 개별 기관, 평가 파트너십 또는 국가 시험 기관이 다중 회로 또는 분산/국가 OSCE 시험의 품질을 향상시키고 공정성을 보장할 수 있도록 지원하는 유망한 기술 지원 방법을 제공한다(Yeates et al. 2020, 2021a, 2021b, 2022).VESCA offers a promising technology-enabled method to assist individual institutions, assessment partnerships, or national testing organisations to enhance the quality and ensure fairness of multi-circuit or distributed/national OSCE exams (Yeates et al. 2020, 2021a, 2021b, 2022).

전달, 분석 및 점수 보고 외에도, 테크롤로지를 광범위하게 사용하다보면, [테스트 보안, 부정행위 및 후보 추궁에 대한 상당한 의견]을 유발한다. 이 논평은 5가지 핵심의 신중한 균형을 강조합니다. 다음과 같이 요약될 수 있다.

- 신뢰: 평가를 제공하는 기관, 교직원 및 후보자 자신(그리고 향후 평가에 대한 후속 신뢰와 신뢰)

- 프로페셔널리즘: 그리고 평가 제공 내부 및 주변에서 후보자와 교수진의 기대

- 적극적 프록토링: 문맥과 무관한 분산이나 후보 또는 교수진에게 추가적인 인지 부하를 주지 않으며 디지털 불평등을 심화시키는 복잡한 브라우저 시스템/장치에 액세스할 필요가 없는 온정적이고 비례적인 응답

- 탐지 및 보안: 평가 내 학업 오류, 보안 테스트 뱅크 위반 또는 타사 또는 클라우드 기반 시스템에 의해 저장될 수 있는 후보 특성/성능 데이터의 우발적 손실.

- 결과: 학문적 과실이 발견되었을 때 제재 측면에서뿐만 아니라 학습자, 전문가 및 환자의 신뢰를 강화하는 측면에서도 마찬가지이다.

Beyond delivery, analysis, and score reporting, the extensive use of technology has generated substantial comments about test security, cheating, and candidate proctoring (Roberts et al. 2020; Bali 2021; Selwyn et al. 2021). The commentary highlights the careful balance of 5 key, overlapping issues which can be best summarised as:

- Trust: In the institution delivering the assessment, within and amongst Faculty and candidates themselves (and the subsequent confidence and trust in future assessments)

- Professionalism: and the expectations of candidates and faculty within, and around, the delivery of assessments

- Active proctoring: compassionate and proportionate responses that do not introduce context irrelevant variance, or additional cognitive load on candidates or Faculty, nor require access to complex browser systems/devices that widen digital inequity

- Detection and security: of both academic malpractice within an assessment, the breach of e.g. a secure test bank, or inadvertent loss of candidate characteristics/performance data that may be stored by a third party or cloud-based systems.

- Consequences: both in terms of sanctions when academic malpractice is detected, but also to reinforce the trust of learners, professionals, and patients

현재까지 데이터에 따르면 일부 대규모 국가 평가는 온라인/오프라인 테스트 전달과 비교하여 후보 성과에 차이가 없다고 보고하는 등 보안과 관련하여 테스트 기관 전반에 걸쳐 매우 혼합된 경험을 제시한다. 보다 광범위하게, 테크롤로지는 '부정행위 계약contract cheating'의 성장을 실질적으로 가능하게 했다. 이는 [아웃소싱된 학습자 평가]와 [아웃소싱 평가를 완료한 사람(개인 및 기업)] 간의 결과 균형을 요구한다. 또한 제도적 관행과 입법 모두에 문제를 남긴다.

Data to date suggests very mixed experiences across testing institutions in relation to security, with some larger scale national assessments reporting no differences in candidate performance comparing online/offline test delivery (Andreou et al. 2021; Hope, Davids, et al. 2021; Tweed et al. 2021). More widely, technology has substantially enabled the growth of ‘contract cheating,’ requiring a balance of consequences across learners ‘outsourcing’ assessment and those completing the outsourcing (individuals and companies) and challenges both institutional practices and legislation (Ahsan et al. 2021; Awdry et al. 2021).

원칙 5: 학습자 진행 상황 및 교수 활동 추적—종방향 학습 및 지속적인 평가 지원

Principle 5: Tracking learner progress and faculty activity—supporting longitudinal learning and continuous assessment

테크놀로지 사용은 평가 프로세스와 실무에서 잠재적으로 혁신적이었지만, 학습자 진급에 대한 테크놀로지 주도 '결정'의 출현은 상당한 도전과 우려를 제기합니다. 의료 분야에서 '인공지능'(AI)의 보다 광범위한 사용은 질병의 조기 발견 또는 보다 정확한 진단에 잠재적인 이점을 제공한다(예: 류 외 2019; Yan 외 2020). 그러나 브루사드는 [모든 데이터가 궁극적으로 인간에 의해 생성되기 때문에 잘못된 의사 결정, 코딩 및 출력 사용에 대한 책임은 인간에게 있다]고 강조한다(Broussard 2018).

Whilst the use of technology has been potentially transformational in assessment processes and practice, the advent of technology-driven ‘decisions’ on learner progress presents significant challenges and concerns. The use of ‘artificial intelligence’ (AI) more widely in healthcare presents potential benefits in the early detection of disease or more accurate diagnosis (e.g. Liu et al. 2019; Yan et al. 2020). However, Broussard highlights that all data is ultimately generated by humans, so the challenge for ‘AI’ of poor decision making, the responsibility for coding and use of any outputs remains with humans (Broussard 2018).

교육에서 AI 기반 기술은 학습 또는 웰빙과 관련하여 학습자의 [성공을 예측]하거나, [특정 지원이 필요한 사람]을 탐지할 수 있는 기회를 예고했다(JISC 2020). 그러나 학습자와 교수진에 대한 이러한 테크놀로지의 성과를 살펴보는 고품질 경험적 연구는 거의 없다(Sonderlund et. 2019). 평가 내에서 논평은 개별 평가 내에서 또는 종단적 데이터 세트의 분석을 통해 기계 기반 의사 결정에 초점을 맞췄다(Hope, Dewar, et al. 2021).

In education, AI-based technologies have heralded opportunities to predict learner success or detect those in need of targeted support, whether relating to learning or well-being (JISC 2020). However, there is little high-quality, empirical research that looks at the outcomes of such technology on learners and faculty (Sonderlund et. 2019). Within the assessment, commentaries have focused on either machine-based decision-making within individual assessments (Hodges 2021) or through the analysis of longitudinal data sets (Hope, Dewar, et al. 2021).

광범위한 교육에서 데이터 처리 및 학습자 분석이 TEA의 일부로 사용되는 방법에 대한 몇 가지 접근법이 있었다. 시스템의 설계, 데이터 처리 또는 결과의 이해/적용 불량으로 인해 '프로파일과 예측'이 실패할 수 있으며, 이는 학습자에게 불명확한 결과, 학습자에게 부정적인 영향(실패에 대한 두려움을 강화함) 또는 '게임 행동'을 초래할 수 있다. 교수진과 기관에 의한 그러한 시스템에 대한 이해와 적용은 동등하게 중요하다(Lawson et al. 2016). 이와는 대조적으로, 사례 연구 4에 나타난 바와 같이, 지능형 시스템 설계와 데이터의 목적적 사용은 미래의 실패 위험에 있는 학습자를 식별하고 의미 있게 지원하기 위해 데이터를 사용하거나(Foster and Siddle 2020), 자율 규제와 더 나은 학습자 선택(Broos et al. 2020)을 지원하는 데 사용될 수 있다. 현재의 과제는 이 원칙이 학습에 대한 의미 있는 영향의 측면에서 교육에 대한 혼합 결과를 강조하는 제한된 공개된 증거 기반 내에 있다는 것이다(2019년 슘과 행운).

Within wider education, there have been several approaches to how data processing and learner analytics have been used as part of TEA. Poor design of systems, data processing, or understanding/application of outcomes can lead to failure in ‘profile and predict,’ resulting in either unclear outcomes for learners (Foster and Francis 2020), negative impact on learners (through reinforcing the fear of failure) or development of ‘gaming behaviours’ (Archer and Prinsloo 2020). Of equal consequence is poor understanding and application of such systems by faculty and institutions (Lawson et al. 2016). In contrast, intelligent systems design and purposeful use of data can be used to ‘gather and guide,’ using data to identify and meaningfully support learners at risk of future failure (Foster and Siddle 2020) or support self-regulation and better learner choices (Broos et al. 2020), as shown in Case Study 4. A current challenge is that this principle is situated within a limited published evidence base which highlights mixed outcomes for education in terms of meaningful impact on learning (Shum and Luckin 2019).

사례 연구 4

Case study 4

지속적인 학습 및 평가 준비를 위한 온라인 형태 형성 평가, 학생 피드백 및 학습 분석 안내(호주 시드니 대학 Karen Scott)

Online formative assessment for continuous learning and assessment preparation, guided by student feedback and learning analytics (Karen Scott, University of Sydney, Australia)

맥락

Context

4년제 시드니 메디컬 프로그램의 학생들은 8주간의 소아과 블록에 참여한다. 대부분의 70~80명의 학생들은 시드니 웨스트메드에 있는 아동병원에 1일차 오리엔테이션, 5주차 수업, 8주차 시험을 위해 있으며, 8~12명의 학생들은 시골 병원에 있다. 나머지 블록에서 학생들은 어린이 병원, 광역 및 농촌 병원, 지역사회 보건 센터에서 임상 배치를 받는다.

Students in the four-year Sydney Medical Program undertake an 8-week paediatric block. Most of the 70–80 students are at The Children’s Hospital at Westmead, Sydney for the Day 1 orientation, Week 5 teaching, and Week 8 examinations; 8–12 students are at rural hospitals. For the remaining block, students undertake clinical placements at the Children’s Hospital, metropolitan and rural hospitals, and community health centres.

우리가 달성하려고 했던 게 뭐죠?

What were we trying to achieve?

소아과는 일반 소아과, 소아외과, 그리고 30개 이상의 하위 전공으로 구성되어 있다. 이 광범위한 교육과정에 걸쳐 학생들은 다양한 대면 및 가상 소규모 및 대규모 그룹 교육 세션을 준비하고, 학습을 통합, 검토 및 확장해야 합니다. 학생들은 블록 말기 필기시험과 임상시험도 준비해야 하며, 기말고사는 필기시험이 있다.

Paediatrics comprises general paediatrics, paediatric surgery, and over 30 sub-specialties. Across this broad curriculum, students need to prepare for a range of face-to-face and virtual small- and large-group teaching sessions, and consolidate, review and extend their learning. Students also need to prepare for end-of-block written and clinical examinations, and final-year has written examinations.

우리가 한 일

What we did

실질적인 온라인 자기 주도형 형성 평가가 개발되었다. 대부분은 전개, 사례 기반 학습으로 구성되어 핵심 지식을 임상 사례에 적용할 수 있다. 일부는 핵심 지식을 학습의 통합 및 확장을 위한 실습 활동과 통합한다. 모든 기능에는 광범위한 자동 피드백이 포함되어 있으며 일부는 보조 웹 링크가 포함되어 있습니다. 핵심지식개발(주로 짧은 포맷으로 녹음된 강의)에 초점을 맞춘 온라인 자료에는 자가테스트를 위한 형성 평가와 이를 통한 장기지식 보유가 포함된다.

Substantial online self-directed formative assessment has been developed: most comprise unfolding, case-based learning, enabling the application of core knowledge to clinical cases; some integrate core knowledge with practice activities for consolidation and extension of learning. All include extensive automated feedback, some with supplementary web links. Online materials focusing on core knowledge development (primarily short format recorded lectures) include formative assessment for self-testing and through this, long-term knowledge retention.

영향 평가

Evaluation of impact

학습 분석 및 학생 설문 조사에 따르면 대부분의 학생들은 대부분의 형태별 평가를 수행하며 더 많은 것을 원합니다! 최근 학습 분석과 평가 결과를 비교한 결과 학생들의 평가 결과는 일반적으로 형성적 평가를 사용하는 범위와 일치한다.

Learning analytics and student surveys show most students do most formative assessments—and want more! A recent comparison of learning analytics and assessment results highlights that students’ assessment results generally correspond with the extent to which they use formative assessment.

테이크홈 메시지

Take-home message

이 연구 결과는 모든 학생(특히 미니멀리스트 접근법을 취하는 학생)이 온라인 형성 평가를 잘 활용하도록 장려하기 위해 의료 프로그램 전체에 전달되고 있다.

This finding is being communicated throughout the Medical Program to encourage all students (especially those taking a minimalist approach) to make good use of online formative assessment.

[교육학적 원칙과 좋은 테크놀로지 설계]에 부합하면 TEA는 '올바른 데이터'를 수집하는 데 상당한 이점을 제공할 수 있으며, 이는 인간의 인지 부하를 해방시켜 데이터를 더 잘 이해하고 따라서 교수진의 시간을 학습자 지원에 집중할 수 있다. 여기에는 데이터 기반 신속한 교정조치(리케츠 및 블라이 2011), 코칭 및 멘토링 접근법(말레카 및 바우드 2021), 행동 넛지(담가드 및 닐슨 2018), 예방적 개입으로 (잠재적) 연말 실패 시점을 앞두고 적용되는 전문가 사례 관리가 포함될 수 있다(윈스턴 외 2012). 그러나 광범위한 데이터 수집은 [학습의 관리를 책임지는 사람들]과 [독립적인 행위자agents으로서 학습자 자신] 사이에 긴장을 야기할 수 있다(Tsai et al. 2020). [데이터 소유권에 대한 문제]는 문헌에 의해 대부분 해결되지 않았지만 가장 중요하다.