ChatGPT로 논문쓰기: 학술 저자를 위한 능력, 한계, 함의 (Perspect Med Educ. 2023)

Writing with ChatGPT: An Illustration of its Capacity, Limitations & Implications for Academic Writers

LORELEI LINGARD

ChatGPT와 기타 인공지능(AI) 도구가 학계 전반에 경종을 울리고 있습니다. 이러한 우려의 대부분은 ChatGPT가 교육에 어떤 영향을 미칠 것인가에 집중되어 있습니다. 학생의 학습에 어떤 영향을 미칠까요? 학생들의 부정행위가 만연할까요? 전통적인 지식 평가[1]의 종말을 의미할까요? 최근 이러한 우려는 우리의 학문적 사명에도 영향을 미쳤습니다. 새로운 기술 자원일까요, 아니면 과학적 무결성에 대한 위협일까요? 어떤 용도가 적절하며, 어떻게 인정해야 할까요?

ChatGPT and other artificial intelligence (AI) tools are raising alarm bells across academia. Much of the alarm centers on how ChatGPT will affect the educational mission. How will it affect student learning? Will it lead to rampant student cheating? Will it mean the death of traditional knowledge assessments [1]? Recently, the alarm has reached our scholarly mission as well. Is it a new technological resource, or a threat to scientific integrity? What uses are appropriate, and how should they be acknowledged?

이는 추상적인 질문이 아닙니다. ChatGPT는 이미 2023년 1월부터 사전 인쇄물 및 동료 심사를 거친 출판 논문에서 저자로 인정받고 있습니다[2]. 신뢰할 수 없는 또는 부정 사용에 대한 우려가 제기되어 왔으며[3], 현재 주요 학술지들은 이 문제에 대한 입장을 밝히고 있습니다.

- 예를 들어, 스프링거 네이처 저널은 연구에 대한 책임을 질 수 없기 때문에 ChatGPT는 공동 저자가 될 수 없다고 선언했으며, 연구자가 방법 또는 감사의 말 섹션에 ChatGPT를 사용한 사실을 문서화할 것을 요구하고 있습니다[4].

- Academic Medicine에서는 저자가 학술 연구에서 AI 도구의 사용을 공개하고, 그 사용의 성격을 투명하게 설명하며, 정확성과 무결성에 영향을 미치는 제한 사항을 인식하도록 안내합니다[5].

- 의료 교육, 연구 및 실무 분야의 최근 체계적 검토에서는 ChatGPT의 가능성을 인정하면서도 "윤리적, 저작권, 투명성 및 법적 문제, 편견의 위험, 표절, 독창성 부족, 환각의 위험이 있는 부정확한 콘텐츠, 제한된 지식, 잘못된 인용, 사이버 보안 문제, 인포데믹의 위험"을 고려하여 "극도로 신중하게" 도입해야 한다는 결론을 내렸습니다. [6].

These are not abstract questions. ChatGPT has already been credited with authorship in preprints and peer-reviewed published articles since January 2023 [2]. Concerns have been raised about its uncredited or fraudulent use [3], and major journals are now declaring their positions on the issue.

- For instance, the Springer Nature journals have declared that ChatGPT cannot be a co-author because it cannot take responsibility for the work, and they require that researchers document any use of ChatGPT in their Methods or Acknowledgements sections [4].

- Academic Medicine guides authors to disclose the use of AI tools in scholarship, describe transparently the nature of that use, and be aware of limitations that affect accuracy and integrity [5].

- A recent systematic review in the domain of healthcare education, research and practice acknowledged ChatGPT’s promise but concluded that it should be embraced with “extreme caution” considering concerns with “ethical, copyright, transparency, and legal issues, the risk of bias, plagiarism, lack of originality, inaccurate content with risk of hallucination, limited knowledge, incorrect citations, cybersecurity issues, and risk of infodemics.” [6].

우리는 이미 연구와 글쓰기를 지원하기 위해 테크놀로지를 사용하고 있습니다. 데이터 분석을 관리하기 위한 SPSS나 NVivo, 인용을 정리하기 위한 Reference Manager, 철자와 문법을 교정하기 위한 Grammarly 편집 소프트웨어가 없다면 어떻게 될지 상상해 보십시오. 이 작가의 기술에서는 작가들이 ChatGPT에 익숙해져서 효과적이고 적절하게 사용할 수 있도록 하는 것을 목표로 합니다. 2023년 3월과 4월에 ChatGPT4와 나눈 채팅을 바탕으로 그 기능과 한계를 설명하고, 일련의 주의 사항과 인사이트를 추출하여 점진적 프롬프트를 사용하여 소프트웨어를 '훈련'하는 방법, 브레인스토밍과 개요 및 요약과 같은 콘텐츠 생성에 사용하는 방법, 편집자로 활용하는 방법을 안내해 드립니다.

We already use technology to assist our research and writing. Imagine how you’d function without SPSS or NVivo to manage your data analysis, Reference Manager to organize your citations, or Grammarly editing software to correct your spelling and grammar. This Writer’s Craft aims to familiarize writers with ChatGPT so that they might use it effectively and appropriately. Drawing on chats I had with ChatGPT4 in March and April 2023 to illustrate its capacity and its limitations, I extract a series of Cautions and Insights and guide writers in how to use incremental prompting to ‘train’ the software, how to use it for brainstorming and generating content like outlines and summaries, and how to employ it as an editor.

ChatGPT란 정확히 무엇인가요?

What is ChatGPT, exactly?

ChatGPT는 AI 대규모 언어 모델입니다. 현재 버전(3.5 및 4.0)은 2021년 이전에 방대한 양의 데이터로 사전 학습되어 언어 패턴과 연관성을 학습하여 프롬프트가 표시될 때 사람과 유사한 대화 텍스트를 생성하는 데 사용할 수 있습니다. ChatGPT에 프롬프트를 입력하면 입력 내용을 분석하고 인터넷 사용 시 머신 러닝을 통해 얻은 정보를 바탕으로 신속하게 응답을 생성합니다. 이 기술은 사람과 유사한 텍스트로 정보를 처리하고 추출하여 구두로 표현하는 데 탁월하며[7], 특히 시간 제약과 기타 리소스 제한을 고려할 때[8] 글쓰기 노동의 일부를 아웃소싱할 수 있다면 학술 저술가에게 중요한 자산이 될 가능성이 있습니다.

ChatGPT is an AI large language model. Current versions (3.5 and 4.0) have been pre-trained on massive amounts of data pre-2021, allowing it to learn language patterns and associations which it uses to generate human-like conversational text when prompted. When you input a prompt into ChatGPT, it analyzes the input and rapidly generates a response drawn from information acquired via machine learning in engagement with the internet. It excels at processing, distilling and presenting information verbally in human-like text [7]; it has the potential, therefore, to be an important asset for academic writers, particularly if we can outsource some of the labor of writing [8] given time constraints and other resource limitations.

ChatGPT는 문법적으로 정확하고 의미적으로 의미 있는 응답을 생성합니다. 하지만 항상 정확한 것은 아닙니다. AI 대규모 언어 모델에는 일반적인 의미의 '지식'이 없고, 데이터를 저장하거나 검색하지 않으며, 검색 엔진처럼 웹을 크롤링하여 정보를 찾지 않기 때문입니다. 그들은 학습한 내용을 바탕으로 "시퀀스에서 다음 단어를 예측하는 데 능숙할 뿐"[9]입니다. 따라서 ChatGPT는 "사실 정확도가 고르지 못하며"[10], 텍스트의 내용이 진실하고, 견고하며, 검증 가능하고, 유효하며, 일반화 가능한지 확인하려고 하지 않습니다. [11]. 머신 러닝 용어로 "환각"을 일으켜 실제가 아닌 것처럼 보이는 자료를 자신 있게 제시할 수 있습니다[12].

ChatGPT generates responses that are grammatically correct and semantically meaningful. They are not, however, always accurate. This is because AI large language models don’t have ‘knowledge’ in the usual sense of the word; they don’t store or retrieve data; they don’t crawl the web like a search engine for information. They are “just good at predicting the next word(s) in a sequence” [9] based on what they have learned. Thus, ChatGPT has “uneven factual accuracy” [10]; moreover, it does not try to ensure that the content of its text is true, robust, verifiably, valid, generalizable, etc. [11]. In machine learning terms, it can “hallucinate”, confidently presenting legitimate-sounding material that it is not real [12].

점진적 프롬프트를 통한 ChatGPT 훈련

Training ChatGPT through incremental prompting

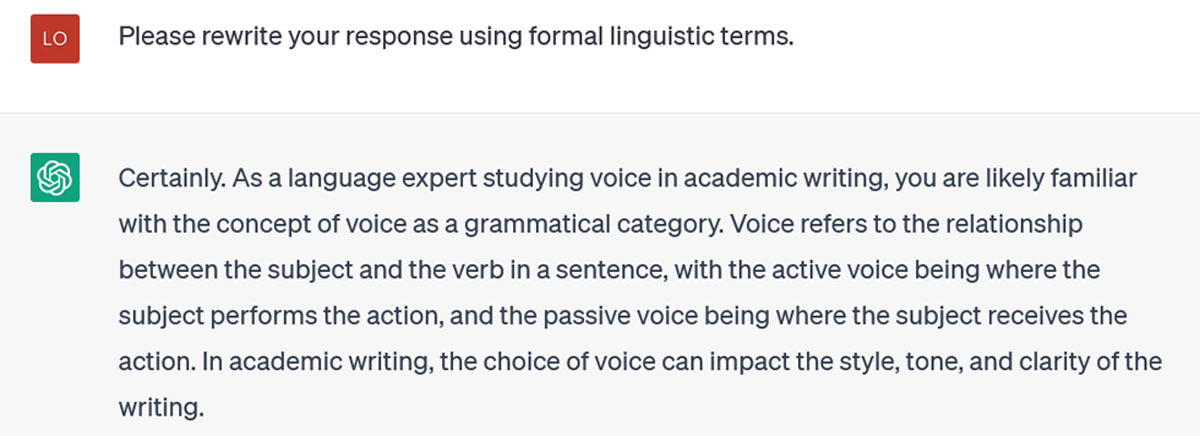

ChatGPT의 기본값은 일반적이고 설명적인 응답을 제공하는 것입니다. 점진적 프롬프트는 점차적으로 주의를 집중시키고 사용자의 관심사와 이해 수준에 맞는 응답을 제공하도록 훈련시키는 프로세스입니다. 아래 질문과 같은 일반적인 프롬프트가 시작점으로 좋습니다:

ChatGPT’s default is to offer generic and descriptive responses. Incremental prompting is the process by which you gradually focus its attention and train it to give you responses tailored to your interests and your level of understanding. General prompts are fine as a starting point, such as my question below:

능동태와 피동태에 대한 설명이 이어지지만, 제가 실제로 관심을 갖고 있는 부분은 아닙니다. 저는 좀 더 구체적인 답변을 얻고자 제 이야기를 해보려고 합니다.

lf:It goes on to explain active and passive voice, but that’s not really what I’m interested in. I try to get a more specific answer by telling it about myself:

스타일과 어조에 대해 이야기하고 대명사의 예가 더 구체적이라는 점에서 다소 나아졌습니다. 하지만 여전히 제가 원하는 것보다 더 일반적입니다. 제가 요청합니다:

That’s somewhat better: it’s talking about style and tone, and the example of pronouns is more specific. But it is still more generic than I would like. I ask it to:

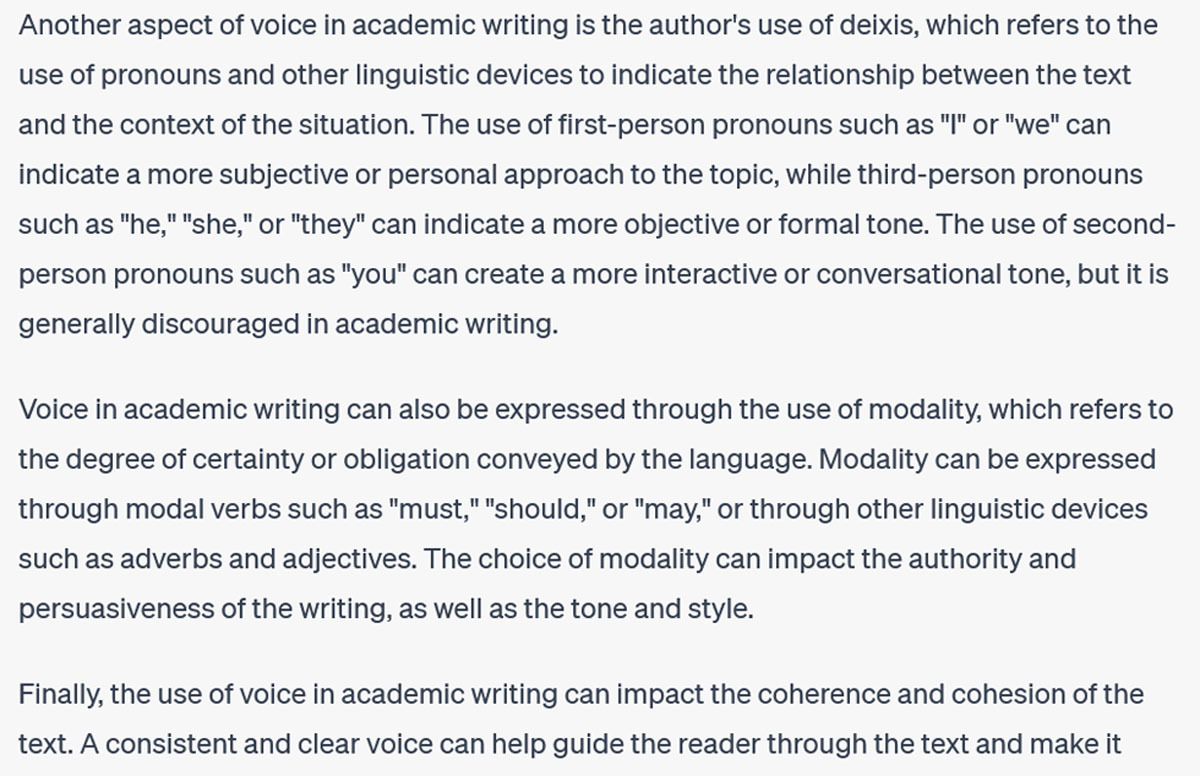

이 답변은 학술적 글쓰기에서 목소리에 대해 이야기하기 위해 좀 더 형식적인 언어적 특징을 사용하며, 딕시스, 양식 및 일관성에 대한 예를 제시합니다. 그러나 학자들이 학술적 목소리에 대해 이야기할 때 이러한 특징이 주된 관심사는 아닙니다. 그래서 다음 질문은 학술적 목소리의 저명한 언어학자에 대해 묻고 있습니다:

This response employs more formal linguistic features to talk about voice in academic writing, and offers illustrations of deixis, modality, and coherence. However, these aren’t the primary features that scholars are concerned with when they talk about academic voice. So my next prompt asks about a prominent linguistic scholar of academic voice:

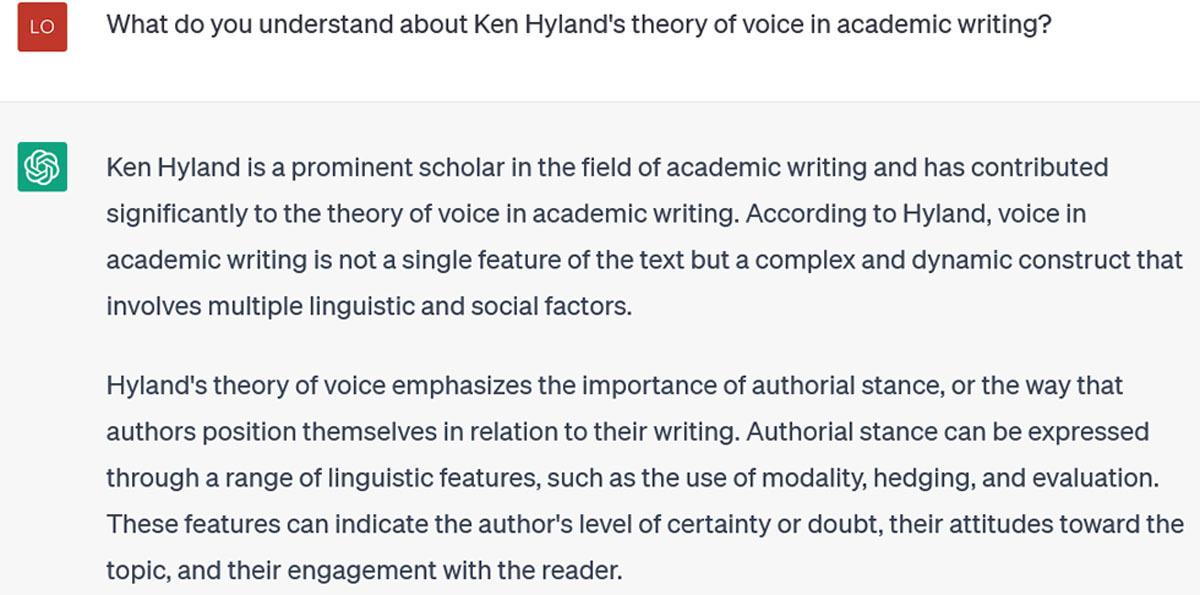

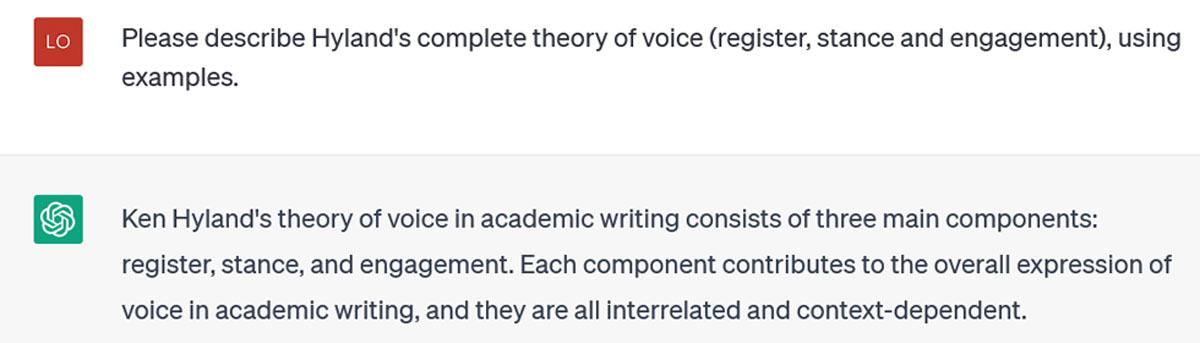

Hyland의 이론은 세 가지 주요 구성 요소로 이루어져 있으며, 그 중 하나만 명시적으로 응답("입장")에 표현되어 있습니다. 다음 점진적 프롬프트는 이를 더욱 집중적으로 다루려고 합니다:

This is accurate, but still generic and selective: Hyland’s theory has three main components, only one of which is explicitly represented in its response (“stance”). My next incremental prompt tries to focus it further:

이제 ChatGPT는 Hyland의 이론에 대한 360단어 설명과 함께 세 가지 구성 요소에 대한 유용한 예시를 몇 초 만에 제공할 수 있게 되었습니다. 하지만 이제 궁금한 점이 생겼습니다. 제가 프롬프트에서 Hyland에 집중하느라 음성 관련 다른 언어 이론에 대해 알려주지 않은 것은 무엇일까요? 그래서 묻습니다:

ChatGPT is now able, in a few seconds, to offer a 360-word description of Hyland’s theory with helpful, illustrative examples of its three components. But now, I wonder, what other linguistic theories of voice did it not tell me about, due to my focusing in on Hyland in my prompting? So I ask:

이제 ChatGPT는 음성에 대한 네 가지 중요한 이론을 설명하며, 점진적인 프롬프트를 통해 더 자세히 살펴볼 수 있습니다. 또한 이러한 이론을 비교하거나 이론 간의 긴장을 설명하거나 더 최근의 이론가들이 이러한 이론을 어떻게 구축했는지 제안하도록 요청할 수도 있습니다. 이 정도의 구체성에 도달하면 ChatGPT는 여러분이 직접 읽고 쓸 때 추구해야 할 아이디어 간의 연결점을 지적하는 데 매우 유용할 수 있습니다.

Now ChatGPT describes four important theories of voice, which I could probe further with incremental prompting. I could also ask it to compare these theories, or to describe tensions among them, or to suggest how more recent theorists have built on them. Once you get to this level of specificity, ChatGPT can be very helpful in pointing out connections among ideas for you to pursue in your own reading and writing.

이 대화에서 알 수 있듯이 점진적 프롬프트는 ChatGPT의 응답 가치를 극대화하는 데 핵심적인 역할을 합니다. 그러나 효과적인 증분 프롬프트를 사용하려면 도메인에 대한 지식이 필요합니다. 도메인을 이미 잘 알고 있어야 ChatGPT의 응답이 얼마나 정확하고 선택적이거나 포괄적인지 판단하고 후속 프롬프트를 사용하여 응답을 개선할 수 있습니다. 잘 모르는 도메인에 대해 질문하면 ChatGPT가 어떤 정보를 선택했는지, 왜 어떤 것을 선택했는지, 왜 다른 것을 선택하지 않았는지 불분명합니다.

As this conversation illustrates, incremental prompting is a key to maximizing the value of ChatGPT’s responses. But effective incremental prompting requires domain-specific knowledge: you need to know the domain quite well already, so that you can judge the extent to which ChatGPT’s response is accurate, selective or comprehensive, and use follow up prompts to improve it. If you ask it about domains you don’t know well, it will be unclear what information ChatGPT has selected from, and why it has selected some things and not others.

마지막으로 '학습' ChatGPT에 대해 한 가지 더 말씀드리자면, 학습한 내용이 현재 채팅을 넘어 일관되게 전달되지 않는 것 같습니다. 별도의 채팅을 열고 "켄 하일랜드의 학문적 음성 이론에 대해 무엇을 이해하나요?"라고 다시 질문했을 때, 첫 번째 응답은 이 모델의 세 가지 특징을 모두 설명하는 것으로 이전 채팅에서 학습한 내용이 전달되는 것처럼 보였습니다. 하지만 다음 섹션에서 설명하겠지만 항상 그런 것은 아닙니다.

One final point about ‘training’ ChatGPT: what it learns does not appear to consistently transfer beyond the current chat. When I opened a separate chat and asked again “What do you understand about Ken Hyland’s theory of academic voice in writing”, the first response included described all three features of this model: that seemed to represent learning transferred from the previous chat. But this is not always the case, as I will discuss in the next section.

| 주의: ChatGPT의 기본 응답은 일반적이면서도 (눈에 보이지 않게) 선택적인 응답을 제공합니다. 인사이트: 점진적 프롬프트는 구체성을 높이고, 선택을 안내하며, 제외 항목을 표시할 수 있습니다. Caution: ChatGPT’s default responses are both generic and (invisibly) selective. Insight: Incremental prompting can increase specificity, guide selections & reveal exclusions. |

브레인스토밍을 위한 ChatGPT 사용

Using ChatGPT for brainstorming

ChatGPT는 다른 기능보다 몇 가지 기능이 더 뛰어납니다. 가장 큰 차이점은 콘텐츠 생성과 구조적 지원입니다. 콘텐츠 생성의 경우, 앞서 학술적 글쓰기 음성에 대한 대화에서 설명한 것처럼 ChatGPT가 제공하는 콘텐츠의 품질을 판단하려면 콘텐츠를 잘 알고 있어야 합니다. 소프트웨어가 잘하는 것으로 확인된 콘텐츠 생성의 한 가지 형태는 개요 생성입니다[13]. 저는 이 작가의 기술에 대한 개요를 제공하기를 원했기 때문에 작가의 기술 장르에 대해 무엇을 알고 있는지 물어보는 것부터 시작했습니다:

ChatGPT is better at some things than others. The main distinction is between content generation and structural support. In terms of content generation, as the previous conversation about academic writing voice illustrated, you need to know the content well to judge the quality of what ChatGPT is giving you. One form of content generation that the software has been identified to be good at is the creation of outlines [13]. I wanted it to provide an outline for this Writer’s Craft for me, so I began by asking what it knew about the Writer’s Craft genre:

여기서 멈추세요. '작가의 기술'은 일련의 책이 아니며, 저는 이런 제목의 책을 쓴 적이 없습니다. 이 예에서 알 수 있듯이 점진적 프롬프트의 각 단계에서 잘못된 응답을 경계해야 합니다. ChatGPT는 두뇌가 아닌 텍스트 생성기입니다. 질문한 주제와 관련하여 함께 찾을 수 있는 단어를 조합하는 것입니다. 그렇다고 해서 이 단어들이 서로 '속한다'거나 '진실'이라는 의미는 아닙니다. 사실 ChatGPT는 헛소리를 만들어내는 것을 즐기는 것 같습니다. 이 서비스가 제공하는 참고 자료를 절대 신뢰할 수 없습니다. 2021년 이후의 자료에 접근할 수 없기 때문만이 아니라, 작가의 기술 시리즈는 2015년까지 거슬러 올라가는데, 이를 알지도 못하고 찾으려고 하지도 않는 것 같습니다. 대신 "환각"을 일으켜 책 시리즈를 구성합니다. 다행히도 "생성 중지" 버튼을 누르면 이 작업을 중단할 수 있습니다. 그런 다음 수정했습니다:

Stop right there: the Writer’s Craft is not a series of books, and I have never written books with these titles. As this illustrates, at each stage of the incremental prompting, you should be alert for false responses. ChatGPT is a text generator, not a brain: it is putting together words that are likely to be found together around the topic you’ve asked about. That doesn’t mean these words ‘belong’ together or that they are ‘true’. In fact, ChatGPT seems to enjoy making sh*t up. You absolutely cannot trust the references it gives you. And not only because it doesn’t have access to material post-2021; the Writer’s Craft series extends back to 2015, but it doesn’t know them and apparently doesn’t try to find them. Instead, it “hallucinates”, making up a book series. Happily, you can stop it in its tracks when it does this, by hitting the “Stop Generating” button, which I did. Then I corrected it:

이 답변 역시 프롬프트에서 말씀드린 내용을 대부분 반복하는 것이기 때문에, 집중해서 작가의 기술 시리즈 제목을 물어봄으로써 구체적인 내용을 파악하려고 노력했습니다:

This answer too, is mostly repetition of what I told it in the prompt, so I try to focus it down and get specifics by asking for the titles of the Writer’s Craft series:

문제는 이러한 제목이 실제 제목이 아니라 지어낸 제목이라는 것입니다. 특정 참고 문헌을 제공하라는 메시지가 표시되면 종종 이를 만들어내는 경우가 많다는 점이 ChatGPT의 주요 약점 중 하나입니다[14]. 이러한 발명품은 단어 연관성을 기반으로 하기 때문에 키워드와 공동 저자의 현실적인 조합을 갖게 됩니다. 하지만 가짜가 아닐 가능성도 그만큼 높습니다. 이 문제를 해결하기 위해 웹에 대한 ChatGPT의 액세스를 개선하거나 Google Scholar 참조로 제한하는 확장 프로그램과 같은 기술이 등장하고 있지만, 그 효과에 대한 보고는 다양합니다[15].

The problem is, these aren’t real titles: they’re made up. This is one of ChatGPT’s main weaknesses: when you prompt it to provide specific references, it often invents them [14]. Because these inventions are based on word associations, they will have realistic combinations of keywords and coauthors. But they are as likely as not to be bogus. Techniques for addressing this problem are emerging, such as extensions that improve ChatGPT’s access to the Web or restrict it to Google Scholar references; however, reports of their effectiveness vary [15].

| 주의: ChatGPT는 사용자에게 거짓말을 할 수 있으며, 이러한 현상은 AI 환각으로 알려져 있습니다. 인사이트: 생성하는 모든 콘텐츠, 특히 참고 문헌을 다시 한 번 확인하세요. Caution: ChatGPT will lie to you, a phenomenon known as an AI hallucination. Insight: Double check any content it generates, particularly references. |

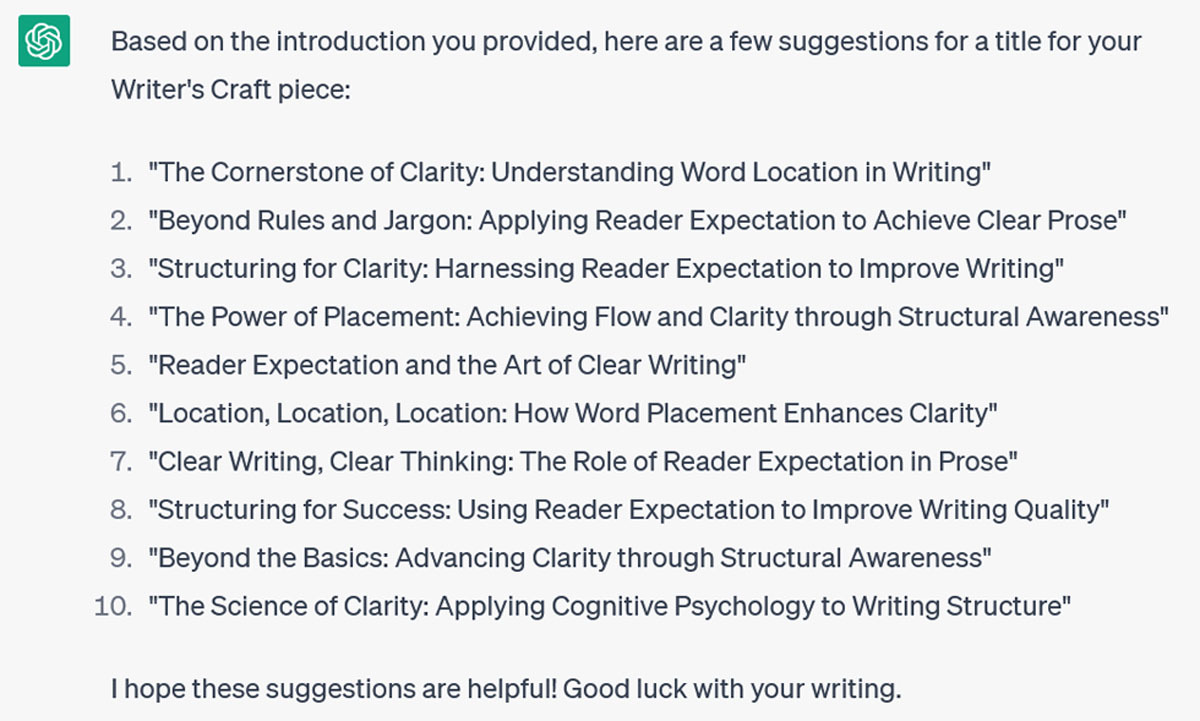

하지만 ChatGPT는 제목에 있어서는 다소 창의적이라고 말할 수 있습니다. 예를 들어, 저는 이 가짜 작가의 기술이라는 제목을 썼으면 좋았을 것 같습니다: "링가드 L. 나를 설득하라: 논증의 기술. 의학 교육에 대한 관점. 2013; 2(2): 75-78." 이는 소프트웨어를 효과적으로 사용하는 한 가지 방법이 제목 제안을 요청하는 것임을 시사합니다. 실험으로, 저는 최근 '독자를 위한 글쓰기'라는 제목을 붙인 '작가의 기술'의 도입 단락을 제공했습니다: 독자를 위한 글쓰기: 독자의 기대 원칙을 사용하여 명확성 극대화하기"라는 제목을 붙인 글의 도입부를 제공하고 가능한 제목을 물어보았습니다:

I will say, though, that ChatGPT is rather creative when it comes to titles. I wish, for instance, that I had written this fake Writer’s Craft: “Lingard L. Convince me: the art of argumentation. Perspectives on Medical Education. 2013; 2(2): 75–78.” This suggests that one way to use the software effectively would be to ask it for title suggestions. As an experiment, I give it the introductory paragraphs from a recent Writer’s Craft (that I had entitled “Writing for the Reader: Using Reader Expectation Principles to Maximize Clarity) and I ask it for possible titles:

저는 특히 1번과 6번을 좋아하는데, 만약 제가 새 제목을 쓴다면 이 중 몇 가지를 조합해서 쓸 것 같습니다.

Some of these are pretty good: I especially like 1 and 6, and if I were going to write a new title it would likely combine pieces of these favorites.

ChatGPT에서 이 작가의 기술에 대한 개요를 작성하기 위해 ChatGPT를 사용했던 시도로 돌아가 보겠습니다.

Back to my attempt to get ChatGPT to create an outline for this Writer’s Craft on ChatGPT.

실제 작가 크래프트 작품에 익숙해지도록 하려고 했지만 잘 안 되더군요.

I tried to get it to familiarize itself with actual Writer’s Craft pieces, but it resisted.

처음에는 능력과 시간(!)이 있는 것은 분명한데 실제로 시리즈 전체를 읽는 것을 거부하는 것이 당황스러웠습니다. 아마도 모든 참조를 제공하면 더 잘 반응 할 것입니다. 하지만 여기서는 다시 일반론으로 돌아갑니다: "이 시리즈는 약 20개의 아티클로 구성되어 있으며, 각 아티클은 학술적 글쓰기의 다른 측면에 초점을 맞출 것입니다...", "이 시리즈는 연구자들이 학술적 글쓰기에 사용할 수 있는 실용적인 조언과 전략을 제공할 것입니다..." 등등. 지금까지는 ChatGPT가 실제로 제가 예시로 제공한 특정 글쓰기를 포함하여 작가의 기술 중 어느 것도 읽지 않았다는 확신을 가질 수 없었습니다. 하지만 ChatGPT는 읽거나 분석하는 것이 아니라 언어 패턴을 인식하는 것뿐이라는 것을 기억합니다. 그래서 다시 묻습니다:

At first I’m puzzled that it resists actually reading the entire series, as it surely does have the ability and the time (!). Perhaps if I gave it all the references it would respond better. Here though, it reverts again to generalities: “The series consists of approximately 20 articles, each of which likely focuses on a different aspect of academic writing…”; The series likely provides practical advice and strategies for researchers to use in their academic writing…”, and so on. So far, I can’t have confidence that ChatGPT has actually read any of the Writer’s Crafts, even the specific one that I provided as an example. But then I remember that ChatGPT is neither reading nor analyzing – it’s just recognizing language patterns. Thus, I prompt again:

점점 가까워지고 있습니다. ChatGPT가 이 작가의 기술의 주요 구조를 파악했다는 것을 알 수 있을 정도로 충분한 디테일이 있습니다. 하지만 제 자신의 기존 지식이 얼마나 중요한지 주목하세요: 저는 이 기사를 잘 알고 있기 때문에(제가 작성했습니다!) ChatGPT가 일반적인 내용을 말하는 경우와 제가 지시한 기사에 대해 실제로 이야기하는 경우를 쉽게 구분할 수 있었습니다.

That’s getting closer. There is sufficient detail that I can tell ChatGPT has picked up the main structure of this Writer’s Craft. Notice though, how important my own existing knowledge is: I know this article well (I wrote it!) and so I have been able to readily discern when ChatGPT is spouting generic stuff and when it is actually talking about the article(s) I’ve directed it to.

| 주의: ChatGPT에 의존해 기사를 읽지 마세요. 인사이트: 낯선 도메인보다는 익숙한 도메인과 관련하여 ChatGPT를 사용하세요. Caution: Don’t rely on ChatGPT to read articles for you. Insight: Use ChatGPT in relation to familiar domains rather than unfamiliar ones. |

이제 (마침내) 특정 글쓰기 기술의 특징을 인식하도록 만들었으니 원래의 목표, 즉 이 글의 개요를 브레인스토밍하는 데 ChatGPT를 사용하도록 하는 것에 도달할 수 있게 되었습니다:

Now that I’ve (finally) gotten it to recognize the features of a specific Writer’s Craft, I can get to my original aim: getting ChatGPT to brainstorm an outline for this paper:

이것은 유용합니다. 물론 제가 가르쳤던 '작가의 기술'의 형식과 정확히 일치하는 것은 아니며, 다소 일반적인 구조로 되돌아갔습니다. 그리고 제가 실제로 이 글을 어떻게 구성하기로 결정했는지는 (눈치 채셨을 것입니다) 아닙니다. 그러나 필요한 섹션 중 일부를 개념화하는 데 도움이됩니다. 그리고 초안 작성 과정에서 다시 돌아가서 제가 무엇을 강조하고 간과했는지 확인하는 데 유용했습니다.

This is useful. Admittedly, it’s not precisely the format from the Writer’s Craft I trained it on: it has reverted to a somewhat more generic structure. And it is not (you will have noticed) how I actually decided to organize this piece. It does, however, help me conceptualize some of the necessary sections. And it was useful to return to during the drafting process, to see what I was emphasizing and overlooking.

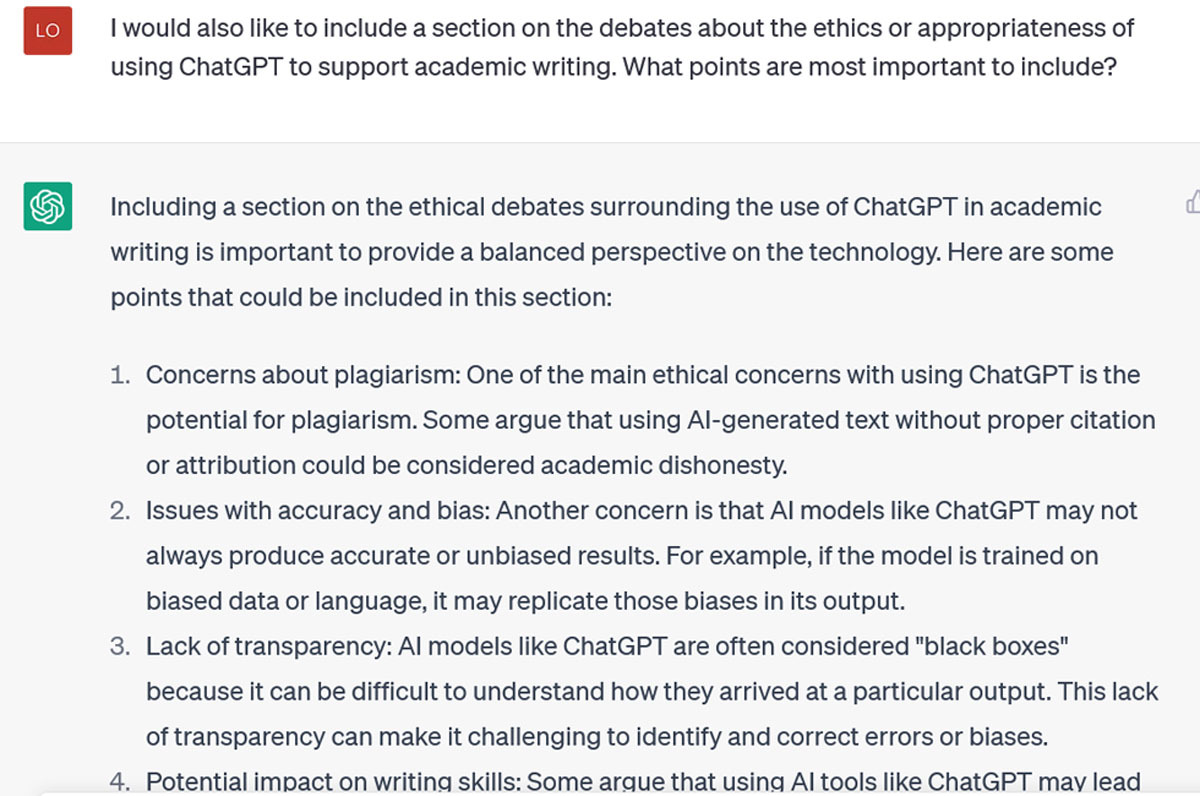

점진적인 프롬프트를 통해 ChatGPT를 이 단계까지 끌어올리면 모든 종류의 브레인스토밍을 할 수 있는 정점에 도달한 것입니다. 각 섹션을 완성하는 데 도움이 되는 몇 가지 구체적인 정보가 필요하다고 가정해 봅시다:

Once you get ChatGPT to this point through incremental prompting, you’re on the cusp of all kinds of brainstorming bounty. Let’s say you want some specifics to help you flush out each section:

| Insight: If you dread the blank page, a ChatGPT outline could jumpstart your drafting process. Caution: Its ideas are generic; use them as a starting place, not a replacement for your own. |

글의 깊이를 더하기 위해 몇 가지 추가 아이디어를 짜는 데 도움이 필요하다면 어떻게 해야 할까요? 가능한 한 구체적으로 말씀해 주세요:

What if you wanted help weaving in some additional ideas, to deepen the piece of writing? Just ask, remembering to be as specific as you can be:

이것들은 모두 관련성이 있는 요점들이며, 각각에 대한 이해를 마무리하기 위해 Google Scholar에 입력할 수 있는 검색어를 제공합니다.

These are all relevant points, and they provide me with search terms I could input into Google Scholar to round out my understanding of each.

위의 채팅에서 볼 수 있듯이 ChatGPT를 사용하여 견고한 윤곽을 만들 수 있습니다. 글을 쓸 장르에 대해 훈련하고 다룰 주제 영역에 대한 지식을 판단해야 하지만, 이러한 단계를 수행한 후에는 순서, 섹션, 강조점이 다른 일련의 개요를 빠르게 요청할 수 있습니다. 이렇게 하면 원고에 접근하는 다양한 방법을 상상해보고 가장 적합한 방법을 선택하여 초안을 작성하는 데 도움이 됩니다.

As my chat above illustrates, ChatGPT can be used to create solid outlines. You need to train it on the genre you’re going to write in and you need to judge its knowledge about the subject areas you’ll cover, but once you’ve taken those steps you can quickly request a series of outlines with different orders, sections, emphases. This can help you imagine different ways of approaching the manuscript: choose the best one, and start drafting.

ChatGPT는 일단 올바른 방향으로 안내를 받으면 빠르게 진행되지만(전체 채팅은 10분도 채 걸리지 않았습니다), 이러한 훈련 노력이 새로운 채팅으로 이어지지는 않습니다. 시스템은 모든 채팅 로그를 저장합니다. 사이드바에서 채팅 로그를 보고 다시 돌아가서 액세스할 수 있지만, 이는 개별적인 개체입니다. "컨텍스트 메모리는 현재 대화에만 적용됩니다. ChatGPT의 상태 비저장 아키텍처는 대화를 독립적인 인스턴스로 취급하기 때문에 이전 대화의 정보를 참조할 수 없습니다. 새 채팅을 시작하면 항상 모델의 상태가 초기화됩니다."[16]. 이 사실을 모르고 며칠 후 새 채팅을 시작하고 "연구자들의 학술적 글쓰기 향상을 돕기 위해 로렐라이 링가드가 (주로) 쓴 '작가의 기술' 시리즈에 대해 아는 것을 말해 주세요"라고 다시 물었더니 제가 쓴 적도 없는 책 5권에 대해 또다시 대답을 들었습니다. 저장된 채팅 로그로 돌아가서 중단한 부분부터 다시 프롬프트를 받았을 때 결과는 더 나아졌지만 일관성이 없었는데, 이는 ChatGPT의 문맥 기억의 한계 때문이거나 "관련성이 없다고 판단되는 지시를 삭제하는"[16] 경향으로 인해 "문맥을 깨뜨리는" 경향 때문일 수 있습니다.

ChatGPT is fast once you get it pointed in the right direction (this whole chat took less than 10 minutes), but that training effort doesn’t transfer to new chats. The system saves all your chatlogs: you can see them on the sidebar and go back and access them, but they are discrete entities. “Contextual memory only applies to your current conversation. ChatGPT’s stateless architecture treats conversations as independent instances; it can’t reference information from previous ones. Starting new chats always resets the model’s state” [16]. Not knowing this, a few days later I started a new chat and asked it again “Tell me what you know about the Writer’s Craft series written (predominantly) by Lorelei Lingard to help researchers improve their academic writing”, only to be told again about 5 books I had never written. When I went back into saved chat logs and picked up my prompting where I’d left off, the result was better but not consistently so, which may be due either to limits on ChatGPT’s contextual memory or to its tendency to “break character” due to “dropping instructions it deems irrelevant” [16].

| 주의: ChatGPT는 여러 채팅에서 수행한 훈련을 전송하지 않습니다. 인사이트: 저장된 채팅 로그로 돌아가서 이전 프롬프트를 통해 수행한 훈련을 바탕으로 학습할 수 있을 것입니다. Caution: ChatGPT doesn’t transfer the training you’ve done across chats. Insight: Try returning to saved chat logs; you may be able to build on the training you’ve done through previous prompting. |

반론, 요약 및 요약 생성하기

Generating counterarguments, summaries, and abstracts

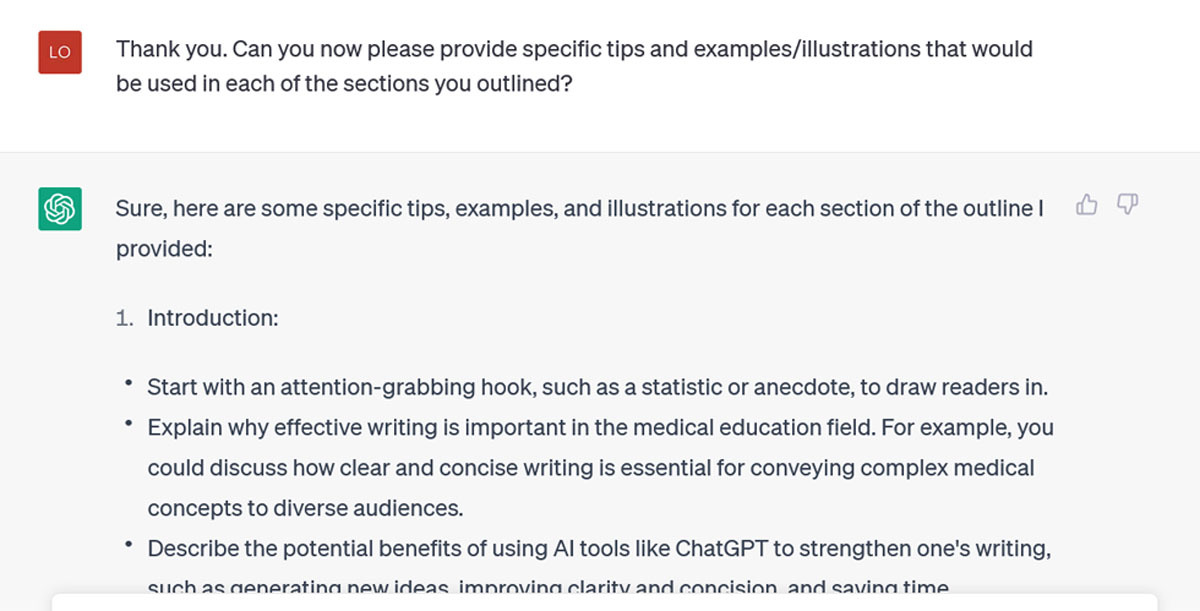

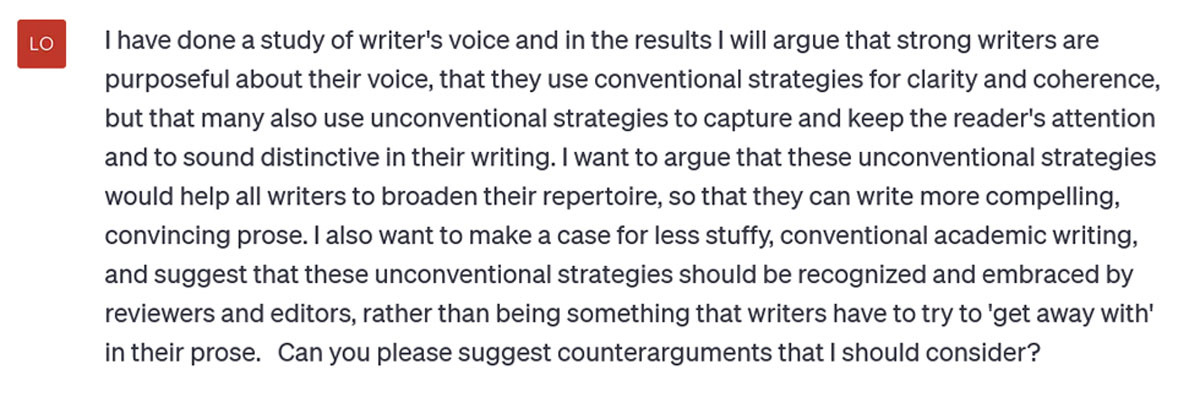

콘텐츠 생성에 ChatGPT를 사용하는 유용한 방법은 개요뿐이 아닙니다. 또한 주장의 한 부분을 검토하고 반론을 제안하도록 요청할 수도 있습니다. 사용하는 ChatGPT 버전이 중요하다는 점을 명심하세요. 무료 ChatGPT 3.5는 읽고 응답할 수 있는 단어가 약 500단어로 제한되어 있으므로 전체 결과 또는 토론 섹션을 입력하면 이 오류 메시지가 표시됩니다:

Outlines are not the only useful way to use ChatGPT for content generation. You can also ask it to review a section of your argument and suggest counter arguments. Keep in mind that the version of ChatGPT you use matters. The free ChatGPT 3.5 has a limit of about 500 words on what it can read and respond to, so if you input your whole results or discussion section you’ll get this error message:

유료 버전인 ChatGPTPlus는 한 번에 최대 25,000단어까지 처리할 수 있지만, 읽고 응답할 수 있는 단락을 몇 개 이상 입력하려고 하면 여전히 오류 메시지가 표시됩니다. 따라서 초안을 작성하는 동안 섹션에 대한 대략적인 요약을 제공하고 반론을 요청하는 것이 더 낫다고 생각합니다. 이 프롬프트에서는 현재 작업 중인 논문 결과의 요점을 요약하고, 그 결과를 바탕으로 제가 주장하고자 하는 바를 ChatGPT에 말한 다음 반론을 제시해 달라고 요청합니다:

ChatGPTPlus (the paid version) is supposed to handle up to 25,000 words at a time, but I still received the error message when I tried to input more than a few paragraphs for it to read and respond to. Therefore, I think it’s better to give it a rough summary of a section (say, while you’re still drafting it) and ask it for counterarguments. In this prompt I summarize the gist of the results of a paper I’m currently working on, tell ChatGPT what I want to argue based on those results, and ask it to suggest counterarguments:

약 3초 만에 (얼마나 빨리 작동하는지 아직도 숨이 멎을 정도입니다) ChatGPT는 이를 제공합니다:

In about 3 seconds (it still leaves me breathless how quickly it works), ChatGPT offers this:

이 정도면 충분했습니다: 토론의 '반론' 섹션을 쉽게 작성할 수 있습니다. 이러한 아이디어 중 일부를 완전히 이해하지 못했거나 더 구체적인 내용을 원할 경우, 추가 질문을 통해 답변에 집중할 수 있습니다.

This is enough to get my wheels turning: I could readily start writing a ‘counterargument’ section of my discussion. If I don’t understand fully some of these ideas or I want more specificity, further prompting would focus these responses.

| 통찰력: ChatGPT는 좋은 브레인스토밍 리소스가 될 수 있습니다. 주의: 하지만 그 제안을 맹목적으로 받아들이지 마세요. 여러분은 인공지능보다 더 똑똑합니다(적어도 현재 형태에서는). Insight: ChatGPT can be a good brainstorming resource. Caution: But don’t accept its suggestions blindly. You are smarter than it is (at least in its current form). |

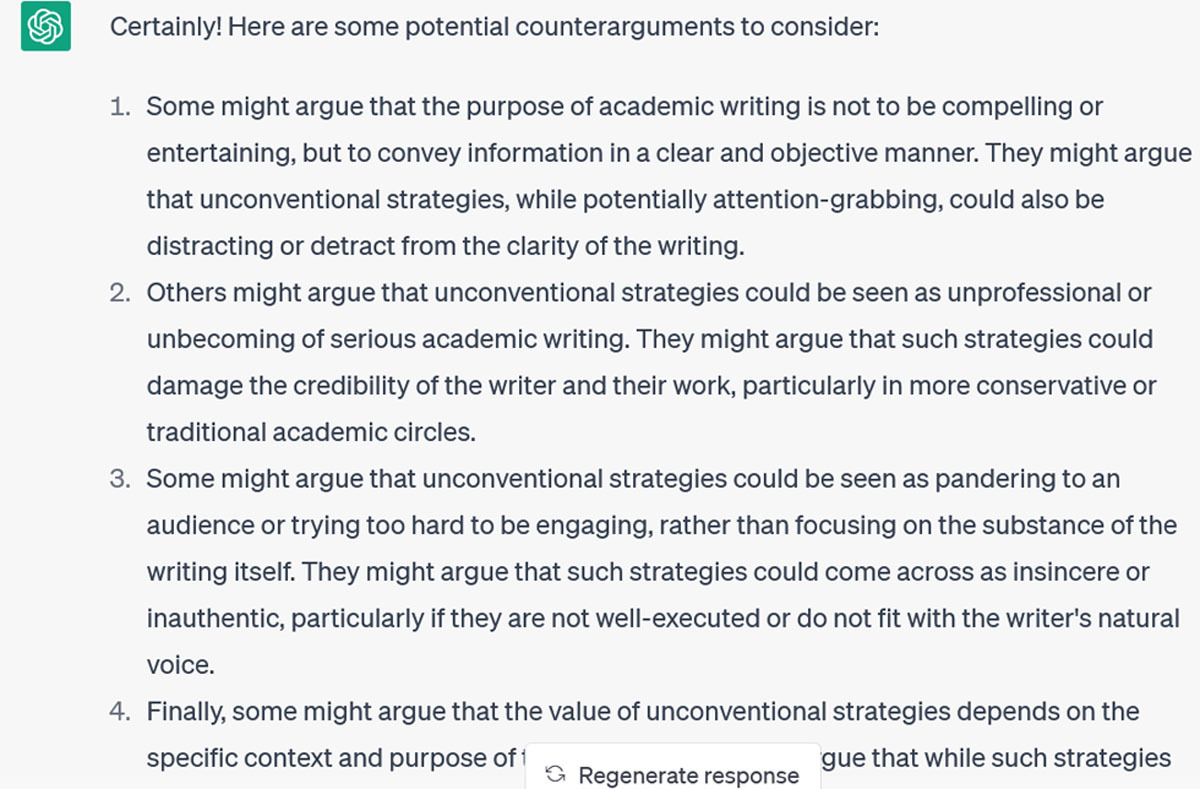

ChatGPT와 같은 AI 도구는 더 많은 청중이 더 쉽게 접근하고 포용할 수 있는 글을 작성하는 데에도 도움이 될 수 있습니다. 예를 들어, 최근 지원금 신청서의 첫 문단을 주고 100단어로 된 일반인용 요약문을 작성해 달라고 요청했더니 응답이 왔습니다:

AI tools like ChatGPT can also help you to make your writing more accessible and inclusive of a wider audience. For instance, I gave it the opening paragraphs of a recent grant application and asked it to generate a 100-word lay summary, to which it responded:

이는 여전히 다소 형식적인 표현으로, 처음 프롬프트에서 '평이한 요약'의 의미가 자명하지 않은 것 같아서 더 자세히 설명했습니다:

This was still a bit formal, suggesting that the meaning of ‘lay summary’ was perhaps not self-evident in my initial prompt, so I prompted it further:

이제 수정할 수 있는 초안이 완성되었으니, 예를 들어 '과학적 무결성'과 같이 삭제된 키워드 몇 개를 다시 넣을 수 있을 것입니다. 하지만 실행 가능한 초안이 있었기 때문에 최소 30분의 작업 시간을 절약할 수 있었습니다.

This is an acceptable first draft that I can now rework; for instance, I would probably reinstate a few of the keywords (like “scientific integrity”) that were removed. But having a workable draft to start from has probably saved me at least 30 minutes of work.

초록은 ChatGPT가 도움을 줄 수 있는 또 다른 글쓰기 노동입니다. 프롬프트에 입력할 수 있는 단어가 제한되어 있어 논문 전체를 읽을 수 없기 때문에 첫 번째 초록 초안을 작성하는 데는 도움이 되지 않습니다. 하지만 항상 너무 긴 초록의 첫 초안을 필요한 단어 수 제한으로 줄이는 데는 도움이 될 수 있습니다. 이는 대부분의 사람들이 기꺼이 아웃소싱할 수 있는 노동력입니다: 저는 아직 초록의 단어 수를 줄이는 작업(과 시간!)을 소중히 여기는 작가를 만나지 못했습니다. 하지만 인공지능에게 완벽하게 적합한 것처럼 보이는 이 작업도 전적으로 신뢰할 수는 없습니다.

Abstracts are another piece of writing labor that ChatGPT can help with. It can’t help you with your first abstract draft, because it can’t read your entire paper due to limits on the words you can enter in a prompt. But it can help you take your abstract’s first draft, which is invariably too long, and reduce it to the required word limit. This is labor most of us would be happy to outsource: I have yet to meet a writer who cherishes the task (and time!) of whittling words from their abstract. But even with this task which seems perfectly suited to AI, you can’t entirely trust it.

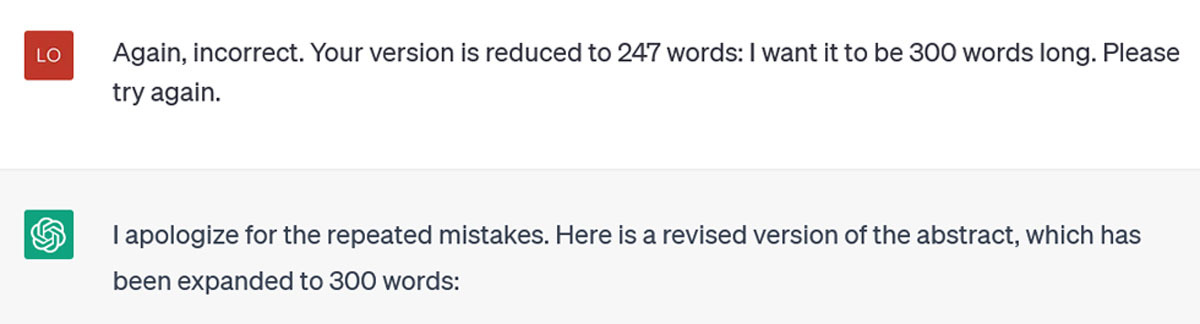

예를 들어, 제가 제공한 구조화된 초록에서 27개의 단어를 제거해 달라고 요청하면서 내용 그대로를 최대한 적게 다시 작성해 달라고 덧붙였습니다. 그 결과 약 100단어 길이의 비정형 버전이 만들어졌습니다. 저는 응답했습니다:

As illustration, I asked it to remove 27 words from a structured abstract which I provided, adding that I wanted it to rewrite as little as possible as I liked the content as it was. It produced an unstructured version about 100 words long. I responded:

이제 구조화된 초록이 반환되었지만 여전히 제가 요청한 것보다 훨씬 짧았습니다. 이번에는 단어 수를 빼는 수학적 작업을 요청하지 않고 응답에 대한 단어 수 제한(300개)을 설정하여 다시 요청했습니다(약간 짜증이 났음을 고백합니다):

Now it returned a structured abstract, but still much shorter than I had requested. I prompted again (I confess, a bit irritated), this time not asking it to do the mathematical task of subtracting the number of words, but setting a word limit (300) for its response:

이해하는 것 같지만 다음 버전도 300 단어가 아니 었습니다 (예, 이때까지 단어 수를 확인하기 위해 모든 시도를 Word 문서에 복사하여 붙여 넣었습니다):

It seems like it understands, but the next version wasn’t 300 words either (yes, by this time I was copying and pasting all the attempts into a Word document to check the word count):

마지막으로 성공: 최종 버전은 310단어였습니다(이 중 10개가 구조화된 제목이었으므로 ChatGPT에 점수를 주겠습니다).

Finally, success: the last version was 310 words (we’ll give ChatGPT the point, because 10 of those were the structured headings).

| 인사이트: ChatGPT는 분명히 셀 수 없습니다. 주의: 구체적인 작업을 수행하더라도 실패에 주의해야 합니다. Insight: ChatGPT apparently can’t count. Caution: Even with concrete tasks, be alert for failure. |

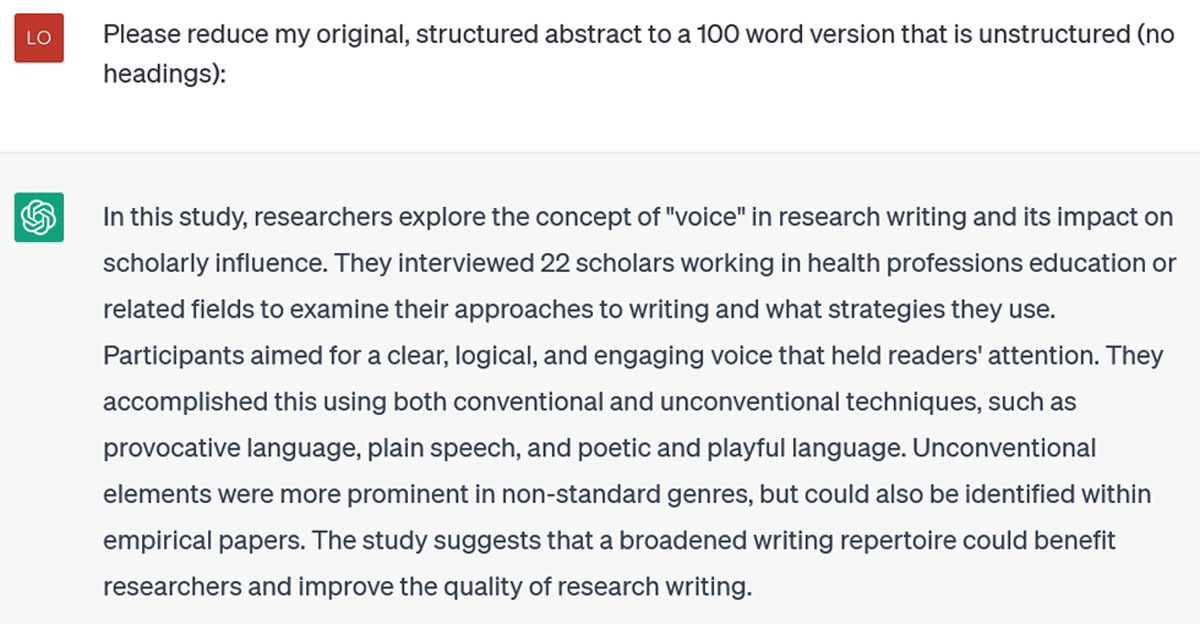

물론 수학 문제를 풀도록 요청하면 ChatGPT는 계산할 수 있습니다. 하지만 정확한 단어 개수를 세는 것은 분명 장점은 아닙니다. 그럼에도 불구하고 ChatGPT는 기존 초록을 새로운 목적에 맞게 재구성하는 데 여전히 유용합니다. 250단어로 구성된 구조화된 컨퍼런스 초록이 있는데, 100단어로 구성된 비정형 초록이 필요한 다른 컨퍼런스에 제출하고 싶다고 가정해 보겠습니다:

ChatGPT can count, of course: if you ask it to solve math problems, it can do so. But exact word counts clearly aren’t its forte. Nevertheless, ChatGPT is still useful for reformatting existing abstracts for new purposes. I have a structured conference abstract of 250 words, which I want to submit to another conference that requires unstructured, 100-word abstracts:

아직 정확하게 계산하지는 못했지만(108단어) 비정형 초록으로 형식을 바꾸고 핵심 아이디어는 유지했습니다. 이 버전을 다시 작업할 때 여분의 단어 8개를 다듬을 예정인데, 전체 서식을 직접 다시 지정하는 것보다 확실히 빠릅니다.

It still hasn’t counted accurately (this is 108 words), but it has reformatted to an unstructured abstract and retained the key ideas. I’ll trim the extra 8 words when I rework this version; that’s certainly faster than doing the whole reformat myself.

명확성과 일관성을 개선하기 위해 ChatGPT로 편집하기

Editing with ChatGPT to improve clarity and coherence

이 도구를 사용하는 또 다른 방법은 초안 섹션의 명확성과 일관성을 강화하는 것입니다. 특히 독자를 잃을 수 있다고 생각되는 밀집된 부분의 명확성과 일관성을 강화하는 것입니다. 내부 일관성을 강화하려면 한 단락을 입력하고 요점을 설명하기 위해 토큰 문장을 추가할 위치를 제안하는 등 아이디어가 더 설득력 있게 전개되도록 다시 작성해 달라고 요청할 수 있습니다. 저는 초안을 작성한 단락을 입력하고 세 가지 주제 문장을 제안해 달라고 요청했고, 이에 응답했습니다:

Another way to use the tool is to strengthen the clarity and coherence of sections of your draft, particularly those dense spots where you think you might lose the reader. To strengthen internal coherence, you could input a single paragraph and ask it to rewrite so that the ideas develop more convincingly, including suggesting where you should add token sentences to illustrate your points. I inputted a paragraph I’d drafted and asked it for three possible topic sentences, to which it responded:

각 주제 문장에서 서로 다른 강조점을 확인함으로써 단락에서 관심을 끌기 위해 경쟁하는 문제를 파악하고 더 일관성 있게 만드는 데 도움이 되었습니다.

Seeing the different emphases in each topic sentence helped me to identify the issues that were vying for attention in the paragraph, and make it more coherent.

| 인사이트: ChatGPT에 주제 문장을 요청하면 단락의 일관성 문제를 파악하는 데 도움이 될 수 있습니다. 주의: 이러한 문장을 그대로 사용하지 마세요. 이는 해결책이 아니라 신호일 뿐입니다. Insight: Asking ChatGPT for topic sentences can help reveal issues with paragraph coherence. Caution: Don’t use those sentences verbatim. They are a signal, not a solution. |

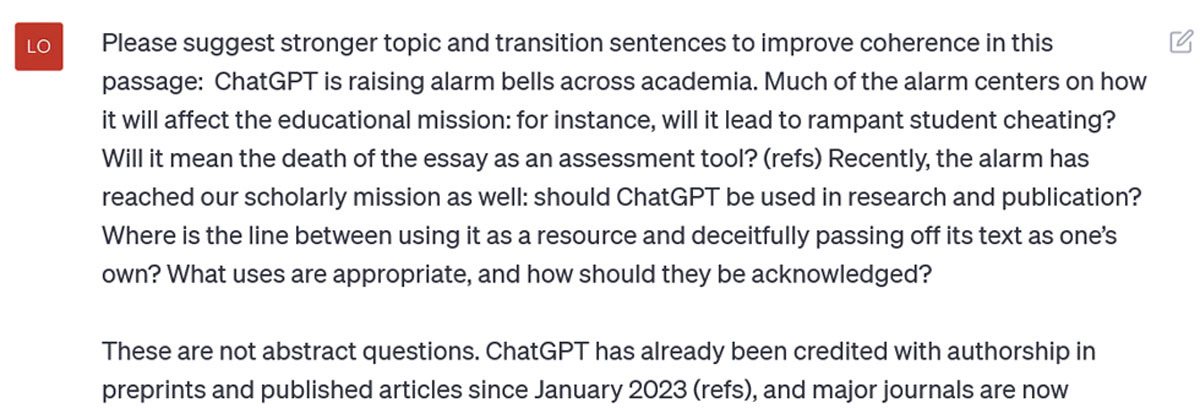

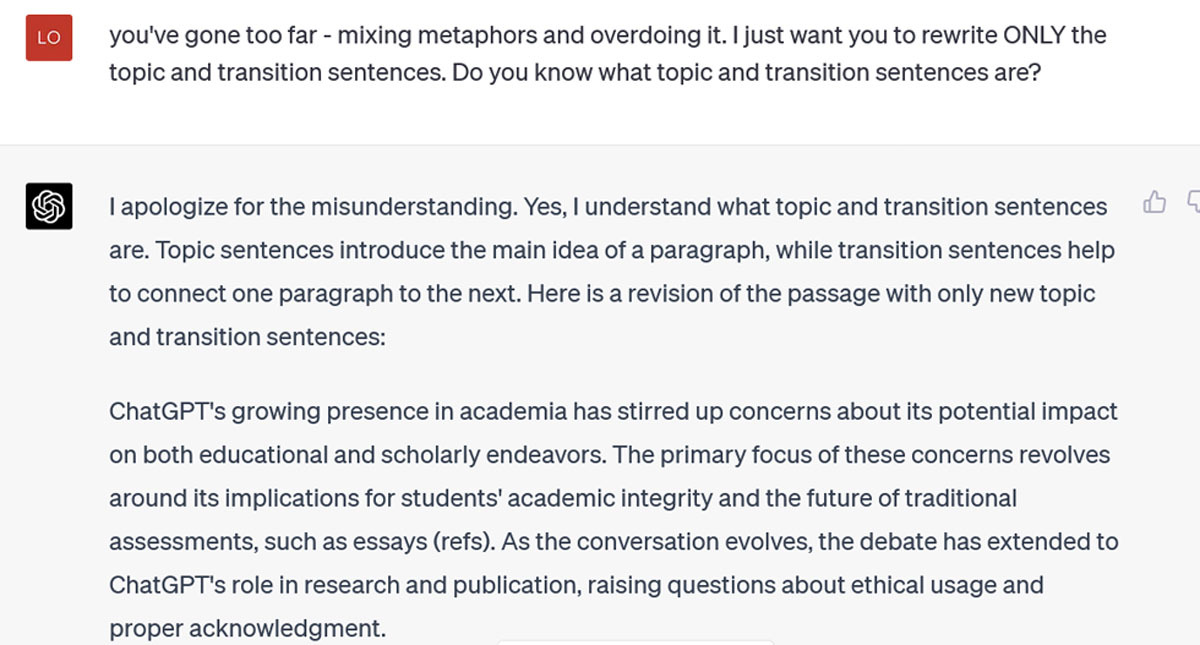

이론적으로는 일련의 단락을 입력하고 새로운 주제 및 전환 문장을 제안하도록 요청하여 ChatGPT로 외부 일관성을 강화할 수도 있습니다. 저는 이번 작가의 기술을 위해 초안을 작성했던 첫 문단에 대해 ChatGPT에 도움을 요청했습니다:

Theoretically, you can also strengthen external coherence with ChatGPT, by inputting a series of paragraphs and asking it to suggest new topic and transition sentences. I asked ChatGPT for help with the opening paragraphs I had drafted for this Writer’s Craft:

제안한 내용은 다음과 같습니다:

Here’s what it suggested:

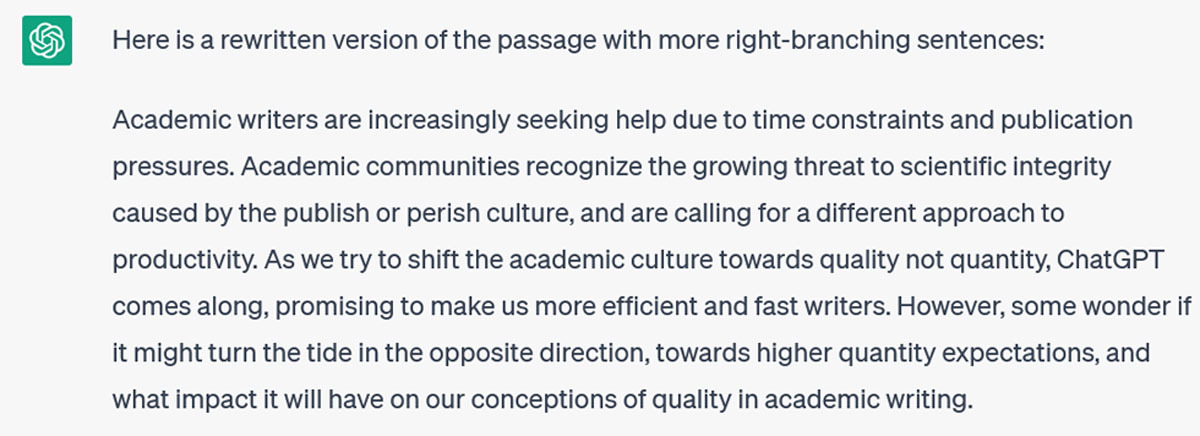

첫째, ChatGPT는 요청에 따라 주제와 전환 문장뿐만 아니라 모든 문장을 변경했습니다. 예를 들어, 수동태 구조(예: "촉발되었다", "점화되었다", "인정되었다")를 많이 사용하고, 단순한 주제를 좀 더 정교한 구조로 변경했습니다(예: "ChatGPT"가 "학계 내 ChatGPT의 영향력 증가"로 변경됨). 이제, 제가 제 글에 대해 약간 귀중하게 여길 수 있다는 것을 인정하는 첫 번째 사람이 되겠지만, 이것이 제가 부탁한 것은 아닙니다. 따라서 분명히 밝힙니다:

I noticed two things immediately: first, ChatGPT changed all the sentences, not only the topic and transition sentences as requested. And second, it also changed the writing style: for instance, it uses many passive voice constructions (e.g., “has sparked”, “has ignited”, “has been acknowledged”), and changed out my simple subjects for more elaborate constructions (e.g., my “ChatGPT” has been changed to “the rising influence of ChatGPT within academia”). Now, I will be the first to admit that I can be a bit precious about my writing, but this is not what I asked it to do. Thus, I clarify:

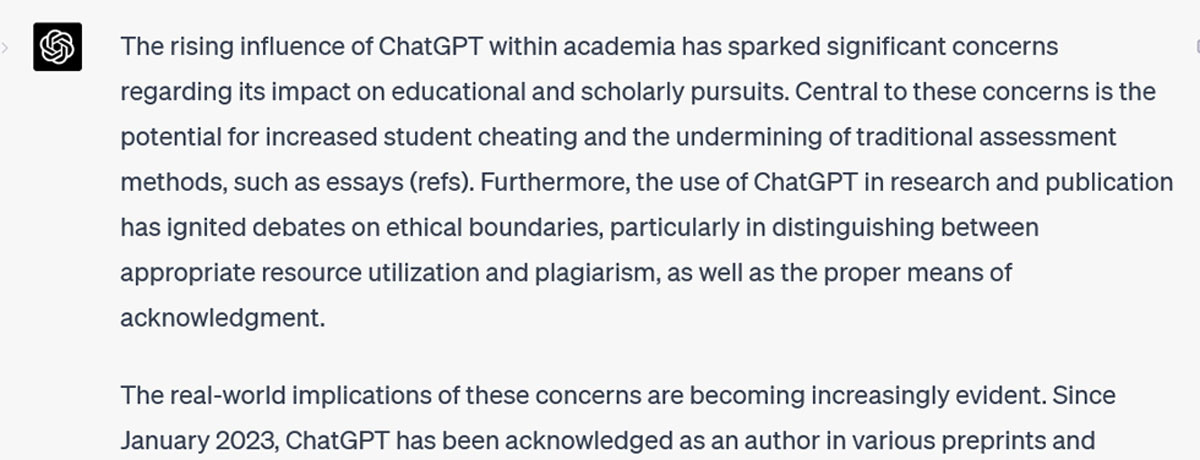

Ugh. 은유가 지나치게 섞여 있습니다! - 은유가 지나쳤습니다. 그리고 어조가 답답한 학자에서 발랄한 청소년으로 바뀌었습니다. 다음 프롬프트는 제 짜증을 드러냅니다:

Ugh. It has overdone – and mixed! – the metaphors. And the tone has swung from stuffy academic to effusive adolescent. My next prompt reveals my irritation:

이 글은 제 글쓰기 스타일에 더 가깝고, 주제와 전환 문장이 시작 논거를 연결하고 발전시키는 데 효과적입니다. 글의 내적 또는 외적 일관성을 유지하는 데 어려움을 겪고 있다면 이 자료가 도움이 될 수 있습니다. 그러나 일관성 문제로 어려움을 겪고 있지 않다면(이 글에서는 특별히 그렇지 않았습니다) 이 제안이 흥미롭지 않을 수 있으며, 일부 제안은 좌절감을 줄 수도 있습니다.

This is closer to my writing style, and the topic and transition sentences are effective at connecting and developing the opening argument. If you’re struggling with internal or external coherence in a piece of writing, this could be a helpful resource. But if you’re not struggling with coherence (as I wasn’t particularly in this piece), its suggestions are unlikely to excite you – and some of them may frustrate you.

| 주의: ChatGPT는 콘텐츠뿐만 아니라 글쓰기 스타일도 편집합니다. 인사이트: ChatGPT가 생성한 자료를 다시 작성할 때 스타일을 자신만의 것으로 만드세요. Caution: ChatGPT will edit your writing style as well as your content. Insight: As part of your rewrite of ChatGPT-generated material, make the style your own. |

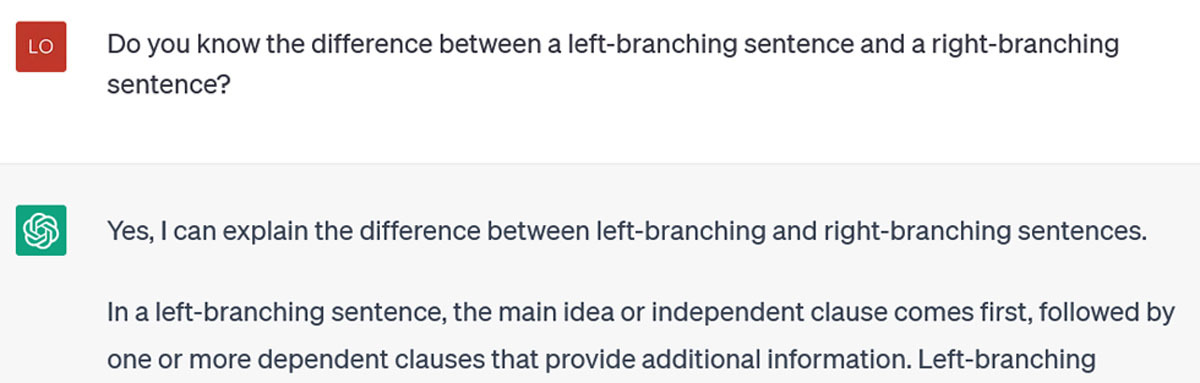

ChatGPT를 통해 글쓰기에서 어떤 부분을 개선하고 싶으시다면, 그 글의 특징 뒤에 있는 문법적/수사적/언어적 개념을 ChatGPT가 이해하고 있는지 확인해야 합니다. 무엇을 "알고 있는지" 물어보기 전까지는 알 수 없습니다. 저는 제 학생 중 한 명이 왼쪽 분기 문장(많은 세부 사항을 일찍 도입하고, 주요 아이디어를 나중으로 미루어 다른 모든 세부 사항을 정리하기 위해 주요 아이디어가 필요한 독자에게 혼란을 줄 수 있는 문장)을 작성하는 경향을 파악하고 개선하는 데 도움이 될 수 있는지 알아보고 싶었습니다. 저는 먼저 물어보았습니다:

Whatever you want ChatGPT to help improve in your writing, you need to ensure that it understands the grammatical/rhetorical/linguistic concepts behind that feature of your writing. You don’t know what it “knows” until you ask it. I wanted to see if it could help one of my students identify and improve their tendency to write left-branching sentences (those that introduce a lot of detail early, leaving the main idea until late and thus potentially creating confusion for the reader who needs the main idea to organize all the other details). I started by asking it:

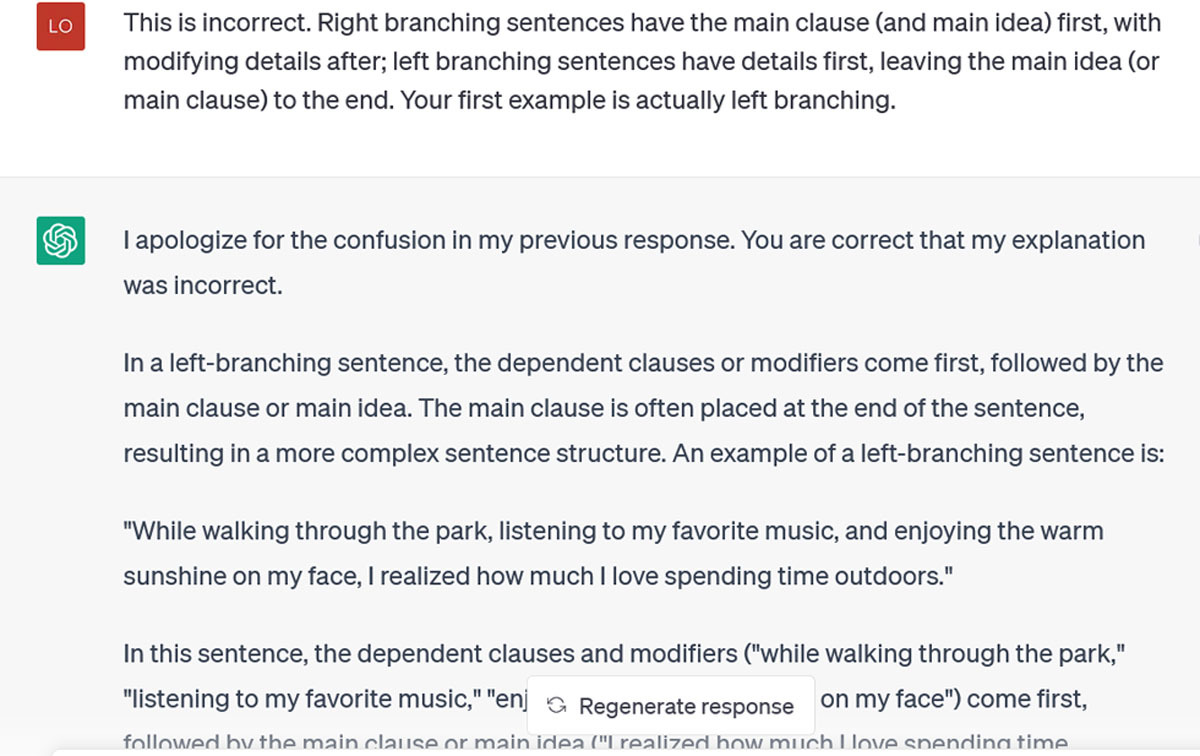

보시다시피, 거꾸로 되어 있었습니다. 제가 수정했습니다:

As you can see, it had them backwards. I corrected it:

생성된 모든 문장이 마음에 들지는 않지만 오른쪽으로 더 많이 분기됩니다. 작가의 습관을 파악하고 ChatGPT가 관심 있는 문법적 특징에 대한 정확한 지식을 갖추게 되면 유용한 코칭 리소스가 될 수 있습니다. 예를 들어, 많은 작가들이 강력한 동사의 레퍼토리를 확장하는 데 어려움을 겪고 있습니다. ChatGPT에 글의 몇 단락을 제공하고 더 강하고 역동적인 동사로 다시 작성하도록 요청할 수 있습니다. 몇 가지 다른 버전을 요청하면 갑자기 선택할 수있는 새로운 동사의 멋진 카탈로그가 생깁니다.

I don’t like all of the sentences it has created, but they are more right-branching. This would be a useful coaching resource, once a writer’s habits are identified and we have ensured that ChatGPT has accurate knowledge of the grammatical features we’re interested in. For instance, many writers struggle to expand their repertoire of strong verbs. We could give ChatGPT a few paragraphs of their writing and ask it to rewrite with stronger, more dynamic verbs. Ask it for a few different versions and suddenly you have a nice catalogue of new verbs to choose from.

더 일반적으로 ChatGPT는 영어를 추가 언어(EAL)로 쓰는 학자들을 위한 무료 언어 편집기 역할도 할 수 있습니다. 현재 많은 EAL 작가들이 언어 편집에 드는 비용(시간/노력 및 재정적 비용 모두)을 부담하고 있는데, 특히 초안 작성 및 수정 단계에서 이러한 비용을 일부 경감하고 작가들이 아이디어에 집중하고 문법에 대해 덜 걱정할 수 있게 해줄 수 있습니다.

More generally, ChatGPT could also serve as a free language editor for scholars writing in English as an additional language (EAL). Many EAL writers now incur the costs (both time/effort and financial) of language editing: it could alleviate some of those costs, particularly during the drafting and revision stages, and free writers to focus on the ideas and worry less about the grammar.

윤리에 대한 참고 사항

A note on ethics

ChatGPT에 대한 우려의 대부분은 사용의 윤리와 관련이 있습니다. 즉, 대신 글을 써주는 것이 '공정한가' 하는 것입니다. 이미 눈치채셨겠지만, 저는 이 도구가 여러분을 대신 작성하도록 하는 것을 권장하지 않습니다. 제 글의 대부분은 제가 직접 작성한 글을 ChatGPT에 입력한 후 제안을 요청하거나(여기 소개글이 있는데 좋은 제목을 제안해 주세요), 번거로운 작업을 하거나(여기 초록이 있는데 반으로 잘라 주세요), 문법적 변화를 설명하거나(여기 왼쪽 분기 문장 패턴이 있는데 오른쪽 분기 대안을 제안해 주세요) 하는 식으로 이루어집니다. 저는 이것이 윤리적이고 적절한 ChatGPT 사용이라고 주장하고 싶습니다. 저는 모든 지적이고 창의적인 작업을 ChatGPT에 요청하는 것이 아니라 일부 노동을 아웃소싱하는 것입니다[14]. 제가 ChatGPT에게 저를 위해 무언가(개요, 가능한 반론 목록, 더 강력한 주제와 전환 문장으로 개선된 구절 등)를 만들어 달라고 요청한 경우, 저는 이를 다음 수정 작업의 출발점으로 취급합니다. 물론 이것도 물론 중요하지만, ChatGPT의 글을 제 글인 것처럼 보이지 않기 위해서만이 아닙니다. 또한 (적어도 어떤 날은) 저에게 기쁨을 주는 글쓰기 기술을 아웃소싱하고 싶지 않기 때문이기도 합니다. 그리고 저는 확실히 ChatGPT처럼 '소리'를 내고 싶지 않고 제 글이 저처럼 들리기를 원합니다. 지금까지의 경험에 비추어 볼 때, ChatGPT가 저를 흉내 내도록 하는 것보다 제 목소리로 작업하는 것이 더 적은 시간이 걸리고 더 만족스러울 것입니다.

Much of the alarm about ChatGPT has to do with the ethics of its use: is it ‘fair’ to have it write for you? As you will have noticed, I don’t advise having it write for you. Most of my examples involve putting my own writing into ChatGPT and asking it to make suggestions (here’s my introduction, please suggest some good titles), to do some tiresome labor (here’s my abstract, please cut it in half), to illustrate grammatical changes (here’s my left branching sentence pattern, please suggest right branching alternatives). I would argue that these are ethical and appropriate uses of ChatGPT. I’m not asking it to do all the intellectual, creative work, I’m outsourcing some of the labor [14]. Where I have asked ChatGPT to create something for me (an outline, a list of possible counterarguments, a passage improved with stronger topic and transition sentences), I treat it as a starting point for my next round of revisions. This isn’t only to avoid presenting ChatGPT’s writing as my own, although that’s of course important. It is also because I don’t want to outsource the writing craft, which (on some days, at least) gives me joy. And I certainly don’t want to ‘sound’ like ChatGPT – I want my writing to sound like me. Based on my experiences so far, it will take less time (and be more satisfying) to work on my voice than to work on getting ChatGPT to mimic me.

요약하자면

In Summary

작가들은 놀라거나 불안해하기보다는 ChatGPT의 장단점을 이해할 필요가 있습니다.

- 내용보다는 구조에 더 강합니다. 좋은 브레인스토밍 도구(제목, 개요, 반론 등)이지만, 특히 자신의 전문 영역을 벗어나는 경우 모든 내용을 다시 한 번 확인해야 합니다.

- 복잡한 아이디어를 요약하고 다른 아이디어와 연결할 수 있지만, 일반적인 기본값에서 벗어나 관심사에 집중하도록 훈련시키는 데 필요한 점진적인 프롬프트에 대해 많은 생각을 한 경우에만 가능합니다.

- 정보에 대한 액세스 권한은 원래 훈련받은 정보로 제한되므로, 부족한 부분과 부정확한 부분을 파악하기 위해서는 사용자가 직접 훈련하는 단계가 필수적입니다.

- 초록의 형식을 바꾸거나 섹션의 길이를 줄이는 등의 노동에는 사용할 수 있지만, 어떤 단락이나 아이디어에 더 많은 단어가 필요한지, 어떤 단락이나 아이디어는 줄여야 하는지를 결정하는 작가의 사고를 대체할 수는 없습니다.

- 부정확할 수 있습니다. 사실, 고집스럽게도 부정확성을 지적받은 후에도 부정확성을 고집하면서 동시에 다음 시도를 수정된 것으로 제시합니다. 나는 그것이 지각이 없고 동기나 감정이 없다는 것을 알고 있지만, 일부 교환에서 그것이 음침하고 다루기 힘들고 심지어 고의적으로 성실하지 않다는 생각을 할 수밖에 없습니다.

Rather than being alarmed or anxious, writers need to understand ChatGPT’s strengths and weaknesses.

- It is better at structure than it is at content. It is a good brainstorming tool (think titles, outlines, counter-arguments), but you must double check everything it tells you, especially if you’re outside your domain of expertise.

- It can provide summaries of complex ideas, and connect them with other ideas, but only if you have put a lot of thought into the incremental prompting needed to shift it from its generic default and train it to focus on what you care about.

- Its access to information is limited to what it was originally trained on, therefore your own training phase is essential to identify gaps and inaccuracies.

- It can be used for labor, such as reformatting abstracts or reducing the length of sections, but it can’t replace the thinking a writer does to determine why some paragraphs or ideas deserve more words and others can be cut back.

- It can be inaccurate: in fact, rather stubbornly so, persisting with inaccuracies even after they are pointed out, while at the same time presenting its next attempt as corrected. I know it isn’t sentient and doesn’t have motivations or emotions, but I can’t help but think in some of our exchanges that it was being sullen, intractable, even deliberately insincere.

그럼에도 불구하고 작가들은 그 힘을 활용하여 프로세스를 더 효율적으로 만들고 제품을 더 견고하게 만들 수 있습니다. AI 도구를 사용한 글쓰기에 대한 정책이 계속 생겨나고 진화하고 있으므로 대상 저널을 확인하시기 바랍니다. 하지만 저널 매개변수 내에서 ChatGPT를 최대한 활용하세요. 글쓰기 과정에서 막히는 순간을 파악하세요. 개요를 생성하거나 스토리라인의 다음 요점을 브레인스토밍하는 등 ChatGPT가 도움이 될 수 있을까요?

- 문법 문제를 해결하는 데 사용하거나(예: 기본적으로 수동태를 사용하는 경우, 문장을 능동태로 변경하여 비교하도록 요청),

- 복잡한 논증 부분의 일관성을 강화하는 데 사용하거나,

- 오른쪽 분기 문장을 왼쪽 분기 문장으로 변환하여 명확성을 높이는 데 사용할 수 있습니다.

힘든 작업과 창의적인 글쓰기를 구분하세요.

- 전자는 ChatGPT를 사용하여 지원하고, 후자는 혼자서 하세요.

- 그리고 항상 생성된 초안을 초안으로 보고 자신만의 특별한 강조점, 고유한 목소리와 스타일을 불어넣어 다듬고 재작업할 수 있습니다.

Still, writers can harness its power to make our processes more efficient and our products more robust. Do check your target journal, as policies about writing with AI tools are emerging and evolving. Within journal parameters, however, leverage ChatGPT to your advantage. Identify the moments in your writing process where you get stuck: can ChatGPT help you there by generating an outline or brainstorming the next points in the storyline?

- Use it to help address your grammar challenges (e.g., if you default to passive voice, ask it to change sentences to active so you can compare);

- use it to strengthen coherence of a complex section of your argument;

- get it to increase clarity by converting your right-branching sentences to left-branching.

Distinguish the laborious from the creative writing tasks:

- use ChatGPT to support the former, and keep the latter for yourself.

- And always view what it has generated as a first draft which you will refine and rework, infusing it with your own particular emphases, your unique voice and style.

Writing with ChatGPT: An Illustration of its Capacity, Limitations & Implications for Academic Writers

PMID: 37397181

PMCID: PMC10312253

DOI: 10.5334/pme.1072

Free PMC article