대규모 의과대학 교육과정에서 프로그램 평가에 대한 학생들의 관점: 비판적 현실주의자 분석(Med Educ, 2022)

Student perspectives on programmatic assessment in a large medical programme: A critical realist analysis

Chris Roberts1 | Priya Khanna1 | Jane Bleasel1 | Stuart Lane1 | Annette Burgess1 | Kellie Charles1,2 | Rosa Howard1 | Deborah O'Mara1 | Inam Haq3 | Timothy Rutzou4

1 서론

1 INTRODUCTION

[총괄적 고부담 의사결정]을 통해 [학습의 평가]를 강조하는 전통적인 평가 시스템은 의과대학 졸업생이 급변하는 의료 시스템에 진입하는 데 필요한 복잡한 역량에 대한 정보가 충분하지 않다는 비판을 받아왔습니다.1-6 이에 대한 대안으로 프로그램 평가는 프로그램 수준 학습 결과의 달성 및 평가를 강화하기 위해 [정보가 풍부하고 시기 적절하며 지속 가능한 프로세스]를 제공합니다. 이는 아래 평가의 세 가지 주요 기능에 대한 설계 원칙을 제공합니다.7

- [학습 촉진(학습을 위한 평가)],

- [학생 진도에 대한 의사 결정 강화(학습에 대한 평가)],

- [교육과정과 평가 간의 연계성 보장] 등

Traditional assessment systems that emphasise the assessment of learning though summative high-stakes decision making have been critiqued for providing insufficient information about the complex competencies medical graduates require for entering rapidly changing health systems.1-6 As an alternative, programmatic assessment provides an information rich, timely and sustainable process for strengthening the attainment and assessment of programme-level learning outcomes. It provides design principles around three key functions of assessment:

- promoting learning (assessment for learning),

- enhancing decision making about student progression (assessment of learning) and

- quality assuring the linkage between curriculum and assessment.7

[프로그램 평가]는 [의도적으로 선택한 여러 평가]를 [일정 기간 동안 결합]하여 [다양한 역량 결과 영역]에서 학습자의 [진도에 대한 삼각형 정보의 종적 흐름]을 생성함으로써 [학습을 위한 평가]를 지원합니다.8 이러한 데이터 포인트를 수집하고 대조하는 것은 교수진이 [학생의 진도에 대한 집단적 의사 결정을 내릴 수 있는 근거]를 제공할 뿐만 아니라(학습에 대한 평가) 학습자에게 개별화된 피드백의 풍부한 소스를 제공합니다(학습을 위한 평가).7

Programmatic assessment supports assessment for learning by using purposefully selected multiple assessments combined over a period of time to create a longitudinal flow of triangulated information about a learner's progress in various competency outcome areas.8 Collecting and collating these data points not only provide a basis for collective decision making on student progress by faculty (assessment of learning) but provides a rich source of individualised feedback to learners (assessment for learning).7

[프로그램 평가의 기본 이론과 원칙]은 문헌에 자세히 설명되어 있습니다.7-11 그럼에도 불구하고 복잡하고 역동적이며 다단계 시스템을 포함하는 다양한 맥락에서 취하는 실행 접근법에 대한 이해는 제한적입니다.12, 13 [프로그램식 평가]가 [어떻게, 누구를 위해, 어떤 맥락에서 작동하는지]에 대한 이론적 근거에 기반한 설명으로 뒷받침되는 경험적 데이터를 제공하는지에 대한 연구]는 거의 없습니다.14-16 이러한 실용적 접근 방식은 [비판적 현실주의 및 현실주의 평가]에서 사용되며,17 일반적으로 ["무엇이 효과가 있는가?"]라고 묻는 전통적인 평가 연구 접근 방식과 대조됩니다.18 따라서 연구자가 프로그램 평가와 같은 복잡한 교육 개입의 영향을 고려할 때 적절한 질문을 할 수 있도록 적절한 연구 방법론을 추가로 개발할 필요가 있습니다.19 경험적 데이터가 없으면 교육자가 전통적으로 평가 경험이 지배적인 프로그램 평가 도입에 대해 정보에 근거한 결정을 내리는 것이 어렵습니다.

The underlying theory and principles of programmatic assessment have been described in detail in the literature.7-11 Notwithstanding, there is limited understanding of implementation approaches taken across different contexts that involve complex, dynamic and multilevel systems.12, 13 Few studies provide empirical data supported by theoretically informed explanations of how programmatic assessment is working, for whom and in what context?14-16 This pragmatic approach is used in critical realist and realist evaluation,17 contrasting with traditional approaches to assessment research that typically asks, “what works?”18 There is thus a need to further develop appropriate research methodologies to ensure researchers are asking the appropriate questions when considering the impact of a complex educational intervention such as programmatic assessment.19 Without empirical data, it is difficult for educators to make informed decisions about introducing programmatic assessment, where the prevailing experience of assessment is often traditionally based.

이 논문에서는 [비판적 현실주의(CR, 이하 CR) 이론 프레임워크]의 연구 결과가 프로그램 평가와 관련된 설계 및 구현 문제를 향후 반복에 최적화할 수 있는 방법에 대한 통찰력을 제공할 수 있다는 개념을 탐구함으로써 프로그램 평가에 대한 현재 연구를 확장합니다. 호주의 한 연구 집약적 대학에서 새로운 의학 대학원 커리큘럼의 첫해에 [학습을 위해 의도적으로 설계된 프로그램적 평가]가 시행되었을 때 이를 연구할 기회가 생겼습니다. 우리는 어떤 상황에서 어떤 프로그래밍 방식의 평가 요소가 학생들의 학습에 도움이 되는지, 왜 그렇게 생각하는지 탐구하고 싶었습니다. 이러한 맥락에서 연구 목표를 달성하기 위한 CR 접근 방식을 설명하기 위해, 우리는 연구 맥락에서 어떻게 작동하도록 의도되었는지에 대한 초기 이론을 강조하면서 전반적인 프로그램식 평가 설계를 설정했습니다. 그런 다음 이론에 기반한 방법론적 접근 방식을 설명하고 중요한 연구 목표와 연구 질문을 설정합니다.

In this paper, we extend current research on programmatic assessment by exploring the notion that findings from a critical realist (CR, hence forth) theoretical framework can provide insights into how design and implementation issues related to programmatic assessment can be optimised for future iterations. An opportunity to study this arose when a purposively designed programmatic assessment for and of learning was implemented in the first year of a new graduate medical curriculum at a research-intensive university in Australia. We wished to explore which elements of programmatic assessment seemed to be valuable for students' learning, under what circumstances, and why this was so. To explain our CR approach for meeting our research goals in this context, we set out our overall programmatic assessment design emphasising the initial theories of how it was intended to work in our research context. Then, we describe our theoretically driven methodological approach and set out our overarching study aims and research questions.

1.1 연구 맥락

1.1 Research context

2020년에 261명의 1학년 학생을 대상으로 하는 새로운 4년제 대학원 입학 MD 커리큘럼이 시작되었습니다. 이 커리큘럼에는 강화되고 다양한 임상 몰입도, 콘텐츠 전달에 대한 플립형 강의실 접근 방식, 커리큘럼 주제의 수평적 및 수직적 연계 등 이전 커리큘럼과 다른 몇 가지 변화가 포함되었습니다. [프로그램식 평가의 도입]은 여러 가지 형성 평가와 필기시험과 같은 주요 요약 평가, 임상 술기에 대한 객관적이고 구조화된 평가로 이루어진 기존의 평가 시스템에서 상당한 변화를 수반하는 복잡한 개입이었습니다. 이 프로그램 시스템은 [일련의 현지 워크숍]과 [네덜란드, 호주, 뉴질랜드의 주요 평가 전문가들과의 협의]를 통해 고안되었으며, [관련 문헌을 검토]했습니다. 그러나 코호트 규모, 이전 요약 평가 프레임워크에 대한 교수진의 경험, 현지 대학 평가 규정 및 요구 사항으로 인해 이론적 원칙을 상황에 맞게 실용적으로 조정할 필요가 있었습니다. 코로나19 팬데믹은 온라인 교수-학습 모드로의 전환이라는 측면에서 새로운 커리큘럼의 여러 측면을 구현하는 데 영향을 미쳤지만 커리큘럼 설계와 프로그램 평가를 뒷받침하는 프로그램 이론에는 큰 영향을 미치지 않았습니다.

A new 4-year graduate-entry MD curriculum commenced in 2020 for 261 Year 1 students. It involved several changes from the prior curriculum including enhanced and diverse clinical immersion, a flipped classroom approach to content delivery, and horizontal and vertical linkages of curricular themes. Introducing programmatic assessment was a complex intervention involving a significant shift from the previous system of assessment that was traditional in the sense of having several formative assessments and major summative assessments such as written tests and the objective structured assessments of clinical skills. The programmatic system was devised through a series of local workshops, consultations with leading assessment experts in the Netherlands, Australia and New Zealand, and was cognisant of the relevant literature. However, cohort size, faculty experience with previous summative assessment frameworks, and local university assessment regulations and requirements required several contextualised and pragmatic adaptations to the theoretical principles. The COVID-19 pandemic influenced the implementation of several aspects of the new curriculum in terms of a shift towards online teaching-learning modes but did not significantly impact the programme theories underpinning both the curriculum design and programmatic assessment.

1.2 시행된 프로그램 평가의 초기 프로그램 이론

1.2 Initial programme theories of implemented programmatic assessment

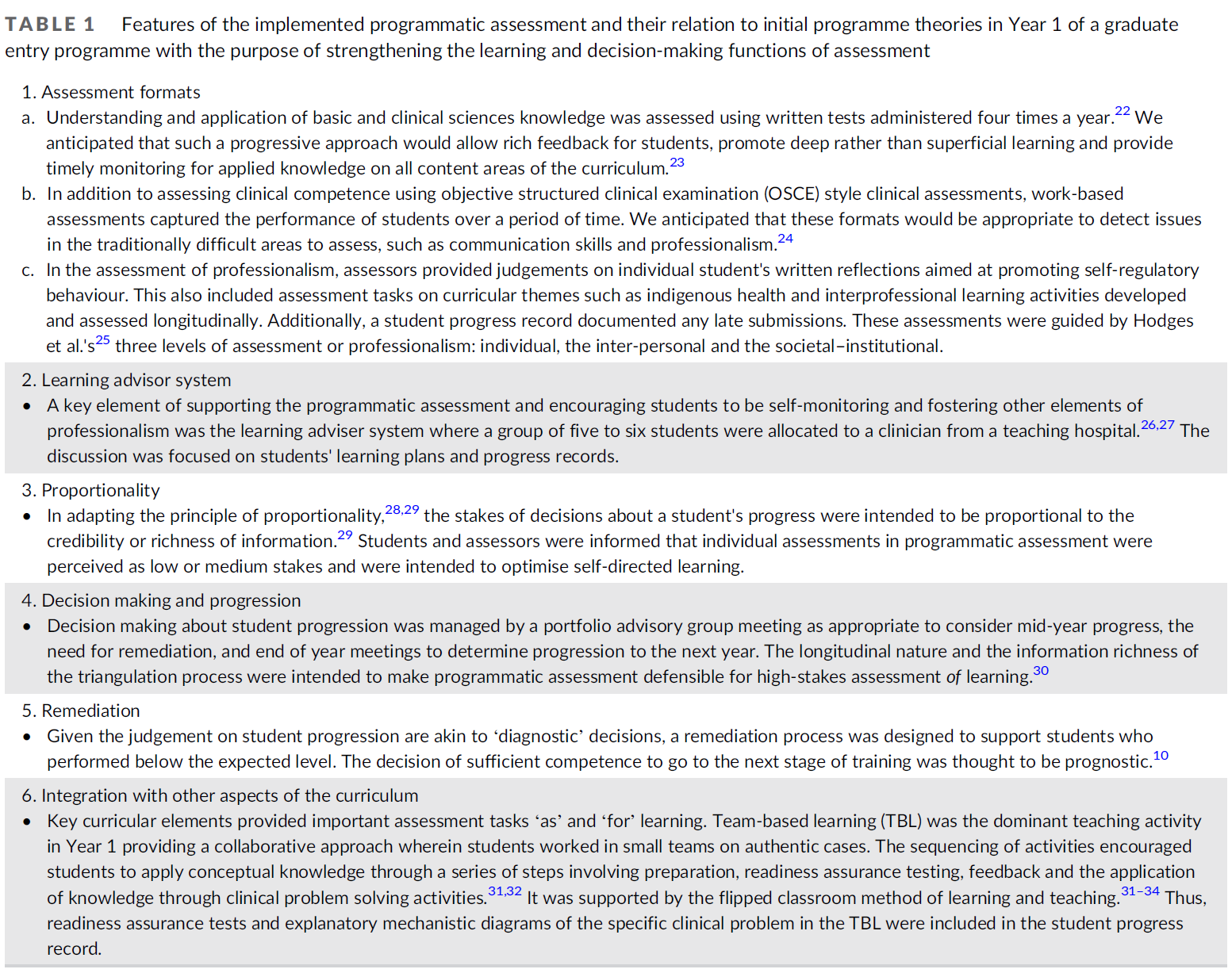

저희 버전의 프로그램적 평가는 [임상 역량에 대한 복잡성 일관된 관점]에 부합하도록 설계되었습니다. 전반적인 프로그램 설계에 대한 시스템 접근법을 고려할 때, 프로그램적 평가 접근법은 교육과정의 특징을 구성하는 몇 가지 필수 요소 중 하나를 제공했습니다.20 [프로그램적 평가]는 이전 평가 시스템의 학습 및 의사결정 기능을 모두 강화하기 위한 것이었습니다.8, 9 여기에는 다양한 신규 및 개정 평가 도구와 완성된 평가 제출에 대한 명확한 규칙 및 학생 행동에 대한 기대치를 가진 개선된 구조가 포함되었습니다. [평가 프로그램의 타당성에 대한 논거]는 전체 프로그램 내의 특정 목적에 따라 다양한 평가 도구를 신중하게 조합한 것에 근거했습니다.11 [공정성]은 모든 학습자가 동일한 수준의 평가를 받는다는 [형평성]의 관점에서 다루어졌습니다.21 학습자에 대한 정보는 맞춤형 e포트폴리오를 구성하는 학생 진도 기록(SPR) 내에서 [Collected(종단적)되고 Collated(삼각측량)]되었습니다. 이는 크게 [세 가지 요소], 즉 [기초 및 임상 과학 지식에 대한 학생의 이해, 임상 기술 역량, 전문성 관련 측면]으로 구성되었습니다. 평가 프로그램의 핵심 요소와 초기 프로그램 이론과의 관계에 대한 자세한 내용은 표 1에 나와 있습니다.

Our version of programmatic assessment was designed to align with complexity-consistent views of clinical competence. In considering a systems approach to overall programme design, a programmatic assessment approach provided one of several integral components that made up the features of the curriculum.20 The programmatic assessment was intended to strengthen both the learning and decision-making functions of the prior assessment system.8, 9 It included various new and revised assessment tools and improved structure with clear rules for submitting completed assessments and expectations of student behaviours. The argument for the validity of our programme of assessments was based on the carefully tailored combination of various assessment instruments depending on the specific purposes within the overall programme.11 Fairness was addressed from a perspective of equity, that is, all learners receiving the same quality of assessment.21 Information about learners was collected (longitudinally) and collated (triangulation) within a student progress record (SPR) that constituted a bespoke ePortfolio. This consisted of three broad elements: students' understanding of basic and clinical science knowledge, competence in clinical skills, and professionalism related aspects. The details of the key elements of the programme of assessment and their relation to the initial programme theory are given in Table 1.

1.3 CR 연구 프레임워크

1.3 CR research framework

프로그램식 평가를 [복잡한 사회 현상]으로 볼 때, 우리는 기본 설계, 프로그램식 평가의 맥락적 구현 및 학생 학습에 미치는 영향 사이의 복잡한 관계와 인과 메커니즘(작동 방식)을 풀고 이해하기 위해 [CR 관점]을 사용했습니다. 우리가 아는 한, CR은 의학 및 보건 과학 교육 내에서 [평가 시스템]을 고려하기 위해 경험적으로 적용된 적이 없습니다. 전통적인 [실증주의] 및 [해석주의] 입장에 더 익숙한 많은 보건 전문 교육자에게 CR은 비교적 새로운 패러다임일 수 있습니다. 세 가지 패러다임은 연구 현상의 실재가 어떻게 결정되는지에 대해 각각 뚜렷한 입장을 가지고 있습니다.35, 36

- [실증주의와 사회 구성주의]는 실재를 '평면적'이고 인간의 해석으로 환원된다고 가정하여 연구 현상에 대한 제한된 관점을 제시합니다.

- 반면에 [CR]은 [현실이 계층화]되어 있고 [인과적 효능(효과나 결과를 유발하는 능력)이 있다]고 가정하며 [귀납보다 더 광범위한 추론 기법]을 통해 이해할 수 있습니다.35

In viewing programmatic assessment as a complex social phenomenon, we used a CR stance to unpack and understand the complex relationships and causal mechanisms (ways of working) between the underlying design, the contextual implementation of programmatic assessment and their impacts on student learning. To the best of our knowledge, CR has not been applied empirically to consider assessment systems within medical and health science education. CR might be a relatively new paradigm for many health professional educators more familiar with traditional positivist and interpretivist positions. Each of the three paradigms has a distinct position as to how the reality of any research phenomenon is determined.35, 36

- Positivism and social constructivism assume reality to be ‘flat’ and reduced to human interpretation and thus offering limited perspectives of the research phenomena.

- CR, on the other hand, assumes reality to be stratified and causally efficacious (an ability to cause an effect or outcome) and can be understood through a broader range of inferential techniques than induction.35

본 연구의 연구 프레임워크는 CR 관점을 사용하여 두 가지 관점에서 도출된 프로그램 평가를 다루는 이전 연구18에서 형성되었습니다.

- 첫째, 현실을 세 가지 영역(경험적, 실제적, 실재적)으로 계층화하는 바스커의 이론(그림 1 참조)과

- 둘째, 아처의 구조 및 대리인 이론37

Our research framework in this study was shaped by our previous work,18 which used a CR perspective to address programmatic assessment derived from two perspectives:

- first, Bhasker's stratification of reality into three domains (the empirical, the actual and the real) (see Figure 1); and

- second, Archer's theory of structure and agency.37

바스카의 계층화 개념을 통해 학생의 프로그램 평가 경험을 형성하는 [현실의 세 가지 교차 영역]으로 분리할 수 있었습니다.36, 38, 39 그림 1 참조.

- 경험적(관찰 및 경험에서 수집한 데이터),

- 현실적(학생이 평가 프로그램 내에서 보고하는 사건 또는 비사건),

- 실재적(근본적인 인과 구조 및 메커니즘)

Bhaskar's concept of stratification allowed us to disentangle three intersecting domains of reality that shape the student experience of programmatic assessment:

- the empirical (data gathered from observations and experiences),

- the actual (events or non-events that students report within the assessment programme) and

- the real (underlying causal structures and mechanisms).36, 38, 39 See Figure 1.

임상 진단의 비유는 현실을 [세 가지 영역(경험적, 현실적, 실재적)으로 계층화]할 수 있는 방법을 설명하는 데 사용될 수 있습니다. 프로그램적 평가와 관련된 경험(즉, 개인 수준에서 기록된 실제 사건)은 환자가 의사에게 제시할 수 있는 증상 및 징후와 유사합니다.40

- [경험적 수준]은 측정 가능하고 평가 가능한 데이터를 제공하는 병력 및 검사와 유사한 개인(환자)의 경험을 포착합니다.

- [인과적 구조와 메커니즘]은 [실재적]이며, [현실적 수준]과 [경험적 수준] 모두에서 구별되고 잠재적으로 다르며, 환자의 근본적인 병리 및 진단과 유사합니다.

The analogy of clinical diagnosis can be used to illustrate how reality can be stratified into three domains (the empirical, the actual and the real). The experiences associated with programmatic assessment (i.e., actual events recorded at the individual level) are akin to the symptoms and signs that a patient might present to a doctor.40

- The empirical level captures the experiences of the person (patient) that are akin to a history and examination in providing measurable and assessable data.

- Causal structures and mechanisms are real, distinct and potentially different from both the actual and the empirical and are akin to the underlying pathology and diagnosis of the patient.

[아처의 CR 관점]을 통해 [평가 관행의 변화에 기여하고 영향을 미칠 수 있는 [구조, 문화, 행위자성] 간의 복잡한 인과적 상호 작용]을 탐구할 수 있었습니다.37 이 연구 맥락에서

- [구조]는 정책, 직위, 자원 및 관행을 설명하는 반면,

- [문화]는 평가 시스템과 관련된 의미, 신념, 규범 및 아이디어의 체계를 설명합니다.

시간이 지남에 따라 [구조]와 [문화]가 인간의 [행위자성]과 함께 복잡하게 상호작용하면41-43 필연적으로

- 아처가 '형태 형성'이라고 부르는 [주기적인 역동적 변화]가 발생하거나

- '형태 정체'44라고 부르는 [동일성 유지]가 발생합니다(그림 2 참조).

Archer's CR perspective allowed us to explore the complex causal interplays between structure, culture and agency that might contribute to and impact the transformation of assessment practices.37 In our research context,

- structure describes the policies, positions, resources and practices,

- whilst culture describes the system of meanings, beliefs, norms and ideas associated with systems of assessment.

The complex interplay over time between structure and culture, together with human agency,41-43 inevitably results in

- cyclical dynamic change referred to by Archer as ‘morphogenesis’, or

- staying the same, referred to as ‘morphostasis’44 (see Figure 2).

1.4 연구 목표 및 연구 질문

1.4 Study aims and research questions

이 연구의 목적은 [CR 관점]에서 [프로그램적 평가의 어떤 요소가 학습에 영향을 미치는지, 그리고 그 이유는 무엇인지]에 대한 학생들의 인식을 탐구하는 것이었습니다.

The purpose of this study was to explore from a CR perspective, students' perceptions of which elements of programmatic assessment influenced their learning and why.

- [새로운 평가 시스템의 특징feature]이 학생들의 학습 요구 사항을 지시하는 능력에 어느 정도 영향을 미쳤습니까?

- [평가 형식, 규칙 및 관행]을 탐색하는 데 있어 학생들의 경험은 어땠나요?

- 교수진 및 동료와 같은 새 커리큘럼 내의 [다양한 주체와의 상호 작용]이 학생들의 프로그램 참여에 어떤 영향을 미쳤습니까?

- [학생들의 인식과 경험에 대한 근본적인 설명]은 무엇이며 [프로그램 평가의 성장과 지속 가능성]에 어떤 영향을 미칠 수 있나요?

- To what extent did the features of the new assessment system influence students' ability to direct their learning needs?

- What were students' experiences in navigating assessment formats, rules and practices?

- How did the interactions with various entities within the new curriculum such as faculty and peers influence students' engagement with the programme?

- What were the underlying explanations of students' perceptions and experiences and how might they influence growth and sustainability of programmatic assessment?

이러한 질문은 실제로 무엇이 효과가 있는지, 어떻게 그리고 왜 효과가 있는지에 대한 풍부한 이론 기반 설명을 제공하여 평가 프로그램과 추가 반복에서 학생 경험을 최적화하는 데 중요하기 때문에 중요합니다.

These questions are important as they provide rich and theory-based explanations of what is really working, how and why it is working, to optimise the programme of assessment and the student experiences in further iterations.

2 방법

2 METHODS

2.1 연구 설계

2.1 Study design

우리는 비판적 현실주의에 기반한 질적 방법론을 사용하여 프로그램 평가의 다양한 측면에 대한 학생들의 인식에 미치는 영향을 탐구하여 연구 질문을 해결했습니다.

We addressed our research questions using a qualitative methodology drawing on critical realism to explore the influences on students' perceptions of various aspects of the programmatic assessment.

2.2 데이터 수집

2.2 Data collection

데이터는 프로그램 첫 해 동안 일주일에 하루씩 학생들이 근무하는 7개 교육 병원 중 6개 병원(병원당 15~52명 범위)의 10개 심층 포커스 그룹(총 n = 112/261, 학생 코호트의 43%)으로부터 수집했습니다. 코호트 인구 통계는 표 2에 나와 있습니다. 모집을 위해 학생들에게 연구에 대해 알리고 소속 임상학교에서 포커스 그룹에 참석하도록 초대했습니다. 초기 샘플링 전략은 적당히 이루어졌으며, 약 20명의 학생이 학습 도우미 시스템에 대해 보고할 수 있는 [충분한 정보력]45을 제공할 것으로 예상했습니다. 그러나 평가 변경에 대한 학생들의 의견을 듣고자 하는 학생들의 관심을 고려하여 추가 포커스 그룹을 마련했습니다.

Data were collected from 10 (labelled A–J) in-depth focus groups (total n = 112/261, 43% of student cohort) across six of the seven teaching hospitals in which students were based (in range 15–52 students per site) for 1 day a week during the first year of the programme. Cohort demographics are illustrated in the Table 2. For recruitment, students were made aware of the study and invited to attend a focus group at their home clinical school. The initial sampling strategy was modest and anticipated that around 20 students would have provided sufficient information power45 to report on the learning advisor system. However, additional focus groups were arranged to account for student interest in having their voices heard about the assessment changes.

동의를 받은 후 인터뷰는 각각 40분에서 60분 동안 진행되었으며 PK, CR, AB 및 SL이 진행했습니다. 초기 인터뷰 가이드는 문헌에서 얻은 통찰력, 사전 이론화18 및 저자들의 전년도 초기 학습 어드바이저 파일럿 평가 경험을 바탕으로 개발되었습니다. 인터뷰 일정에서 질문은 [학습 어드바이저가 평가로서, 또는 평가를 위해 학생의 학습을 지원하거나 도전하는 방식에 초점]을 맞춰 학생들의 [프로그램 평가 경험]을 이끌어내기 위해 고안되었습니다. 그러나 포커스 그룹을 진행하는 동안 학생들이 학습 조교 시스템뿐만 아니라 프로그램식 평가 시스템 전반에 대해 공유하고 싶은 중요한 통찰력을 가지고 있다는 것이 분명해졌습니다. 따라서 포커스 그룹은 학생들이 학생 역량에 대한 판단, 학습 활동과 평가의 적합성 등 프로그램식 평가 시스템에 대한 인식을 자세히 설명할 수 있는 [대화 형식]으로 진행되었습니다. 오디오 테이프는 비식별화되고 그대로 전사되어 대학 데이터 보호 시설에 보관되었습니다.

Having been consented, interviews lasted from 40 to 60 min each and were conducted by PK, CR, AB and SL. An initial interview guide was developed from insights from the literature, prior theorising18 and the authors' experience of an initial learning advisor pilot evaluation in the previous year. In the interview schedule, questions were designed to elicit students' experiences of programmatic assessment focussing on the ways in which learning advisors supported or challenged student learning as and for assessment. However, during focus groups, it became clear that students had significant insights they wished to share on not just the learning advisor system but with the programmatic assessment system as a whole. Accordingly, focus groups were conducted as a conversation allowing students to elaborate on their perceptions of the programmatic assessment system including judgements of student competence and the fit of assessment with learning activities. Audiotapes were deidentified, transcribed verbatim and stored on the university data protection facility.

2.3 데이터 분석

2.3 Data analysis

우리는 프로그래밍 방식의 평가에 대한 [학생의 경험을 형성하는 근본적인 인과 메커니즘]을 밝히고자 했습니다. CR 프레임워크에 따라 데이터 분석 및 종합은 [선형적이기보다는 동적]으로 이루어졌으며, [반복적으로 수행되는 세 단계의 추론]이 포함되었습니다. 전체 데이터에 대한 이해를 보장하기 위해 연구자 간 관점의 차이는 회의(대면, 화상 회의 및 이메일)와 연구 자료의 화이트보드를 통해 조정되었습니다. 데이터는 질적 데이터 분석 프로그램 NVivo(버전 12)(QSR International Pty Ltd. 2020)를 사용하여 관리되었습니다.

We wished to unpack the underlying causal mechanisms that shaped the student experience of programmatic assessment. In line with the CR framework, data analysis and synthesis were dynamic rather than linear and involved three phases of inference undertaken iteratively. To ensure understandings applied to the full data, differences in researcher perspectives were negotiated through meetings (face to face, video conference and email) and using whiteboarding of the research materials. Data were managed using the qualitative data analysis program NVivo (Version 12), (QSR International Pty Ltd. 2020).

2.3.1 1단계: 귀납법

2.3.1 Phase 1: Induction

반복적 귀납적 분석의 초기 초점은 [특정 이론에 얽매이지 않고 코호트의 프로그램 평가 경험과 관련 커리큘럼 요소를 풀고 설명]하는 데 있었습니다.35 우리(CR, PK, TR)는 원시 데이터를 검토하여 일반적이고 새로운 패턴, 연결성, 유사성 및 차이를 반복적으로 식별했습니다. 이 시점에서 우리는 [학생들의 학습 및 평가 경험의 기저에 있는 것으로 보이는 종종 상충되는 원인을 이해하는 데 있어 귀납법의 내적 한계]를 발견했습니다.35

The initial focus of our iterative inductive analysis was around unpacking and describing the cohorts' experience of programmatic assessment and its related curricular elements, without being tied to a specific theory.35 We (CR, PK and TR) reviewed the raw data to iteratively identity general and emergent patterns, connections, similarities and variances. At this point, we noticed the internal limitations of induction in understanding the often conflicting causes that appeared to underlie the students learning and assessment experiences.35

2.3.2 2단계: 가추법

2.3.2 Phase 2: Abduction

[가추법]은 [초기 패턴 인식]을 넘어 [데이터에서 연관성을 형성]하여 [새로운 패턴을 보다 포괄적으로 이해하는 수단]을 제공했습니다.35, 46 우리의 방법을 설명하기 위해 가추법은 특정 맥락(예: 교육 활동으로서의 팀 기반 학습[TBL])에서 이해되었을 수 있는 개념을 [재기술 또는 재맥락화를 통해 프로그래밍 평가(학습을 위한 평가로서의 TBL)의 새로운 맥락에 연결]했습니다. 데이터의 [초기 귀납적 코딩]은 가추를 통해 [재검토 및 재코딩]된 다음, [실제적이고 경험적이며 잠재적인 '실제 메커니즘'으로서 현실]의 [계층화된 영역]에 대한 [CR 기반 개념 맵]으로 [재구성 및 재맥락화]되었습니다.

- 데이터는 관찰 여부에 관계없이 학생들이 보고한 ['현실적'(임상 증상과 유사)40로 코딩]되었다. 여기에는 학생들이 일상적인 [평가 활동을 인식하는 방식, 성취도, 그리고 그 활동으로 인해 느낀 감정] 등이 포함되었습니다.

- '경험적'(임상 검사 및 조사와 유사) 코딩에는 [새로운 평가 시스템의 다양한 측면]에 대한 학생들의 관찰, 인식 및 반성이 포함되었습니다.

- 이 단계에서 '실재적'(감별 진단과 유사)은 현실적 및 경험적 평가가 왜, 어떻게 이루어졌는지를 설명하는 잠재적 메커니즘으로만 코딩할 수 있었지만, 핵심 메커니즘은 코딩할 수 없었습니다.

Abduction provided a means of forming associations in the data that went beyond initial pattern recognition to give a more comprehensive understanding of the emergent patterns.35, 46 To illustrate our method, abduction linked concepts that might have been understood within a particular context (e.g., team-based learning [TBL] as a teaching activity) to the new context of programmatic assessment (TBL as an assessment for learning) through redescription or recontextualization. The initial inductive coding of the data was re-examined and recoded through abduction and then reorganised and recontextualised into a CR-based conceptual map of stratified domains of reality as actual, empirical and potential ‘real mechanisms’.

- Data coded as ‘actual’ (akin to clinical symptoms)40 reported by the students whether observed or not. This included the way students perceived everyday assessment activities, their achievements and how it made them feel.

- The coding for the ‘empirical’ (akin to clinical examination and investigations) included students' observations, perceptions and reflections of various aspects of the new assessment system.

- At this stage, the ‘real’ (akin to a differential diagnosis) could only be coded as potential mechanisms that explain why and how the actual and empirical came to be, but not which were the key mechanisms.

2.3.3 3단계: 역행추론법

2.3.3 Phase 3: Retroduction

CR 방법론의 핵심 구성 요소인 [역행추론]은 [현실적 또는 경험적 수준만으로는 설명할 수 없는 기본 조건, 구조 및 메커니즘을 풀기 위해 데이터의 인과적 설명]을 포함합니다.35 우리는 문화, 구조 및 기관 간의 상호 작용에 대한 Archer의 이론에 비추어 수렴 및 상충하는 잠재적 ['실재' 메커니즘]을 모두 다시 코딩했습니다.37, 41 (그림 2) 세 가지 추론 모드를 사용하여 프로그램 평가 실행의 맥락과 기본 프로그램 이론을 고려하여 결과에 대한 진화하는 설명은 [현실적, 경험적, 실재적 사이를 이동]했습니다.46, 47

Retroduction, a key component of CR methodology, involves causal explanation of the data to unpack the basic conditions, structures and mechanisms that cannot be explained at the actual or empirical levels alone.35 We re-coded both the converging and conflicting potential ‘real’ mechanisms in the light of Archer's theory of the interplay between culture, structure and agency.37, 41 (Figure 2) Using the three modes of inferences, the evolving explanation of findings moved between the actual, the empirical and the real, taking account of the context of our implementation of programmatic assessment and the underlying programme theories.46, 47

2.4 팀 반사성

2.4 Team reflexivity

우리 팀은 다학제적이고 경험이 풍부한 연구자, 임상의, 임상 과학자들로 구성되었으며, 이들은 프로그램 평가를 만들고 실행하는 데 공동으로 그리고 직접적으로 참여했습니다. 프로그램에 참여하지 않은 사회과학자가 데이터에 대한 다양한 통찰력을 제공함으로써 이 연구의 의미를 구성하는 데 도움을 주었습니다48. 저자 중 일부는 연구 전에 비판적 현실주의에 대해 잘 알고 있었습니다. 반성적 현실주의는 회의와 이메일을 통한 내부 대화 공유를 통해 촉진되었으며, 이를 통해 개인이 평가 관행 변화에 대한 데이터의 내용에 대한 우려를 해결하고 우선순위를 정하는 반성적 숙고를 거쳤습니다.37

Our team comprised multidisciplinary and experienced researchers, clinicians and clinical scientists, who were collectively and directly involved in creating and implementing the programmatic assessment. A social scientist, not involved in the programme, helped construct meanings in this research48 by providing differing insights into the data. Some of the authors were familiar with critical realism prior to the study. Reflexivity was promoted through meetings and via email sharing our internal conversations, the reflexive deliberations through which the individuals address and prioritise their concerns about what the data said about changing assessment practice.37

3 결과

3 RESULTS

연구 결과는 두 부분으로 나누어 제시합니다:

- 첫째, 첫 번째 세 가지 연구 질문을 다루는 귀납과 가추를 사용한 '경험적인 것과 현실적인 것'에 대한 설명

- 둘째, 네 번째 연구 질문을 다루는 가추와 역행추론을 사용하여 학생들을 위한 프로그램 평가의 '실재'를 풀어낸 설명입니다.

We present our findings in two parts:

- First, an account of the ‘empirical and actual’ using induction and abduction that addresses the first three research questions;

- second, an account of the unpacking of the ‘reality’ of programmatic assessment for the students using abduction and retroduction that addresses our fourth research question.

3.1 1부: '경험적이고 현실적인' 수준

3.1 Part 1: The ‘empirical and actual’

경험적이고 현실적인 실재의 수준에는 다음과 관련하여 학생들이 경험한 실제 사건에 대한 학생들의 개인적인 경험과 해석이 포함됩니다.

- 첫째, 학습 및 교수 활동 또는 다양한 평가와 같은 커리큘럼 구성 요소; 그리고

- 둘째, 프로그램 요구 사항과 관련된 의사소통, 신념 및 규범에 대한 회상에 반영된 학습 환경의 문화에 대한 인식.

The empirical and actual levels of reality included students' personal experience and interpretations of actual events they experienced in relation to

- first, their curricular components such as learning and teaching activities, or various assessments; and

- second, their perceptions of the culture of the learning environment, as reflected in their recall of communication, beliefs and norms in regard to programme requirements.

연구 질문을 고려하여 학생들의 프로그램 평가 경험과 관련하여 다음의 세 가지 주제를 개발했습니다.

- (1) 학습 선택권 부여(주체성),

- (2) 평가 시스템 탐색(구조),

- (3) 문화 시스템 구축

Considering our research questions, we developed three themes in relation to student experiences of programmatic assessment:

- (1) enacting learning choices (agency),

- (2) navigating the assessment system (structure) and

- (3) building a cultural system.

RQ 1: 새 평가 시스템의 기능이 학생의 [학습 요구 사항을 지시하는 능력]에 [어느 정도 영향]을 미쳤습니까?

RQ 1:To what extent did the features of the new assessment system influence students' ability to direct their learning needs?

3.1.1 학습 선택권 부여(주체)

3.1.1 Enacting learning choices (agency)

이 주제에서는 학생이 학습에서 [어떤 선택을 어떻게 할 수 있는지]에 대한 관점에서 [구조(행동을 가능하게 하거나 제약할 수 있는 평가 규칙, 관행 및 자원)와 주체성 간의 상호작용을 매개하는 요인]에 대해 설명합니다. ['선택']이란 학생이 자신의 학습 요구를 파악하고 그에 따라 학습을 주도할 수 있는 [인지된 자유의 정도]를 의미합니다.

This theme describes the factors that mediate the interplay between structure (the assessment rules, practices and resources that may enable or constrain action) and agency from the perspective of how and what choices students have in their learning. By ‘choices’, we mean the perceived degree of freedom that allowed students to identify their learning needs and direct their learning accordingly.

학생들은 의료 프로그램 내에서, 특히 프로그램 평가에서 다양한 영향을 받았으며, 이는 학생들이 무엇을 언제 어떻게 학습할지 선택할 수 있는 구조가 어느 정도인지에 영향을 미쳤다고 보고했습니다. 예를 들어, 학습 지도교수 시스템 내에서 학생의 주체성은 [교수진과의 오랜 관계]를 통해 표현되었으며, 학생에서 의사가 되기까지의 [전문성 개발 여정에서 전문적인 대화]가 건설적인 영향을 미쳤습니다. 대부분의 학생들은 [학습 어드바이저 제도]를 통해 학습의 강점과 약점을 분석하고 약점을 보완하기 위한 개인 학습 계획을 세움으로써 자기 효능감과 자기 조절력을 키울 수 있었습니다.

Students reported various influences within the medical programme, and the programmatic assessment specifically, that shaped the degree to which the structures in place gave them choice in what and how they learned and by when. For example, student agency within the learning adviser system was expressed through having a long-standing relation with teaching faculty, in which a professional conversation was a constructive influence on their professional development journey from being a student and becoming a doctor. For most students, the learning advisor system supported their own self-efficacy and self-regulation through analysing their strengths and weakness in their learning and devising a personal learning plan to work on those weaknesses.

저는 (개발) 계획을 세우는 것이 정말 마음에 들었습니다. 어떤 이야기를 하고 싶은지 설정할 수 있기 때문입니다. 그리고 마지막에 행동 계획을 세우고 회의에서 논의한 내용을 바탕으로 계획을 업데이트하는 것도 좋았는데, 회의가 끝난 후 스스로 행동 계획을 세우도록 강제하기 때문입니다. (C2)

I definitely liked having the idea of having the (development) plan going in, because it sets up what you want to talk about. And then I also liked having the actions at the end, and then having the update to the plan based on what you discussed in the meeting, because it really forced you to set actions for yourself after the meeting. (C2)

그러나 일부 학생의 경우 현재 형태의 [학습 어드바이저 구성 요소]는 프로그램 요구 사항의 일부로 완료해야 하는 [또 다른 평가로 인식]되었습니다. 따라서 "따라잡기, 확인, 몇 가지 질문"(C)을 위한 추가 미팅을 부과하는 것은 학습을 지원하기보다는 학습 어드바이저 프로세스에 대한 참여를 증명하기 위한 것입니다. 때때로 학생들은 [필수 출석 규칙]이 [전문성을 나타내는 지표라는 인식]과 같이, 평가 시스템의 [특정 구조가 학습을 지원하기보다는 학습에 불리하게 작용한다]고 인식했습니다.

However, for some students, the learning advisor component, in its current form, was perceived as another assessment to complete as part of programme requirements. Thus, imposing an additional meeting to “catch-up, check in, ask a few questions” (C) to evidence their engagement with the learning advisor process, rather than supporting their learning. At times, students perceived that certain structures of the assessment system worked against their learning rather than supporting it, such as a perception that mandatory attendance rules were a marker of professionalism.

출석을 강제하는 것이 아니라, 예를 들어 연초에 사람들이 QR(빠른 응답) 코드를 제대로 하고 있는지, 심지어 Zoom(화상 회의 소프트웨어)을 제대로 사용하고 있는지 믿지 못해서 무작위로 들어와서 누가 있는지 수작업으로 확인하는 것과 같은 답답한 일이 있었습니다. (H)

I find it frustrating not that they are forced to meet attendance, it's like, for example, at the start of the year, they came in and randomly did a manual check of who was in there because they did not trust that people were doing the QR (Quick Response) code properly or even in our Zooms (video conferencing software) at the start. (H)

학생들은 [완료된 평가가 학습 관리 시스템에 업로드되는 과정]과 [개인 및 팀 평가에 대한 피드백을 받는 데 지연]이 발생하는 등 [리소스 문제]로 인해 영향을 받는다고 생각하는 평가 시스템의 요소에 대해 이야기했습니다.

Students talked about elements of the assessment system, which they thought were impacted by resource issues, for example, the process by which completed assessments were uploaded in the learning management system and the delays they perceived in getting feedback on individual and team assessments.

이러한 마감일을 지키지 못하는 이유는 아마도 업무가 과중하고 인력이 부족하며 새로운 과정을 시작하면 더 많은 지원이 필요하기 때문일 것입니다. 우리가 들은 바에 따르면 이런 일이 발생했습니다. 그리고 그것은 우리의 학습에 영향을 미쳤습니다. 그것은 우리에게 영향을 미쳤고, 우리가 받고 있는 교육의 질에 확실히 변화를 가져왔습니다(J).

The reasons that they are not meeting these deadlines is probably because they are overworked, and understaffed, and starting a new course you need more support, not less. Which is kind of through the grapevine what we have heard has happened. And it has affected our learning. It has impacted on us, and it has definitely changed the quality of the education we are getting (J)

그럼에도 불구하고, 프로그램 평가 시스템은 [시간이 지남에 따라 발전할 가능성]이 있는 것으로 인식되었으며, 예를 들어 [학습 지도교수가 의학 프로그램을 통해 학생의 여정에서 멘토가 되는 개념]을 발전시켰습니다.

Notwithstanding, the programmatic assessment system was recognised as having the potential to develop over time, for example, developing the notion of a learning advisor being a mentor on the student journey through the medical programme.

저는 학습 지도교수를 커리큘럼 자체뿐만 아니라 일종의 커리어 코치로서도 활용합니다. 저는 이전에 다른 직종에서 일한 경험이 있고, 회사에서도 학생의 진로에 대해 멘토링을 해주고 적절한 리소스를 연결해줄 수 있는 커리어 코치를 원했기 때문에 학습 어드바이저의 역할이 매우 중요하다고 생각합니다. 하지만 그것은 학생들이 그런 종류의 도움을 요청할 수 있는 힘이 있다고 느낄 때만 가능합니다. (A)

I use my learning advisor not just for the curriculum itself, but also as a bit of career coach. So, I think there's a lot of value to be had there, and I did that because I come from a different profession previously, and my firm was quite keen on having a career coach that will suit – mentor you on the way, and connect you with the right resources, if you ask for it. But that's only possible when the students feel empowered to reach out for that kind of help. (A)

요약하면, 학생들은 자신의 행위자성을 주로 다음의 세 가지와 관련해서 이해했다.

- 첫째, [학습 과정을 진행하는 데 도움이 된다고 느낀 학습 연습]을 통해 스스로 동기를 부여하고 자기 조절을 할 때,

- 둘째, 학습 조언자인 임상의와의 전문적인 대화를 통해,

- 셋째, 개인 또는 팀 평가에 대한 건설적이고 개별적인 피드백

학습자 에이전시는 다음으로 인해 어느 정도 제약을 받았습니다.

- IT 시스템 탐색,

- 교수진과의 부정적인 커뮤니케이션 경험,

- 의도한 프로그램을 제공하기 위한 리소스 부족

In summary, students made most sense of their agency related to three factors:

- first, their own motivations and self-regulation from having a study practice that they felt helped them in progressing through the course;

- second, with professional conversations with clinicians as learning advisors;

- third, from constructive and individual feedback around individual or team assessments.

Learner agency, to some extent, was constrained by

- navigating the IT systems,

- negative communication experiences with faculty and

- a perceived lack of resources to deliver the intended programme.

RQ 2: 학생들이 [평가 형식, 규칙 및 관행을 탐색]하는 데 있어 어떤 [경험]이 있었습니까?

RQ 2:What were students' experiences in navigating assessment formats, rules and practices?

3.1.2 평가 구조 탐색하기

3.1.2 Navigating assessment structures

이 주제에서는 프로그램 평가에 대한 [학생의 기대, 교수진의 의도된 구현 및 프로그램의 교육기관 제공 간의 역동적인 상호 작용]에 대해 설명합니다. 프로그램 기능의 중요한 구조는 학생 진도 보고서 내에서 완료된 평가 과제 모음에 대한 판단 및 의사 결정 과정, 특히 수정 과정 및 전문성 관련 문제에 대한 의견에서 발견되었습니다. 학생들은 의견을 표현할 때 기존의 평가 시스템에 대한 사전 적응으로 인해 [프로그램 평가에 대해 잘못된 오해]를 하는 모습을 보였습니다.

This theme describes the dynamic interplay between student expectations of the programmatic assessment, the faculty's intended implementation and the institutional delivery of the programme. Critical structures of programme functioning were found in their comments about the judgement and decision-making process on the completed collection of assessment tasks within the student progress report, especially the remediation process, and the professionalism-related issues. In expressing their opinions, students showed fallible misunderstandings about the programmatic assessment, shaped by their prior conditioning to traditional assessment systems.

예를 들어, '형성적'과 '총괄적'이라는 용어의 이해, '부담stake'의 해석, [학습을 위한 평가]와 [학습에 대한 평가] 등 프로그램식 평가에 대한 이야기를 둘러싸고 학습자와 교수자 모두 많은 긴장을 느꼈습니다.

There were a number of tensions in both learners and faculty around the narratives about programmatic assessment, for example, what was understood by the terms ‘formative’ and ‘summative’; interpretation of ‘stakes’; and assessment for and of learning.

형성 평가와 총괄 평가의 차이, 그리고 이 과정에서는 모든 것이 총괄 평가가 될 때까지 형성 평가라는 점은 이해합니다. 문제는 그것이 언제인지 말하지 않기 때문에 일년 내내 지나갔는지 알기 위해 사소한 일에 땀을 흘릴 수 있다는 것입니다. (G)

I get it; the difference between formative and summative, and that everything is formative in this course until it is summative. Problem is they do not say when that is so you could be sweating on a minor thing to know if you have passed the whole year. (G)

[부담 또는 가중치]는 [학생의 진급에 대한 교수진의 결정]이 [정보의 신뢰성에 비례하는 정도]를 나타냅니다. 학습자의 불완전하고 종종 오류가 있는 평가에 대한 인식 사이에서 특정 평가의 지분이 SPR에 포함된 다른 평가와 비교되는 것에 대해 많은 불확실성이 있었습니다.

The stakes or weightage describes the degree to which faculty decisions about student's progress are proportional to the credibility of information. There was much uncertainty amongst learners' incomplete and often fallible perceptions of assessment as to what the stakes of a particular assessment were compared with other assessments included in the SPR.

연초에 그들은 모든 평가의 가중치가 같거나 다른 평가보다 더 가중치가 높은 평가는 없다는 식의 말을 했습니다. 그래서 그 라인에서 그들은 적어도 그들이 진실하다고 생각하는 것을 얻으려고 노력하고 있다고 생각합니다. 그들은 우리에게 다른 가중치가 있음을 알려주지 않았습니다. 하지만 그것이 사실인지 아닌지는 모르겠습니다. 실제로는 [필기 시험]이 해부학 [실습 시험]보다 가중치가 더 높나요? (C)

I would say at the beginning of the year they did say everything is—they said something along the lines of everything is of equal weight, or nothing is weighted more than the other. So, I guess in that line, they are trying to get the—which I think they have at least held true to, they have not let us know anything is weighted differently. But if that's true or not, I do not know. Behind the scenes, is the [written test] weighted more than an Anatomy Spot Test? (C)

프로그램 평가의 개별 요소 중 대부분의 학생들은 [연속된 필기 시험]이 "우리를 평가하는 공정한 방법이었다"(J), "장벽이 있는 것보다 스트레스가 덜했다"(F)고 느꼈습니다. [점진적 평가]는 프로그램 첫해의 진행 상황을 알려주었고 학습에 도움이 되는 것 같았습니다.

Of the individual elements of the programmatic assessment, most students felt the continuous testing in the written assessments seemed to “have been a fair way to assess us” (J), as well as “less stressful than having a barrier” (F). The progressive assessments provided an indication of where they were in terms of progress in the first year of the programme and seemed to be supportive to their learning.

[작업 기반 평가]에서 코로나19는 [관찰 및 피드백을 위한 작업장의 어포던스에 영향]을 미쳤지만, 전반적으로 의도한 대로 작동하였고, 학생의 임상 기술 개발 진행 상황에 대한 유용한 피드백을 제공하는 동시에 즉각적인 피드백을 제공하는 것으로 간주되었습니다.

In the work-based assessment, COVID had impacted the affordances of the workplace for observation and feedback, but overall was regarded as working as intended and giving useful feedback on student progress in developing clinical skills, whilst providing immediate feedback.

채점 방식은 매우 일반화되어 있어 구체적이지 않다는 점에서 정말 좋았습니다. 올해에는 병력과 신체 검사를 통해 자신감을 키우는 것이 더 중요하다고 말했는데, 정말 자신감을 키우는 데 도움이 된 것 같아요. 호흡기 첫 번째 블록에서 신체검사를 할 때 규모가 아주 작았던 것도 정말 좋았습니다. 주변부 검사만 하다가 복부 전체 검사 같은 것까지 확장해 나갔어요. (C)

The marking scheme was really good in that it's quite generalised, so it's not very specific. So, I feel like they did say for this year it's more about building confidence by doing the history and physical exams, and I think that those really built up the confidence. I also really liked how in our first block in respiratory, for the physical exam it was quite small. It was kind of just doing peripheries, but then they just built up to something like maybe the whole abdominal exam. (C)

[TBL 세션에서 기계식 다이어그램을 공동으로 제작하는 것]은 TBL 프로세스의 유용한 학습 목표이자 프로그램 이론과 잘 어울리는 것으로 간주되었습니다. 그러나 [코로나19 적응]의 일환으로 팀 기반 평가로 재구성되었을 때 학생들은 이를 고난도 평가로 인식하여 전반적인 학습에 큰 지장을 주었습니다. 학생들은 주로 투자한 시간과 학습 성취도 사이의 불균형, 즉 불필요한 인지적 부하 때문이라고 설명했습니다.49 일부 그룹에서는 [전반적인 학습적 가치를 희생]하면서까지 [점수만 더 잘 얻는 데 집중]하는 방식으로 팀워크가 형성되었습니다. 이는 학생들이 [TBL 관련 점수를 해석하는 방법]과 [기대되는 표준이 무엇인지에 대한 불확실성]이 그 배경에 있었습니다.

The collaborative production of mechanistic diagrams in the TBL sessions was seen as a useful learning endpoint of the TBL process and a good match to programme theory. However, when recrafted as a team-based assessment, as part of COVID adaptations, the students perceived them as a high-stakes assessment, strongly detracting from overall learning. Students explained this was mainly because of an uneven balance between the time invested and their learning gains, a matter of extraneous cognitive load.49 For some groups, collaborative teamwork became focussed on achieving higher marks at the expense of the overall learning value. This was on a background of student uncertainty in how to interpret the TBL-related marks and what the standard expected might be.

우리가 기계식 다이어그램을 만들기 시작했을 때 수업 시간에 할 때는 매우 간단하다고 느꼈습니다. 그런데 막상 제출하고 마킹을 해야 하는 순간, 이 다이어그램에는 높은 수준의 복잡성과 많은 양의 세부 사항이 포함되어야 했기 때문에 당연히 시간이 더 걸리고, 더 많은 시간을 생각해야 했습니다. (B)

When we started doing the mechanistic diagrams, I feel like—when we are doing it in class, they are very simple. And then as soon as they had to be handed in and marked, we were expected to have a high level of complexity and large amounts of detail within this diagram, which of course adds more time, and you have to spend more time thinking about it. (B)

마찬가지로, TBL 세션의 일부인 [개별 준비도 확인 테스트(iRAT)]는 학습의 유용한 동기 부여로 여겨졌습니다. 그러나 학습 진도를 나타내는 지표로서 iRAT는 학습의 만족스러운 성취도를 측정하기보다는 TBL 전에 학습할 준비가 되었는지를 나타내기 위한 것이기 때문에 그 중요성이 지나치게 크다고 생각했습니다.

Similarly, the individual readiness assurance tests (iRATs) as part of the TBL sessions were seen as a useful motivator of learning. However, as indicators of progress in learning, iRATs were considered to have too much perceived importance, given they were intended to indicate readiness to learn before the TBL rather than a measure of satisfactory achievement of learning.

SPR에 과제를 늦게 제출한 것을 기록하는 등 [전문성을 평가하는 것]에 대한 [교수진의 집단적 견해]는 학생에게 문제가 되었습니다. 학생들은 [여러 평가 중 하나를 제출할 때 사소한 문제로 전문성 위반으로 판단될까 봐 이 과정이 징벌적이라고 느꼈다]고 우려했습니다. 또한 [사소한 위반 사항]이 [학생 기록]에 남아 [교수의 학생에 대한 인상을 편향적]으로 만들 수 있습니다. 학생들은 [전문직업성 위반]으로 간주하기보다는, 추가적인 지원과 노력을 통해 [개선해야 할 과실]로 간주하는 것이 더 편한 것으로 나타났습니다.

The collective faculty view on assessing professionalism including recording late submission of tasks in the SPR was problematic for students. They worried the process felt punitive as they feared being judged in breach of professionalism for a minor issue when submitting one of multiple assessments. Further, trivial breaches could remain in the student record and bias faculty impressions of them. Students appeared more comfortable with viewing unprofessionalism as a lapse to be worked on,25 with additional support and work, rather than being viewed as a professional breach.

전문성을 평가하는 것은 누군가를 프로페셔널하다고 평가하기보다는 잃어버릴 수 있는 무언가라고 생각합니다. 하지만 강의나 임상에서 어떤 사람이 행동하는 방식이 비전문적이라고 느껴질 때가 있는데, 그런 부분도 반영되어야 한다고 생각합니다. (A)

With assessing professionalism, I feel like it's sort of more something to be lost, rather than having to assess someone as being professional. But then like sometimes things might happen throughout the year, the way someone acts in lectures, or at clinical school, like, there's instances where I feel like they are displaying unprofessionalism, and that is sort of what should be reflected instead. (A)

[재교육 프로세스의 시행]은 [불확실성을 초래]했습니다. 이는 학생들이 의사 결정 및 진행 과정과 SPR의 연말 검토에서 포트폴리오 자문 그룹의 역할에 대한 지식이 부족하다는 주장으로 인해 증폭되었습니다.

The implementation of the remediation process led to uncertainty. This was amplified by the claimed lack of knowledge amongst the students about the decision-making and progression process and the role of the portfolio advisory group in the end of year review of the SPR.

(재교육을) 겪어보지 않고는 알기 어렵고, 얼마나 많은 정보가 공개되었는지 알기 어렵지만, 시험에 실패하면 어떤 결과가 초래되는지 이해하지 못한다는 점에서 투명하지 않은 것 같고, 처음에는 상당히 지원적인 과정이라는 인상을 받았고, 자원이 주어지고 개선 방법을 알려주어 한 해를 마무리하는 것을 목표로 할 수 있을 것이라고 생각했습니다. 하지만 꼭 그런 것만은 아닌 것 같습니다. (E)

It's hard to know, not going through it (remediation), it's hard to know how much was disclosed to the people that did, but it has not seemed all that transparent in terms of you do not understand, if you were to fail an exam, what the consequences are and I was under the impression to begin with that it was quite a supportive process, and that you'd be given the resources and told how to improve so that then you could, with the aim of completing the year. But it seems like that's not reality necessarily. (E)

요약하면, 평가 데이터의 수집과 대조 및 보고에 관한 프로그램 이론의 관점에서 볼 때, [기초 및 임상 과학의 점진적 테스트와 작업 기반 평가는 프로그램 이론이 예측한 대로 대체로 작동]했습니다.

- [핵심 학습 방법으로서 TBL]의 [어포던스와 평가]라는 다른 맥락에서의 사용 사이의 차이로 인해 상당수의 학생들이 [SPR에 준비성 확인 시험을 포함하는 것의 가치]에 대해 이의를 제기했습니다.

- [전문직업성 평가]는 단순하고 과제 제출 시간 지연에 국한된 것으로 인식되었습니다.

- [의사 결정 및 진급 규칙이 운영되는 방식을 사회화하는 데 있어서의 문제]는 학생들이 [다양한 평가 형식의 부담]과 [교정 시스템의 유용성]에 대한 [불확실성]으로 나타났습니다. 이는 일부 학생에게 스트레스가 되었습니다.

In summary, in terms of programme theories around the collection and collation and the reporting of assessment data, the progressive testing of basic and clinical science and the work-based assessment had worked largely as the programme theories had predicted they would.

- The difference between the affordances of TBL as a key learning method and its use in a different context, as an assessment, had a significant proportion of students challenging the value of including, for example, readiness assurance testing in the SPR.

- The assessment of professionalism was perceived as simplistic and limited to the lateness of assignment submission.

- Problems in socialising the way in which decision-making and progression rules operated were manifested in students' uncertainty of the stakes of differing assessment formats and the utility of the remediation system. That was stressful for some students.

RQ 3: 교수진 및 동료와 같은 새로운 커리큘럼 내의 다양한 주체와의 상호작용이 학생들의 프로그램 참여에 어떤 영향을 미쳤나요?

RQ 3:How did the interactions with various entities within the new curriculum such as faculty and peers influence students' engagement with the programme?

3.1.3 문화 시스템 구축

3.1.3 Building a cultural system

이 주제는 프로그램 내에서 널리 퍼져 있는 [문화 시스템, 학생과 교수진이 '함께 배우는 방법을 배우려는' 시도]를 설명합니다.50 [프로그램 평가]는 학생과 교수진 모두에게 새로운 경험이었습니다. 이 주제에는 학생들의 정서적 혼란, 비생산적인 작업이라는 개념, 학생들이 처한 학습 상황에서 '어려운 집단'이라는 인식도 포함됩니다. 학습 문화 시스템에 대한 학생들의 인식은 일부 학생들의 학습 평가에 여러 가지 방식으로 영향을 미쳤습니다.

This theme describes the system of culture prevailing within the programme, the sense of students and faculty attempting ‘to learn how to learn together’.50 Programmatic assessment was a new experience to both students and faculty. The theme also includes the contribution of the emotional turmoil of the students, the notion of unproductive work and the student perceptions of ‘being a difficult cohort’ in the learning contexts they found themselves in. Their sense of the learning cultural system impacted some students' assessment as learning in a number of ways.

심지어 사람들이 내 편이 되어야 할 때 내 편이 아닌 것처럼 느껴지면 동기를 유지하기가 어렵습니다. 그래서 약간 징징대는 것처럼 들리겠지만, 전반적으로 이 코호트의 분위기가 다운된 것 같아요. 그리고 제가 그렇게 말하는 것이 과장된 것 같지는 않습니다. (J)

And even—yeah, it's just hard to stay motivated when you feel like people aren't on your side, when they are supposed to be on your side. So, it sounds a bit whingy, I know, but I just think it's overall, like, brought down the mood of this cohort. And I do not think I'm exaggerating when I say that. (J)

일부 학생들에게는 부정적인 학습 문화 또는 심지어 '비난 문화'(J)에 대한 인식이 있었는데, 이 프로그램의 정신이 학교를 갓 졸업한 학부생에게 더 적합한 감시의 문화로 인식되었습니다. 학생들은 자신을 제외한 동료 학생들이 의학을 배우는 과정에서 변화에 저항하고 있다는 사실을 인식하고 있었습니다.

For some students, there was a perception of a negative learning culture or even a ‘blame culture’ (J) where the ethos of the programme was perceived as one of surveillance, more appropriate to undergraduate students straight from school. Students recognised that their fellow students, perhaps excluding themselves, were being resistant to change in the context of learning medicine.

그러나 그들은 또한 당신이 마치 미성년자인 것처럼 평가에서 징벌적으로 처벌하기를 원합니다. 이제 17세와 18세인 여러분은 고등 교육 시스템에서 어떻게 존재해야 하는지 배우기 위해 일종의 채찍질을 당해야 합니다. 좋아요. 사실 1학년 과목이 약간 징벌적이어도 괜찮아요. (B)

But then they also want to punish you punitively in assessments as if you are an under-grad. Now, if you are a 17- and 18-year-old, you need to be kind of whipped into shape to learn how to exist in a tertiary education system. Fine. I'm actually okay with first year subjects being a bit punitive. (B)

학생들이 교수진으로부터 [필요한 정보를 얻기 위해 해결 방법]으로 찾은 몇 가지 방법이 있었습니다. 이러한 방법 중 하나는 "학생 대표(학년 학생 대표)를 통해 Facebook(1학년 비공개 소셜 미디어) 그룹에 글을 올리는 것"(C)과 같이 학생 대표를 통하는 것이었습니다. 다른 학생들은 교수진과의 커뮤니케이션에 문제가 있다고 지적했습니다.

There were a few ways that the student found as workarounds to get the information they felt they required from faculty. One of these ways was through the student representatives, for example, “relying on student reps (year student representatives) to post up on the Facebook (private Year 1 social media) group” (C). Others noted that the faculty communications were problematic.

저는 학생 대표들이 놀라운 일을 하고 있다고 생각합니다. 하지만 당신들은 시험에 어떤 내용이 포함될지 저희에게 알려주면 안 됩니다. 그건 교수진에게 맡겨야 합니다. (J)

I think student reps are doing an amazing job. But you guys should not be responsible for telling us what's going to be on our assessment. That should be on the faculty (J)

학생들은 정서적 혼란을 겪으면서 평가 참여와 학습에 영향을 미치는 다양한 상황적 요인을 경험했습니다.51

Students had experienced a range of differing situational factors impacting their participation in assessment and learning through their emotional turmoil.51

개인적으로 저는 첫 번째 해부학 실기 시험에 정말 정말 스트레스를 많이 받았습니다. 그 시험 공부에 많은 시간을 할애했고, (필기 평가에서) 평가될 다른 내용을 위해 제 학습을 많이 희생했습니다. 그리고 그 후에 그 시험이 감독 시험이 아닌 이유는 비중이 충분하지 않기 때문이라는 것을 알게 되었습니다. (J)

Well, for me personally, I went into the first, for example, the anatomy spot test, being really, really stressed. Spent a lot of time dedicating to studying for it, and kind of sacrificed a lot of my learning for the other content that was going to be assessed in the (written assessment). And then I found out after that that the reason that it wasn't a proctored exam is because it does not weigh enough. (J)

그러나 몇몇 학생들은 동료들 중 일부가 익명성 뒤에 숨어 교수진에게 피드백에 대한 책임을 지지 않는 등 [비전문적으로 '무례하게' 행동한다]고 지적했습니다. 이에 대한 해결책은 교수진과 학생 간의 소통을 개선하고 다양한 커뮤니케이션 수단을 통해 명확한 기대치를 설정하는 것으로 나타났습니다.

However, several students noted that a proportion of their peers were being unprofessionally ‘rude’, hiding behind their anonymity, and not taking responsibility for their feedback to the faculty. The solution appeared to be better communications between faculty and students and setting clear expectations, through multiple means of communication.

연초에 이러한 기대치를 잘 설정하는 것만으로도 충분했습니다. 따라서 기초 세션에서 전문성, 참여도, 사람들이 참여해야 하는 학습 리소스에 대한 기대치를 설정하고 학생들이 이를 보완하기 위해 무엇을 해야 하는지에 대한 기대치를 평가하면 이러한 문제를 상당 부분 해결할 수 있습니다. (A)

Just setting those expectations well at the beginning of the year. So, in your—in the foundation sessions, setting the expectations around professionalism, around participation, around what learning resources people should be engaging with, and assessing expectations around what students need to be doing supplementary to that, solves a lot of these problems. (A)

요약하면, 데이터에 따르면 대부분의 학생이 [학습에 대한 새로운 사고 방식과 평가와의 관계에 대한 요구 사항을 수용]하고 있는 것으로 나타났습니다. 그러나 일부 학생들은 [교수진과의 일부 커뮤니케이션]에서 [개인의 행동을 규제하는 사회적 규범(규범 없음)의 붕괴], 즉 뒤르켐이 말한 아노미를 경험했습니다.52 이러한 현상은

- 첫째, 학생들 사이에서, 그리고 학생 대표와의 대화에서 분명하게 드러났습니다.

- 둘째, 이메일을 통한 교수진과의 소통, 학습 관리 시스템을 통한 공지, 학생 핸드북에 포함된 정보에 대한 설명을 통해 나타났습니다.

교수진과의 프로그램에 대한 학생들의 [사회적 상호 작용]에서 [교수진이 지지하는 문화적 목표]와 [이를 전달하기 위한 제도적 수단] 간의 [격차]로 인해 학습 문화에 대한 인식된 문제가 발생했을 수 있습니다.

In summary, our data suggested that most students embraced the requirements for new ways of thinking about learning and its relationship with assessment. However, some students did experience what Durkheim called anomie, a breaking down of social norms (normlessness) regulating individual conduct in some of the communications with the faculty.52 It was made manifest in the talk of students,

- first with each other, and their student representatives.

- Second, through their communications with faculty via email, announcements through the learning management system, and clarification of information contained in student handbooks.

In the students' social interactions about the programme with faculty, the perceived problems of the learning culture may have arisen because of the gap between the cultural goals espoused by faculty and the institutional means to deliver them.

3.2 파트 2: 실제 포장 풀기

3.2 Part 2: Unpacking the real

RQ 4: 학생들의 인식과 경험에 대한 근본적인 설명은 무엇이며, 그것이 프로그램적 평가의 성장과 지속 가능성에 어떤 영향을 미칠 수 있습니까?

RQ 4:What were the underlying explanations of students' perceptions and experiences, and how might they influence growth and sustainability of programmatic assessment?

CR 관점에서 프로그램식 평가가 학생들에게 어떻게, 왜, 어떤 특징이 효과가 있었는지를 설명하려면 [평가 시스템이 학습에 어떤 영향을 미쳤는지]에 대한 [학생들의 인식과 경험의 근본적인 메커니즘]을 풀어야 했습니다.36, 53

- 아처의 [형태 발생 이론(앞서 소개)]44, 54은 프로그램식 평가를 실행하는 맥락에서 구조, 문화 및 기관 간의 3방향 상호 작용을 뒷받침하는 인과 관계(메커니즘)를 풀어내고 이해하는 데 더 깊은 통찰을 제공했습니다.

- [형태 발생학적 접근 방식]은 구조, 문화 및 에이전트에 대한 계층화된 설명을 가능하게 하는데, 이는 각각이 프로그램식 평가에 대한 학생의 경험을 설명할 수 있는 새로운 속성 및 힘(즉, 인과적 메커니즘)을 가지고 있기 때문입니다.55

- 이러한 메커니즘은 [프로그램식 평가로 변화]할 때 특정 조건(즉, 제약 및 어포던스)에서만 나타난다.

- 더욱 정교화(형태 발생)하거나

- 변화에 저항(Archer가 말하는 형태 형성54)하거나

- 프로그램적 평가에서 주기적이고 지속적인 형태 형성 과정은 다음의 둘 사이의 최적의 긴장을 유지하는 데 달려 있습니다.

- '조건화'(새로운 관행과 이전에 가지고 있던 신념의 합의 및 통합)

- '정교화'(새로운 기능의 수용 및 적응성)

Explanation of how, why and what features of the programmatic assessment worked for the students from a CR stance involved unpacking the underlying mechanisms behind students' perceptions and experiences of how the assessment system impacted their learning.36, 53

- Archer's theory of morphogenesis (introduced earlier)44, 54 provided us with deeper insights into disentangling and understanding causal linkages (mechanisms) underpinning the three-way interplay between structure, culture and agency in the context of implementing programmatic assessment.

- The morphogenetic approach allows for a stratified account of structures, culture and agents, as each has emergent and irreducible properties and powers (i.e., causal mechanisms) that explain the student experiences of programmatic assessment.55

- These mechanisms only manifest themselves under specific conditions (i.e., constraints and affordances) when changing to programmatic assessment

- to further elaborate (morphogenesis) or

- to resist the change (what Archer calls morphostasis54).

- The cyclical and ongoing process of morphogenesis in programmatic assessment depends on maintaining optimal tensions between

- ‘conditioning’ (consensus and integration of new practices with previously held beliefs) and

- ‘elaborations’ (acceptance and adaptability of the new features).

[경험적 및 현실적 수준]에서 연구 결과에서 '실재'를 역행추론 할 때, 프로그램적 평가와 관련된 구조 및 문화 시스템은 뚜렷하지만 서로 [연관된 인과적 힘]을 가지고 있습니다(그림 3 참조). 특히, 역행추론은 다음을 강조했다.

- 첫째, 진정한 [프로그램적 의제]를 유지하는 데 있어 [학생 코호트의 반성적 숙고]가 중요하다는 점,

- 둘째, [프로그램적 평가의 지속 가능성]에 필요한 형태 형성(형태 고정이 아닌)을 촉진하기 위해 평가를 둘러싼 지역 구조 및 문화 시스템의 (학생 주도) 변화에 주의를 기울이는 것이 중요하다는 점

In retroducing the ‘real’ from our findings at the empirical and actual level, the structure and culture systems associated with the programmatic assessment have distinct but related causal powers (see Figure 3). In particular, retroduction highlighted

- first, the centrality of reflexive deliberation of the student cohort in maintaining a truly programmatic agenda;

- second, the importance of attending to (student-led) changes in the local structures and cultural systems surrounding assessment to facilitate the morphogenesis (rather than morphostasis) required for the sustainability of programmatic assessment.

[평가 구조, 문화 시스템 및 학생 주체성 간의 상호 작용의 균형]을 맞추는 중요한 예는 임상의가 되기 위한 광범위한 측면에 대해 [학습 상담사와의 귀중한 전문적 대화]였습니다. 이는 대부분의 학생의 교육에 대한 주체성을 강화하는 역할을 했습니다. 동시에 학생들은 의학 지식에 대한 이해를 촉진하는 데만 초점을 맞춘 [평가 위주의 관계]보다는 [멘토링 유형의 관계]를 요구함으로써 프로그램 평가의 의도된 목적을 유지하고 더욱 정교화할 수 있는 조건도 갖추게 되었습니다.

An important example of balancing the interplay between assessment structures, the cultural system and student agency, was the valuable professional conversations with learning advisors concerning broader aspects of becoming a clinician. This functioned to enhance the agency of most students in their education. At the same time, the students were also conditioned to sustain and further elaborate the intended purpose of programmatic assessments, by calling for a more mentorship type relationship rather than a purely assessment focussed one that would only facilitate their understanding of medical knowledge.

반대로, [균형을 맞추지 않으면 학생의 주체성을 상실]하고, [전통적인 평가 구조와 문화로 되돌아]가면서, 시행된 평가 프로그램이 여전히 문제가 되는 [모포스타시스 상황]이 발생할 수 있습니다. 이는 많은 학생들에게 '아노미'52, 즉 규범이 없는 상태, 즉 의도된 목적과 실제 전달에서 [역기능과 비활성화로 이어지는 무규범normless 상태]로 이어질 수 있습니다. 그 결과 중 하나는 평가의 이상과 실제 사이의 불일치로 인해 프로그램 평가의 고유한 [모포제네시스]에 위협을 가하는 것입니다.

In contrast, getting the balance uneven potentially leads to situations of morphostasis where the implemented programme of assessments remains problematic due to the loss of student agency and the return of the traditional assessment structures and culture. This can lead to a sense of ‘anomie’52 for many of the students, that is, a normless state leading to dysfunctionality and inactivity in the intended purpose and actual delivery. One of the consequences is threats to the inherent morphogenesis of programmatic assessment due to a mismatch between assessment ideals and practices.

균형이 맞지 않는 예로는 [의도된 이론]과 [구현된 평가 구성 요소] 간의 [불일치]가 있으며, 이는 평가의 구조와 문화 모두에 영향을 미칩니다. 예를 들어,

- [재교육의 지원적 목적과 징벌적 목적]에 대한 [학생의 인식]은 [학생의 자율성을 잠재적으로 제약하는 요인]으로 작용했습니다.

- 마찬가지로, [전문직업성 평가에 대한 징벌적 인식]은 학생들이 e포트폴리오를 감시와 통제의 도구로 경험함으로써 수동성과 무력감, 수동적 비활동성(아노미)을 유발하여 반성성과 주체성을 강화하기보다는 오히려 감소시켰습니다.

Examples of uneven balance include the mismatch between the intended theory and the implemented version of assessment components, impacting both the structure and culture of assessment.

- Student perceptions about the supportive versus punitive purpose of remediation, for example, served as potential constraints to students' agency.

- Similarly, punitive perceptions of the assessment of professionalism, where the ePortfolio was experienced by students as a tool for surveillance and control, diminished rather than enhanced reflexivity and agency by creating a sense of passivity and a feeling of powerless and passive inactivity (anomie).

요약하면, 프로그램 평가를 개발하고 정교화할 때 [구조, 문화 및 주체성] 간의 [균형]을 유지하여 [모포제네시스]를 지속하려면 교수진과 학생 간의 [권력 역학 관계]와 [신뢰의 최적 분배]에 달려 있습니다. 이는 평가 프로그램 내에서 숨겨진 커리큘럼이라는 비생산적인 느낌으로 이어지는 균형 부족으로 인해 성공적인 변화를 구현하는 데 핵심적인 요소로 부상했습니다.In summary, providing balance between structure, culture and agency to sustain morphogenesis in developing and elaborating programmatic assessment relies on optimal distribution of power dynamics and trust between faculty and the student body. This emerged as central to implementing successful changes with a lack of balance leading to the counterproductive sense of a hidden curriculum within the programme of assessments.

4 토론

4 DISCUSSION

4.1 주요 결과 요약

4.1 Summary of key findings

우리는 새로 도입된 프로그램적 평가의 요소가 어떤 상황에서 왜 학습을 향상시키는 측면에서 학생들에게 어떻게 작용했는지 이해하고자 했습니다. 우리는 평가 실행의 [구조, 문화 시스템의 조건 및 학습자 주체성] 간의 복잡한 상호 작용을 풀기 위해 순환적 역동적 변화 모델(형태 형성)과 연계된 세 가지 현실 영역(경험적, 현실적, 실재적)에 기반한 CR 관점을 사용했습니다. 우리의 핵심 발견은 학생의 경험을 설명하고 향후 평가 프로그램의 반복을 최적화할 수 있는 방법을 암시하는 [근본적인 메커니즘]을 발견하는 것이었습니다. 이 연구에서 나온 모델은 그림 3에 나와 있으며, 인과적 메커니즘을 구조, 문화, 기관 간의 균형으로 시각화하는 방법입니다. [건설적인 균형의 예는 학습 어드바이저 시스템 운영]에서 발견되었습니다. [균형이 부족]하면 평가 프로그램 내에서 학생들에게 [숨겨진 커리큘럼이 있다는 느낌]을 주게 됩니다.

We sought to understand how elements of a newly introduced programmatic assessment worked for the students in terms of enhancing their learning under what circumstances and why. We used a CR stance based on three domains of reality (empirical, actual and real) allied to a cyclical dynamic model of change (morphogenesis) to unpack the complex interplay between the structures of assessment practice, the conditions of the culture system and learner agency. Our key finding was discovering underlying mechanisms that were both explanatory of student experiences and suggestive of ways in which future iterations of the programme of assessments could be optimised. The model that emerged from this study is given in Figure 3, which is a way of visualising the causal mechanism as one of balance between structure, culture, and agency. An example of a constructive balance was found in the operating of the Learning Advisor system. A lack of balance led to the sense of a hidden curriculum for students within the programme of assessments.

프로그램 평가를 [복잡한 사회적 변화]로 간주할 때,

- [관련 구조와 문화]는

[에이전트(학생 및 교수진 선택)의 행동]에 대한

조건(제약과 활성화의 형태)과

조건화(새로운 '비전통적' 평가 프로세스의 수용의 형태)를 제공했습니다. - 이러한 상호 작용을 통해 [전통적인 평가 관행이 프로그램 평가로 전환(정교화)]되었습니다.

Considering programmatic assessment as a complex social change,

- the associated structures and culture

provided conditions (in the form of constraints and enablements) and

conditioning (in the form of acceptance of new ‘non-traditional’ assessment processes)

for the actions of agents (student and faculty choices). - These interactions resulted in traditional assessment practices being transformed (elaboration) towards programmatic assessment.

그러나 평가 관행이 어떻게 전통적인 방식으로 유지될 수 있는지에 대한 지적도 있었습니다. [형태 형성 및 형태 정체 과정]은 프로그램식 평가 내에서 지속적이고 지속적이면서도 [쉽게 원래의 특징으로 되돌아갈] 수 있는 [변화의 순환적 특성]에 대한 이해를 제공했습니다.54 프로그램식 평가의 다양한 요소의 근간이 되는 [의도된 프로그램 이론]과 [프로그램식 평가에 대한 학생들의 (종종) 잘못된 인식] 사이의 [불일치]는, 새로운 평가 관행을 유지하고 학생들의 학습 및 반성성을 최적화하는 데 위협이 될 수 있습니다. CR 접근법의 역동적 유연성은 프로그램식 평가의 다양한 요소(예: 평가 형식, 학습 어드바이저 시스템, 교정 및 진도 결정)가 어떻게 상호 연관되어 있는지, 즉 한 영역의 변화가 다른 영역의 변화에 영향을 미치는지 이해하는 데 도움이 되는 것으로 입증되었습니다.

However, there was also indication of how the assessment practice could remain traditional. The process of morphogenesis and morphostasis provided an understanding of the cyclic nature of changes within the programmatic assessment that are sustained, continued, and yet which can easily revert back to the original features.54 A mismatch between intended programme theories underlying various elements of programmatic assessment and the students (often) fallible perceptions in their experience of the programmatic assessment can be a threat to sustaining new assessment practices and optimising student learning and reflexivity. The dynamic flexibility of the CR approach proved helpful in understanding how the various elements of programmatic assessment (such as assessment formats, learning advisor system, remediation and progression decision making) were interrelated, such that change to one area impacted change in another.

4.2 기존 이론 및 문헌과의 비교

4.2 Comparison with existing theory and literature

우리의 연구 결과는 [프로그램 평가]를 실행하는 동안 학생들의 다양한 경험에 영향을 미치는 [중요하지만 종종 무시되는 인과 메커니즘]이 있음을 시사함으로써 보건 전문직 교육에서 프로그램 평가에 대한 기존 논쟁에 추가됩니다. 이는 복잡하고 역동적이며 다단계 시스템을 포함하는 실행 접근법에 관한 기존 문헌에 추가됩니다.12, 13 우리의 연구 결과는 프로그램 평가에 대한 학생의 경험을 설명할 수 있는 중요한 인과 메커니즘에 추가됩니다.12, 13, 56 우리의 연구는 또한 CR 입장을 사용하는 이전의 이론적 연구를 확장합니다.18 경험적 데이터를 제공하고 학생의 기관과 평가의 규칙 및 규정과 지역 문화 시스템 간의 미묘한 균형을 밝혀 설명할 수 있는 잠재적 메커니즘을 식별함으로써 그렇게합니다. 이 연구는 [평가 구조 및 학생 주체성과 연결된 문화 시스템]을 확인함으로써 보건 전문직 교육의 문화 및 문화 변화에 대한 현재의 사고를 확장합니다57, 58 이 연구는 학생 주체성에서 얻은 통찰력에 대한 현재의 이론적 사고를 확장합니다.59 비교 및 확장 이론을 개발하면서 그림 3에서 구조, 문화 및 주체성 간의 인과 메커니즘과 역동적인 상호 작용을 고려한 세 가지 영역에 대해 논의합니다.

Our findings add to the existing debates about programmatic assessment in health professions education by suggesting that there are important and often neglected causal mechanisms that impact the students varied experiences during the implementation of programmatic assessment. This adds to the existing literature on implementation approaches involving complex, dynamic and multilevel systems.12, 13 Our findings add to the overarching causal mechanisms that can explain student experiences of programmatic assessment.12, 13, 56 Our research also extends previous theoretical work in using a CR stance.18 It does so by providing empirical data and identifying potential mechanisms that are explanatory by revealing the delicate balances between students' agency and the rules and regulations of assessment and the local cultural system. It extends current thinking on culture and cultural change in health professional education57, 58 by identifying a culture system that is linked with structures of assessment and student agency.54 This research extends current theoretical thinking on insights gained from student agency.59 In developing the comparison and extending theory, we discuss three areas that take account of the causal mechanisms and the dynamic interplay between structure, culture and agency in Figure 3.

- 집단적 반성성을 통한 주체성 증진

- 평가 구조에 대한 통합적이고 유연한 접근 방식

- 사회 문화적 조건에 대처

- Promoting agency through collective reflexivity.

- Integrated and flexible approaches to assessment structures.

- Addressing socio-cultural conditioning.

4.3 집단적 반사성을 통한 주체성 증진

4.3 Promote agency through collective reflexivity

[반사성]은 아처의 CR 프레임워크에서 핵심 개념 중 하나입니다. 사람들의 '관심사'(관심 있는 것의 중요성)와 '맥락'(사회적 환경의 연속성 또는 불연속성) 간의 상호작용이 '반사성'의 방식을 형성합니다.37, 55 우리의 맥락에서 일부 프로그램 평가 관행은 학습 평가 이론에 확고하게 기반을 두고 있었습니다. 따라서 학습자가 주체성을 발휘할 수 있는 기회60 는 다소 제한적이었습니다. [교수자와 학생 간의 쌍방향 대화]는 [학습자가 평가 및 학습을 경험하는 동안 선택할 수 있는 능력]을 포함하여, [학습자의 주체성을 촉진]하여, [학습을 위한 그리고 학습으로서의 평가를 촉진]할 수 있습니다.61-63 다른 사람들은 학습자가 평가의 다양한 데이터 요소를 [고부담]으로 인식함으로써 주체성이 방해받을 수 있다고 지적하며, 교수자가 [안전하고 신뢰하는 평가 관계]에서 학습자의 주체성을 촉진할 수 있다고 제안했습니다.64

Reflexivity is one of the central concepts in Archer's framework of CR. The interplay between people's ‘concerns’ (the importance of what they care about) and their ‘context’ (the continuity or discontinuity of their social environment) shapes their mode of ‘reflexivity’.37, 55 In our context, some of the programmatic assessment practices were firmly grounded in the theory of assessment of learning. Accordingly, opportunities for learners to be agentic60 were somewhat constricted. A two-way dialogue between faculty and students might promote learners' agency including their ability to make choices during their experience of assessment and learning, facilitating assessment for and as learning.61-63 Others have noted that agency may be hindered by learners' perceptions of various data points in the assessment as high stakes and suggested that faculty can promote learner agency in safe and trusting assessment relationships.64

우리의 데이터는 [학습자의 주체성]을 촉진하려면 [일부 평가 구조와 통합 방식을 변경해야 한다]는 것을 시사합니다. 학생은 [자신의 주체성을 행사]하고, 학습을 촉진하기 위해 [직접 설계한 평가 과제에 참여]할 수 있는 [직접적인 책임]이 있습니다. [전통적인 평가 시스템]에서 [급진적인 프로그램식 평가 시스템]으로 대대적인 학습 전환을 겪는 학생들을 위한 [오리엔테이]션은 학생들의 준비 수준, 참여 및 학습 측면에서 학생의 주체성을 최적화하는 데 중요합니다.65 평가 구조를 조정하는 동시에 학생의 주체성을 촉진하는 메커니즘을 위해서는 특정 인과적 힘과 역량을 개발하는 데 더 많은 투자가 필요합니다.36 예를 들어, 평가 구조의 변화에 기여하고 학생의 반사성을 촉진하기 위해 교수진이 [학생 단체에 권한을 부여]할 수 있어야 합니다. [권한 부여의 정도]는 프로그램 제공의 지역적 맥락과 문화에 따라 달라질 수 있습니다.

Our data suggest that to promote learner agency, some of the assessment structures and the ways they integrate need to be changed. Students have direct responsibility in this regard to exercise their agency and engage with assessment tasks they had a hand in designing to facilitate their learning. The orientation for students undergoing a major learning transition from the traditional to a radical programmatic assessment system is important, so that students' level of preparedness, their agency in terms of engagement and learning is optimised.65 For any mechanism to promote student agency whilst simultaneously adapting assessment structures, there has to be further investment in developing certain causal powers and capacities.36 For example, there would need to be empowerment of the student body by faculty to contribute to a change in the assessment structures and promote student reflexivity. The degree of empowerment would depend on the local context and culture of programme delivery.

4.4 평가 구조에 대한 통합적이고 유연한 접근 방식

4.4 Integrate and flexible approaches to assessment structures

[여러 번의 필기 시험]과 [작업 기반 평가]와 같은 [프로그램 평가의 많은 요소]는 [의도한 대로 작동]했으며, 학생의 [진도를 나타내는 유용한 지표]로 인식되었습니다. 본 연구에서 프로그램 평가의 다양한 요소(예: 학습을 지원하기 위해 고안된 교정)의 근간이 되는 [의도된 프로그램 이론]과 [평가에 대한 학생들의 인식(예: 징벌로 인식되는 교정)] 간의 [불일치]는 [새로운 평가 관행을 유지하는 데 위협]이 되고, 이전의 [전통적인 관행으로 회귀할 위험이 있음]을 시사했습니다.

Many elements of the programmatic assessment worked as intended, such as multiple written tests and the work-based assessment, and were perceived as useful indicators of student progression. In our study, a mismatch between intended programme theories underlying various elements of programmatic assessment (such as remediation designed to support learning) and the students' perceptions of the assessment (such as remediation perceived as punitive) suggested a threat to sustaining new assessment practices and risk returning to previous traditional practices.

다른 사람들은 평가 과제가 이해되지 않거나 너무 복잡하여 학습자의 주체성에 도전하지 못할 수 있다고 지적했지만, 우리는 복잡성이 문제라기보다는 [일부 평가 과제(예: 팀 기반 학습)가 너무 큰 작업 부하]를 나타내며, [학습 진행에 부정적인 영향]을 미친다고 느꼈습니다.66 평가 요구 사항의 전반적인 [외부 인지 부하]는 특히 평가의 다른 요소와 교육과정의 다른 측면을 통합하는 데 있어 학습에 유리하도록 균형을 맞춰야 합니다.49, 1

Although others have noted that assessment tasks can fail to challenge learners' sense of agency by virtue of not being understood or too complex, we found that, rather than complexity being an issue, some assessment tasks (for example in the team based learning) were felt to represent too great a workload and had a negative impact on learning progress.66 The overall extraneous cognitive load of assessment requirements needs to be balanced in favour of learning, particularly in ensuring the integration of the different elements of the assessment as well as other aspects of curriculum.49, 1

개별 평가 형식의 [비례성 또는 부담에 관한 프로그램 이론의 불일치 문제]는 다른 연구 결과와 유사합니다. Schut 외.61 및 Heeneman 외.67은 [프로그램 설계자의 저부담 평가에 대한 의도]와 [이러한 평가를 총점 또는 높은 부담으로 인식하는 학생의 인식] 사이에 [불일치]가 있다고 보고했습니다. 평가에 '스테이크'가 부여되는 순간 학습자는 평가가 의도한 교육 효과를 방해하고 학생 학습의 본질을 변화시킬 수 있는 '총괄적'인 것으로 인식하게 됩니다.61, 67, 68 개별 평가에 대한 '스테이크'라는 용어는 SPR 전체에 대한 의사 결정 과정에 적용하는 것이 가장 적합하다고 생각합니다.18

The issues with mismatch of programme theory around proportionality or stakes of the individual assessment formats resonate with findings elsewhere. Schut et al.61 and Heeneman et al.67 reported a mismatch between programme designers' intentions underpinning low-stakes assessments and students' perceptions of these assessments as summative or high stakes. The moment ‘stakes’ are assigned to assessments; they are perceived as ‘summative’ by learners that may interfere with the intended educational effect and change the nature of student learning.61, 67, 68 In our view, the terms ‘stakes’ on individual assessment are best applied to the decision-making process on the whole of the SPR.18

[학습을 위한 그리고 학습으로서의 평가 문화]에 변화를 구현하려면 [평가 프로그램, 평가자 및 학생 간의 열린 상호작용]이 필요하며,9, 10, 69 [의도한 설계]와 [평가 결과 간의 관계]를 [개선]해야 합니다.7, 20 학습 상담사와 같은 학습자 기관을 지원하는 구조를 활성화하는 데 충분한 자원이 필요할 수 있습니다.61 대부분의 학생과 교직원은 전통적인 접근 방식으로 일한 경험이 있으므로 의사 결정 및 진행 규칙을 사회화하는 데 교수진 개발이 중요한 역할을 담당합니다.

Implementing change to the culture of assessment for and as learning requires open interactions between the assessment programme, the assessors and the students,9, 10, 69 creating an enhanced relationship between the intended design and assessment outcomes.7, 20 Sufficient resources are likely to be needed for enabling structures to support learner agency such as learning advisors.61 There is an important role for Faculty development in socialising the decision-making and progression rules as most student and staff have a history of working with traditional approaches.

4.5 사회문화적 조건 해결

4.5 Address sociocultural conditioning

아처의 [형태 형성] 개념에 따르면 학습, [문화의 변화 과정]은 [학생과 평가 프로그램의 구조]가 서로 맞물려 [시간적으로 복잡한 방식]으로 지속됩니다.44 학생들은 [새로운 규범, 새로운 동료 커뮤니티 및 권력 관계]를 습득합니다. 프로그램 평가에 참여하는 [학생의 구조적, 문화적 문제]를 해결하면 평가 설계를 정교화하고 개선할 수 있습니다. 이를 무시하면 문화가 기존 평가의 규범으로 되돌아갈 수 있습니다. 요컨대, 프로그램식 평가는 커리큘럼의 구조적 변화뿐만 아니라 문화적 변화도 동시에 요구합니다.

According to Archer's notion of morphogenesis, the processes of change in a learning culture are sustained for both the students and the structures of the assessment programme in interlocking and temporally complex ways.44 Students acquire new norms, new communities of peers and power relationships. Addressing the structural and cultural concerns of students in engaging with programmatic assessment will lead to elaboration and refinement of the design of assessments. Neglecting this may reset the culture back towards the norms of traditional assessment. In short, programmatic assessment requires not only structural changes to the curriculum but also a simultaneous cultural shift.

평가 개혁을 수행할 때 상당수의 학생이 [숨겨진 또는 의도하지 않은 커리큘럼]을 경험한다면 이는 항상 교수진의 관심사가 될 것입니다. 문헌에서 평가의 숨겨진 요소에 대한 논의가 있었습니다.70, 71 우리의 데이터에 따르면 프로그램에 대한 학생들의 '아노미'는 주로 [학습을 위한 평가]에 대한 기대에 부적합한 [위압적인 평가 구조를 경험]하는 학생들의 증상과 징후에 관한 것이었습니다. 이는 다음으로 인해 더욱 악화되었습니다.

- 교수진과의 소통이 원활하지 않은 문화,

- 학생 대표가 갈등이 있는 부분을 협상해야 한다는 불공정한 기대,

- 평가가 신뢰에 기반한 것이 아니라 학생을 감시하는 관행이라는 느낌

It will always be a faculty concern if a significant proportion of students experience a hidden or unintended curriculum, when undertaking assessment reform. There has been discussion of the hidden element of assessment in the literature.70, 71 Our data suggest that the student ‘anomie’ with the programme was principally around the symptoms and signs of students experiencing an overbearing structure of assessment that was a misfit for their expectations of assessment for learning. This was exacerbated by

- a perceived culture of suboptimal faculty communication,

- an unfair expectation of student representatives to negotiate areas of perceived conflict and

- a sense of feeling assessment was a practice of surveillance of students rather than trust based.

소수는 프로그램식 평가에 대한 경험을 파괴적으로 해석했지만, 대다수는 학생의 선택권과 주체성 표현을 확대하고 덜 경직된 평가 프로토콜, 즉 [구조의 문제로 문화가 변화할 수 있다]고 말했습니다. 학습 환경의 문화 변화는 동료 교수 및 지원 프로그램, 거버넌스 프로세스, 궁극적으로 평가 변화를 포함하는 [교육과정 변화에 대한 학생의 적극적인 참여를 위한 전략 개발]을 통해 가장 잘 관리됩니다.72, 73

Although a small minority were subversive in their interpretation of their experiences of the programmatic assessment, the majority spoke of potential culture changes towards more student choice and expression of agency, and less rigid assessment protocols, an issue of structure. Changing the culture of the learning environment is best managed through developing a strategy for active student engagement with curriculum change, covering peer teaching and support programmes, governance processes and ultimately assessment change.72, 73

4.6 방법론적 강점과 불확실성

4.6 Methodological strengths and uncertainties

본 연구는 연구 결과를 이해할 때 몇 가지 강점과 한계를 가지고 있습니다. 강점으로는, 이 연구는 프로그램적 평가의 실행에 대한 최초의 이론적으로 엄격한 설명 중 하나입니다. 이 연구는 학생의 경험을 보고하는 것을 넘어 학생들의 인식과 그것이 교육 및 사회 변화로서 프로그램식 평가의 성장과 지속 가능성에 어떤 영향을 미칠 수 있는지에 대한 훨씬 더 심층적인 설명을 제공하는 것을 목표로 합니다. [추론 도구]로서 비판적 현실주의와 가추 및 역행추론을 사용하는 것은35, 46 HPE 연구에서 비교적 새로운 방법입니다. 인터뷰 데이터를 존재론적 수준(실제, 경험적, 실제)에서 코딩하고 이분법적 귀납-연역 방식을 넘어서는 의미 있는 추론을 도출함으로써, 방법론적 엄밀성을 더할 뿐만 아니라 연구 결과에 대한 보다 의미 있는 설명을 제공할 수 있었습니다. 마지막으로, 14개 포커스 그룹에 걸쳐 112명의 학생의 관점과 경험을 수집함으로써 연구의 좁은 목표를 고려할 때 충분한 정보력을 갖춘 표본을 확보했다고 주장합니다.45

Our study has several strengths and limitations when making sense of the findings. As a strength, this is one of the first theoretically rigourous accounts of an implementation of programmatic assessment. It goes beyond reporting student experiences by aiming to provide a much deeper explanation of students' perceptions and how they might influence growth and sustainability of programmatic assessment as an educational and social change. The use of critical realism and abduction and retroduction as inferential tools35, 46 is relatively new to the health professional education research. Coding interview data at ontological levels (actual, empirical and real) and drawing meaningful inferences that go beyond dichotomous inductive–deductive modes not only added to methodological rigour but also provided more meaningful explanations of the findings. Lastly, by collecting the perspectives and experiences of 112 students across 14 focus groups, we claim a sample with sufficient information power given the narrow aims of our study.45

방법론적 과제로는

- 첫째, 귀납적, 연역적, 회귀적 분석 단계가 일부 중복되었고, 분석 과정이 선형적이기보다는 반복적이었다는 점입니다. 마찬가지로, 실제로는 연구자들 간에 경험적인 것과 실제적인 것에 대해 어느 정도 중복되는 부분이 있었지만, 무엇이 실제적인지에 대해서는 훨씬 더 큰 합의가 이루어졌습니다.

- 둘째, 구조, 문화 및 기관44 측면에서 데이터를 재개념화할 때 Staff의 행위자성을 고려하면 도움이 될 수 있었습니다. 이 연구의 초점은 학생의 설명이었지만, 프로그램의 구조와 문화가 학생의 행위자성에 미치는 영향에 대한 보다 풍부한 이해를 제공하기 위해서는 자체적인 대리성을 가진 교직원에 대한 인식도 고려할 필요가 있습니다.

- 마지막으로, 우리는 우리의 분석과 이론화가 새로운 커리큘럼의 일부로 프로그램 평가가 도입된 특정 맥락을 기반으로 했다는 점을 인정합니다. 그럼에도 불구하고 우리는 우리의 연구 결과가 대규모 학생 집단을 대상으로 한 프로그램 평가의 실행을 이해하고자 하는 다양한 맥락의 다른 사람들에게 적용될 수 있다고 믿습니다.

In terms of methodological challenges, first, there was some overlap between inductive, abductive and retroductive phases of analysis with the process being more iterative than linear. Similarly, in practice, although there was some overlap between researchers as to what was considered empirical and actual, there was much greater agreement on what constituted the real; second, reconceptualising the data in terms of structure, culture and agency44 might have benefited from considering staff agency. Although the focus of this study was the students' account, perceptions of faculty, who have their own agency, need to be considered in providing a richer understanding of the influence of structure and culture of the programme on student agency. Finally, we acknowledge that our analysis and theorising was based on a specific context where programmatic assessment was introduced as part of a new curriculum. Nonetheless, we believe our findings to be adaptable to others in differing contexts seeking to understand the implementation of programmatic assessment with large cohorts of students.

4.7 실무 및 연구에 대한 시사점

4.7 Implications for practice and research

구조, 문화, 기관37, 44, 54 및 현실의 계층화된 영역36, 38, 39 간의 관계에 기반한 CR 접근법은 소홀히 다루어진 관심 영역을 강조함으로써 보건 전문직 교육에서 평가 실무를 연구하는 데 의미 있고 적응 가능한 방법론을 제공할 수 있습니다.

- 교육자에게는 구조 문화 기관 프레임워크(그림 3)가 평가 및 교육과정을 (재)설계할 때 복잡한 교육 및 사회적 변화를 단순화할 수 있는 툴킷을 제공할 수 있습니다.

- CR 접근법은 다양한 맥락에서 무엇이 효과가 있는지, 누구에게 효과가 있는지, 가장 중요한 것은 근본적인 메커니즘 측면에서 어떻게 작동하는지 설명하는 데 신뢰할 수 있는 분석을 제공할 수 있습니다.

- 이 논문은 학생 경험에 초점을 맞추었지만 이러한 조사는 교수진의 관점을 이해하기 위해 확장될 수 있습니다.

- CR 접근법은 의과대학 또는 대학 내의 다양한 주체(예: 교수진 리더십 그룹, 교수진)가 프로그램 평가의 번창에 영향을 미치는 인과적 힘을 개발하고 행사하는 방식을 설명하는 데 도움이 될 수 있습니다.

- 또한 CR 관점에 기반한 연구 프로그램은 프로그램식 평가와 커리큘럼 간의 연결에 기반이 되는 기본 원칙에 대한 이해를 풍부하게 하여 현지의 질 개선과 다른 맥락에서 원칙의 더 나은 적용을 이끌어낼 수 있습니다.

A CR approach based on the relationship between structure, culture and agency37, 44, 54 and stratified domains of reality36, 38, 39 can provide a methodology that is meaningful and adaptable for researching assessment practice in health professional education by highlighting neglected areas of concern.

- For educators, our structure culture agency framework (Figure 3) can provide a toolkit which promotes a simplification of the complex educational and social changes when (re)designing assessment and curriculum.

- A CR approach can provide credible analysis for determining what might work across multiple contexts, what works for whom, and most importantly explaining how it works in terms of fundamental mechanisms.

- In this paper, we have focussed on student experiences, but such investigations can be extended to understand faculty's perspectives.

- A CR approach may help to explain how various entities within the medical school or university, for example, the faculty leadership groups, and teaching faculty develop and exercise causal powers that influence the flourishing of programmatic assessment.

- Research programmes based on CR perspectives can also enrich understanding of the fundamental principles underlying the link between programmatic assessment and curriculum thereby leading to local quality improvement and better adaptations of the principles in other contexts.

평가 개혁을 연구하는 접근법의 레퍼토리를 확장함으로써 프로그램 평가와 같은 복잡한 교육 이니셔티브에 대한 평가를 CR이 제공하는 보다 근본적인 관점에서 풀고 이해할 수 있습니다. 향후 작업에서 CR을 사용하면 의도한 결과를 현지의 요구와 상황에 맞게 맞춤화하고 조정할 수 있습니다. 이를 통해 실용적인 실행과 프로그램 평가의 장기적인 지속 가능성을 보장할 수 있습니다.