평가 실무의 개편에서 복잡성 탐색: 비판적 실재주의자 관점(Adv Health Sci Educ Theory Pract. 2021)

Exploring complexities in the reform of assessment practice: a critical realist perspective

Chris Roberts1 · Priya Khanna1 · Andrew Stuart Lane1 · Peter Reimann2 · Lambert Schuwirth3

소개

Introduction

학습에 대한 전통적인 평가를 학습을 위한, 그리고 학습으로서의 평가를 포괄하는 프로그램으로 개혁할 때 몇 가지 문제가 있을 수 있습니다. 총괄적 고부담 의사 결정을 강조하는 평가 시스템에 대한 전통적 접근 방식은 복잡한 인간의 기술과 행동을 숫자로 변환하는 데 한계가 있다는 지적을 받아왔습니다(Cate & Regehr, 2019; Driessen et al., 2005; Epstein & Hundert, 2002; Hodges, 2006, 2013; Schuwirth & Van der Vleuten, 2006). 이러한 한계를 부분적으로 해결하기 위해 [학습을 위한 평가] 그리고 [학습으로서의 평가]를 지원하는 프로그램 평가와 같은 대안적 접근 방식이 개발되었습니다. 프로그램적 평가는 의도적으로 선택된 여러 평가 과제를 사용하여 각각 일정 기간 동안 결합된 의미 있는 데이터를 생성함으로써 다양한 역량 결과 영역에서 학습자의 진행 상황에 대한 풍부하고 종적인 삼각형 정보의 흐름을 생성할 수 있습니다(Van der Vleuten & Schuwirth, 2005). 학습자에 대한 정보는 수집(종단적), 대조(삼각 측량) 및 연결(정보의 질)되어 해당 정보의 의미에 대한 의사 결정이 평가자의 전문적 판단과 일치하도록 합니다. 이를 통해 프로그래밍 방식 평가는 학습을 위한 평가, 학습으로서의 평가, 학습에 대한 평가 간의 균형을 촉진합니다. (Dannefer, 2013; Driessen 외., 2012; Khanna 외., 2021).

There can be several problems when reforming traditional assessment of learning to a program which encompasses assessment for and as learning. Traditional approaches to assessment systems which emphasise summative high-stakes decision making, have been challenged for their limitations in converting complex human skills and behaviours to numbers (Cate & Regehr, 2019; Driessen et al., 2005; Epstein & Hundert, 2002; Hodges, 2006, 2013; Schuwirth & Van der Vleuten, 2006). Partly to address these limitations, alternate approaches such as programmatic assessment have been developed that support assessment for and as learning. By using purposefully selected multiple assessment tasks, each generating its own meaningful data combined over a period of time, programmatic assessment allows for the creation of an abundant and longitudinal flow of triangulated information about a learner's progress in various competency outcome areas (Van der Vleuten & Schuwirth, 2005). Information about learners is collected (longitudinally), collated (triangulation), and connected (quality of information), so that decision making about the implications of that information is aligned with the professional judgement of assessors. In doing this, programmatic assessment promotes a balance between assessment for, as and of learning. (Dannefer, 2013; Driessen et al., 2012; Khanna et al., 2021).

개혁을 도입하고 보고할 때 교육자들이 직면하는 주요 과제이자 이 백서의 초점은 의과대학이 학습을 위한 평가 및 학습으로서의 평가 원칙에 동의하는 경우에도 기존의 전통적인 관행을 개혁하는 것이 어렵다는 것입니다(Driessen 등, 2012; Roberts 등, 2014; Dannefer, 2013; Torre 등, 2021). 여기에는 보건 전문가 교육 결과에 관심이 있는 이해관계자들에게 의미 있는 방식으로 변화를 촉진하고 평가하고자 하는 사람들에게 통찰력을 제공할 수 있는 복잡한 이유가 있습니다. 한 가지 이유는 다음 두 그룹 간의 의견 불일치일 수 있습니다.

- 학습자의 성과에 대한 기존의 '객관적', 구조화된 정량화를 평가에 유지하려는 사람들(Swanson & Roberts, 2016)과

- 임상 역량에 대한 새로운 개념을 고려한 체계적인 접근 방식을 장려하는 사람들(Driessen et al., 2012; Schuwirth & Van der Vleuten, 2011)

When introducing and reporting reforms, a major challenge for educators, and the focus of this paper, is that medical schools have found it difficult to reform pre-existing traditional practices, even where there is agreement with the principles behind assessment for and as learning, (Driessen et al., 2012; Roberts et al., 2014; Dannefer, 2013; Torre et al., 2021). There are complex reasons for this which may provide insights for those wishing to promote and evaluate change in a way that is meaningful to stakeholders interested in health professional education outcomes. One reason might be disagreement between

- those who wish to retain the traditional ‘objective’, structured quantification of learners’ performances to assessment (Swanson & Roberts, 2016) and

- those promoting a systemic approach that take into account newer conceptions of clinical competence (Driessen et al., 2012; Schuwirth & Van der Vleuten, 2011).

이 백서에서 논의한 바와 같이, 의료 전문가 교육 내에서 평가 문화를 크게 변화시키는 데 중요한 요소를 조명할 수 있는 방법론을 개발하는 데 있어 교육자를 안내할 수 있는 출판된 문헌은 거의 없습니다. 이 백서에서는 이론에 기반한 접근 방식을 취하여 평가 실무에서 주요 개혁을 실행하고 평가하려는 사람들을 지원하기 위한 몇 가지 핵심 원칙과 방법론적 접근 방식을 제안합니다.

As we discuss in this paper, there is little published literature to guide educators in developing methodologies that might illuminate significant factors in making major changes to the culture of assessment within healthcare professional education. In this paper, we take a theoretically informed approach to propose some key principles and a methodological approach to support those considering implementing and evaluating major reform in assessment practice.

표면적으로는 학습 평가에 대한 전통적인 접근 방식과 평가의 의사 결정 및 학습 기능을 통합하는 새로운 접근 방식(Schut et al., 2021)의 차이점은 방법론적인 것으로 보입니다. 이는 부분적으로는 평가 관행의 기본 프레임워크와 품질을 확립하는 데 사용되는 타당성 제안의 차이 때문일 수 있습니다.

- 구조화된 임상 평가의 객관성이 고부담 평가의 특징이 된 이후(Newble & Swanson, 1988), [전통적인 평가 접근법]은 의과대학 평가 관행을 안내하는 데 큰 영향을 미쳐 왔습니다.

- 이 방식을 옹호하는 사람들은 공정성 문제를 해결하는 동시에 측정 오류를 줄임으로써 학생의 임상 역량에 대한 고품질 시험의 타당성과 신뢰성을 확립할 수 있다고 주장합니다. (Clauser 외, 2006; Norcini 외, 2018)

- [학습의 평가]는 미래의 성과를 예측할 수 있다고 가정하는 [선형 동적 과정]으로 생각됩니다.

- '공정성'은 평등의 관점에서 다루어지며, 모든 응시자는 동일한 표준화되고 구조화된 테스트 프로세스를 적용받습니다. (AERA, 2014)

- 검증된 평가 도구는 상황, 문화 또는 관련된 사람에 관계없이 일반화하거나 다른 환경으로 이전할 수 있는 것으로 간주됩니다.

On the surface, the differences between traditional approaches to the assessment of learning and newer approaches that integrate the decision-making and learning functions of assessment (Schut et al., 2021) appear to be methodological. In part this may be due to differences in the validity propositions used to establish the underlying frameworks and quality of assessment practices.

- Since the objectivity of structured clinical assessments became the hallmark of high stakes assessment (Newble & Swanson, 1988) traditional approaches to assessment have been highly influential in guiding medical school assessment practice. Advocates claim that the validity and reliability of high quality testing of the clinical competence of students is established by reducing errors of measurement, at the same time as addressing fairness. (Clauser et al., 2006; Norcini et al., 2018)

- The assessment of learning is thought to be a linear dynamic process which is assumed to be predictable of future performance.

- ‘Fairness’ is addressed from a perspective of equality; all candidates are subject to the same standardised and structured testing processes. (AERA, 2014)

- Validated assessment tools are assumed to be generalisable or transferable to other settings regardless of context, culture, or persons involved.

반면에 프로그램적 평가를 지지하는 사람들은 [복잡한 비선형 시스템 접근 방식]을 취하여 임상 역량 개념에 더 잘 부합하는 평가 접근 방식을 강조합니다.

- 이러한 복잡성 관점에서는 역량이 다면적인 것으로 간주되며 단일 수치 결과로 표현하기 어렵습니다. 대신 역량은 문제 공간의 경계를 넘나드는 민첩한 문제 해결에서 나타난다는 점을 인정합니다. 따라서 전문성, 팀워크, 전문가 간 협업과 같은 복잡하고 실용적인 기술을 포함하고 통합하도록 설계되었습니다(Khanna et al., 2021; Schuwirth & Van der Vleuten, 2020; Van der Vleuten et al., 2018).

- 학습을 위한 그리고 학습으로서의 평가는 평가 프로그램, 평가자 및 학생 간의 긴밀한 상호 작용을 가정합니다. (Schuwirth & Van der Vleuten, 2011, 2019; Van der Vleuten 외., 2012)

- 타당도는 전체 프로그램 내의 특정 목적에 따라 다양한 평가 도구를 신중하고 맞춤식으로 조합하는 것을 기반으로 합니다. (Schuwirth & Van der Vleuten, 2012).

- 공정성은 형평성의 관점에서 다루어지며, 모든 학습자가 동일한 품질의 평가를 받지만 그 과정은 맞춤형으로 이루어집니다. (Schuwirth & Ash, 2013) 검증된 평가 프로그램은 상황, 문화 및 관련 인원을 고려하여 다른 환경에 맞게 조정할 수 있습니다. (Valentine 외., 2021).

Advocates for programmatic assessment, on the other hand, take a complex non-linear systems approach, emphasising an approach to assessment that better aligns with concepts of clinical competence.

- In this complexity perspective, competence is seen as multifaceted and not amenable to being expressed by a single numerical outcome. Instead it accepts that competence manifests itself in agile problem solving withing the boundaries of a problem space. As such it is designed to include and integrate complex and practical skills such as professionalism, team work and interprofessional collaboration (Khanna et al., 2021; Schuwirth & Van der Vleuten, 2020; Van der Vleuten et al., 2018).

- Assessment for and as learning assumes a close interaction between the assessment program, the assessors, and the students. (Schuwirth & Van der Vleuten, 2011, 2019; Van der Vleuten et al., 2012)

- Validity is based on a careful and tailored combination of various assessment instruments depending on the specific purposes within the overall program. (Schuwirth & Van der Vleuten, 2012).

- Fairness is addressed from a perspective of equity; all learners receive the same quality of assessment, but the processes are tailored. (Schuwirth & Ash, 2013)

- Validated programs of assessment can be adapted to other settings taking account of context, culture, and the people involved. (Valentine et al., 2021).

고전적 평가 관행과 프로그램적 평가 관행을 옹호하는 사람들 사이의 의견 차이는 종종 [철학적 수준에서 평가와 학습 간의 관계에 대한 확고한 신념과 서로 다른 구성]에 있습니다(Torre et al., 2020).

- 전통적인 평가 관행은 [학습하는 사람]과 [평가받는 사람]의 경험을 분리하는 경험주의적 인식론에 기반을 두고 있으며(Adie 외, 2018), 따라서 학습자는 '측정의 대상'이 됩니다.

- 학습을 위한 그리고 학습으로서의 평가를 옹호하는 접근 방식에서 평가 프로그램의 설계는 학습 및 커리큘럼 품질 보증을 최적화하기 위한 것입니다. (Van der Vleuten 외., 2015) 평가는 학습자가 평가와 학습을 경험하는 동안 자신의 행동을 선택할 수 있는 능력을 포함하여 학습자의 주체성을 촉진하는 쌍방향 대화입니다(Meeuwissen 외., 2019; Schut 외., 2018, 2020).

- 전통적인 접근 방식에서는 평가가 학생에게 수행되는 반면,

프로그램적 평가에서는 학생과 함께 평가가 수행됩니다.

The differences in opinion between advocates of classical and programmatic assessment practices often also lies in firmly held beliefs and differing constructions of the relationship between assessment and learning at a philosophical level (Torre et al., 2020).

- Traditional assessment practices are based on an empiricist epistemology that separates the experience of the person-as-learning from the person-as-being assessed (Adie et al., 2018) and therefore learners become an ‘object of measurement’.

- In approaches that advocate assessment for and as learning, the design of an assessment program is intended to optimise learning and curriculum quality-assurance. (Van der Vleuten et al., 2015) Assessment is a two-way dialogue promoting learners’ agency including their ability to make choices in their actions during their experience of assessment and learning (Meeuwissen et al., 2019; Schut et al., 2018, 2020).

- In the traditional approach, assessment is done to the students while

in programmatic assessment, assessment is done with the students.

이러한 대조는 평가 분야의 평가 및 연구에 시사점을 주는데, 연구자들은 평가 실행과 같은 복잡한 사회 현상을 고려한 이론적 관점과 이를 뒷받침하는 연구 패러다임 및 이론을 설명할 필요가 있습니다(Roberts et al., 2020).

- [학생을 대상으로] 평가가 이루어지는 연구에서는 일반적으로 맥락, 문화, 사람 및 이들 간의 상호 작용과 같은 요소와 무관하게 "무엇이 효과가 있는가"라는 질문을 던집니다. 이는 평가 도구의 고유한 가치와 타당성을 파악하고자 합니다(Cronbach & Meehl, 1955; Downing, 2003; Messick, 1995).

- [학생과 함께] 평가를 실시하는 경우 "무엇이 효과가 있는가"라는 질문만으로는 충분하지 않습니다. 대신 "무엇이, 누구에게, 어떤 맥락에서, 그리고 가장 중요한 것은 왜 효과가 있는가"와 같은 보다 복잡한 질문이 더 적절합니다.

This contrast has implications for evaluation and research in the field of assessment, where researchers need to explain the theoretical lens through which they have considered complex social phenomena like assessment practice, including the underpinning research paradigm and theory (Roberts et al., 2020).

- Research where assessment is done to the students typically asks the question “what works” independently of the factors such as context, culture, and people and the interactions between them. It seeks to tease out the unique value and validity of the assessment instrument (Cronbach & Meehl, 1955; Downing, 2003; Messick, 1995).

- Where assessment is done with the students, the question of “what works” is not enough. Instead, more complex questions such as “what works, for whom, in which context and, most importantly, why” are more appropriate.

이론적 프레임워크

Theoretical framework

이러한 질문은 이러한 현상에 대한 비판적 현실주의적 평가의 전형적인 예입니다(Ellaway 외., 2020).

- 비판적 현실주의 관점에서 평가는 특정 사회 구조 내에서 목적과 기능을 정의할 수 있는 관행으로 볼 수 있습니다(Delandshere, 2001).

- 평가 관행을 뒷받침하는 구조를 탐구하는 것은 바스카의 현실주의적 분석을 통해 도움이 될 수 있습니다. (Bhaskar, 1978; Bhaskar 외., 2018; Groff, 2004)

- 경험적(경험),

- 실제적(사건),

- 실재적(인과 구조 및 메커니즘) 수준을 구분한

- 인과적 구조와 메커니즘은 실재적이며 그것이 생성하는 사건의 패턴과 구별되며, 이는 다시 그것이 포착되는 경험과는 구별됩니다.

- 현실에 대한 바스카의 광범위한 설명의 주요 응용 분야 중 하나는 의료 환경과 같은 복잡한 시스템에서 현실주의 프로그램 평가의 현대적 접근 방식으로 이어졌습니다. 현실주의 평가는 주로 개입의 효과 여부가 아니라 '무엇이, 누구에게, 어떤 상황에서, 어떻게 효과가 있는가'라는 질문을 해결하기 위해 맥락-기제-결과 구성을 이해하는 데 중점을 둡니다(Dalkin 외., 2015).

- 현실주의적 접근법은 '생성적' 인과관계 이론에 기반합니다. 즉, 상황을 변화시키는 것은 프로그램이 아니라, 프로그램에 노출되었을 때, 주어진 메커니즘을 활성화하고 변화를 일으키는 것은 [맥락에 내재된 사람]입니다(Pawson et al., 1997).

Such questions are typical examples of a critical realist evaluation of such a phenomenon (Ellaway et al., 2020).

- From a critical realist perspective, assessment can be viewed as a practice whose purpose and functions can be defined within particular social structures (Delandshere, 2001).

- Exploring the structures that underpin assessment practice can profit from Bhaskar’s realist analysis of the distinction between the level of

- Causal structures and mechanisms are real and distinct from the pattern of events they generate, which in turn are distinct from the experiences in which they are captured.

- One of the key applications of Bhaskar’s extensive account of reality has led to the contemporary approach of realist program evaluation in complex systems such as healthcare settings. Realist evaluation is primarily concerned with understanding the context-mechanism-outcome configuration to address the question, 'what works, for whom, under what circumstances, and how' as opposed to whether an intervention works or not (Dalkin et al., 2015).

- The realist approach is based on a ‘generative’ theory of causality: it is not programs that make things change, it is people, embedded in their context who, when exposed to programs, do something to activate both given mechanisms and change (Pawson et al., 1997).

학생의 학습 및 평가에 대한 구조적 요인의 영향을 이해하는 것뿐만 아니라 개별 학생의 주체성과 학습에서 선택할 수 있는 개인적 권한을 어떻게 행사할 수 있는지를 고려하는 것이 중요합니다(Kahn, 2013). 교사도 마찬가지입니다. 아처는 [사회 구조]와 [인간의 주체성] 간의 상호작용을 설명하기 위해 이러한 프레임워크를 제공합니다(Archer, 2000; 2003). [학습자의 주체성]은 기본적인 자아 감각에서 시작하여 프로그램에 참여하는 과정을 통해 발전하며 미래의 실무자가 되기 위한 기본 요소입니다. 에이전시를 설명하려면 [시간에 따른 구조와 에이전시 간의 복잡한 상호작용]을 포함해야 합니다(Archer, 2000, 2002; Priestley 외., 2015). Archer의 '형태 발생적' 접근법(Archer, 1982)에 따르면 학습자가 사회적, 실제적, 자연적 세계와 상호작용할 때 행위자성의 변화가 나타납니다. 개인이 교육 프로그램에 대한 누적된 경험에 반응하고 물질적, 사회적 조건이 변화함에 따라 행위자성의 변화는 긍정적이거나 부정적일 수 있습니다. 아처의 이론은 고등 교육 분야(Ashwin, 2008; Case, 2015; Leibowitz 외, 2012), 전문직 간 보건직업 교육(Hutchings 외, 2013), 의학교육에서 교육자가 소그룹 교육을 통해 전문성을 증진하는 방법을 조사하기 위해 광범위하게 사용되어 왔습니다(Kahn, 2013).

As well as understanding the influences of structural factors in student learning and assessment, it is important to consider the agency of individual students and how they might exercise their personal powers to make choices in their learning (Kahn, 2013). Similarly with teachers. Archer provides such a framework that seeks to account of the interplay between social structure and human agency (Archer, 2000; 2003). Learner agency develops from a basic sense of self through a process of engagement with programs and is fundamental to becoming a future practitioner. Explanation of agency must include the complex interplay between structure and agency over time (Archer, 2000, 2002; Priestley et al., 2015). In Archer’s ‘‘morphogenetic’’ approach (Archer, 1982) changes in agency emerge as a learner interacts with the social, practical and natural worlds. Change in agency may be both positive and negative as individuals respond to their cumulative experience of the educational program and as their material and social conditions evolve. Archer’s theory has been used extensively in the higher educational field (Ashwin, 2008; Case, 2015; Leibowitz et al., 2012), in interprofessional health professions education (Hutchings et al., 2013) and in medical education in order to investigate how educators develop their practice to promote professionalism through small group teaching (Kahn, 2013).

우리는 프로그램적 평가를 도입하는 복잡한 개입이 여러 환경에서 작동하여 무엇이, 어떻게, 누구를 위해, 어떤 맥락에서 작동하는지에 대한 유용한 통찰력을 제공할 수 있는 방법을 고려하고자 했습니다. 우리의 비판적 현실주의 접근법은 다음의 상호 작용을 탐구함으로써 평가 시스템 개혁에 영향을 미치는 조건의 복잡성을 해결하고자 합니다.

- 평가 구조(학생에게 수행되는 평가를 제한하거나 가능하게 하는 규칙 및 리소스)와

- 학습자 주체성(학생과 교직원이 평가가 어떻게 학생과 함께 수행되었는지에 대한 의견을 제시하는 곳)

We wished to consider the ways in which the complex intervention of introducing programmatic assessment might work across multiple settings to provide useful insights of what works, how it works, for whom, and in what contexts. Our critical realist approach seeks to address the complexity of conditions that influence reforming of assessment systems by exploring the interplay of

- assessment structures (rules and resources that constrain or enable assessment that is done to students) and

- learner agency (where students and staff have input into how assessment is done with them).

우리의 중심 질문은 "기존 평가가 학습에 대한 전통적인 총괄 평가였던 의학 또는 보건 과학 프로그램에서 프로그램 평가 관행의 번성을 뒷받침하는 몇 가지 중요한 요소는 무엇인가?"였습니다.

Our central framing question was “What are some critical factors that underpin the flourishing of programmatic assessment practices in a medical or health science program where pre-existing assessment has been traditional summative assessments of learning?”.

방법

Methods

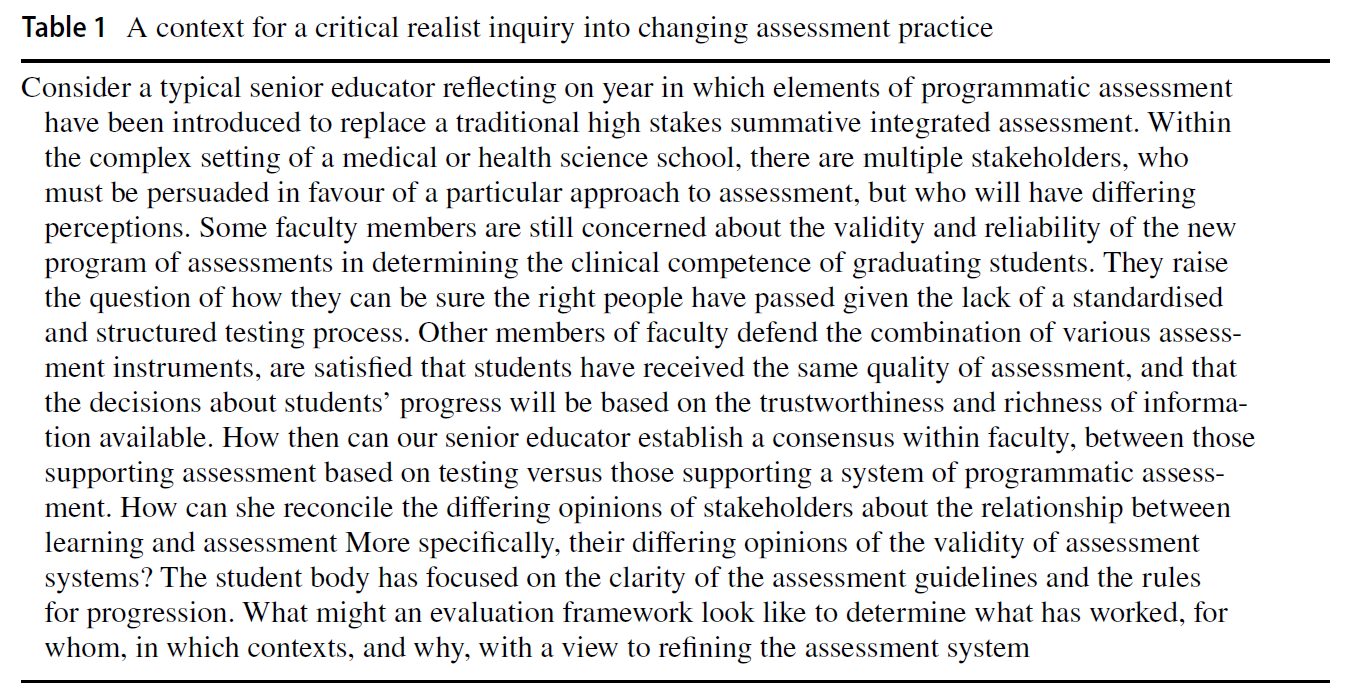

구조와 기관의 문제로서 평가 개혁에 관한 프로젝트의 맥락을 제공하기 위해, 우리는 기존 평가 시스템을 개혁하고 평가를 계획하는 한 의과대학의 전형적이지만 익명으로 처리된 비넷을 개발했습니다. 이 그림은 저자들의 평가 개혁에 대한 국제적 경험을 바탕으로 작성되었습니다. (표 1 참조).

In order to provide a context for our project on assessment reform as a problem of structure and agency, we developed a typical but anonymised vignette of a medical school undergoing reform in its traditional assessment system, and planning an evaluation. The vignette is based on the authors’ international experience of assessment reform. (See Table 1).

평가 관행과 기관 간의 관계에 대한 우리의 프레임 질문을 다루기 위해, 우리는 헌신적인 개인의 반사성의 특징적인 측면, 즉 프로그램 평가의 측면을 구현할 때 궁극적인 관심사의 본질과 순서를 파악하기 위해 Archer가 개발한 이론에 대한 비판적 현실주의적 접근 방식을 수정했습니다(Archer, 2000, 2007). 처음 두 저자는 다른 저자들과 개별적인 개방형 질문 토론을 진행하면서 평가와 학습에 대한 서로 다르지만 광범위한 이론적, 경험적 경험들 사이에서 반사성을 장려했습니다.

- 토론은 첫째, 프로그램적 평가를 도입하고 유지하는 데 있어 근본적인 문제를 규명하는 것으로 시작되었습니다.

- 둘째, 잠재적인 기본 메커니즘에 대한 통찰력을 제공한 프로그램 평가의 주요 논문에 대한 해석을 논의하고,

- 셋째, 세 개의 다른 기관에서 프로그램 평가의 구현을 설계하고 평가한 저자의 경험을 반성했습니다.

각 회의에 대한 자세한 메모가 작성되었습니다. 첫 번째 저자들은 새로운 주제를 도출하고 이를 수집 및 정리하여 추가 논의를 위해 그룹에 다시 제시했습니다. 이러한 반복적인 과정을 통해 합의에 도달하고 관련 문헌과 저자들의 전문가적 입장을 모두 담아낸 주제를 더욱 구체화할 수 있었습니다. 이 연구에서는 기관 윤리를 요구하지 않았습니다.

In order to address our framing question about the relationship between assessment practices and agency, we modified a critical realist approach to theory developed by Archer in order to tease out characteristic aspects of reflexivity in committed individuals, about the nature and order of their ultimate concerns in implementing aspects of programmatic assessment (Archer, 2000, 2007). The first two authors held extended individual open-ended questions discussions with the other authors, encouraging reflexivity amongst our differing but extensive theoretical and empirical experiences of assessment and learning.

- The discussions began with first, elucidating the fundamental issues in introducing and sustaining programmatic assessment.

- Second, discussing interpretations of key papers in programmatic assessment that gave insight into potential underlying mechanisms, and

- third reflecting on the author experience of designing and evaluating implementations of programmatic assessment across three different institutions.

Detailed notes were made of each of the meetings. The first authors drew out emergent themes which were captured and collated and presented back to the group for further discussion. Through this iterative process, we were able to reach a consensus and further refine the themes that captured both the pertaining literature and the expert positions of the authors. We did not require institutional ethics for this study.

연구 결과

Findings

프레이밍 리얼리즘 질문과 관련하여, 우리는 비판적 리얼리즘 관점에서 의료 또는 보건 과학 프로그램에서 새로운 평가 관행을 구현하는 맥락에서 네 가지 주제를 도출했습니다. 이는 다음과 같습니다:

In relation to our framing realist question, we drew out four themes in the context of implementing new assessment practices in a medical or health science program from a critical realist perspective. These were:

- 1. 학습자의 적극적 참여와 주체성 활성화.

- 2. 논증적 타당성에 중점을 둔 타당성 프레임워크 구축.

- 3. 통합된 프레임워크 내에서 의도적이고 다양한 평가 과제를 설계합니다.

- 4. [평가 규칙의 구조]와 [학습자 주체성] 간의 관계를 더 잘 이해할 수 있도록 공유된 내러티브를 일관되게 사용합니다.

- 1.Enabling positive learner engagement and agency.

- 2.Establishing validity frameworks that are oriented on argumentative validity.

- 3.Designing purposeful and eclectic assessment tasks within an integrated framework.

- 4.Developing consistent use of a shared narrative to provide a better understanding of the relationship between the structure of assessment rules and learner agency.

학습자의 긍정적인 참여 및 자율성 지원

Enabling positive learner engagement and agency

이 주제에서는 평가 관행을 변경할 때 학습자의 자율성을 향상하기 위해 무엇이 어떻게 작용할 수 있는지에 대한 관점에서 구조와 자율성 간의 상호 작용에 대해 설명합니다. [구조]는 [행동을 가능하게 하거나 제약할 수 있는 규칙 및 리소스]로 구성되며, 일부 구조적 특성은 다른 구조적 특성보다 변경하기가 더 어렵습니다. (Archer, 1982) 평가에서 학습자 주체성은 학습자를 선택을 하는 행위자로 인정하며, 학습자의 행동은 예상된 방식과 예상치 못한 방식으로 평가 관행을 형성합니다. (Adie 외., 2018).

This theme describes the interplay between structure and agency from the perspective of how and what might work to enhance learner agency when changing assessment practice. Structure consists of the rules and resources that may enable or constrain action, with some structural properties being more challenging to change than others. (Archer, 1982) Learner agency in assessment acknowledges learners as actors who make choices, and whose actions shape assessment practices in both anticipated and unexpected ways. (Adie et al., 2018).

[행위자성에 영향을 미치기 위해 평가를 재설계하는 것]은 교육 시스템 내의 모든 평가, 특히 널리 사용되는 고부담 총점 평가의 배경을 고려하여 고려해야 합니다. (Cilliers 외., 2010; Harrison 외., 2015, 2017). 개혁을 실행할 때 교수진이 새로운 평가 접근법을 통해 학습자가 참여할 수 있는 기회를 수용하면 구조와 학습자 주체 사이의 역학 관계가 바뀔 것입니다(Adie 외., 2018).

Re-designing assessment to influence agency has to be considered against the backdrop of all assessment within the educational system, particularly the prevailing high-stakes summative assessments. (Cilliers et al., 2010; Harrison et al., 2015, 2017). In implementing reform, the dynamic between structure and learner agency will change where faculty embraces opportunities for learners to engage (Adie et al., 2018) with new assessment approaches.

[교사-학습자 관계의 특성] 또한 학습자 에이전시의 중요한 특징입니다. (Schut 외., 2021), 특히 [교사의 평가 신념](Meeuwissen 외., 2019)에 영향을 미칩니다. 교사가 커리큘럼 변화에 가져올 수 있는 신념, 가치 및 속성은 교사가 주체성을 달성할 수 있는 정도에 영향을 미칩니다(Priestley 외., 2012). 객관식(MCQ)(Haggerty, 1918)과 OSCE(Harden & Gleeson, 1979)가 지배적인 평가 관행 문화에서 교사가 사회화되어 온 방식은 보다 미묘한 평가 이론을 개발하는 데 있어 교사의 주체성을 제약할 수 있습니다(Vosniadou, 2014; Vosniadou 외., 2001). 교수개발은 교사의 주체성을 개발하고 학습 문화에 프로그램 평가에 대한 공유된 이해를 포함시키는 데 중요합니다. (Bok et al., 2016; Driessen et al., 2012; Schut et al., 2021)

The nature of teacher-learner relationships is also an important feature of learner agency. (Schut et al., 2021) and in particular the assessment beliefs of teachers (Meeuwissen et al., 2019). The beliefs, values and attributes that teachers can bring to curriculum change impacts the extent to which they are able to achieve agency (Priestley et al., 2012). The ways in which teachers have been socialised in a culture of assessment practice dominated by multiple choice questions (MCQ) (Haggerty, 1918) and the OSCE, (Harden & Gleeson, 1979) can constrain their agency in developing a more nuanced theory of assessment (Vosniadou, 2014; Vosniadou et al., 2001). Faculty development is important in developing teacher agency and embedding a shared understanding of programmatic assessment in the learning culture. (Bok et al., 2016; Driessen et al., 2012; Schut et al., 2021)

그러나 학생은 평가 및 학습 참여를 유도하고 지원하는 다양한 상황적 요인을 경험할 가능성이 높습니다(Billett, 2001).

- Heeneman 등(2015)은 관찰 및 피드백을 위한 작업장의 특성에 따라 학습자의 주체성에 미치는 영향이 달라질 수 있다고 지적합니다.

- 학습자가 이해하지 못하거나, 학습의 이득에 비해 너무 복잡하거나, 업무량이 너무 많아 학습자의 주체성에 도전하는 평가 과제는 학습에 부정적인 영향을 미칠 수 있습니다(Cilliers et al., 2010).

- 학습자의 주체성은 학습자가 평가 과제를 부담스러운 것으로 인식하는 경우에도 방해받을 수 있지만, 예를 들어 교사가 안전하고 신뢰할 수 있는 평가 관계에서 학습자의 주체성을 촉진함으로써 강화될 수 있습니다(Schut et al., 2020).

However, students are likely to experience differing situational factors that invite and support their engagement in assessment and learning (Billett, 2001).

- Heeneman et al., 2015 also note the differences in characteristics of the workplace for observation and feedback, leading to differing impacts on learner agency.

- Assessment tasks that challenge learners’ sense of agency by virtue of not being understood or too complex or too great a workload for the gain in learning may have a negative impact on learning (Cilliers et al., 2010).

- Learner agency may be also hindered by learners' perceptions of assessment tasks as high stakes but can be empowered, for example, by teachers promoting learner agency in safe and trusting assessment relationships (Schut et al., 2020).

그럼에도 불구하고 학습자가 평가 설계에 적극적으로 참여할 수 있는 권리에는 책임이 수반됩니다. 학습자는 체계적인 평가의 표준과 규범, 특정 측정 방법, 학습 목표 및 달성해야 할 역량 간의 관계를 존중해야 합니다. 프로그램 평가의 원칙에 대한 학생 오리엔테이션과 개별 학생 및 학생 단체와의 지속적인 커뮤니케이션을 통해 상당한 학습자 개발이 필요합니다.

Notwithstanding, the right for learners to be actively involved in assessment design comes with responsibilities. Learners must respect the standards and norms of systematic assessment and the relation between specific measurement methods, learning goals and the competencies to be achieved. Significant learner development will be needed with student orientation to the principles of programmatic assessment and ongoing communication with the individual students and the student body.

[학습 멘토 시스템]과 같이 학습자 행위자성을 지원할 수 있는 평가 구조에 새로운 리소스를 재할당하거나 제공하는 것도 고려해야 합니다(Schut et al., 2018). 전통적인 평가 실행 구조는 대규모 객관적 구조화 임상 시험(OSCE)과 서면 문제 은행을 실행하는 데 상당한 리소스를 필요로 합니다. 프로그래밍 방식의 평가는 맞춤형 소프트웨어인 e포트폴리오에서 보다 의미 있고 확실한 평가를 수집하고 대조하는 데 리소스가 필요할 수 있습니다(Driessen et al., 2007).

Consideration needs to be given to reallocating or providing new resources to those assessment structures which might support learner agency such as a learning mentor system (Schut et al., 2018). Traditional assessment practice structures require significant resource in running large-scale Objective Structured Clinical Examinations (OSCEs) and written question banks. Programmatic assessment might require resources to collect and collate more meaningful and authentic assessments in customized software; the ePortfolio (Driessen et al., 2007).

요약하면, 학습자 주도성을 촉진하기 위한 전략에는 [학습자와 함께] 평가가 이루어질 수 있도록 [평가 구조를 변경하는 것]이 포함됩니다. 변화의 주요 장벽은 교사와 학생이 기존의 평가 구조에서 벗어나 프로그램 평가에 유리한 조건을 제공하는 새로운 구조로 전환하는 것일 수 있습니다. 교수자가 평가 관행을 변경하는 경우, 학생은 학습 기회를 극대화하기 위해 적극적으로 참여할 책임이 있습니다. 학습자의 주체성을 촉진하기 위해 평가에 대한 리소스를 재할당해야 할 수도 있습니다. 이 시나리오에서 평가 관행의 구조를 변경하면 학습자의 주체성에 복잡한 영향을 미칠 수 있습니다. 동시에 학습자의 주체성을 촉진하려면 평가 구조의 변화가 필요합니다.

In summary, strategies to promote learner agency involve changing assessment structures so that assessment is done with learners. Major barriers to change may be the socialization of teachers and students away from pre-existing structures of assessment into newer structures that provide favourable conditions for programmatic assessment. Where faculty does change assessment practice, students have responsibilities to be active in maximizing their learning opportunities. Resources for assessment may need to be reallocated to promote learner agency. In our scenario, changing the structure of assessment practice will have complex impacts on learners’ agency. At the same time, promoting learner agency would require a change in the structure of assessment.

타당도 프레임워크 구축

Establishing validity frameworks

이 주제에서는 논증 기반 프레임워크가 제공하는 구조가 교수자, 학생 및 인증 기관과 같은 외부 이해관계자 모두에게 프로그램식 평가의 타당성 주장을 명확하게 하는 방법을 설명합니다.

This theme describes how the structure provided by an argument-based framework might give clarity around the validity claims of programmatic assessment for both faculty, students, and external stakeholders such as accreditation bodies.

프로그래밍 방식 평가는 [학습을 위한 평가]를 촉진합니다. 학습의 평가에서는, 원하는 학습 결과의 범위를 나타내는 통합된 작업 모음에 대한 결정이 내려집니다(Van der Vleuten & Schuwirth, 2005) 전통적인 평가 관행에서는 학습에 대한 검증된 총합 평가를 준비한다는 측면에서, ['형성'이라는 용어]가 [학습을 위한 평가]를 의미하는 다양한 평가를 사용하는 경향이 있습니다. 이론적 관점에서 이러한 가정을 비판하는 광범위한 문헌이 있습니다. (Bennett, 2011).

Programmatic assessment promotes assessment for learning. For assessment of learning, decisions are made on an integrated collection of work representing a range of desired learning outcomes (Van der Vleuten & Schuwirth, 2005) Traditional assessment practice tends to use a variety of assessments where the term ‘formative” implies assessment for learning, in preparation for a validated summative assessment of learning. There is an extensive literature critiquing this assumption from a theoretical perspective. (Bennett, 2011).

교수자가 형성적 평가를 프로그램적 평가로 인식하는 경우에도, 학생은 평가가 진급progression 결정에 사용되는 경우 형성적 평가를 총괄적 평가로 인식합니다(Heeneman 외., 2015). 학습에 대한 평가에서 형성적/총괄적 평가가 무엇인지에 대한 이러한 혼란을 피하기 위해, 우리는 프로그램식 평가를 뒷받침할 수 있는 타당성에 대한 논증 기반 관점으로 전환합니다.

Students perceive formative assessment as summative if it is used for any progression decisions (Heeneman et al., 2015) even where faculty perceive the assessment as programmatic. To avoid this confusion about what is formative/summative in the assessment for and of learning, we turn to an argument-based view of validity that can underpin programmatic assessment.

케인의 프레임워크는 프로그램적 평가 관행에 대한 검증 프로세스와 의도적으로 선택된 증거 기반 평가 과제의 타당성에 신뢰성을 부여하는 데 중요한 역할을 할 수 있습니다. (Kane, 2013; Schuwirth & Van der Vleuten, 2012).

Kane’s framework can play a significant role in lending credibility to the validation process for programmatic assessment practice, and the validity of purposely chosen and evidence-based assessment tasks. (Kane, 2013; Schuwirth & Van der Vleuten, 2012).

타당도는 [시험의 속성]이 아니라 [시험 점수의 해석 및 사용 제안의 속성]입니다.

- 해석과 사용에 있어 타당성이 있고 적절한 증거에 의해 뒷받침되는 높은 타당도를 가진 것으로 간주됩니다.

- 해석과 사용에 있어 적절하게 뒷받침되지 않거나 증거에 의해 모순되는 것은 타당도가 낮은 것으로 간주됩니다. (Kane, 2013)

Validity is not a property of a test, but a property of the proposed interpretations and uses of test scores.

- Interpretations and uses that make sense, and are supported by appropriate evidence, are considered to have high validity.

- Those that are not adequately supported or are contradicted by evidence, are taken to have low validity. (Kane, 2013)

모든 이해관계자의 초점은 점수/측정/정보가 [의도한 결론을 도출하는 데 유효하게 사용될 수 있다]는 명제를 뒷받침할 수 있는 충분한 증거와 논리적 논거가 있는지에 있습니다. Kane의 주장에는 특정한 철학적 또는 이론적 제약이 없습니다(Schuwirth & Van der Vleuten, 2012). 타당성 논증을 구축하기 위한 케인의 조언에는 테스트 프로세스의 품질에 대한 구체적인 가설이나 테스트에 대한 구체적인 기법이 포함되어 있지 않습니다. 그는 평가 대상 구조의 본질에 대한 명확한 이론적 가정이 중요하며, 이해 관계자를 설득하기 위해서는 잘 논증된 일련의 추론이 필요하다고 조언합니다(Kane, 2013). 평가 프로그램에 사회적 관심사에 대한 고려가 포함된 경우, '사회적 명령으로서의 타당성'이 평가 전략에 포함될 수 있습니다(Marceau et al., 2018; St-Onge et al., 2017). 케인 프레임워크의 네 가지 추론 유형, 즉 채점, 일반화, 외삽, 결정 규칙은 [평가 실무에서 일상적으로 사용할 수 있는 이론적 발판]을 제공합니다. 관찰에서 점수, 목표 영역으로, 마지막으로 구성으로 이어지는 논증적 추론은 [추론의 계층]을 추가하여 타당성을 향상시킵니다. 평가 프로그램의 타당성을 입증하는 데에도 동일한 원칙을 사용할 수 있습니다.

The focus for all stakeholders is on whether there is sufficient evidence and a logical argument to support the proposition that the scores/measures/information it yields can be validly used to draw the conclusions it was designed to support. There are no specific philosophical or theoretical constraints on Kane’s argument, (Schuwirth & Van der Vleuten, 2012). Kane’s advice for building the validity argument does not include specific hypotheses about the quality of test processes or specific techniques for testing them. He advises that a clear theoretical assumption about the nature of the construct being assessed is important and that a well-argued series of inference is needed to convince stakeholders (Kane, 2013). Where the program of assessments includes consideration of societal concerns, then ‘validity as a social imperative’ can be embedded in the assessment strategy (Marceau et al., 2018; St-Onge et al., 2017). The four types of inferences in Kane’s framework, namely, scoring, generalisations, extrapolation, and decision rules, provide theoretical scaffolding for their everyday use in assessment practice. Argumentative inferences from an observation to a score, to target domain, and finally to construct, add layers of inferences to improve validity. The same principles can be used to establish the validity of programs of assessments.

평가 설계자는 평가의 맥락과 목적에 따라 주장arguments의 성격이 추론에 가장 적합한 이유를 명확하고 일관성 있게, 그리고 그럴듯하게 방어해야 할 책임이 있습니다. 논증 기반 타당도 프레임워크를 전체 평가 프로그램으로 확장하려면 학습을 위한 평가의 [이중적 성격]을 인식해야 합니다(Van der Vleuten & Schuwirth, 2005).

- 목표 역량을 평가하는 평가 프로그램의 경우, 채점 과정과 시험관 등급 생성에 일관된 원칙을 적용하여 평가 형식을 만들거나 조정할 때 주의를 기울여야 합니다. 이러한 평가는 단순히 완료/미완료, 만족/불만족 또는 등급을 매길 수 있습니다.

- 의도적으로 설계된 과제 모음에서 기대되는 성과는 목표 역량을 평가하는 데 사용될 수 있는 과제의 '유니버스'에 걸쳐 일반화할 수 있어야 합니다.

- 의미 있는 정보 삼각 측량을 통해 선택된 과제 모음과 그 평가 또는 서술적 피드백에서 외삽하는 것은 목표 역량 또는 다른 맥락에서의 향후 역량 성과를 측정하는 것이어야 합니다.

- 선택된 과제의 수집을 기반으로 한 의사 결정 프로세스의 견고성이 갖는 함의를 고려해야 합니다. 교수진 개발은

- 첫째, 개별 평가를 수행하고 피드백을 제공하는 방법에 대한 교사의 우려를 해결해야 합니다.

- 둘째, 의사 결정 과정, 진행 규칙, 적절한 교정 및 추가 평가 규칙에 대한 이해와 자신감의 수준을 높입니다.

The onus is with the assessment designer to clearly, coherently, and plausibly defend why the nature of the arguments are best suited for the inferences according to the context and purpose of the assessment. Extending an argument-based validity framework into the whole program of assessments also needs to recognise the dual nature of the assessment for learning (Van der Vleuten & Schuwirth, 2005).

- For programs of assessment to assess targeted competencies, care needs to be taken in creating or adapting assessment formats, by applying consistent principles on scoring processes and the generation of examiner ratings. These may be simple completed/not completed, satisfactory/unsatisfactory or graded.

- The expected performance across the purposively designed collection of tasks should be generalisable across the ‘universe’ of tasks that could have been used to assess the target competencies.

- Extrapolating from the collection of selected tasks and their ratings or narrative feedback through meaningful triangulation of information should be a measure of the target competencies, or future performance of competencies in a different context.

- Consideration needs to be given to the implications of the robustness of the decision-making process based on the collection of selected tasks. Faculty development will need to address teachers’ concerns about

- first; how to undertake individual assessment and give feedback.

- Second, increase the level of understanding and confidence in the decision-making processes, progression rules, and were appropriate remediation and further assessment rules.

케인은 평가 프로그램의 타당성 주장에 대한 엄격한 평가는 해석 사용 논증에서 [가장 약한 가정]이나 [고부담 결정을 뒷받침하는 가정]을 식별하고 우선순위를 정하는 것에서 시작해야 한다고 주장합니다. (Kane, 2013) 연구 결과는 평가 구조를 최적화하고, 교수자 개발을 개선하고, 학생의 학습 개발을 개선하는 데 다시 피드백될 수 있습니다.

Kane argues rigorous evaluation of the claims to validity of a program of assessments, should start by identifying and prioritising the weakest assumptions in the interpretation use argument or those that underpin high stakes decisions. (Kane, 2013) Findings can be fed back into optimising the structures of assessment, refining faculty development, and learning development of students.

요약하면, 논증 기반 타당도 프레임워크는 학생이 프로그램 평가를 위해 제시한 특정 정보 모음이 해당 학생의 진도 결정을 알리는 데 충분한 타당도를 가질 수 있는 방법과 이유를 명확하게 제공함으로써 교수자 및 학습자를 포함한 다양한 이해관계자에게 효과적일 수 있습니다.

In summary, an argument-based validity framework can work for a range of stakeholders including faculty and learners by providing clarity in how and why a particular collection of information presented by a student for programmatic assessment can have sufficient validity to inform progression decisions about that student.

목적이 있고 다양한 과제 설계

Designing purposeful and eclectic tasks

이 주제에서는 평가 시스템 구조와 학습자 기관 간의 교차점이 평가에 대한 다양한 접근 방식에 대한 일부 교수진의 순진함으로 인해 어떻게 영향을 받을 수 있는지에 대해 설명합니다.

- 첫째, 순진한 경험주의: 학습자에 대한 지식의 기초를 형성하는 절대적인 사전 이론적 관찰 및 경험이 있다는 믿음입니다.

- 둘째, 순진한 절충주의: 순전히 경험주의적이고 환원주의적인 접근 방식으로 평가 과제를 설계하거나 프로그램 내 관습 및 관행에 기반한 형식을 사용할 때 발생할 수 있습니다(Bhaskar 외., 2018).

This theme describes how the intersection between the structure of an assessment system and learner agency can be impacted by the naivety of some faculty in differing approaches to assessment.

- First, naïve empiricism: the belief that there are some absolute pre-theoretical observations and experiences which form the basis of knowledge about a learner.

- Second, naïve eclecticism (Bhaskar et al., 2018) which can arise when assessment tasks are designed on a purely empiricist and reductionist approach, or using formats based on custom and practice within the program.

좀 더 자세히 설명하자면, 학습자의 수행에 대한 '관찰'에 초점을 맞추면 평가 설계자가 순진한 경험주의, 즉 평가자의 평가가 오류 없이 절대적인 시험 점수를 제공할 수 있다는 생각으로 이어질 수 있습니다. 점수에 대한 지나친 강조는 학습자의 주체성을 해칠 수 있습니다. 숫자는 학습자의 성과에 대한 다양한 판단과 후속 학습을 개선하기 위한 피드백의 동화를 왜곡할 수 있습니다. 평가와 학습의 이론이 서로 어떻게 영향을 미치는지에 대한 최근의 검토에서 베어드 외, 2017은 평가의 이론적 근거는 불가지론적이라고 제안합니다.

To illustrate further, a focus on ‘observation’ of learner performances can lead to naïve empiricism by the assessment designer; the notion that an assessor’s rating can provide a person’s test score that is absolute and free from error. An overemphasis on scores can be detrimental to learner agency. Numbers can skew the assimilation of multiple judgements of a learner’s performances and the attendant feedback aimed at refining subsequent learning. In a recent review of how theories of assessment and learning influence each other, Baird et al., 2017 suggest that the theoretical basis of assessment is agnostic.

학습을 위한 평가와 학습을 위한 평가는 평가의 서로 다른 기능을 제시하는 서로 다른 방식으로 간주됩니다. 이러한 주장은 형성 평가와 총괄 평가의 맥락에서 Norcini 외., 2018에 의해 제기되었습니다. 평가에 대한 이러한 이론적 접근의 의도하지 않은 결과는 평가 설계자가 정책, 커리큘럼 및 측정 의무를 충족하는 과정에서 발생하는 실용적 및 측정 고려 사항이 우세하다는 것입니다. 순진한 절충주의의 의도하지 않은 결과는 이론적 근거에 기반한 가정 없이, 오직 실용적으로 평가 과제를 선택할 수 있으며, 이러한 과제의 집합으로서 학습자의 다양한 역량에 대한 학습자의 진도에 대한 정보의 종적 흐름을 제공하지 못할 수 있다는 것입니다(Van der Vleuten & Schuwirth, 2005).

Assessment for learning and of learning are seen as differing ways of presenting the different functions of assessment. This argument is taken up in the context of formative and summative assessment by Norcini et al., 2018. An unintended consequence of this atheoretical approach to assessment is the dominance of practical and measurement considerations arising from assessment designers meeting policy, curriculum, and measurement imperatives. An unintended consequence of naive eclecticism is that assessment tasks may be chosen pragmatically without theoretically informed assumptions, and which may, as a collection of tasks, fail to provide for longitudinal flow of information about a learner's progress in various competencies (Van der Vleuten & Schuwirth, 2005).

[평가 관행을 혼합하는 것]은 [이론]과 [실행의 실용성] 사이의 균형을 맞추기 위해 서로 반대되는 것처럼 보이는 평가 관행 사이의 긴장을 해결하는 한 가지 접근 방식입니다. 일반적으로 일부 학습 결과에는 전통적인 총괄 평가 요소를, 다른 학습 결과에는 프로그래밍 방식의 평가를 사용합니다. 안타깝게도 혼합형 평가 관행은 다양한 평가 과제의 중요성을 해석하는 타당성(Cook & Beckman, 2006)과 신뢰성(Driessen et al., 2012)을 둘러싸고 학습자와 교수진의 마음속에 긴장을 조성합니다. 가능한 경우 혼합 평가 관행을 피하는 것이 좋습니다.

Hybridising assessment practice is one approach to resolving the tension between seemingly opposing assessment practices to balance theory with the pragmatics of implementation. Typically, by having an element of traditional summative assessment for some learning outcomes and programmatic assessment for others. Unfortunately, hybridised assessment practices create tensions in the minds of learners and faculty, around the validity (Cook & Beckman, 2006) and trustworthiness (Driessen et al., 2012) of interpreting the importance of various assessment tasks. It is beneficial to avoid hybrid assessment practice where possible.

요약하면, 평가 구조를 설계할 때 교수자의 순진한 경험주의는 프로그램적 평가의 구현을 방해하고 학습자의 주체성과 학습을 위한 평가를 제약할 수 있습니다. 학생과 교수진 모두에게 효과적인 평가 시스템을 만들려면 평가 시스템을 의도적으로 설계해야 합니다. 필요한 역량을 다루기 위한 다양한 평가 과제의 필요성은 프로그램에 적합한 증거 기반 평가 과제를 의도적으로 선택하여 그 타당성을 확립함으로써 관리할 수 있습니다(Schuwirth & Van der Vleuten, 2012).

In summary, naïve empiricism from faculty in designing the structures of assessment can impede the implementation of programmatic assessment and constrain learner agency and assessment for learning. To make an assessment system work for both students and faculty, it must be purposefully designed. The need for an eclectic set of assessment tasks to address the required competencies is managed by establishing the validity of purposely chosen evidence-based assessment tasks appropriate to the program (Schuwirth & Van der Vleuten, 2012).

공유된 내러티브 개발

Developing a shared narrative

이 주제는 평가와 학습 간의 상호작용에 대해 서로 다른 생각을 가진 교육자 간의 격차를 해소하기 위한 공유 내러티브에 대한 합의가 부족하다는 점에 초점을 맞췄습니다. (웹스터-라이트, 2009).

This theme focussed on the lack of a consensus on a shared narrative to bridge the gap between educators holding differing ideas about the interplay between assessment and learning. (Webster-Wright, 2009).

우리는 [학습을 위한 평가]에서 중요한 두 가지 문제, 즉 비례성(평가의 지분)과 학생 학습에 대한 데이터의 삼각 측정을 논의함으로써 평가 관행을 개혁하는 데 있어 공유된 내러티브의 필요성을 설명합니다. 프로그램식 평가에는 [학습을 위한 평가]의 구조를 제공하고, 여기에는 기존의 총괄 평가와는 크게 다른 여러 가지 핵심 타당도 주장이 있습니다. 여기에는 다음이 포함됩니다(Dijkstra 외., 2012; Van der Vleuten 외., 2015).

- 비례성의 원칙,

- 피드백의 가치,

- 학습에 대한 평가와 학습을 위한 평가 간의 균형

We illustrate the need for a shared narrative in reforming assessment practice by discussing two issues that are important in assessment for learning: proportionality (the stakes of an assessment) and triangulation of data on student learning. In programmatic assessment, there are a number of core validity claims which provide a structure for assessment for learning, and which differ substantially from traditional summative assessment. These include

- the principle of proportionality,

- the value of feedback, and

- the balance between assessment of and assessment for learning (Dijkstra et al., 2012; Van der Vleuten et al., 2015).

[비례성]은 학습자의 진도에 대한 결정에 대한 이해관계가 정보의 신뢰성 또는 풍부함에 비례해야 한다는 것을 의미합니다. 프로그램 평가에서 형성적-총괄적 평가의 전통적인 이분법은 의사 결정의 이해관계에 따른 연속적인 평가로 대체됩니다(Schuwirth et al., 2017). 비판적 현실주의 관점에서 볼 때, 무엇이 누구에게 왜 효과가 있는지에 대한 실제 설명은 다소 다릅니다. 프로그램 설계자는 주로 평가의 구조, 즉 학습자 선택에 미치는 영향을 검토하지 않고 타당도 규칙을 다루는 것처럼 보입니다. 현재 프로그래밍 평가의 언어에서는 학습자 선택권을 최적화하기 위해 개별 평가에 "낮은 위험도" 또는 "중간 위험도"라는 라벨을 붙입니다. Schut 등(2018)과 Heeneman 등(2015)은 '낮은 위험도 평가'를 뒷받침하는 프로그램 설계자의 의도와 이러한 평가를 높은 위험도로 인식하는 학습자의 인식 사이에 불일치가 있음을 보여주었습니다.

Proportionality implies that the stakes of decisions about a learner’s progress should be proportional to the credibility or richness of information. The traditional dichotomy of formative-summative assessments in programmatic assessment is replaced with a continuum of assessments depending upon stakes of decisions (Schuwirth et al., 2017). From a critical realist perspective, the real explanation of what is working for whom and why is somewhat different. It would seem program designers mainly address the structure of assessment, i.e., the validity rules without examining impacts on learner agency. In the current language of programmatic assessment, individual assessments are labelled as “low stakes” or “medium stakes” to optimise learner agency. Schut et al. (2018) and Heeneman et al. (2015) have shown that there is a mismatch between program designers’ intentions underpinning ‘low stakes assessments,” and learners’ perceptions of these assessments as high stakes.

이로 인해 학습자가 평가 과제를 저부담, 중부담 또는 고부담으로 간주하는지 또는 위험도가 평가의 조합을 기반으로 한 판단 또는 진도 결정을 의미하는지에 대해 혼란을 야기할 수 있습니다. 프로그래밍 방식의 평가를 구현할 때 개별 평가 과제에 할당된 '부담'이라는 단어는 세 가지 문제를 야기합니다.

- 첫째, 평가에 '스테이크'가 부여되는 순간 학습자는 평가가 '합산'된 것으로 인식하여 의도한 교육 효과를 방해할 수 있습니다(Heeneman 외., 2015; Schut 외., 2018; Watling & Ginsburg, 2019).

- 둘째, 프로그램식 평가의 적용 가능성을 주로 의사 결정 또는 판단 목적으로 제한하고 평가의 학습 효과를 가려버립니다.

- 개별 과제에 '부담'을 할당할 때 의도하지 않은 세 번째 효과는 학습을 위한 평가의 [이중 목적]에 미치는 영향입니다. 학생은 저부담 과제를 작업량 측면에서 수행할 가치가 없는 것으로 인식하고, 고부담 과제로부터 주의를 분산시키는 과제일 뿐이어서, 학습 목적도 낮은 가치로 간주할 수 있습니다.

This leads to confusion as to whether students considered assessment tasks as low, medium, or high stakes, or whether the stakes refer to the judgment or progression decision based on the collation of the assessments. When implementing programmatic assessment, the ‘stakes’ assigned to individual assessment tasks leads to three issues.

- First, the moment ‘stakes’ are assigned to assessments, they are perceived as ‘summative’ by learners which may interfere with the intended educational effect (Heeneman et al., 2015; Schut et al., 2018; Watling & Ginsburg, 2019).

- Second, it limits the applicability of programmatic assessment mostly to the decision-making or judgemental purpose of assessments and eclipses the learning impact of assessment.

- A third and unintended effect of assigning ‘stakes’ to individual tasks is its impact on the dual purpose of the assessment for learning. Students may perceive a task with low stakes as not worth doing in terms of the workload and distracting them from tasks designated high stakes and inferring that the learning purpose of the task is also deemed as low value.

따라서 '부담'이라는 용어의 사용하는 것은 그 자체로 학생의 자율성에 부정적인 영향을 미칠 수 있으며, '위험도가 낮은' 과제에 대해 풍부한 피드백을 제공하는 등 교사의 자율성을 증진하는 데 거의 도움이 되지 않습니다.

Thus, counterintuitively the use of the term ‘stakes’ can have a negative effect on student agency, and do little to promote teacher agency in for example giving rich feedback for ‘low stakes’ tasks.

'스테이크'라는 용어는 학습 과제에 대한 개별 평가와 관련하여 사용하지 않는 것이 가장 좋으며, [학습의 평가]를 목적으로 제출된 작품 모음에 대한 의사 결정 및 진급 결정을 위해 유보되어야 한다.

The term ‘stakes’ is best avoided in relation to individual assessment for learning tasks, and reserved for the decision making and progression decisions on the collection of works submitted for the purpose of in assessment of learning.

평가 관행 개혁의 두 번째 사례는 [삼각 측량 개념]입니다.

- [전통적인 평가]에서 삼각 측량이란 프로그램에서 각 평가 요소의 최종 결과를 조합하는 것을 말합니다. 이러한 정보 결합 방식은 학생의 전반적인 역량에 대한 논증과 추론의 근거가 취약할 수 있습니다. 이 공식은 [결합 및 보상]과 같은 개념을 기반으로 합니다(Schuwirth & Van der Vleuten, 2012). 역량 기반 의학교육에서 결합과 보상의 개념은 논쟁의 여지가 있습니다. 예를 들어, 지식이 부족한 학생에게 의사소통을 잘하는 것이 충분한 보상이 될 수 있다고 주장할 수는 없습니다.

- [프로그램식 평가]에서는 평가 도구 간의 삼각 측정을 통해 학습자의 강점, 약점 및 진도에 대한 의미 있는 정보를 제공합니다. 기존 평가에서는 임상 검사에서 복부 검사 스테이션의 결과와 무릎 검사의 결과와 같이 동일한 형식이기 때문에 서로 다른 부분이 결합됩니다. 프로그래밍 방식 평가는 의미 있는 콘텐츠를 기반으로 삼각 측정을 추구한다는 점에서 근본적으로 다릅니다. 즉, 서로 다른 평가 도구의 일부가 의미 있게 결합되어 정보가 풍부한 내러티브로 이어질 수 있기 때문에 서로 삼각 측량됩니다.

Our second example of a shared narrative issue in assessment practice reform is the concept of triangulation.

- In traditional assessment, triangulation refers to a combination of the final results of each assessment element in the program. This way of combining information may provide a weak basis for argumentation and making inferences about the students’ overall competence. This formulation is based on notions such as conjunction and compensation (Schuwirth & Van der Vleuten, 2012). In competency-based medical education, the notions of conjunction and compensation are contentious; one cannot argue that for example, being a good communicator would be sufficient compensation for a student having insufficient knowledge.

- In programmatic assessment, triangulation across assessment instruments provides meaningful information about a learner’s strengths, weaknesses and progress. In traditional assessment different parts are combined because they are of the same format, e.g., the results on an abdominal examination station in a clinical examination with those on a knee examination. Programmatic assessment is fundamentally different in that it seeks triangulation based on meaningful content. This means that parts of different assessment instruments are triangulated with each other because they can be meaningfully combined leading to information-rich narratives.

또한 삼각측정은 단일 평가 형식, 단독 평가자, 단일 관점의 이론이나 모델의 한계를 극복합니다. 삼각측량과 삼각측량 수행 방법에 대한 명확한 규칙은 평가 프레임워크의 타당성 논증의 요소를 강화합니다. 이 평가 시스템에서 나오는 풍부한 정보 결과와 내러티브에 중점을 두면 [학습을 위한 평가]에 더 잘 적용될 수 있습니다. 동시에 삼각측량 과정의 종단적 특성과 풍부한 정보는 환자에게 임상의의 역량을 확신시켜야 하는 면허 취득 상황과 같은 고위험 학습 평가에 더욱 적합하게 만듭니다. (Norcini 등, 2018)

- 전통적인 시험에서는 각 역량 영역이 개별적으로 측정 가능한 구성 요소로 간주되는 반면,

- 프로그램적 평가에서는 [역량]이라는 [다면적인 현상에 대한 다양한 렌즈]로 간주되며, 각 영역은 서로 보완적인 역할을 합니다(Schuwirth & Van der Vleuten, 2012).

Moreover, triangulation overcomes the limitation of singular assessment formats, lone assessors, and single-perspective theories or models. Clear rules on triangulation and how it was performed, will enhance elements of the validity argument of the assessment framework. The emphasis on information-rich results and narratives that emerge from this system of assessment make it more applicable for an assessment for learning. At the same time, the longitudinal nature and the information richness of the triangulation process make it more defensible for high-stakes assessment of learning, for example the licensing context, where patients need to be assured of their clinician’s’ competence. (Norcini et al., 2018)

- Where in traditional testing, each competency domain is seen as a separately measurable construct,

- in programmatic assessment, they are seen as a variety of lenses on the multifaceted phenomenon of competence, and each is complementary to the other (Schuwirth & Van der Vleuten, 2012).

종단적 평가 정보가 쉽게 접근 가능하고 상호 참조할 수 있는 형식으로 제공되고, 소위 '저부담' 평가를 포함한 모든 평가에서 삼각측정이 학생의 전반적인 역량에 기여하는 것을 볼 수 있는 경우, 교사와 학생은 비례성과 삼각측량의 개념을 더 잘 이해할 수 있습니다. 이는 의사 결정을 지원하기 위해 학생들의 정보 모음을 시각화하는 데 기술을 사용하는 것과 관련이 있습니다.

The concepts of proportionality and triangulation are more likely to be appreciated by teachers and students where longitudinal assessment information is in an easily accessible and cross-referential format and the contribution of triangulating across all assessment including so-called ‘low stakes’ assessments can be seen contributing to the overall capabilities of the students. This relates to the use of technology in visualising collections of astudents’ information to support decision-making.

요약하면, '스테이크' 및 '평가의 삼각 측량'과 같은 [주요 용어의 정의]에 대한 아이디어를 공유하면 교육자가 평가와 학습의 상호 작용을 더 잘 이해하고 다양한 평가 관행의 언어에 대한 유창성을 개발하는 데 도움이 될 수 있습니다. 이러한 방식으로 교수진과 학생 모두 몇 가지 지침과 이론적 틀을 통해 평가 관행을 변화시킬 수 있는 역량을 강화할 수 있습니다. 교수자와 학습자는 아이디어를 공유해야만 학습자의 선택권을 부여하고 평가 관행의 구조를 어느 정도 통제할 수 있는 선택권과 조치를 취할 수 있습니다(Archer, 2003).

In summary, sharing of ideas about the definitions of key terms such as ‘stakes’ and ‘triangulation of assessment’ could help educators better appreciate the interplay of assessment and learning and develop fluency in the language of differing assessment practices. In this way both faculty members and students might be better empowered to change assessment practice with some guidelines and theoretical framing. Only through sharing their ideas can faculty and learners have the power to make choices and take action to privilege learner agency and develop a degree of control over the structure of assessment practice (Archer, 2003).

토론

Discussion

우리의 비판적 현실주의 질문은 새로운 평가 관행을 구현하고 평가하는 맥락에서 [평가 관행의 구조]와 [학습자 주체성] 간의 상호 작용을 탐구했습니다. 우리는 개혁 관리의 문제에 대한 더 깊은 설명은 평가 관행을 뒷받침하는 구조와 학습자 선택의 어포던스 사이의 복잡한 역학 관계에 대한 설명에서 찾을 수 있다고 주장했습니다. 우리는 구조, 에이전시 및 이들 간의 상호 작용에 대한 정보를 제공함으로써 기존의 전통적인 평가 시스템이 있는 맥락에서 프로그램 평가와 같은 새로운 프로그램이 미치는 영향에 대한 초기 이해를 제공하고자 했습니다(De Souza, 2013; Pawson 외., 1997).

Our framing critical realist question explored the interplay between the structure of assessment practice and learner agency in the context of implementing and evaluating new assessment practices. We have argued that a deeper explanation of the problem in managing reform can be found in accounts of the complex dynamics between the structures underpinning assessment practice and the affordances of learner agency. We have sought to provide some initial understanding of the impact of a new program such as programmatic assessment in a context where there is a pre-existng traditional assessment system by providing information about the workings of structure, agency and the interplay between them (De Souza, 2013; Pawson et al., 1997).

네 가지 주요 관점에 주의를 기울이면 기존 평가 관행의 한계를 이해하고 새로운 평가 관행을 개발하는 데 도움이 될 것입니다.

- 학습자의 주체성 활성화,

- 새로운 타당성 논거의 재구성 및 확립,

- 목적에 맞는 평가 과제 설계,

- 이해관계자가 평가에 대한 새로운 접근 방식을 이해하고 수용할 수 있도록 교수자 개발을 촉진하는 것입니다.

이러한 관점을 통해 교육자는 프로그램 평가와 같은 개입이 여러 맥락에서 누구를 위해, 어떤 상황에서, 왜 작동하는지에 대한 복잡성을 풀 수 있습니다.

Paying attention to four key perspectives will aid in both understanding the limitations of traditional assessment practice and in developing new assessment practice. These are:

- enabling learner agency,

- restructuring and establishing new validity arguments,

- designing purposeful assessment tasks, and

- promoting faculty development to enhance the fluency of stakeholders to understand and accept new approaches to assessment.

These perspectives allow educators to unpack the complexity of how interventions such as programmatic assessment work across multiple contexts, for whom, under what circumstances, and why?

비판적 현실주의 렌즈를 통해 평가 개혁을 실행하고 평가할 때 이론, 정책 및 실무에 대한 여러 가지 시사점이 있습니다. 구조와 행위자성 간의 상호 작용에 대한 이러한 접근 방식은 교육자가 자신의 교육기관에서 평가 관행에 대한 주요 변화의 복잡성을 이해하는 데 유용한 통찰력을 제공할 수 있습니다. 이는 정책, 커리큘럼 및 측정 의무를 충족하고 연구 질문, 데이터 수집 및 분석 방법 안내를 포함한 평가 연구 프로토콜을 개발할 때 실제 평가 고려 사항을 기반으로 할 수 있는 이론적 틀을 제공할 수 있습니다.

There are a number of implications for theory, policy, and practice when implementing and evaluating assessment reforms when viewed through a critical realist lens. This approach around the interplay between structure and agency can give helpful insights for educators in making sense of the complexity of major changes to assessment practice in their own institutions. It can provide a theoretical framing on which to base practical assessment considerations in meeting policy, curriculum, and measurement imperatives, and in developing evaluative research protocols, including guiding research questions, data collection and analysis methods.

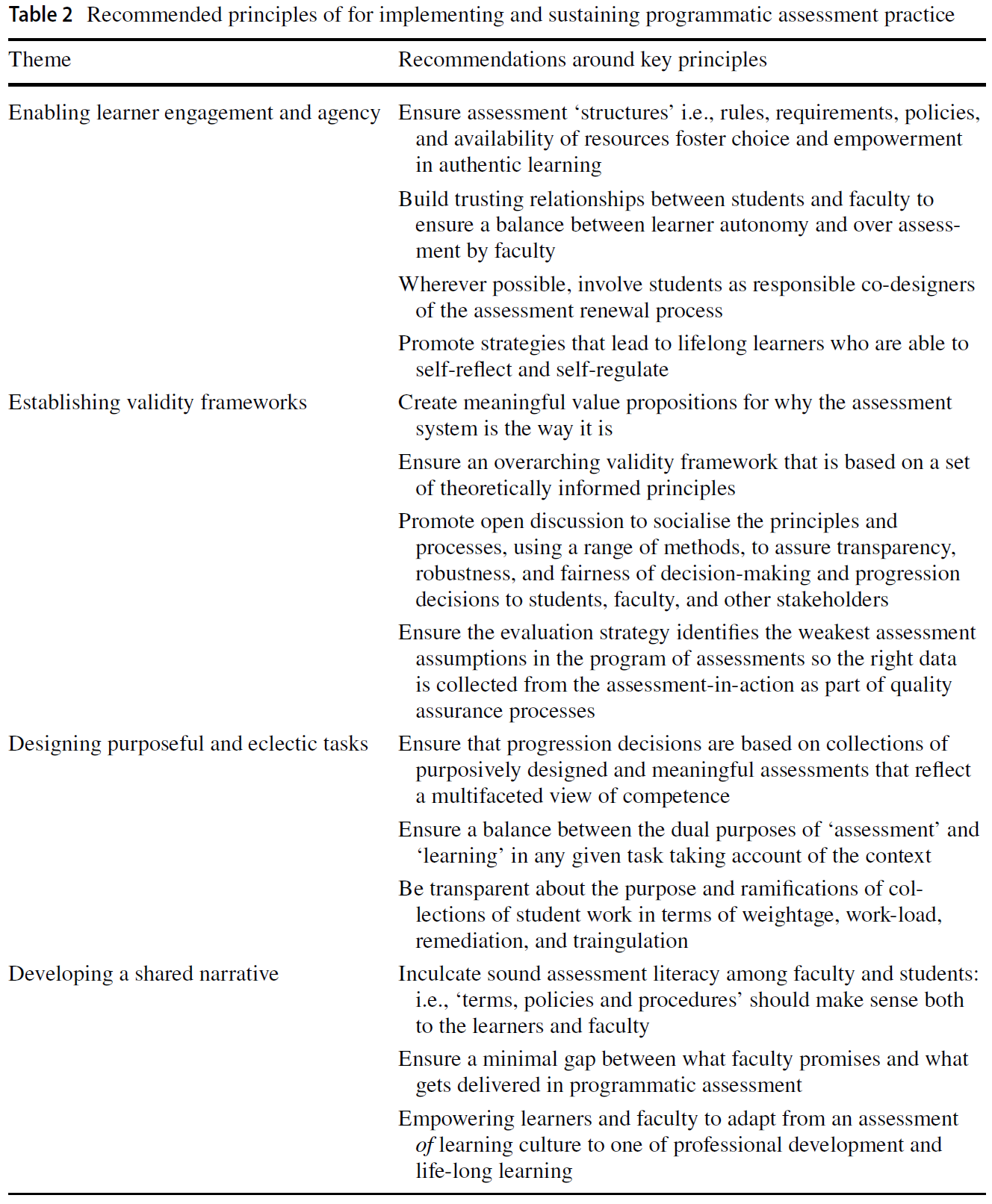

표 2에서는 프로그램 평가를 실행하거나 지속하는 데 관심이 있는 사람들을 위해 각 주제에서 다양한 실제 적용 사례를 제공하며, 비네트(표 1)에 요약된 문제 유형을 다룹니다.

In Table 2, we provide a number of practical applications from each theme for those interested in implementing or sustaining programmatic assessment and addressed the kinds of issues outlined in our vignette (Table 1).

[학습자 주도성을 촉진하기 위한 전략]에는 학습자와 함께 평가가 이루어질 수 있도록 평가 구조를 변경하는 것이 포함됩니다. 학생은 학습 기회를 극대화하고 성취도에서 표준을 입증할 수 있도록 연중 내내 자신의 책임에 대해 방향을 설정하고 지속적으로 참여해야 합니다.

Strategies to promote learner agency involve changing assessment structures so that assessment is done with learners. Students need to be orientated and continually engaged throughout the year around their responsibilities to maximize their learning opportunities and demonstrate standards in their achievements.

[Kane과 같은 논증적 프레임워크를 재구성]하면 교수자, 학생 및 인증 기관과 같은 외부 이해관계자 모두에게 평가의 타당성과 표준에 대한 명확성을 제공할 수 있습니다(Kane, 2013; Schuwirth & Van der Vleuten, 2012). 그러면 학생은 자신의 학습을 결정할 때 진정으로 얼마나 많은 권한을 가질 수 있는지, 학습 결과의 성취를 뒷받침하는 데 사용할 수 있는 증거의 종류에 대해 더 명확하게 알 수 있습니다. 학생 점수/측정/정보에 대한 의사 결정의 타당성을 명확히 하면 교수진, 학생, 인증 기관, 의료 서비스 제공자 및 커뮤니티에 확신을 줄 수 있습니다.

Restructuring an argumentative framework such as Kane’s gives clarity around validity and standards of assessment for both faculty, students and external stakeholders such as accreditation bodies (Kane, 2013; Schuwirth & Van der Vleuten, 2012). Students can then have more clarity around how much agency they can genuinely assume in determining their learning and the kinds of evidence they can use to underpin their achievements of learning outcomes. Clarity around the validity of decision making on student scores/measures/information in their collections of evidence gives assurity for faculty, students, accreditation bodies, healthcare providers, and the community.

[교수진 개발 전략]은 학생과 교사를 새로운 평가 관행의 변경된 언어와 규칙에 익숙하게 만드는 데 매우 중요합니다. 이러한 방식으로 교수진과 학생 모두 평가 관행의 변화를 지속할 수 있는 역량을 강화할 수 있습니다(Leibowitz et al., 2012).

- 교수자 개발은 새로운 평가 관행의 변화된 언어와 규칙에 익숙해지도록 할 때 교사의 상황에 따라 영향을 받은 평가 경험뿐만 아니라 제도적 맥락을 고려해야 합니다.

- 마찬가지로, 프로그램 평가에 대한 학습자 개발도 학습 활동에 포함되어야 합니다. 워크숍은 개인(교사와 학생)이 변화하는 평가 관행에 대한 우려를 해결하고 우선순위를 정하는 반성적 숙고, 즉 내부 대화를 촉진할 수 있습니다(Archer, 2003).

이러한 방식으로 교수진은 평가 관행에 대한 신뢰를 갖고 변화를 지속할 수 있으며(Schut et al., 2020), 교사-학습자 관계가 개선될 수 있습니다. (Schut 외, 2021)

Strategies for faculty development are critical in socializing student and teachers into the changed language and rules of the new assessment practices. In this way both faculty members and students might be better empowered to sustain changes in assessment practice (Leibowitz et al., 2012).

- Faculty development needs to take the institutional context as well as teachers’ contextually influenced experiences of assessment into account when socializing them into the changed language and rules of the new assessment practices.

- Similarly, learner development around programmatic assessment needs to be embedded in the learning activities. Workshops can promote an internal conversation; the reflexive deliberations through which the individual (teachers and students) address and prioritise their concerns about changing assessment practice (Archer, 2003).

In these ways, both faculty members might be better empowered to have trust in and sustain changes in assessment practice (Schut et al., 2020) and have an improved teacher-learner relationship. (Schut et al., 2021)

비판적 현실주의 접근법은 의과대학 또는 대학 내의 다양한 주체(예: 프로그램 및 평가 위원회 구조)가 어떻게 인과적 힘을 행사하고 의도된(예: 통합 평가 시스템) 및 의도하지 않은 관찰 가능한 결과(예: 과도한 평가를 통한 학습자 이탈)로 이어지는 일련의 사건 패턴을 생성할 수 있는 메커니즘을 생성할 수 있는지를 설명하는 데 도움이 될 수 있습니다. 권력 문제가 평가 이외의 '현실' 구조의 겹겹이 쌓인 층과 상호작용하여 개혁에 영향을 미치는 방식에서 우리의 시나리오에 대한 추가적인 방법론적 탐구의 기회가 있습니다. 예를 들어, 교육 거버넌스, 그리고 선임 교수진(학장 및 부학장)과 같은 인과적 권한을 가진 기타 행위자들(Bhaskar, 1978)이 이에 해당합니다. 향후 연구에서는 이 방법론적 접근 방식을 평가 관행의 주요 변화에 관여하는 프로그램의 경험적 데이터에 적용하여 주요 기본 메커니즘을 밝힐 수 있습니다.

A critical realist approach might help explain how various entities within the medical school or university, for example, the program and assessment committee structures, are capable of exercising causal powers and generating mechanisms that can create a pattern of events leading to intended (e.g., an integrated assessment system) and unintended observable outcomes (e.g., learner disengagement through over assessment). There is an opportunity for further methodological exploration of our scenario in the ways in which issues of power interact with the laminated layers of ‘reality’ of structures other than assessment, to impact reform. For example, educational governance, and other agencies having causal powers, for example senior faculty (Deans and Associate Deans) (Bhaskar, 1978). Future research might apply this methodological approach to empirical data from programs engaged in major change in assessment practice to illuminate the key underlying mechanisms.

불확실성 영역

Areas of uncertainty

이 논문은 변화하는 평가 관행에 대한 비판적 현실주의적 탐구를 제공하는 몇 안 되는 문헌 중 하나입니다. 이 연구는 평가 관행의 구조 개혁에 대한 현재의 맥락적 영향, 평가와 학습 간의 관계에 대한 다양한 생각, 학습자의 선택권을 강화하기 위해 평가 구조와 프레임워크를 조정하는 데 필요한 여러 단계와 관련하여 설명된 구조와 선택권 간의 상호 작용이라는 개념을 지지합니다. 저희는 저희의 분석과 이론화가 데이터에 기반한 것이 아니라 반사적이라는 점을 인정하지만, 평가 관행 변화의 맥락에서 경험적 연구에 대한 중요한 노력을 고려하는 사람들에게 견고한 이론적 근거를 제공했다고 믿습니다. 저희는 근본적인 메커니즘을 제공하지 못했음을 인정합니다. 그보다는 맥락이 풍부한 연구 환경에서 경험적 데이터를 검토할 때 해결해야 할 가능성이 있는 논쟁의 종류를 설명했습니다.

This paper is one of few in the literature that provide a critical realist exploration of changing assessment practice. The study supports the notion of an interplay between structure and agency, which has been illustrated in relation to current contextual influences on reforming the structure of assessment practices, differing ideas about the relationship between assessment and learning, and the several steps required to adapt assessment structures and frameworks to enhance learner agency. We acknowledge that our analysis and theorising was reflexive and not data driven, but we believe we have provided a solid theoretical grounding for those contemplating significant efforts on empirical research in contexts of assessment practice change. We recognise that we have not provided underlying mechanisms as such. Rather, we have described the kinds of arguments that are likely to need addressing when reviewing empirical data in context rich research settings.

결론

Conclusion

비판적 현실주의 접근법은 교육자가 평가 실무에서 개혁을 반영하고, 실행하고, 평가하는 데 도움이 될 수 있습니다. 비판적 현실주의 접근법은 프로그램 평가와 같은 혁신이 여러 맥락에서 어떻게 작동할 수 있는지, 그리고 어떤 것이 누구에게 효과가 있는지 설명하는 데 도움이 될 수 있습니다. 저희는 교육자가 각자의 맥락에서 평가 관행의 구조를 개혁하는 데 도움이 되는 근본적인 설명을 찾는 데 도움이 될 수 있는 네 가지 관점을 제안합니다. 여기에는 다음이 포함됩니다.

- 학습자의 참여와 선택권 보장,

- 논증에 기반한 타당도를 강조하는 타당도 프레임워크 수립,

- 증거에 기반한 의도적이고 다양한 평가 과제 설계,

- 평가 구조와 학습자의 선택권에 대한 대화의 결과를 통합할 수 있는 공유 내러티브 개발

이러한 관점과 관련된 전략을 적용하는 방법에 대한 몇 가지 지침을 제공합니다.

A critical realist approach may help educators in reflecting on, implementing, and evaluating reforms in assessment practice. It can help identify how innovations such as programmatic assessment might work across multiple contexts and explain how it works, and what works for whom. We propose four perspectives which can aid educators to find underlying explanations that are helpful in reforming the structures of assessment practice in their contexts. These include

- enabling learner engagement and agency,

- establishing validity frameworks that emphasizes argument-based validity,

- designing purposeful and eclectic assessment tasks that are evidence-based, and

- developing a shared narrative that can integrate outcomes of conversations about the structure of assessment and learner agency.

We provide some guidance on how to apply strategies related to these perspectives.

Adv Health Sci Educ Theory Pract. 2021 Dec;26(5):1641-1657. doi: 10.1007/s10459-021-10065-8. Epub 2021 Aug 24.

Exploring complexities in the reform of assessment practice: a critical realist perspective

PMID: 34431028

Abstract

Although the principles behind assessment for and as learning are well-established, there can be a struggle when reforming traditional assessment of learning to a program which encompasses assessment for and as learning. When introducing and reporting reforms, tensions in faculty may arise because of differing beliefs about the relationship between assessment and learning and the rules for the validity of assessments. Traditional systems of assessment of learning privilege objective, structured quantification of learners' performances, and are done to the students. Newer systems of assessment promote assessment for learning, emphasise subjectivity, collate data from multiple sources, emphasise narrative-rich feedback to promote learner agency, and are done with the students. This contrast has implications for implementation and evaluative research. Research of assessment which is done to students typically asks, "what works", whereas assessment that is done with the students focuses on more complex questions such as "what works, for whom, in which context, and why?" We applied such a critical realist perspective drawing on the interplay between structure and agency, and a systems approach to explore what theory says about introducing programmatic assessment in the context of pre-existing traditional approaches. Using a reflective technique, the internal conversation, we developed four factors that can assist educators considering major change to assessment practice in their own contexts. These include enabling positive learner agency and engagement; establishing argument-based validity frameworks; designing purposeful and eclectic evidence-based assessment tasks; and developing a shared narrative that promotes reflexivity in appreciating the complex relationships between assessment and learning.

Keywords: Assessment reform; Clinical competence; Critical realism; Programmatic assessment; Structure and agency.

© 2021. The Author(s), under exclusive licence to Springer Nature B.V.

'Articles (Medical Education) > 평가법 (Portfolio 등)' 카테고리의 다른 글

| 생성형 인공지능의 시대에 평가를 다시 생각하기 (Med Educ, 2023) (0) | 2023.05.23 |

|---|---|

| 전공의 수련과정에서 직접관찰의 현상학: 밀러의 'does'레벨은 관찰가능한가? (Med Educ, 2022) (0) | 2023.04.23 |

| 졸업후의학교육에서 자기모니터링의 스코핑 리뷰 (Med Educ, 2023) (0) | 2023.03.26 |

| 자기평가: 그 모든 한계에도 불구하고, 왜 우리는 여전히 측정하고 가르치는가? 스코핑 리뷰의 교훈 (Med Teach, 2022) (0) | 2023.03.26 |

| 전공의 역량 검토: 수행능력 평가에 CCC의 역할에 대한 질적 연구(Acad Med, 2015) (0) | 2023.03.04 |