평가프로그램에 대한 오타와 2020 합의문 - 1. 원칙에 대한 합의 (Med Teach, 2021)

Ottawa 2020 consensus statement for programmatic assessment – 1. Agreement on the principles

Sylvia Heenemana, Lubberta H. de Jongb, Luke J. Dawsonc, Tim J. Wilkinsond , Anna Ryane, Glendon R. Taitf, Neil Riceg , Dario Torreh , Adrian Freemang and Cees P. M. van der Vleuteni

배경

Background

2010년, 오타와 회의는 좋은 평가를 위한 일련의 합의된 기준을 만들었다(Norcini et al. 2011). 단일 평가를 넘어 후속적으로 특정 목적을 위한 증거를 제공하기 위해 통합된 일련의 개별 측정(예: 졸업 또는 다음 연도의 승진 결정)을 체계적으로 결합하는 [평가 시스템]에도 유사한 기준 세트가 필요하다는 것이 인식되었다. 따라서 오타와 2018 합의 프레임워크에서는 [평가 시스템]에 적용되는 별도의 프레임워크가 제시되었다(Norcini 등 2018). 오타와 2018 합의에서 설명한 바와 같이, 평가 시스템은 다양한 형식을 가질 수 있다. 평가 시스템은 선발 및 면허 시스템과 같은 다층적 결정을 용이하게 하기 위해 다른 정보와 결합된 일련의 평가로 구성될 수 있다. 다른 평가 시스템은 진도 시험 및 프로그램 평가와 같은 교육 및 교육 설계 접근방식을 우선시한다(Norcini et al. 2018).

In 2010, the Ottawa conference produced a set of consensus criteria for good assessment (Norcini et al. 2011). It was recognised that a similar set of criteria would be needed for systems of assessment, which goes beyond single assessments, and systematically combines a series of individual measures that are subsequently integrated to provide evidence for a certain purpose, e.g. a decision for graduation or promotion to a subsequent year. Therefore, in the Ottawa 2018 consensus framework, a separate framework applying to systems of assessment was presented (Norcini et al. 2018). As described in the Ottawa 2018 consensus, systems of assessment can have various formats. A system can consist of a series of assessments, combined with other information, to facilitate a multi-layered decision, e.g. admission and licensure systems. Other systems of assessment prioritise educational and instructional design approaches, such as progress testing and programmatic assessment (Norcini et al. 2018).

[프로그램 평가]는 개별 평가만 (합격-불합격) 결정에 사용할 경우, 모든 개별 평가 방법 또는 도구가 각자의 한계를 가지고 있기에, 타협점을 필요로한다는 원칙에 기초한다. 그러나, 흔히 사용되는 평가 접근법은 종종 모듈식이며, 기간 종료/모듈/과정 평가를 통해 등급 및 관련 합격/불합격 결정을 이끌어낸다. 평가의 [전통적인 총괄접근법]은 바람직하지 않은 학습 접근법을 추진하고, 외적 동기를 촉진하고, 주어진 피드백을 무시하는 것과 같은 여러 의도하지 않은 결과를 초래한다(van der Vleuten and Schwirth 2005).

Programmatic assessment was introduced by van der Vleuten and Schuwirth (van der Vleuten et al. 2012; van der Vleuten and Schuwirth 2005) and is based on the principle that every individual assessment method or tool has limitations and compromises are needed if just individual assessments are used for (pass–fail) decisions. In contrast, common assessment approaches are often modular, with an end of period/module/course assessment, that leads to a grade and an associated pass–fail decision. This traditional summative approach to assessment has multiple unintended consequences, such as driving undesirable learning approaches, promoting extrinsic motivation, and ignoring any feedback that is given (van der Vleuten and Schuwirth 2005).

프로그램 평가 모델은 위에 언급된 문제들에 대한 잠재적인 해결책입니다. 프로그램 평가 모델은 [평가가 가지고 있는 학습과 의사결정 기능을 최적화하기 위하여 평가와 교육을 설계하는 특정한 접근방식]으로 정의되었다. 다양한 평가 형식의 여러 데이터 지점에서 비롯된 평가 정보와 피드백은 학습자와 스태프가 취합하여, 학습을 위한 목적으로 사용할 수도 있고, 진급 또는 인증과 같은 고부담 의사 결정에 사용될 수 있다.

The programmatic assessment model as proposed by van der Vleuten and Schuwirth, is a potential solution to the abovementioned problems. The programmatic assessment model has been defined as a specific approach to the design of assessment and education aimed at optimising the learning and decision function of assessment. Assessment information and feedback, originating from multiple data points in a variety of assessment formats, is aggregated by the learner and staff and is used for learning and for high-stakes decisions such as promotion to the next year or certification (Schuwirth and van der Vleuten 2011; van der Vleuten et al. 2015).

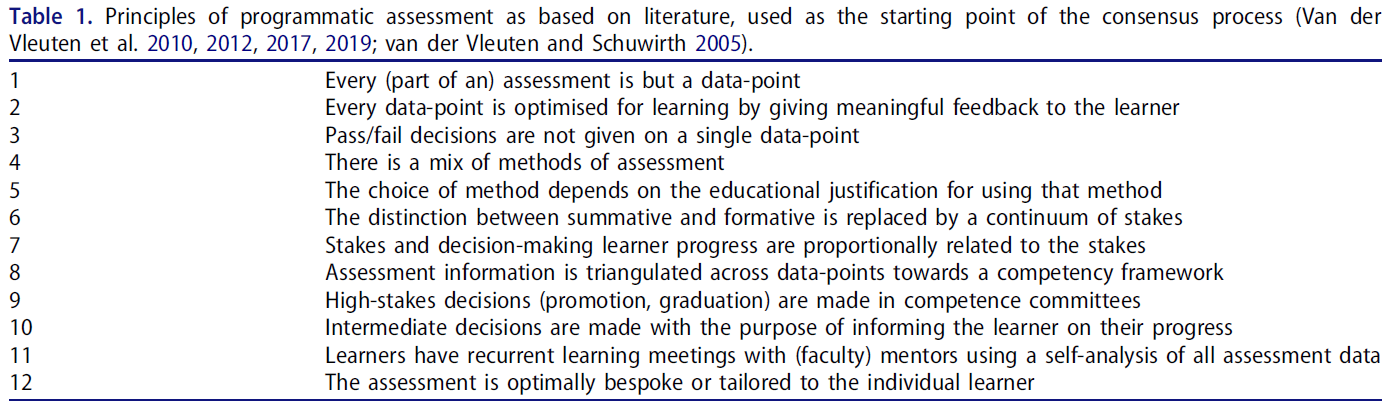

프로그램 평가는 다양한 핵심 논문(표 1)에 요약된 바와 같이 여러 가지 핵심 원칙에 기초한다. 그러나 프로그램 평가는 교육적 설계 접근법이며, [프로그램 평가의 수용가능성은 교육 프로그램의 가치와 제도적 요건에 의해 부과된 한계와 같은 다양한 요소에 의해 강하게 영향을 받는다]는 것을 인식해야 한다. 프로그래밍식 평가는 평가 개념이지 레시피가 아니라는 점을 유념하는 것이 중요하다. 통과가 필요한 일련의 모듈 또는 과정이 있는 전통적인 교사 중심의 커리큘럼의 맥락에서, 프로그래밍식 평가 접근법은 가치가 낮다. 교육에 대한 구성주의적 관점을 가진 학습자 중심의 커리큘럼에서, 종단적 스킬 발달을 사용하며, 평생 학습과 자기주도적 학습에 중점을 둔 경우에 프로그래밍 평가가 적합하다.

Programmatic assessment is built on a number of key principles, as outlined in various key papers (Table 1). It is however important to realise that programmatic assessment is an instructional design approach (van der Vleuten and Schuwirth 2005) and its acceptability is strongly influenced by a variety of factors such as the values of the educational programme and limitations imposed by institutional requirements. It is critical to note that programmatic assessment is an assessment concept and not a recipe. In the context of a conventional teacher-centred curriculum with a set of modules or courses that need be passed, a programmatic assessment approach has less value. In a learner-centred curriculum with a constructivist view on education, using longitudinal skill development and with an emphasis on life-long learning and self-directed learning, programmatic assessment is a natural fit.

현재 문헌에 기술된 원칙(표 1)은 중요하지만 다양한 형태로 실현될 수 있다.

The principles as delineated in current literature (Table 1) are important, yet can be realised in many different manifestations.

현행 문헌에 기술된 핵심 원칙(표 1)은 평가 및 교육 접근방식을 ['평가의 프로그램']이 아니라, [프로그램적 평가]로 특징짓는지 여부를 정의하는 데 중요하다. 모든 학교에는 평가 프로그램이 있지만 모든 학교가 프로그램화된 것은 아니다. '프로그램적'이 되기 위해서는, 이론적 원칙이 교육 및 평가 프로그램의 설계에 통합되어야 하며, 학습 기능(즉, 원칙 1/2/3/11/12)과 평가의 의사결정 기능(즉, 원칙 7/8/9/10) 모두에 관련된 원칙이 존재해야 한다. 이 Ottawa 2020 합의서의 목적은 실무와 연구의 통찰력을 사용하여 표 2에 제시된 프로그램 평가 원칙에 대한 합의를 정의하는 것이다.

The key principles as delineated in current literature (Table 1) are important for defining whether the assessment and education approach should be characterised as programmatic assessment rather than ‘programmes of assessment’. All schools have a programme of assessment, but not all are programmatic. To be programmatic, the theoretical principles should be integrated into the design of the teaching and the assessment programme, and principles pertaining to both the learning function (i.e. principle 1/2/3/11/12) and the decision function of assessment (i.e. principle 7/8/9/10) should be present. The aim of this Ottawa 2020 consensus paper is to use insights from practice and research to define agreement on the principles for programmatic assessment, which are presented in Table 2.

프로그램 평가의 이론적 원리에 대한 합의

Consensus on the theoretical principles of programmatic assessment

판 데르 블뢰텐과 슈비르트가 제안한 프로그램 평가 이론과 모델은 파트 1이 프로그램 평가의 원칙에 대한 합의에 도달하기 위한 출발점이었다.

The theory and model of programmatic assessment as proposed by van der Vleuten and Schuwirth was the starting point for part 1 to reach a consensus on the principles of programmatic assessment.

첫 번째 단계는 프로그램에 프로그램 평가를 도입했거나 사용하고 있는 프로그램 리더나 평가 책임자와 같은 실무 경험이 있거나 학자와 교육학자 등 이론과 연구에 대한 경험이 있는 다수의 전문가를 모으는 것이었다.

The first step was to assemble a number of experts that have experience with either the practice, such as programme leaders or directors of assessment that introduced or are using programmatic assessment in their programmes, or experience with theory and research, such as scholars and educationalists, or both.

두 번째 단계는 인지된 구성요소, 근거 및 프로그램 평가 설계의 중요성에 대한 목록을 만드는 것이었다. 전문가 그룹은 표 1과 같이 원칙에 관한 질문을 가지고 설문조사를 완료하도록 초청되었다.

The second step was to make an inventory for the perceived components, rationale, and importance of the programmatic assessment design. The group of experts were invited to complete a survey with questions regarding the principles as shown in Table 1:

- 여러분은 이 원칙에 동의하나요?

- 이 원칙의 구성 요소는 무엇이라고 생각하십니까?

- 이 원칙은 프로그램 평가에서 얼마나 중요한가?

- 이 원칙은 지키기가 쉬운가요?

- 이 원칙을 프로그램에 구현한 적이 있습니까? 그렇다면 어떻게 구현합니까?

- Do you agree with this principle?

- What do you think are components within this principle?

- How important is this principle in programmatic assessment?

- Is this principle easy to adhere to?

- Have you implemented this principle in your programme and if yes, how?

전문가 그룹에 설문 조사와 함께 초청장을 보내기 전에 시범적으로 하위 그룹(SH, LdJ, LD, TW)이 먼저 조사를 완료했으며 토론 후 원칙 1-3, 원칙 4, 5 및 원칙 6과 7에 대한 응답을 결합하기로 결정했다. 이 조사는 3개 대륙에 걸쳐 6개국의 15개 프로그램을 대표하는 전문가들에 의해 완료되었다. 이 15개 프로그램의 특징은 표 3에 나와 있습니다.

In a pilot prior to sending the invitation with the survey to the expert group, a subgroup (SH, LdJ, LD, TW) first completed the survey and after discussion decided to combine the responses for principles 1–3, principles 4 and 5, and principles 6 and 7, given that these share similar theoretical tenets of the programmatic assessment model. The survey was completed by experts representing 15 programmes from six countries across three continents. The characteristics of these 15 programmes are shown in Table 3.

사전 컨퍼런스 토론에 참석한 전문가 그룹 구성원들과 공감대 초안을 분석하고 논의한 결과, [언어와 공식화]가 중요함을 알 수 있었다. 언어와 수사학의 영향은 환자 의사소통의 교육이나 '역량'이라는 단어의 해석과 같은 다른 교육 관행에서 나타났다(Lingard 2007, 2009). 원칙 9와 12의 표현은 특정한 오해를 불러일으켰고 더 명확히 하고 개선할 필요가 있었다. 그 결과, 9번과 12번 원칙은 재검토되었고, 다섯 가지 질문에 대한 전문가들의 답변은 컨퍼런스 워크숍에 앞서 다시 정리되고 분석되었다. 이 요청에 전문가 15명 중 13명이 응했다.

The analysis and discussion of the draft consensus with the members of the expert group present at the pre-conference discussion showed that language and formulation were important. The impact of language and rhetoric has been shown in other educational practices, such as the teaching of patient communication or the interpretation of the word ‘competence’ (Lingard 2007, 2009). The phrasing of principles 9 and 12 led to certain misunderstandings and needed further clarification and refinement. Consequently, principles 9 and 12 were rephrased and experts’ responses to the five questions were then recollected and reanalysed, prior to the workshop at the conference. Thirteen of the 15 experts responded to this request.

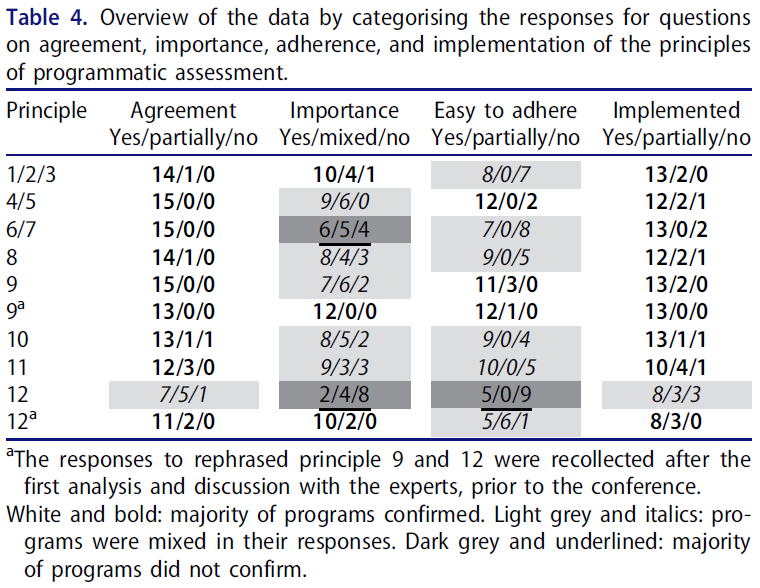

합의, 중요도, 준수 및 이행의 분류를 위한 데이터는 표 4에 요약되어 있다.

The data for the categorisation of agreement, importance, adherence, and implementation are summarised in Table 4.

- 원칙 8에서는 삼각측량 및 집계에 사용되는 프레임워크가 반드시 역량 기반 프레임워크가 아니므로 '적절한' 프레임워크로 변경되었다(원칙 8: 평가 정보는 데이터 포인트 전체에서 적절한 프레임워크로 삼각측량됨).

For principle 8, it was discussed that the framework used for triangulation and aggregation is not necessarily a competency-based framework, therefore this was changed to an ‘appropriate’ framework (principle 8: Assessment information is triangulated across data-points towards an appropriate framework).

- 원칙 10에서는 수행자료 검토에서 학습자의 중심 역할과 중간 검토 목적을 논의했고, 표현 변경으로 이어졌다(원칙 10: 학습자와 진행에 대해 논의하고 결정하는 중간 검토).

For principle 10, the central role of the learner in the review of his/her performance data and the purpose of the intermediate review was discussed, and led to a change in the phrasing (principle 10: Intermediate review is made with to discuss and decide with the learner on their progression).

- 원칙 11에서 멘토라는 단어는 코치라는 단어로 보충되었다.

For principle 11, the word mentor was supplemented by the word coach.

- 원칙 5와 7의 경우, 변경사항은 주로 문법과 구문과 관련이 있다. 내러티브에 대한 주제 분석과 회의 중 피드백과 함께, 이것은 원칙에 대한 다음과 같은 합의를 이끌어냈다.

For principles 5 and 7, the changes mainly concerned grammar and syntax. Together with the thematic analysis of the narratives and the feedback during the conference, this led to the following agreement on the principles:

원리 1/2/3:

모든 (일부) 평가는 데이터 포인트일 뿐이다/

모든 데이터 포인트는 학습자에게 의미 있는 피드백을 제공함으로써 학습에 최적화된다/

합격/실패 결정은 단일 데이터 포인트에서 내려지지 않는다.

Principle 1/2/3:

- every (part of an) assessment is but a data-point/

- every data-point is optimised for learning by giving meaningful feedback to the learner/

- pass/fail decisions are not given on a single data-point

이러한 원칙의 근거는 ['평가가 학습 행동을 주도한다']는 관찰에서 비롯되며, 따라서 학습 접근법에 대한 긍정적인 영향이 가장 중요해야 한다. 일반적인 모듈식 종합 평가 시스템에서 더 많은 부정적인 교육 영향이 나타난다(알 카드리 외). 2009). 평가가 학습을 어떻게 주도하는지drive는 복잡한 문제이다. 그러나 (평가) 과제와 평가 시스템 설계는 모두 [영향에 대한 학습자의 판단, 인식된 행위자성agency, 대인관계 요인]와 같은 [학습자 요인]에 의해 매개되는 중요한 메커니즘임이 분명해지고 있다(실리어 외 2012a, 2012b; Schut 외 2018). 또한 일부 전통적인 평가 시스템에서는 피드백이 무시될 수 있는 것으로 밝혀졌다(Harrison et al. 2013, 2015). 이러한 연구 결과는 평가가 의미 있는 학습을 주도하고 바람직한 학습 접근법을 육성하기 위해 프로그래밍 평가의 목표를 강화하는 데 가장 중요했다. 평가 프로그램은 의미 있는 (종종 서술적인) 피드백을 생성함으로써 평가의 학습 기능을 최적화하도록 설계되었다. 또한 단일 평가를 통과-실패 결정에 사용하지 않는다.

The rationale for these principles derives from the observation that ‘assessment drives learning behaviour’ and therefore a positive impact on learning approaches must be paramount. More adverse educational impacts are seen in typical modular, summative assessment systems (Al Kadri et al. 2009). How assessment drives learning is complex; however, it is becoming clear that both the (assessment) task and the assessment system design are important mechanisms, which are mediated by learner factors, such as the learner’s appraisal of the impact, perceived agency, and interpersonal factors (Cilliers et al. 2012a, 2012b; Schut et al. 2018). In addition, it has been found that feedback can be ignored in some traditional assessment systems (Harrison et al. 2013, 2015). These findings were paramount in reinforcing the objective of programmatic assessment to have assessment drive learning in a meaningful way and foster desirable learning approaches. The assessment programme is designed to optimise the learning function of assessment by the generation of meaningful, often narrative feedback and single assessments not being used for pass–fail decisions.

전반적인 합의가 이루어졌으며 목록을 완성한 15개 프로그램 중 대다수가 이러한 원칙을 이행하였다(표 4). 학습자에게 의미 있는 피드백을 제공해야 할 필요성이 중요한 요소로 인식되었습니다. 복잡한 스킬에 대한 피드백은 내러티브 정보(Govaerts 및 Van der Bleuten 2013)를 통해 향상되었습니다. 서술적 피드백은 또한 표준화된 평가에 의미를 더할 수 있다(Tekian et al. 2017). 또한 피드 포워드를 가능하게 하고 학습을 위한 종단적 모니터링과 가이드를 지원하기 위해 [학습 및 평가 커리큘럼 구조의 종단적 구성]이 언급되었다. 이는 또한 이러한 종단적 평가 커리큘럼 구조의 설계를 의식하는 것의 중요성을 강조했다. 이를 위해, 평가의 매핑 또는 청사진도 또한 4/5 원칙과 연결되는 중요한 구성 요소로 제시되었다. 사고방식과 평가문화에 변화가 필요하다는 지적도 나왔다. 실제로 학습을 자극하기 위한 저부담 설계와 학습자에 대한 종합적인 인식을 위한 고부담 설계 사이의 불일치가 나타났다(Bok et al. 2013; Heeneman et al. 2015). 학습자의 행위자성agency을 위한 기회와 함께 의도적인deliberate 설계, 학습자를 위한 지지적 평가 및 피드백 리터러시 프로그램은 프로그램 평가의 학습 기능을 실현하는 데 도움이 될 수 있다(Price et al. 2012; Schut et al., 2020; Sutton 2012).

There was overall agreement and the majority of the 15 programmes that completed the inventory implemented these principles (Table 4). The need to generate meaningful feedback for learners was recognised as an important component. Feedback for complex skills is enhanced by narrative information (Govaerts and van der Vleuten 2013). Narrative feedback can also add meaning to standardised assessment (Tekian et al. 2017). In addition, the longitudinal organisation of learning and assessment curricular structures was mentioned both to enable feed-forward and to support longitudinal monitoring and guidance for learning. This also highlighted the importance of being conscious of the design of these longitudinal assessment curricular structures. For this, mapping or blueprinting of assessment was also indicated as an important component, which links to principle 4/5. It was also indicated that a change in mindset and assessment culture is needed. Indeed a discrepancy between a low-stakes design to stimulate learning and a high-stakes, summative perception of learners has been shown (Bok et al. 2013; Heeneman et al. 2015). A deliberate design, with opportunities for the learners’ agency, a supportive assessment and/or feedback literacy programme for learners may help actualise the learning function of programmatic assessment (Price et al. 2012; Schut et al. 2018, 2020; Sutton 2012).

원칙 4/5:

평가 방법은 혼합될 수 있다.

방법 선택은 해당 방법을 사용하기 위한 교육적 정당성에 달려 있다.

Principle 4/5:

- there is a mix of methods of assessment

- the choice of method depends on the educational justification for using that method

이러한 원칙에 대한 중요한 근거는 모든 평가 방법이 타당성과 신뢰성 측면에서 한계가 있으며, 밀러 피라미드에서 하나의 수준에만 사용될 수 있다는 것이다(van der Vleuten et al. 2010). 따라서, 피라미드 전체를 커버하고 신뢰성과 타당성의 적절한 조합을 보장하기 위해 정교하고 목적적인 방법의 혼합이 필요하다. 또한 평가 형식의 선택은 의도된 학습 결과 및 교육 활동에 대한 [건설적 정렬constructive alignment]에 기초해야 한다(Biggs 1996).

An important rationale for these principles is that any assessment method has its limitations in terms of validity and reliability, and can be used for only one level of Miller’s pyramid (van der Vleuten et al. 2010). Therefore, an elaborate and purposeful mix of methods needs to be used to cover the whole pyramid and to ensure an appropriate mix of reliability and validity. In addition, the choice of any assessment format needs to be based on constructive alignment with the intended learning outcome and the teaching activities (Biggs 1996).

이러한 원칙에 전반적으로 동의하였고 목록을 완성한 15개 프로그램 중 대다수가 어느 정도 이를 구현하였다(표 4). 일부 전문가들은 이 원칙이 프로그램 평가뿐만 아니라 모든 교육 및 평가 설계에서 필요하기 때문에 '부분적' 중요성을 나타냈다. 이러한 원칙을 적용하는 데 필요한 구성요소는 청사진에 부합하는 건설적 정렬의 원칙에 따라 신중하게 평가 방법을 선택하는 것입니다. 과정의 블루프린팅에 대한 가이드라인이 설명된 바 있으나, 프로그램 평가에서 이러한 청사진들은 [프로그램의 전체적인 평가 설계]를 포함해야 하며, 고위 지도부와 경영진의 거버넌스와 지원은 필수적이다. 또한 효용 모델은 이러한 원칙의 중요한 기본 개념으로 제시되었다(Van der Bleuten 1996). 이 모델은 (신뢰성, 타당성 및 교육적 영향과 같이) 평가 방법이나 도구를 판단할 수 있는 여러 요소를 개념적으로 곱하여 평가 효용성utility을 특징짓는다. 개념적 곱셈 모델은 어떤 요소가 0이면 효용이 0이라는 것을 강조한다. 전문가들은 프로그램 평가에서 모든 평가 방법이 사용될 수 있고 효용성에 가치가 있지만, 이는 전체 평가 프로그램의 맥락에서 볼 때에만 판단할 수 있다고 지적했다.

There was overall agreement with these principles and the majority of the 15 programmes that completed the inventory implemented them to some degree (Table 4). Some experts indicated a ‘partial’ importance, as this principle would be necessary in any educational and assessment design, not just in programmatic assessment. The components needed to apply these principles would be a deliberate choice of assessment methods guided by the principles of constructive alignment adhering to a blueprint. Guidelines of the blueprinting of courses have been described (Mookherjee et al. 2013; Villarroel et al. 2018), however in programmatic assessment, these blueprints need to cover the whole assessment design of the programme (Wilkinson and Tweed 2018), and governance and support by senior leadership and management is indispensable. In addition, the utility model was indicated as an important underlying concept of these principles (van der Vleuten 1996). This model characterises assessment utility by conceptually multiplying a number of elements on which assessment methods or instruments can be judged, such as reliability, validity, and educational impact. This conceptual multiplication model emphasises that if any element is zero, then the utility is zero. The experts indicated that in programmatic assessment, any assessment method can be used and be of value for the utility, but this can only be judged when seen within the context of the entire assessment programme.

원칙 6/7:

총괄평가와 형성평가의 것의 구별은 학습자 진전에 대한 일련의 이해관계로 대체된다.

학습자 진척에 대한 의사결정은 부담에 비례한다.

Principle 6/7:

- the distinction between summative and formative is replaced by a continuum of stakes/

- decision-making on learner progress is proportionally related to the stakes

프로그램 평가에서 평가의 부담은 낮은 평가에서 높은 평가까지의 연속체로 개념화된다. 이것은 형성 평가와 총괄 평가의 전통적인 이분법과 대조된다. 저부담 평가의 결과는 합격 또는 불합격 측면에서 학습자에게 전혀 consequences가 없거나 매우 제한적으로만 consequences를 초래하며, 대신 이 데이터 포인트는 원칙 1/2/3에서 예시된 것처럼 학습에 최적화된다. 고부담 평가나 고부담 결정은 졸업이나 승진과 같은 중요한 결과로 이어진다. 많은 저부담 평가의 정보는 고부담 의사결정에 기여하며, 고부담 결정일수록 의사결정에 더 많은 데이터 포인트가 필요하다(van der Vleuten et al. 2012).

In programmatic assessment, the stakes of the assessment are conceptualised as a continuum from low- to high-stakes. This contrasts with the more traditional and binary dichotomy of formative versus summative assessment. In a low-stakes assessment, the results have no or limited consequences for the learner in terms of passing or failing, this datapoint instead is optimised for learning, as exemplified in principle 1/2/3. The high-stakes assessment or high-stakes decision, has important consequences, such as graduation or promotion. The information from many low-stakes assessments contributes to the high-stakes decision, and the higher the stakes, proportionally more data points are needed for the decision (van der Vleuten et al. 2012).

이 원칙들에 대한 전반적인 동의가 있었다. 그러나 목록을 완성한 15개 프로그램 중 여러 프로그램은 중요도의 정도와 이를 준수하기 쉬운지에 대해 엇갈린 합의를 나타냈다(표 4). 저부담 평가는 여전히 학습자들의 불안감을 유발하고, 1/2/3 원칙에서도 알 수 있듯이, 교사들이 형성-총괄이라는 이분법적 패러다임에서 저부담-고부담 연속체로 전환하기가 쉽지 않을 수 있다고 언급했다. 교사들의 인식과 관련하여, 연구는 또한 프로그램 평가의 사용이 교사들의 관행과 평가 신념을 긍정적으로 변화시킬 수 있다는 것을 보여주었다. 원칙 6/7에 따르면, 교사는 의사결정 결과가 아닌 평가의 학습 결과(원칙 1/2)에 집중할 수 있다(원칙 9 참조). 이렇게 초점이 달라지만, [교사들의 통제권]와 [학습자들의 독립 허용] 사이의 긴장은 고려해야겠지만, 역할 갈등role conflict을 줄이는 것으로 나타났다.

There was overall agreement with these principles. However, several of the 15 programmes that completed the inventory indicated a mixed agreement about the degree of importance and whether it was easy to adhere to (Table 4). It was mentioned that a low-stakes assessment would still cause anxiety among learners, and it may not be easy for teachers to shift from a formative-summative paradigm to a low-high stakes continuum, as also indicated for principle 1/2/3. Regarding the perceptions of teachers, research has also shown that the use of programmatic assessment can positively transform teachers practices and assessment beliefs. Given principle 6/7, teachers can focus on the learning outcome of assessment (principle 1/2/3) and not the decision making outcome (see principle 9). This shift in teachers’ focus was shown to reduce role conflicts, although the tension between teachers taking control and allowing learners' independence still needs careful navigation (Jamieson et al. 2021; Schut et al. 2020).

거의 모든 프로그램은 다양한 형식을 사용하여 교육 및 평가 프로그램에서 원칙 6/7을 구현하였다. 예를 들어,

- 위임 가능한 전문 활동

- 포괄적인 연말 포트폴리오 평가에 기초한 고부담 결정

- ITER에 기초한 학습 계획 평가와 이를 위한 역량위원회의 설치

Almost all programmes implemented principles 6/7 in their education and assessment program, using various formats, e.g.

- entrustable professional activities (ten Cate 2005; ten Cate and Scheele 2007),

- a high-stakes decision based on a comprehensive end of year portfolio assessment (Friedman Ben David et al. 2001; Tochel et al. 2009; van Tartwijk and Driessen 2009), and

- assessment of learning plans based on in-training assessment reports (Dawson et al. 2015; Laughlin et al. 2012), for which ‘competence committees’ were installed (see principle 9).

워크숍 이전과 워크숍 기간 동안 전문가 및 오타와 참석자들과의 토론에서 이러한 원칙의 사용에 대한 몇 가지 주의사항이 제기되었다.

- 한 가지는 [고부담 결정을 위한 데이터 포화 필요성]에 관한 것이다. [의사결정자들 사이의 합의]는 [필요한 최소치를 초과한 데이터 포인트의 숫자]와는 무관하다는 증거가 있으며, 이는 데이터 포화에 필요한 최소한의 숫자를 정하고, 주어진 맥락에서 얻어질 수 있음을 시사한다(de Jong 등 2019).

- [Teaching and Working 환경에서의 심리적 안전]의 필요성도 제기됐다. 프로그램 평가가 시행되는 환경에서 심리적 안전에 대한 연구는 아직 거의 없다. 학습자는 낮은 점수를 높은 점수로 인식하고 불안감을 느낄 수 있습니다. Tsuei 외 연구진(2019)은 [학습자가 심리적으로나 교육적으로 안전하다고 느끼는 많은 특징들]이 프로그램적 평가의 원칙으로도 인정될 수 있음을 제안했다. 여기에는 동료와 멘토와의 협력적인 관계를 맺는 것, Consequences를 걱정하지 않고 학습에 집중하는 것 등이 있다. 그럼에도 불구하고, 관계적 구성relational construct로서의 [교육적 안전감]은 어떤 교육 설계에서도 주의와 인식이 필요하다.

- 마지막으로, 프로그램적 평가의 고부담 의사결정 기능의 맥락에서도, [학습자 개발에 초점을 맞추고 성찰이 가능하도록 해야 할 필요성]이 표명되었다. 성찰과 자기 모니터링은 전문적인 발전과 성과를 위해 중요한 것으로 인식되어 왔지만, 명백한 도구적이고 의무적인 접근 방식은 학습자에게 무의미한 활동으로 이어질 수 있습니다(Murdoch-Eaton 및 Sandars 2014). 포트폴리오를 작성할 때, 역량개발에 대해 학습자가 어떤 것을 문서화하는지는 학습과 평가 사이의 긴장, 포트폴리오의 목적에 대한 학습자의 인식 등에 영향을 받을 수 있는 것으로 나타났다. 그러나 학습자는 프로그래밍 평가(원리 1/2/3)의 학습 기능 및 코치의 지침(원리 11)에 성찰 또는 자기 평가가 포함되면 학습에 도움이 된다는 것도 인지한다(Heeneman et al. 2015).

In the discussion with experts and Ottawa attendees prior to, and during the workshop, several points of attention were raised for the use of these principles.

- One point concerned the need for data saturation for high-stakes decisions. There is some evidence that consensus amongst decision makers is independent of the number of datapoints exceeding the required minimum, suggesting that data saturation can be obtained in a given context, with a defined minimum of datapoints (de Jong et al. 2019).

- Another point was raised on the need for psychological safety in teaching and working environments. There is little research yet on psychological safety in a setting where programmatic assessment is implemented. Learners can perceive low-stakes assessment as high-stakes and feel anxious. Tsuei et al. (2019) suggested that a number of features that learners would perceive as beneficial for feeling psychologically or educationally safe, are recognisable in the principles of programmatic assessment, such as having supportive relationships with peers and mentors and a focus on learning without considering consequences. Nevertheless, educational safety as a relational construct needs attention and awareness in any education design.

- Finally, the need was expressed to keep a focus on learner development and enable reflection, in the context of the high-stakes decision function of programmatic assessment. Reflection and self-monitoring have been recognised as important for professional development and performance, yet an overt instrumental and mandatory approach can lead to meaningless activities for the learners (Murdoch-Eaton and Sandars 2014). It has been shown that what learners document on competency development in a portfolio can be influenced by tensions between learning and assessment, and the learners’ perceptions about the purpose of the portfolio (Oudkerk Pool et al. 2020). However, learners also perceive the embedding of reflection or self-assessment in the learning function of programmatic assessment (principle 1/2/3) and the guidance from a coach (principle 11) are helpful for their learning (Heeneman et al. 2015).

원칙 8: 적절한 프레임워크에 대한 데이터 포인트에 걸친 평가 정보 삼각 측량

Principle 8: assessment information triangulation across data-points, towards an appropriate framework

삼각측량의 원칙은 도메인 특이성에 기초한다. 역량과 같은 구조는 컨텐츠 도메인이 동일할 때 평가 형식보다 잘 일반화된다. 이것은 또한 [시험 형식]이 아닌 [(학습자의) 속성attribuate]에 따라 증거에 기반한 결정을 내릴 수 있는 가능성을 열어준다. 예를 들어 한 학생이 [OSCE의 구성 요소 중 병력청취 점수]를 활용하여 병력청취에 대해 요구되는 표준에 도달했는지 판단할 때, 여기에 [미니-CEX의 병력청취 구성 요소], 그리고 [환자 의견 조사에서 병력청취 구성 요소]까지도 함께 사용하는 것이다.

The principle of triangulation is based on domain-specificity; constructs such as competencies generalise well over assessment formats when the content domain is the same. This also opens up the possibility of making evidence-based decisions by attribute rather than by test format – for example determining if a learner has reached the required standard on history taking might draw on the history taking components of an OSCE, alongside the history taking components of a mini-CEX, and alongside the history taking components of a patient opinion survey.

정보 결정에서 이러한 데이터 삼각측량은 강력한 의사결정의 중요한 구성 요소이다(Norman 등 1996년; Schwirth 및 Van Der Vleuten 2019년). 따라서, 프로그램 평가에서, 동일한 내용에 관련된 평가 정보는 지식, 기술, 태도 또는 역량과 같은 구조에 삼각측량 된다. 적절한 프레임워크로 간주되는 설계와 프로그램의 국가 또는 입법 경계에 따라 달라집니다. 의학 교육에서 역량은 종종 사용된다(Frank et al. 2010).

We see this triangulation of data in informing decisions as an important component to robust decision making (Norman et al. 1996; Schuwirth and Van Der Vleuten 2019). Thus, in programmatic assessment, assessment information that pertains to the same content is triangulated, to constructs such as knowledge, skills, and attitude or competencies. It will depend on the design, and national or legislative boundaries of the programme what is considered as an appropriate framework. In medical education, competencies are often used (Frank et al. 2010).

목록을 완성한 15개 프로그램 중 일부(표 4)는 의도적인 설계, 데이터 관리를 위한 일부 기술, 교수진과 프로그램의 이해 및 지원으로 인해 준수하기가 덜 쉽다는 것을 나타냈지만, 원칙에는 전반적으로 동의하였다. 삼각측량의 개념은 종종 수치 데이터와 서술 데이터의 조합을 요구하기 때문에 교육 실습으로 변환하기가 어려울 수 있다. 최종 결과는 계산이 아니라 [학습자에 대한, 학습자를 위한 풍부한 정보가 담긴 내러티브]입니다. 이를 위해서는 교육 및 평가 설계, 정렬, 교수진 개발, 필요한 수준의 직원 평가 소양 및 전문 지식, 데이터의 전체적인 관점을 취하는 효과적인 그룹 의사결정 프로세스의 확립이 필요하다(나중에 참조).

There was overall agreement with the principle, although some of the 15 programmes that completed the inventory (Table 4) indicated that it was less easy to adhere to, due to the need for a deliberate design, some form of technology to manage the data, and an understanding and support of this concept by faculty and the programme. The concept of triangulation can be difficult to translate into educational practice, as it often asks for a combination of numerical and narrative data. The end result is not a calculation but an informative narrative about and for the learner. This requires central governance of the educational and assessment design, alignment, faculty development, a necessary level of staff assessment literacy and expertise (Prentice et al. 2020; Schuwirth and Van Der Vleuten 2019), and establishment of effective group decision making processes which take a holistic view of the data (see later).

15개 프로그램(표 4)의 목록은 대부분의 프로그램이 다음의 구성요소를 통해 이 원칙을 구현했다: 적절한 방식으로 고품질 데이터를 수집할 뿐만 아니라, 교육 활동, 평가 및 평가 도구를 신중하게 설계한다. 이를 위해서는 모든 평가와 피드백 정보를 수집하는 강력한 시스템이 필수적이다. 전자 포트폴리오와 같은 기술 지원 접근방식이 자주 사용되며, 프로그램 평가에 필요한 목적을 제공할 수 있다.

- (1) 모든 정보의 보관소(서식, 평가 결과, 회의록),

- (2) 평가 프로그램의 관리적administrative 목적 촉진(예: 멀티소스 피드백 도구, 다중 플랫폼을 통한 평가 및 피드백 양식 로딩, 액세스 관리)

- (3) (적절한) 프레임워크를 사용하여 집계된 데이터 포인트의 개요를 생성하여 삼각 측량 함수를 지원한다.

- (4) 학습자의 자기 평가 및 행위자성agency를 지원한다(Tillema 2001; van Tartwijk and Driessen 2009).

The inventory amongst the 15 programmes (Table 4) showed that most have implemented this principle with the components being: a careful design of educational activities, assessments, and assessment instruments, as well as high quality data aggregation in an appropriate manner. A robust system to collect all assessment and feedback information is essential (van der Vleuten et al. 2015). A technology supported approach, e.g. an electronic portfolio, is often used and could serve the purposes needed for programmatic assessment,

- (1) as a depository for all information (feedback forms, assessment results, minutes),

- (2) to facilitate administrative purposes of the programme of assessment (e.g. direct online completion of forms, such as multisource feedback tools, loading of assessment and feedback forms via multiple platforms, managing access),

- (3) to support the triangulation function by generating overviews of aggregated datapoints using the (appropriate) framework, and

- (4) to support learners’ self-assessment and agency (Tillema 2001; van Tartwijk and Driessen 2009).

평가와 피드백 정보를 수집하기 위해 선택한 테크놀로지 접근법은, 코치(원리 11)가 더해져서, 학습 기능(원리 1/2/3), 프로그래밍 평가의 의사결정 기능(원리 9)을 지원할 수 있다.

The technology approach chosen to collect the assessment and feedback information can, together with a coach (principle 11), support the learning function (principle 1/2/3), and the decision function of programmatic assessment (principle 9).

원칙 9: 전체론적 접근 방식을 사용하여 신뢰할 수 있고 투명한 방식으로 내린 고위험 의사 결정

Principle 9: high-stakes decisions made in a credible and transparent manner, using a holistic approach

원칙 6/7에 내재된 바와 같이, 프로그래밍 평가에서 고부담 결정은 광범위한 샘플링, 맥락, 평가 방법 및 다양한 평가자에서 비롯된 풍부한 정보에 기반한 많은 데이터포인트에 기초한다(van der Vluten et al. 2012, 2015). 고부담이라는 특성과 그에 따르는 중대한 consequences를 고려할 때, 절차는 신뢰할 수 있고 신뢰할 수 있어야 한다. 절차적 척도procedural measures에는 다음이 포함된다.

- 서술적 표준, 루브릭 또는 이정표를 사용할 수 있도록 교육을 받은 전문가로 구성된 평가위원회의 구성

- 결정에 대한 정당성 제공

- 코치나 멘토, 학습자의 멤버체킹 절차

- 항소appeal 절차서 사용

As embedded in principle 6/7, the high-stakes decision in programmatic assessment is based on many datapoints, on rich information originating from a broad sampling, across contexts, assessment methods, and diverse assessors (van der Vleuten et al. 2012, 2015). Given the high-stakes and prominent consequences, the procedures need to be trustworthy and credible. Procedural measures could include:

- appointment of an assessment committee of experts that are trained and can use narrative standards, rubrics or milestones;

- the provision of a justification for the decision;

- member-checking procedures, of the coach/mentor and the learner;

- instatement of appeal procedures.

판 데르 블뢰텐 등은 다음과 같이 표현했다. '절차적으로 합당한 프로세스를 이루는 요인이나, 전문적인 판단의 전문성에 기여하는 요인과 같기, [어떤 척도가 법정에서도 효력이 있을지를 생각해 보는 것]이 도움이 된다. 이러한 결정은 일반적으로 신뢰성이 있고 신뢰할 수 있는 강력한 결정으로 이어진다'(p. 643)(van der Vleuten et al. 2015).

As expressed by van der Vleuten et al.: ‘it is helpful to think of any measure that would stand up in court, such as factors that provide due process in procedures and expertise of the professional judgement. These usually lead to robust decisions that have credibility and can be trusted’ (p. 643) (van der Vleuten et al. 2015).

이 원칙에 대한 일반적인 합의가 있었고 목록을 완성한 15개 프로그램(표 4) 중 대다수가 이를 이행했지만, 일부에서는 이를 준수하기가 쉽지 않다고 인식하기도 했다. 준수하기 쉽지 않은 이유는 다음과 같았다.

- 평가 절차 및 위원회에 필요한 자원 (부재)

- 전문가 그룹 또는 위원회의 결정을 수용하기 위해 필요한 리더십 (부재)

- 이러한 평가 절차의 집행을 가능하게 하는 기관 정책의 권한 (부재)

Although there was general agreement on this principle and majority of the 15 programmes that completed the inventory (Table 4) have implemented it as such, it was also perceived by some as not easy to adhere to, due to

- the resources needed for these assessment procedures and/or committees,

- required leadership for acceptance of decisions by an expert group or committee and

- a mandate from institutional policies to enable enactment of these assessment procedures.

많은 프로그램에서 임상 역량 위원회 또는 독립 포트폴리오 위원회와 같은 전문가 그룹을 사용하고, 멤버체킹을 위해 멘토와 학습자의 관점을 반영하여 고위험 결정을 내렸다. 이 때 [그룹 의사결정의 원칙]이 강조되었다(Hauer 등 2016).

- 전체론적holistic 의사결정을 위해 aggregated data를 사용한다.

- 정신 모델을 공유하는 것이 중요하다

- 적절한 정보 공유 방법이 필요하다.

Many programmes used a group of experts to make the high-stakes decisions, e.g. clinical competency committees (Duitsman et al. 2019; Kinnear et al. 2018) or independent portfolio committees taking the view of mentor and learner into account with a member checking procedure (Driessen et al. 2012). The principles of group-decision making were emphasised, including

- the use of aggregated data to make an holistic decision,

- the importance of having a shared mental model and

- a proper method for sharing information (Hauer et al. 2016).

또한 패널은 그룹 의사결정에서 발생할 수 있는 편향에도 주의를 기울여야 한다(Tweed and Wilkinson 2019). 위원회가 피드백 및 성과 데이터 축적에 대한 overview를 관리하고 유지하는 것을 지원하고, 의사결정에 필요한 정보제공을 지원하기 위해, [수행능력 데이터의 모자이크]를 사용하고 [베이지안 네트워크]를 사용하는 접근법이 제안되었다. 신뢰성과 투명성의 필요성은 프로그램 평가에만 국한된 것이 아니며, 모든 평가 절차와 형식은 이를 필요로 한다. 그러나 프로그래밍 방식 평가에서, [전통적인 grading rules이나 심리측정학이 의사결정 과정에 적용할 가능성이 낮다는 것]을 의미하는, [다양한 형식으로 제시된 집계 데이터를 기반으로 전체론적 의사결정이 이루어진다는 것]을 깨닫는 것이 중요하다.

In addition, the panel needs to be attuned to possible sources of bias associated with group decision making (Tweed and Wilkinson 2019). Approaches using mosaics of performance data and use of Bayesian networks have been proposed to support the committees in managing and maintaining overview of accumulating feedback and performance data, and informing the decision making (Pearce et al. 2021; Zoanetti and Pearce 2021). The need for credibility and transparency is not unique to programmatic assessment, all assessment procedures and formats need this. It is however important to realise that in programmatic assessment a holistic decision is made, based on aggregated data that is presented in a variety of formats, meaning traditional grading rules or psychometrics are unlikely to be as applicable in the decision process.

원칙 10: 학습자와 진행 상황을 논의하고 결정하기 위해 중간 검토가 이루어집니다.

Principle 10: intermediate review is made to discuss and decide with the learner on their progress

기간, 연도 또는 프로그램의 말기에 고부담 결정이 상당한 결과를 가져온다는 점을 감안할 때, (결과가) 학습자에게 예상치 못한 일로 다가오지 않아야 한다(van der Vleuten et al. 2015). 따라서 학습자는 잠재적 결정에 대한 중간 피드백을 받아야 하며, 필요한 경우 개선하도록 행동할 수 있어야 합니다. 또한 이 [중간 검토intermediate review]는 고부담 의사결정의 신뢰성을 보장하기 위한 중요한 절차적 조치로 볼 수 있다(원칙 9 참조). (van der Vleuten et al. 2015) [중간 검토]는 더 적은 데이터 포인트(비례성, 원리 6/7 참조)를 기반으로 하며, 학습자가 어떻게 하고 무엇을 할 수 있는지 '진단' 메시지를 제공하도록 설계되었습니다. [중간 검토]를 위해 학습자가 코치/멘토(원칙 11)의 지도를 받고 피드백 대화가 마련되어 있는지 확인하는 것이 중요하다. 피드백은 대화를 포함하는 순환 과정인 '루프'일 때 가장 효과적이라는 것은 잘 알려져 있다(Boud and Molloy 2012; Carless et al. 2011). 토론과 대화를 강조하고 학습자가 행동할 수 있는 능력을 강조한 것도 오타와 컨퍼런스에서 워크숍이 끝난 후 이 원칙을 되새겨야 하는 이유였다.

Given that the high-stakes decision at the end of a period, year or programme has substantial consequences, this must not come as a surprise for the learner (van der Vleuten et al. 2015). Therefore, it is imperative that the learner receives intermediate feedback on the potential decision and can act to improve if needed. This intermediate review can also be seen as an important procedural measure for ensuring the credibility of the high-stakes decision (see principle 9) (van der Vleuten et al. 2015). The intermediate review is based on fewer datapoints (proportionality, see principle 6/7) and is designed to give a ‘diagnostic’ message, how is the learner doing and what can be done. For this intermediate review, it is important that the learner is guided by a coach/mentor (principle 11), and that a feedback dialogue is in place. It is well known that feedback is most effective, when it is a ‘loop’, a cyclical process, involving a dialogue (Boud and Molloy 2012; Carless et al. 2011). The emphasis on the discussion and dialogue and the ability of the learner to act were also the rationales for the rephrasing of this principle after the workshop at the Ottawa conference.

합의가 이루어졌고 목록을 완성한 15개 프로그램(표 4) 대부분이 구현되었지만, 일부 프로그램의 경우 필수 자원과 커리큘럼 설계에 중간 순간을 명시적으로 통합해야 할 필요성 때문에 준수하기가 쉽지 않았다. 종종 중간 순간의 순간은 일정 기간이나 한 해의 중간 정도의 공식적인 순간으로 구현되거나 멘토 미팅의 과정의 일부로 통합되거나 감독자에 의해 수행된다. 중간 검토의 존재는 학습 촉진에 있어 프로그램이 학습자를 돌본다는 것을 의미하기도 했다. 피드백을 활용하는 학습자 스스로의 역할과 피드백의 후속 조치가 매우 중요하다고 보았다.

Although there was agreement and most of the 15 programmes that completed the inventory (Table 4) have implemented, for some it was less easy to adhere to, because of the necessary resources and the need to explicitly incorporate an intermediate moment in the design of the curriculum. Often the intermediate moment was implemented as a formal moment in time halfway through a period or year, integrated as part of the process of mentor meetings, or done by the supervisors. It was also indicated that the presence of an intermediate review signified that the programme takes care of the learner, in facilitating the learning. The role of the learners themselves in using the feedback, and follow-up of feedback was seen as very important.

원칙 11: 학습자는 모든 평가 데이터의 자체 분석을 사용하여 멘토/코치와 반복적인 학습 미팅을 갖습니다.

Principle 11: learners have recurrent learning meetings with (faculty) mentors/coaches using a self-analysis of all assessment data

위에서 설명한 것처럼(원칙 1/2/3 및 10), 피드백은 학습 및 전문성 개발을 위해 필수적입니다. 학습자에 의한 피드백의 사용은 종종 자기 분석이나 성찰에 있어 중요한 역할을 한다. 학습자는 성찰 활동을 체크박스 실습 이상으로 인식하지 않습니다. 하지만, 학습자들은 성찰의 가치를 멘토와의 대화에서 찾는다. 자기 주도성과 성찰에는 멘토나 코치의 디렉션과 가이드가 필요하다는 것은 잘 알려진 사실이다. 따라서 멘토에 의한 이 지침은 프로그램 평가에서 중요한 원칙이다(van der Vleuten et al. 2012, 2015).

As indicated above (principles 1/2/3 and 10), feedback is essential for learning and professional development. The use of that feedback by the learners is often scaffolded in self-analysis or reflection (Sargeant et al. 2009). Learners do not appreciate reflective activities as more than tick-box exercises (de la Croix and Veen 2018); however, they do see the value of reflection as part of a dialogue with a mentor (Driessen et al. 2012; Heeneman et al. 2015). It is well known that self-direction and reflection require direction and guidance by a mentor or coach (Knowles 1975; Pilling-Cormick 1997). Therefore, this guidance by a mentor is an important principle in programmatic assessment (van der Vleuten et al. 2012, 2015).

전반적인 합의가 이루어졌으며 목록을 완성한 15개 프로그램(표 4) 중 대다수는 이 원칙을 구현하였다. 리소스 부족과 (훈련된) 직원 부족이 이 원칙을 고수하기 쉽지 않은 요인이었습니다. 대부분의 프로그램은 전담 스태프 멘토/코치를 사용하거나 대학원 교육에서 프로그램 책임자가 참여했습니다. 프로그램의 규모도 중요했다. 학생의 규모는 큰데, 자원이 제한적일 경우, 멘토링 시스템이 없거나 연중 연락 횟수가 제한적일 수 있다.

There was overall agreement and the majority of the 15 programmes that completed the inventory (Table 4) implemented this principle. Lack of resources and lack of (trained) staff were factors that made this principle less easy to adhere to. Most programmes used dedicated staff mentors/coaches, or in post-graduate training the programme director was involved. It was clear that the size of the programme also mattered; if many learners were present, and resources limited, the choice could be made to have no mentoring system or a limited number of contacts throughout the year.

원칙 12: 프로그램 평가는 개별 학습 우선순위를 지원하도록 맞춤화된 학습을 통해 학습자의 자기 학습에 대한 행위자성과 책임감을 점진적으로 증가시키는 것을 추구한다.

Principle 12: programmatic assessment seeks to gradually increase the learner’s agency and accountability for their own learning through the learning being tailored to support individual learning priorities

평가의 학습적 기능(원리 1/2/3)을 위해 평가와 피드백이 저부담으로 설계되고, 지속적인 정보 흐름이 자기조절 학습을 촉진한다. 자기 결정 이론과 자기 조절 학습과 같은 프레임워크는 학습자의 학습 동기와 기관의 중요성을 뒷받침한다. Schut 등은 프로그램 평가의 맥락에서, 스스로 통제하고 있다는 느낌이나 행위자성agency을 갖는 것이 평가 이해 관계에 대한 학습자의 인식에 필수적이라는 것을 확인했다(Shut 등 2018). 프로그램의 몇몇 feature는 학습자가 평가를 통제하고 저부담 평가로 인식할 수 있는지에 중요했다. 즉, 프로그램에서 학습자가 [스스로 평가를 시작하거나 진행 상황에 대한 증거를 선택할 수 있도록 허용할 때], sense of agency가 장려되었다.

For the learning function of assessment (principle 1/2/3), assessment and feedback are designed as low-stakes, and the continuous flow of information fosters self-regulated learning. Frameworks such as the self-determination theory and self-regulated learning indeed support the importance of learners’ motivation and agency for learning (Panadero 2017; Zimmerman 1989). Schut et al. identified that, in the context of programmatic assessment, the feeling of being in control, or agency, was essential for the learners’ perception of assessment stakes (Schut et al. 2018). Programme features were an important factor in whether learners were able to take control over the assessment and perceive it as low-stakes, i.e. a sense of agency was encouraged when the programme allowed the learner to initiate their own assessment or select the evidence for their progress (Schut et al. 2018).

이것은 가장 복잡한 원칙으로 인식되었고 메시지와 함축된 의미를 전달하기 위해 리퍼레이싱이 필요했다. 재정비 후, 원칙과 전반적인 합의가 이루어졌는데, 이를 준수하기가 쉽지 않았고, 재고를 완료한 일부 프로그램(표 4)에서 이행이 일부 이루어졌다. 잘하는 학습자와 어려움을 겪는 학습자 모두에게 agency과 accountability가 중요함이 강조되었다. 이는 어려움을 겪는 학습자에게 특히 더 힘든데, 왜냐하면 그러한 학생일수록 코치나 스텝이 개입하여 조치를 취할 가능성이 더 높고, 재교육 조치를 스텝이 통제하고 규제하기 때문이다. 그러나 프로그램 평가에서 학습에 초점을 맞춘 것은 [이미 잘 하고 있는 사람들]이 훨씬 더 잘 할 수 있도록 지원하고 격려하며, 궁극적으로 모든 의료 종사자들에게 평생 학습의 중요성을 강화한다.

This was perceived as the most complex principle and rephrasing was needed to convey the message and implications. After rephrasing there was overall agreement with the principle, although it was not easy to adhere to, and implementation was partial in some of the programmes that completed the inventory (Table 4). It was indicated that agency and accountability are important for all learners, both for those that do well and those that struggle. This is challenging as for the learners that struggle, coaches and staff are more likely to step in and take action (Heeneman and de Grave 2017), and remediation is controlled and regulated by staff (Ellaway et al. 2018). Yet the focus on learning in programmatic assessment suggests those already doing well are supported and encouraged to do even better, reinforcing the importance of lifelong learning for all health care practitioners.

표 2는 프로그램 평가의 최종 Ottawa 2020 합의 원칙을 제시한다. 표 2의 원칙은 평가 프로그램을 프로그래밍 방식으로 호출하기 위해 이행해야 하는 체크리스트의 항목으로 간주되지 않는다. 앞서 언급한 바와 같이, 원칙은 교육, 평가 및 조정에 대한 개념적 관점을 나타낸다. 프로그램 평가는 레시피가 아니며 다양한 표현을 할 수 있다. 그럼에도 불구하고 이러한 표현은 프로그램 평가가 교육 설계를 주도하고 그러한 맥락에서 평가의 학습과 의사결정 기능을 극대화하는 프로그램으로 간주될 수 있다.

Table 2 presents the final Ottawa 2020 consensus principles of programmatic assessment. The principles in Table 2 are not be considered as items of a checklist that need to be fulfilled in order to call the programme of assessment, programmatic. As indicated earlier, the principles represent a conceptual view on education, assessment and its alignment. Programmatic assessment is not a recipe and may have many different manifestations. These manifestations may nevertheless be considered as programmes in which programmatic assessment is leading the educational design and maximises the learning and decision function of assessment in that context.

향후 작업에 대한 권장 사항

Recommendations for future work

프로그래밍 평가 원칙에 대한 이 오타와 2020 합의문(파트 1)의 작업과 진행은 여러 가지 중요한 통찰력을 제공한다.

The work and proceedings for this Ottawa 2020 consensus statement (part 1) on the principles of programmatic assessment let to a number of important insights.

첫째, 프로그래밍 평가 모델에서 중요한 측면은 원칙의 연계이다. 예를 들어 중간 진척도 회의(원칙 10)를 위해서는, 멘토의 지도가 필요하다(원칙 11). [원칙이 서로 의존한다는 사실]은 커리큘럼의 평가와 교육 설계의 중심으로서 프로그램 평가를 선택할 때 고려해야 할 중요한 사항이다. 중요한 질문은 일정한 원칙이 있는지, 또는 평가의 학습과 의사결정 기능에 원하는 영향을 미치기 위해 설계에 필요한 구체적인 원칙이 있는지 여부이다. 다시 말해, 어떤 원칙의 부재가 시스템을 프로그래밍 방식이라고 부를 수 없게 만드는가? 프로그래밍 방식이 실현되기 전에 적용해야 할 특정 수의 원칙이 있는가?

First, a significant aspect in the programmatic assessment model is the interlinking of certain principles, e.g. for the intermediate progress meeting (principle 10), guidance by a mentor is needed (principle 11). The finding that the principles depend on each other in practice, is important to take into account in the choice for programmatic assessment as central to the assessment and educational design of a curriculum. An important question is whether there are a certain number of principles, or whether there are specific principles that are needed in the design to lead to the desired impact on the learning and decision function of assessment. In other words, are there principles without which a system could not be called programmatic and/or are there a certain number of principles that need to be applied, before a programmatic approach is realised?

여기서 여러 맥락에 걸친 다른 교육 형식의 구현과 비교하는 것은 유용할 수 있다(예: 문제 기반 학습(PBL)). PBL은 원래 의도한 모델에 대한 타협으로 인해 많은 표현 또는 하이브리드 접근법을 가질 수 있다. 연구에 따르면 PBL의 성과에 대해서는 혼재hybrid 되어있다. 마찬가지로 프로그램적 평가에서 특정 원칙을 부분적으로만 구현하면 원치 않는 부작용을 초래할 수 있다. 예를 들어, 학습자가 저부담 평가를 인식하지 못하는 것이다. 중요한 질문은 최적의 구현을 하지 못해서 결과가 하이브리드였는지, 아니면 특정 원칙이 부분적으로만 구현되었는지 여부이다.

Here, the comparison to the implementation of other educational formats across contexts may be useful, e.g. problem-based learning (PBL). PBL can have many manifestations or hybrid approaches, as a result of compromises on the original intended model. Studies have shown that the outcome of PBL may then give a ‘hybrid’ success (Frambach et al. 2012), and also in programmatic assessment, the partial implementation of certain principles may give unwanted side effects, e.g. low-stakes assessment that is not perceived as such by the learners (Bok et al. 2013; Heeneman et al. 2015; Schut et al. 2018). An important question is whether the implementation itself was not optimal and therefore led to a hybrid outcome, or was a certain principle only partially implemented, e.g. a number of assessments are present that yield individual summative decisions, and that led to the hybrid outcome.

그러나 프로그램 평가가 커리큘럼의 평가와 교육 설계에 중심인 경우, [학습 기능(즉, 원칙 1/2/3/11/12)]과 [평가의 의사결정 기능(즉, 원칙 7/8/9/10)] 모두에 관련된 원칙이 존재해야 한다는 것이 프로그래밍 평가의 핵심 특징으로 강조되고 고려된다. 이 합의문에 기여한 전문가들이 속한 프로그램마다 실무에서는 프로그래밍 평가가 서로 다른 방식으로 구현되었으며, 혁신이 다양성에서 발생할 수 있음을 고려하면, 더 장려되어야 한다.

It is however emphasised and considered as a key feature of programmatic assessment that principles pertaining to both the learning function (i.e. principle 1/2/3/11/12) and the decision function of assessment (i.e. principle 7/8/9/10) should be present if programmatic assessment is central to the assessment and educational design of a curriculum. Different manifestations of programmatic assessment were seen in the actual practices of the experts’ programmes that contributed to this consensus statement, and this should be encouraged as innovation can arise from diversity.

둘째, 부담의 연속체 원칙(원리 6/7)과 학습자 행위자성(원리 12)은 중요성과 고수성adherence 측면에서 가장 다양한 응답이 얻어졌다(표 4). 실제로 [부담의 연속체]는 프로그램적 평가 모델의 중요한 이론적 토대이지만, 이와 같은 연속체라는 차원을 파악하고 고수하는 것은 어렵다고 여겨졌다. 예:

- 저부담 평가는 언제 '진정한' 저부담 평가인가?

- 의도된 학습 성과 수준에서 의미 있고 신뢰할 수 있는 고부담 결정을 어떻게 내려야 하는가?

- (부담의) 전체 연속체를 어떻게 도입할 수 있을까?

Second, the principles on the continuum of stakes (principle 6/7) and learner agency (principle 12) gave the most varied responses in terms of importance and adherence (Table 4). Indeed the continuum of stakes is an important theoretical foundation of the programmatic assessment model, but the dimensions of this continuum were considered difficult to grasp and adhere to. For example:

- When is a low-stakes assessment ‘truly’ low-stakes?

- How should we come to a meaningful and reliable high-stakes decision at the level of the intended learning outcomes?

- And how can the full continuum be employed?

원칙 12와 관련하여, 학습자의 행위자성은 중요하지만 달성하기 어려운 것으로 인식되었다. 이를 위해서는 커리큘럼과 평가 설계의 변경이 필요하며, 정렬이 더욱 중요할 것임이 분명했다(Kulasegaram et al. 2018). 와틀링 등이 보여주듯 '행위자성은 (힘든) 일'이라는 점에서, 학습자는 사회적·전문적 기대에 저항해야 할 수 있으며, 지원/코칭은 성과가 있고 필요한 것으로 판단되었다(원칙 11).

- [기관 수준에서의 정책]과 [인증 기관]이 긴장을 유발할 수도 있다. 왜냐하면 [프로그램의 의도된 학습 성과를 달성하고 보호해야 할 필요성]과 [([학습의 자기 조절와 자기 결정의 극대화]를 위한) 학습자가 원하는 자율성 또는 행위자성] 중 어느 한 쪽이 강조되기 때문이다.

- 게다가, 선생님들의 역할이 중요한 것으로 나타났다: 교사들이 accounting와 control에 더 집중하는 것도 긴장을 유발할 수 있다. 교사는 학습자를 통제하는 것과 학습자의 행위자성을 허가하는 것 사이에서 어려움을 겪을 수 있다(Shut et al. 2020).

Regarding principle 12, leaner agency was perceived as important but also difficult to achieve. It was clear that this would need a change in both the curriculum and assessment design and even more important the alignment (Kulasegaram et al. 2018). As shown by Watling et al., ‘agency is (hard) work’, learners may need to resist social and professional expectations, and support/coaching was deemed as fruitful and needed (principle 11) (Watling et al. 2021).

- Institutional policies and accreditation bodies can create tensions by emphasising the need to attain and safeguard the intended learning outcomes of a programme versus the desired autonomy or agency of the learner to maximise self-regulation and self-determination of learning.

- In addition, the teachers’ role was shown to be important: when teachers are more focused on the conception of accounting and control, this could lead to tensions. Teachers may struggle between being in control and permitting learner agency (Schut et al. 2020).

셋째, 맥락이 프로그램 평가의 구현과 잠재적 결과에 매우 중요한 영향을 미친다는 것은 분명하다. 이 합의문의 전문가들은 유럽, 북미, 오스트랄라시아 지역에 근거지를 두고 있었다는 점을 주목해야 한다. 문화적 측면이 평가 신념과 제도에 영향을 미친다는 것은 잘 알려져 있다. 다른 지역의 평가 관행을 바꿔야 한다는 요구(Khan 2018)가 있으며, 다른 지역이나 문화에서의 프로그램 평가에 대한 더 많은 연구가 적극 권장된다.

Third, it is clear that the context is a very significant influence on the implementation and the potential outcomes of programmatic assessment. It is important to note that the experts of this consensus statement were based in European, North-American, and Australasia regions. It is well known that cultural aspects influence assessment beliefs and systems (Wong 2011). Calls for a change of assessment practices in other regions are made (Khan 2018) and more studies on programmatic assessment in other regions or cultures are highly recommended.

결론들

Conclusions

전문가들과 그들의 프로그램들 사이의 목록은 비록 다양한 접근법과 엄격함에도 불구하고 이러한 원칙들이 사용되고 구현되었음을 보여주었고, 이는 프로그램 평가가 구현 가능한 현실적인 평가 모델임을 시사한다. Variability는 프로그램 규모, 제도 장벽, 법률 제한, 가용 자원, 평가 문해 수준 및 변화에 대한 기본 태도와 같은 다양한 맥락적 요소와 관련이 있었다. 다양한 맥락에서 프로그램 평가가 어떻게 운영되고 있는지에 대한 지식을 공유하면 교육자가 프로그램에서 프로그램 평가의 구현 여정에 대한 현재 또는 미래의 계획을 나타내는 데 도움이 될 수 있다.

An inventory amongst experts and their programmes showed that these principles were used and implemented, albeit with a range of approaches and rigor, suggesting that programmatic assessment is a realistic assessment model that can be implemented. The variability was related to various context factors such as programme size, institutional barriers, legislation restrictions, available resources, level of assessment literacy and underlying attitudes to change. Sharing knowledge of how programmatic assessment is being operationalised in different contexts may help educators in signifying their current or future plans for the implementation journey of programmatic assessment in their programmes.

doi: 10.1080/0142159X.2021.1957088. Epub 2021 Aug 3.

Ottawa 2020 consensus statement for programmatic assessment - 1. Agreement on the principles

PMID: 34344274

Abstract

Introduction: In the Ottawa 2018 Consensus framework for good assessment, a set of criteria was presented for systems of assessment. Currently, programmatic assessment is being established in an increasing number of programmes. In this Ottawa 2020 consensus statement for programmatic assessment insights from practice and research are used to define the principles of programmatic assessment.

Methods: For fifteen programmes in health professions education affiliated with members of an expert group (n = 20), an inventory was completed for the perceived components, rationale, and importance of a programmatic assessment design. Input from attendees of a programmatic assessment workshop and symposium at the 2020 Ottawa conference was included. The outcome is discussed in concurrence with current theory and research.

Results and discussion: Twelve principles are presented that are considered as important and recognisable facets of programmatic assessment. Overall these principles were used in the curriculum and assessment design, albeit with a range of approaches and rigor, suggesting that programmatic assessment is an achievable education and assessment model, embedded both in practice and research. Knowledge on and sharing how programmatic assessment is being operationalized may help support educators charting their own implementation journey of programmatic assessment in their respective programmes.

Keywords: Programmatic assessment; curriculum; decision-making; feedback; learners; teachers.

'Articles (Medical Education) > 평가법 (Portfolio 등)' 카테고리의 다른 글

| 신뢰와 통제 사이: 프로그램적 평가에서 교수의 평가에 대한 개념화(Med Educ, 2020) (0) | 2021.12.03 |

|---|---|

| 프로그램적 평가를 위한 오타와 2020 합의문 - 2. 도입과 실천(Med Teach, 2021) (0) | 2021.12.02 |

| 평가 프로그램의 철학적 역사: 변화해온 윤곽의 추적(Adv Health Sci Educ Theory Pract. 2021) (0) | 2021.11.18 |

| 평가에서 독소 빼내기: 발달평가의 역할이 있는가? (Med Educ, 2016) (0) | 2021.11.07 |

| 총괄적 위임결정의 타당도에 대하여 (Med Teach, 2021) (0) | 2021.11.05 |