발달시험의 시스템 프레임워크: 강점, 제약, 이슈(AMEE Guide No. 71) (Med Teach, 2012)

A systemic framework for the progress test: Strengths, constraints and issues: AMEE Guide No. 71

WILLIAM WRIGLEY, CEES PM VAN DER VLEUTEN, ADRIAN FREEMAN & ARNO MUIJTJENS

Department of Educational Development and Research, The Netherlands

소개 Introduction

보건과학 교육의 새로운 교육 철학으로서의 문제 기반 학습(PBL)의 도입은 1970년대 초 캐나다에서 맥마스터스 대학교에서 시작되었고 곧이어 네덜란드의 마스트리히트 의과대학에서 시작되었다. 이러한 변화는 학생 지향성, 심층 및 평생 학습의 PBL 신조와 일치하는 지식을 평가하기 위한 새로운 방법의 필요성을 가져왔고, 전통적인 객관식 테스트(vander Vleuten et al 1996)와 함께 인식된 단순 암기 및 시험 지향 학습의 장려를 피했다.

The introduction of problem-based learning (PBL) as a new educational philosophy in health sciences education began in the early 1970's in Canada at McMasters University and soon after at Maastricht Medical School in the Netherlands. This change brought the need for new methods to assess knowledge that were consistent with the PBL tenets of student-directedness, and deep and life-long learning, and which avoided the encouragement of rote and test-directed learning that were recognised to accompany traditional multiple-choice testing (van der Vleuten et al. 1996).

이러한 자극은 1970년대 말 마스트리히트 대학교와 미주리 대학교 둘 다에서 독립적으로 응용 의학 지식의 발달시험을 도입하는 결과를 가져왔다. 그 이후로, 그것은 전 세계의 의학 프로그램에서 점점 더 많이 사용되고 있다. 최근 조사에 따르면 이 종적 객관식 질문(MCQ) 평가 도구는 남 아프리카, 아시아, 유럽의 여러 나라, 중동, 남북 아메리카, 뉴질랜드와 호주(Freeman et al. 2010b)와 같은 다양한 지역을 포함하는 남극을 제외한 모든 대륙에 도입되었다.

This impetus resulted in the introduction of the progress test of applied medical knowledge in the late 1970s at both Maastricht University and the University of Missouri independently. Since then, it has been increasingly used in medical programs across the globe. A recent survey showed that this longitudinal, multiple choice question (MCQ) assessment tool has been introduced on all continents except Antarctica, involving such diverse regions as Southern Africa, Asia, several countries in Europe, the Middle East, North and South America, and in New Zealand and Australia (Freeman et al. 2010b).

의학교육의 평가 도구의 경우, 발달시험은 다른 유형의 평가와 구별되는 몇 가지 독특한 특성을 제공한다.

- 보통 전체 학업 프로그램 전체에 걸쳐 동시에 그리고 정기적으로 (보통 일년에 두 번에서 네 번) 의학 프로그램에 있는 모든 학생들에게 시행된다.

- 이 시험은 학생의 연도 레벨에 관계없이 의대생 과정 수료 시 예상되는 전체 지식 영역을 표본으로 추출한다.

- 결과 점수는 전체 프로그램의 목표(지식)에 대한 종단적, 반복적 척도이며, 커리큘럼-독립적 평가를 제공한다. (반데르 볼루텐 외 1996).

For an assessment tool in medical education, the progress test offers some distinctive characteristics that set it apart from other types of assessment. - It is usually administered to all students in the medical programme at the same time and at regular intervals (usually twice to four times yearly) throughout the entire academic programme.

- The test samples the complete knowledge domain expected of medical students on completion of their course, regardless of the year level of the student.

- The resultant scores provide longitudinal, repeated measures, curriculum-independent assessment of the objectives (in knowledge) of the entire medical programme. (van der Vleuten et al. 1996).

네덜란드, 캐나다, 영국 및 아일랜드의 의과대학과 치과 및 심리학 대학원 의과대학에서 얻은 상당한 경험적 증거는 진도 시험의 종적 특성이 학습과정 전반에 걸친 학생들의 지식의 성장과 효과에 대한 독특하고 입증 가능한 측정을 제공한다는 것을 보여주었다.

Considerable empirical evidence from medical schools in the Netherlands, Canada, United Kingdom and Ireland, as well postgraduate medical studies and schools in dentistry and psychology have shown that the longitudinal feature of the progress test provides a unique and demonstrable measurement of the growth and effectiveness of students’ knowledge acquisition throughout their course of study.

결과적으로, 이 정보는 진단, 예측 및 교정 교육 및 학습 개입에 일관되게 사용될 수 있다. 네덜란드에서 이러한 개입은 ProF(Muijtjens et al. 2010)로 알려진 웹 기반 결과 피드백 시스템의 제공으로 도움을 받는다.

As a result, this information can be consistently used for diagnostic, prognostic and remedial teaching and learning interventions. In the Netherlands, these interventions have been aided by the provision of a web-based results feedback system known as ProF

또한 종단적 데이터는 학교가 커리큘럼 목표를 충족하는 정도에 대한 평가를 제공함으로써 프로그램 검토를 위한 투명한 품질 보증 척도로 작용할 수 있다. 또한 이 테스트는 원샷 방법(Schuwirth 2007)이 아닌 연속 학습의 여러 측정 방법을 사용하여 높은 이해도의 평가 결정을 위한 보다 신뢰할 수 있는 데이터를 제공한다.

Additionally, the longitudinal data can serve as a transparent quality assurance measure for programme reviews by providing an evaluation of the extent to which a school is meeting its curriculum objectives (van der Vleuten et al. 1996; Verhoeven et al. 2005; De Champlain et al. 2010). The test also provides more reliable data for high-stakes assessment decisions by using multiple measures of continuous learning rather than a one-shot method (Schuwirth 2007).

대학 간 발달시험 협업은 문항, 문항 작성자, 검토자 및 관리자의 더 큰 풀을 공유함으로써 평가의 비용 효율성을 향상시키는 수단을 제공한다. 네덜란드와 다른 컨소시엄이 채택한 협업 접근 방식은 발달시험이 지식의 교육 결과 품질을 측정하는 벤치마킹 도구가 될 수 있게 했다. 이러한 방식으로 발달시험이 성공함에 따라 국제 발달시험 개발을 고려하게 되었다.

Inter-university progress testing collaborations provide a means of improving the cost-effectiveness of assessments by sharing a larger pool of items, item writers, reviewers, and administrators. The collaborative approach adopted by the Dutch and other consortia has enabled the progress test to become a benchmarking instrument by which to measure the quality of educational outcomes in knowledge. The success of the progress test in these ways has led to the consideration of developing an international progress test (Verhoeven et al. 2005; Schauber & Nouns 2010).

의료 프로그램의 모든 이해당사자에 대한 편익은 발달시험을 평가 시스템에 포함할 자원과 시간을 투자하기 위한 매력적인 도구로 만든다. 이러한 매력은 전 세계의 개별 의료 교육 기관 및 교수간 컨소시엄에서 점점 더 널리 사용되고 있으며 국가 및 국제 벤치마킹 관행에 사용된다는 점에서 입증된다.

- 발달시험은 현재 영국(스완슨 외 2010), 네덜란드(슈비탈 외 2010), 독일(오스트리아 포함) 및 아프리카(아르트 외 2010), 사우디아라비아(알 알완 외 2011), 동남아시아(남아시아)의 학교에서 사용되고 있다. 뉴질랜드, 스웨덴, 핀란드, 영국 및 미국(Freeman et al. 2010b).

- 미국의 국가 의료 검사 위원회도 다양한 국가에서 진행 상태 테스트를 제공하고 있습니다(De Champlain et al. 2010; International Foundation of Medicine 2011).

- 발달시험에 대한 국제적인 접근법의 실현 가능성은 최근에 인정되었고(Finucane et al. 2010) 독일, 네덜란드 및 이탈리아의 의과대학에서 시험 점수를 비교한 알바노 외 연구진(1996)에 의해 처음으로 입증되었다.

- 아일랜드, 호주, 캐나다, 포르투갈 및 서인도 제도의 교수진이 참여하는 국제 컨소시엄이 캐나다에 설립되었다.

The benefits for all stakeholders in a medical programme make the progress test an appealing tool to invest resources and time for inclusion in an assessment regime. This attractiveness is demonstrated by its increasingly widespread use in individual medical education institutions and inter-faculty consortia around the world, and by its use for national and international benchmarking practices.

- The progress test is currently used by national consortia in the United Kingdom (Swanson et al. 2010), The Netherlands (Schuwirth et al. 2010), in Germany (including Austria) (Nouns & Georg 2010), and in schools in Africa (Aarts et al. 2010), Saudi Arabia (Al Alwan et al. 2011), South East Asia (Mardiastuti & Werdhani 2011), the Caribbean, Australia, New Zealand, Sweden, Finland, UK, and the USA (Freeman et al. 2010b).

- The National Board of Medical Examiners in the USA also provides progress testing in various countries (De Champlain et al. 2010; International Foundations of Medicine 2011).

- The feasibility of an international approach to progress testing has been recently acknowledged (Finucane et al. 2010) and was first demonstrated by Albano et al (1996) who compared test scores across German, Dutch and Italian medical schools.

- An international consortium has been established in Canada (Finucane et al. 2010; International Partnership for Progress Testing 2011) involving faculties in Ireland, Australia, Canada, Portugal and the West Indies.

그 중요성, 모든 이해 관계자에 대한 장점, 그리고 점점 더 널리 사용되고 있음에도 불구하고, 증거는 발달시험의 내용과 적용에 상당한 차이가 있음을 시사한다(Ricketts et al. 2010).

- Blueprint와 컨텐츠 샘플링 프로파일은 크게 다를 수 있습니다.

- 시험 관리 및 구성에서도 상당한 차이를 발견할 수 있으며, 시험 반복 횟수는 연간 2-4회, 시험 항목 수는 100~250회이다.

- 또한 인정된 채점 및 점수 계산 절차도 없으며, '모름' 옵션에 대해서도 차이가 있고, 무작위 찍기를 예방 및 교정하기 위한 채점공식, 결과 분석을 위한 누적 편차 방법의 사용절차 등에 차이가 있다.

- 총괄평가 또는 형성 평가로서 시험 목적의 차이가 있어 시험 결과 상태에 따라 학생의 시험 응시 태도에 영향을 미쳐 다른 결과를 제공할 수 있다.

Despite its significance, its advantages for all stakeholders and its increasingly widespread use, evidence suggests that there is considerable variation in the content and application of the progress test (Ricketts et al. 2010).

- The blueprint and content sampling profiles can differ widely.

- Considerable divergence in test administration and composition can also be found, with testing repetitions varying between two to four tests per year, and the total number of items in a test differing between 100 and 250.

- There are also no accepted scoring and score calculation procedures, with differences evident in the inclusion of the ‘don’t know’ option and formula scoring to prevent and correct for uninformed guessing, (McHarg et al. 2005) and using procedures, such as the cumulative deviation method for the analysis of results (Muijtjens et al. 2008; Schauber & Nouns 2010).

- Furthermore, there are differences in the purpose of the test as a summative or formative assessment, which can influence the student's test-taking attitude according to the outcome status of the test, thereby providing different results.

이러한 변동은 자원, 기관의 약속 및 평가 프로그램 설계의 상이한 가용성에서 부분적으로 기인했을 가능성이 높으며 따라서 예기치 않은 것은 아니다. 또한, 이는 지역 조건과 문제를 수용하고 존중하기 위해 평가 관행이 다양해야 한다는 널리 인정된 필요성을 반영한다(2003년 Pridaux & Gordon 2002; World Federation for Medical Examination).

These variations are likely to have resulted in part from the differing availability of resources, institutional commitments and assessment programme designs, and are therefore not unexpected. They also reflect the widely acknowledged need for assessment practices to vary in order to accommodate and respect local conditions and issues (Prideaux & Gordon 2002; World Federation for Medical Examinaton 2003).

그러나 [다양한 평가 접근법을 수용하는 것]과, [타당하고 신뢰할 수 있는 데이터를 달성하기 위한 전제 조건인 엄격한 테스트 균일성과 일관성의 필요성]을 혼동하지 않는 것이 중요하다. 실제로, 영국의 최근 평가 연구 결과는 원하지 않는 결과가 평가 관행에 차이가 있을 수 있다는 것을 보여주었다.

However, it is important to not confuse the accommodation of plurality in assessment approaches with the need for rigorous test uniformity and consistency that are prerequisites for achieving valid and reliable data. Indeed, the results of a recent study of assessments in the UK showed that unwanted outcomes can result from variations in assessment practices.

발달시험에서 일관성 및 균일성 개선의 필요성의 근거 중 하나는 의학 및 보건 과학에서 MCQ 테스트가 "구조와 무관한 분산CIV"에 대해 상당한 민감도를 보인다는 것이다.

- 비핵심 의료 지식을 반영하는 것으로 판단된 항목에서 의심스러운 표본 추출 절차가 경험적으로 발견되었다.

- 결함 있는 시험 항목의 빈번한 발생, 부정확한 용어의 사용, 발달시험 공동출제 시 문항 출처 편향, 시험 난이도의 변화, 최대 15%까지 점수를 낮춘 고위험 시험의 결과 결함 있는 시험 항목의 영향이 모두 입증되었다.

The need for improved consistency and uniformity in progress testing is also suggested by evidence that MCQ tests in medicine and the health sciences show considerable sensitivity for “construct-irrelevant variance” (Downing 2002).

- Questionable sampling procedures have been empirically found in which items were judged to reflect non-core medical knowledge (Koens et al. 2005).

- Frequent occurrences of flawed test items (Downing 2002; Jozefowicz et al. 2002; Downing 2005; Stagnaro-Green & Downing 2006; Tarrant et al. 2006; Tarrant & Ware 2008; Danish & Khan 2010), the use of imprecise terms (Holsgrove & Elzubeir 1998), item origin bias in progress test collaborations (Muijtjens et al. 2007), variation in test difficulty (van der Vleuten et al. 1996), and the influence of flawed test items in the outcome of high stakes examinations that lowered scores by up to 15% (Downing 2005; Tarrant & Ware 2008) have all been demonstrated.

시스템 발달시험 프레임워크

Systemic progress test framework

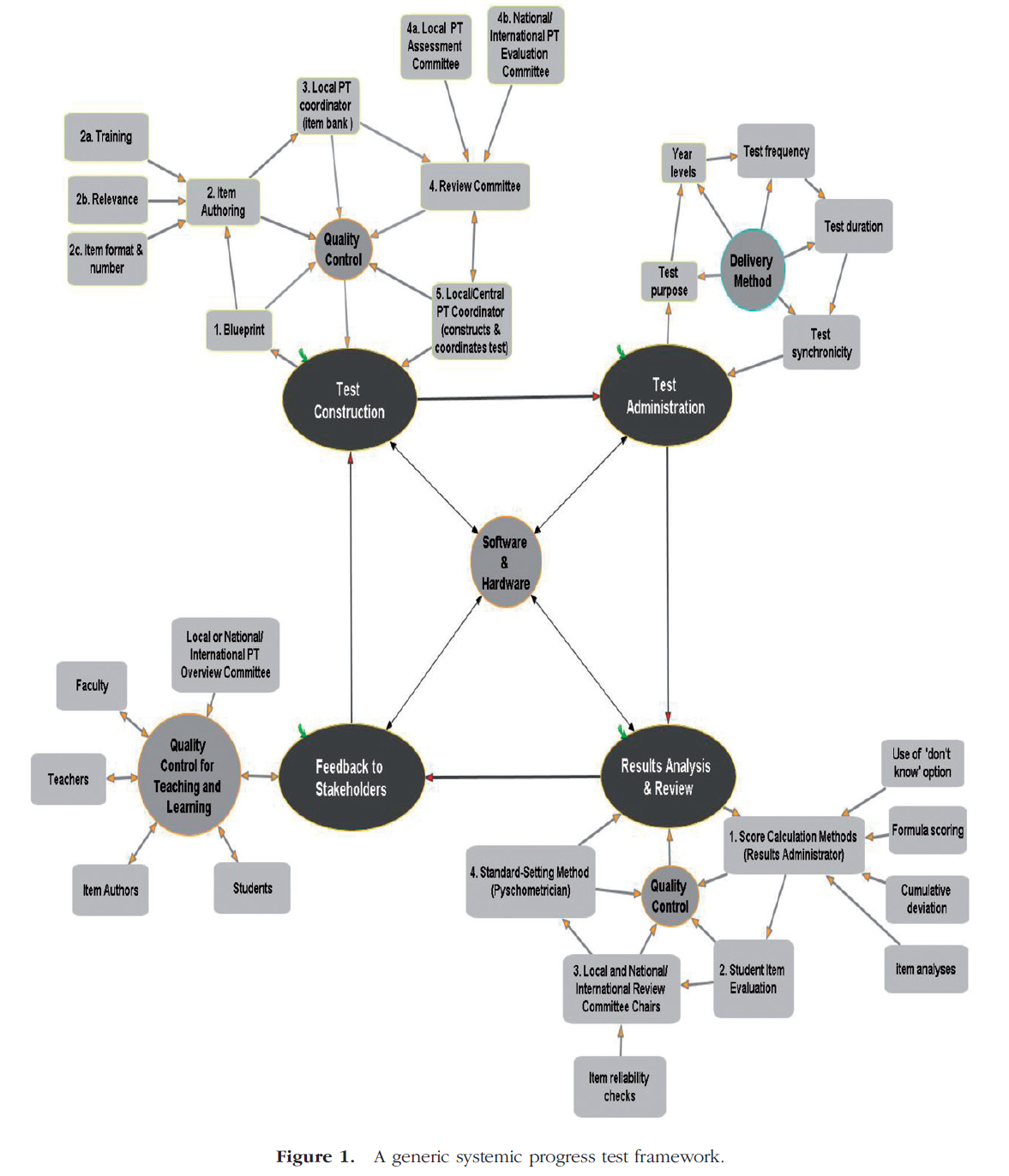

그림 1은 네덜란드 컨소시엄 시스템, 페닌슐라 스쿨 및 문헌에 기술된 원칙과 프로세스의 검토에서 일반적으로 채택된 체계적 발달시험 프레임워크의 주요 구성 요소를 보여준다.

Figure 1 displays the main components of a systemic progress test framework that has been generically adapted from the Dutch consortium system, Peninsula School and from a review of the principles and processes described in the literature.

Figure 1. A generic systemic progress test framework.

프레임워크의 주요 단계는

- 테스트 구성,

- 테스트 시행,

- 결과 분석 및 검토,

- 이해관계자에 대한 피드백

...등 4가지 단계로 구성되며, 각 구성요소와 관련된 중첩된 상호작용적 파트와, 네 가지 요소 중 세 가지 요소에서 핵심 기능으로 작동하는 품질 관리 메커니즘이 있다.

There are four main phases of the framework, comprising

- test construction,

- test administration,

- results analysis and review, and

- feedback to stakeholders,

with nested interactive parts pertaining to each, and quality control mechanisms operating as a central feature in three of the four components.

개별 학교 또는 국가 또는 국제 발달시험 시스템에 대해, 검토 위원회와 관련 지역 조정자(컨소시엄의 추가 중앙 조정자)는 시험 구성, 결과 분석 및 검토, 피드백 단계에서 품질 관리 절차에서 중추적이고 재귀적인recursive 역할을 수행한다.

Whether for an individual school, or a national or international progress test system, the review committee(s) and their associated local coordinator(s) (an additional central coordinator for consortia) play pivotal and recursive roles in the quality control procedures at the test construction, results analysis and review, and feedback phases.

- 각 시험문항은 작성자 또는 항목 뱅크에서 내용의 청사진에 따라 로컬 또는 중앙 코디네이터에 의해 추출됩니다.

- 그런 다음 중앙 위원회의 검토를 거쳐 조정자가 검토한다.

- 항목은 이 세분화 과정에서 위원회와 저자들 간에 왔다갔다 한다.

- 최고 실무그룹(국내 또는 국가/국제 진도 시험 개요 위원회(관계자에게 피드백 하위시스템, 그림 1 참조)은 시스템의 전반적인 품질을 보장할 책임이 있으며, 주기적인 시험 검토와 시험 시공 및 분석 프로세스의 추가 개선을 통해 투입된다.

- Items for each test are drawn from the authors or item bank by the local or central coordinator according to a blueprint of content.

- They are then reviewed by a central committee and subsequently by the coordinator(s).

- Items are passed back and forth between committee and authors during this refinement process.

- A supra working group (the local or national/international progress test overview committee (in the Feedback to Stakeholders subsystem, see Figure 1) has the responsibility for ensuring the overall quality of the system, and has input through periodic test reviews and additional refinements of test construction and analyses processes.

네덜란드 컨소시엄에서는 대부분의 다른 기관과는 달리, 학생들도 [시험 항목의 품질과 정확성 검증] 및 [사후 평가 의견을 제공]하여 품질 검사에 참여하고 있으며, 이는 결과 분석 및 검토 단계에 통합된다. 이 피드백은 학생 점수 및 합격/불합격 표준을 계산할 때 항목 풀을 세분화하는 데 도움이 되는 장점이 있습니다. 또한 시험 항목의 수정과 변화에 대한 필수 입증 권장 사항으로 인해 학생들이 학습할 수 있는 장점도 있다. 다만, 이러한 evaluation을 하게되면 학생들이 사후시험에서 시험 책자와 정답을 받아야 하기 때문에 시험마다 새로운 문항을 출제해야 한다. 이로 인해 발생하는 리소스와 시간에 대한 추가 부담은 발달시험 시스템의 이 구성요소가 많은 교수진에게 매력적이지 않다는 것을 의미할 수 있다.

In the Dutch consortium, unlike in most other institutions, students are also involved in quality checks by providing substantiated, post-test evaluative comments about the quality and accuracy of the test items which are then incorporated in the results analysis and review phase. This feedback has the advantage of helping to refine the item pool in the calculation of student scores and pass/fail standards. There are also learning advantages for students that come from their revision of test items and their required substantiated recommendations for changes. However, because this evaluation requires students to receive the test booklet and answers at post-test, new test items are required to be written for each test. The extra burden on resources and time this creates may mean that this component of the progress test system is not attractive for many Faculties.

시스템 진행 상태 테스트 프레임워크의 구성 요소

The components of the systemic progress test framework

조직

Organisation

전 세계적으로 발달시험을 수용하는 많은 개별 학교가 있지만, 벤치마킹, 리소스 공유 및 비용 편익을 극대화하기 위해 국내 및 국제 대학 간 컨소시엄이 점점 더 인기를 얻고 있다. 자원이 제한된 지역에서 컨소시엄은 특히 유용한 구조적 옵션이 될 수 있다.

Although there are many individual schools worldwide that embrace the progress test, national and international inter-university consortia are becoming increasingly popular, in order to maximise their benchmarking, resource-sharing, and cost benefits. In regions where resources are limited, a consortium may be a particularly useful structural option.

네덜란드와 독일 컨소시엄의 경험에 따르면 [생산적인 협업]을 위해서는 비용 분담과 자금 조달, 연구 간행물에 대한 데이터 사용, 특정 행정, 조직 및 물류 준비와 관련된 파트너십 계약이 필요할 가능성이 높다(Suwbirth et al. 2010). 모든 파트너가 기금 직원 및 인프라에 수수료를 지불한다는 합의도 필요할 수 있습니다(Nons & Georg 2010).

Experience from the Dutch and German consortia has suggested that a productive collaboration is likely to require a partnership agreement in regard to cost-sharing and funding arrangements, the use of data for research publications, as well as specific administrative, organisational and logistical arrangements (Schuwirth et al. 2010). An agreement that all partners pay fees to fund staff and infrastructure is also likely to be necessary (Nouns & Georg 2010).

시험 구성

Test construction

발달시험 시스템의 시험구성 단계는 설계도, 항목작성, 항목은행, 심사위원회, 사례관리자로 구성된 5가지 주요 구성부품을 포함한다.

The test construction phase of the progress test system involves five main components, comprising the

- blueprint,

- item authoring,

- item bank,

- review committee and

- case administrator.

이러한 부분들은 전체 활동 순서를 반영하기 위해 그림 1에서 순차적으로 번호가 매겨지지만, 실제로는 품질 관리의 유지에 종종 이들 요소들 사이의 빈번한 상호작용과 상호호혜성이 요구된다.

Although these parts are numbered sequentially in Figure 1 to reflect the overall order of activities, in practice the maintenance of quality control often requires a frequent interaction and reciprocity between these elements.

1 청사진

1 Blueprint

지식을 분류하는 청사진은 발달시험이 내용의 유효하고 신뢰할 수 있는 구성에 의존하는 기본적이고 근본적인 요구사항이다. 이 청사진은 동일한 내용의 대표적이고 균형 잡힌 샘플링을 통해 각 테스트의 적절한 타당성과 비교 가능성을 보장한다(Bridge et al. 2003).

The blueprint of knowledge classification is a basic and fundamental requirement on which the progress test relies for the valid and reliable construction of its content. The blueprint ensures adequate validity of and comparability for each test through representative and balanced sampling of the same content (Bridge et al. 2003).

청사진은 각 시험에 대해 규정된 내용을 포함하고 있으며, 일반적으로

장기 시스템(호흡기, 근골격계 등)과 기술(진단, 관리 등)을 포함하는 [열]과

분야(해부학, 수술 등) 또는 프로세스 및 작업(질병의 메커니즘, 원칙)을 포함하는 [행]의 분류 매트릭스에 따른다.

The blueprint contains the prescribed content for each test, usually according to a classification matrix of

- columns containing, for example, organ systems (respiratory, musculoskeletal etc) and skills (diagnosis, management etc), and

- rows containing disciplines (anatomy, surgery etc) or processes and tasks (mechanisms of disease, principles of therapeutics etc) (Coombes et al. 2010; Muijtjens & Wijnen 2010; Nouns & Georg 2010; Swanson et al. 2010).

이 행렬의 각 셀에는 해당 행 x 열 조합에 대해 각 검정에 포함할 항목(질문)의 합의된 빈도가 포함됩니다. 이 가중치는 지식에서 교육 프로그램의 최종 목표 측면에서 셀의 중요성 또는 우선순위를 규정한다(Muijtjens & Wijnen 2010).

Each cell in this matrix contains the agreed frequency of items (questions) to be included in each test for that row x column combination. This weighting prescribes the importance or priority of the cells in terms of the end objectives of the educational programme in knowledge (Muijtjens & Wijnen 2010).

일부 청사진은 또한 항목이 테스트하는 인지 난이도의 다양한 수준에 대한 항목의 빈도를 지정한다. 일반적으로 지식 응용 및 문제 해결의 더 높은 인지 수준을 테스트하기 위해 항목을 작성해야 한다고 인식되어 왔다(Haladyna et al. 2002). 웨어와 토스타인(2009)은 최근 문항 품질에 대한 5가지 기준을 요약했는데, 여기에는 상위 인지 수준(응용 및 추론)에서 최소 50%를 포함하는 것이 포함되어 있다.

Some blueprints also specify the frequency of items for various levels of cognitive difficulty that the items test. It has been generally recognised that items need to be written so that they test the higher cognitive levels of knowledge application and problem-solving (Haladyna et al. 2002). Ware and Torstein (2009) have recently outlined five criteria for quality items that include at least 50% of items at a higher cognitive levels (application and reasoning).

청사진구축

Blueprint construction

청사진 내용은 보통 캐나다(Frank 2005)의 CanMEDs Good Medical Practice in UK(General Medical Council 2009), 네덜란드의 Raamplan(van Herwarden 등)과 같은 국가 인증 기관에서 개발한 학습 목표와 역량에 따라 정렬되고 반영된다. 또는 미국 대학원 의학 교육을 위한 인증 위원회(2012)의 구성원. 여기서 주목해야 할 점은 청사진이 커리큘럼에 직접 맞춰져 있지 않다는 것입니다. 교육과정이 자연스레 최종 목표와 맞물려 있지만, 발달시험의 청사진과 커리큘럼은 직접적인 연관이 없다. 이렇게 하면 모든 커리큘럼 개혁에 따라 설계도를 변경할 필요가 없습니다.

The blueprint content is aligned to and reflects the end-of-programme learning objectives and competencies, usually according to those developed by national accreditation bodies, for example the CanMEDS in Canada (Frank 2005) Good Medical Practice in the UK (General Medical Council 2009), the Raamplan in the Netherlands (van Herwaarden et al. 2009), or those from the Accreditation Council for Graduate Medical Education in the USA (2012). It is important to note here that the blueprint is not directly aligned to a curriculum. Although the curriculum is naturally aligned with the end objectives, the progress test blueprint and curriculum are not directly related. This prevents having to change the blueprint with every curriculum reform.

시험 내용의 under-representation에 의해 타당성이 훼손되지 않도록 주의할 필요가 있다(2002년 하향). 이는 청사진의 범주가 너무 광범위하거나 정의되지 않거나, 교육 목표를 충분히 반영하지 못하거나, 범주 간 질문 빈도의 분포가 덜 객관적인 방법으로 선택되는 경우에 발생할 수 있다.

Care is required to ensure that validity is not compromised by the under-representation of test content (Downing 2002). This can occur if the categories in the blueprint are too broad or ill-defined, insufficiently reflect the educational objectives, or if the distribution of question frequencies across categories are selected by less objective means.

따라서 청사진 구성은 [행렬의 내용에 대한 결정]과 [행렬의 각 행 x 열 셀 내의 상대적 항목 가중치에 대한 결정] 등 두 가지 순차적 의사결정 과정이 필요하다. 이러한 두 가지 결정은 일반적으로 전문가의 합의에 의해 완료된다

Therefore, the blueprint construction requires two sequential decision processes – decisions about the content in the matrix and then decisions about the relative item weightings within each pertinent row x column cell of the matrix. Both these decisions are usually completed by expert consensus (Tombleson et al. 2000; McLaughlin et al. 2005; Coderre et al. 2009; Sales et al. 2010), for example by a Delphi procedure (Munro et al. 2000).

청사진 구축에 공감대를 형성할 전문가를 선정할 때 고려해야 할 두 가지 중요한 요소가 있다.

- 청사진에 반영될 조직의 수준(조직에 따라 지역, 국가, 지역 또는 글로벌)에 부합하는지 확인하기 위한 전문가의 폭넓은 경험

- 항목 가중치를 결정하는 데 사용되는 기준입니다.

There are two important factors to consider when selecting experts to seek consensus in constructing a blueprint -

- the experts’ breadth of experience to ensure that it corresponds to the level of organisation that the blueprint will reflect (local, national, regional or global depending on the organisation), and

- the criteria they use to determine item weightings.

- 지역 또는 국가 경험을 가진 전문가를 선택하여 생태학적 및 내용적 타당성을 얻을 수 있다.

- 국제 청사진은 일반적이고 문화적으로 중립적인 분류를 개발하기 위해 국제 또는 지역 실무 경험을 가진 전문가들의 참여를 필요로 할 것이다.

The selection of experts with local or national experience to devise a blueprint for progress test organisations at these corresponding levels is an approach likely to yield acceptable ecological and content validity.

An international blueprint will require the involvement of experts with international or regional practice experience to develop generic and culturally neutral classifications.

전체 교육 프로그램의 전체 연도 수준에서 적용 청사진의 구성을 설명하는 연구는 없는 것으로 보이지만, 일부 연구는 프로그램의 임상 학년에 대한 청사진을 구성하기 위한 내용 선택 또는 항목 가중치 부여 절차를 기술했다.

Although there appear to be no studies that describe the construction of a blueprint for application across all year levels of an entire educational programme, a few studies have described the content selection or item weighting procedures for constructing a blueprint for the clinical years of a programme. (Munro et al. 2000; McLaughlin et al. 2005; Coderre et al. 2009; Sales et al. 2010)

2 문항 작성

2 Item authoring

설계도가 작성되면 설계도 매개변수 및 항목 뱅크의 내용 격차에 따라, 발달시험의 각 문항을 준비하기 위해 다양한 전문가와 교육받은 저자가 필요합니다. 네덜란드 컨소시엄의 경험을 통해 잘 작성된 품목의 흐름을 유지하는 데 몇 가지 어려움이 있다는 것을 보여주었다.

- 교수진과 직원들은 문항을 지속적으로 개발할 동기를 요구합니다. 특정 단위나 과정과 직접 관련이 없는 대신 프로그램의 잘못 정의된 최종 목표를 측정하는 것은 종종 어렵고 까다로운 작업이며, 이는 문헌 참조와 함께 수반되어야 한다.

- 결과적으로, 시험 항목은 너무 상세하거나 충분히 관련이 없어서 거부되는 경우도 많다.

- 정기적인 교육 세션, 업데이트, 강점과 개선 영역을 보여주는 저자별 항목 분석 피드백, 엄격하고 지원적인 환경(Malau-Aduli & Zimitat 2011)에서 수행된 피어리뷰 등은 항목 작성자의 동기 및 항목의 품질을 개선하는 데 도움이 될 수 있다.

Once the blueprint has been prepared, a range of expert and trained authors are required to prepare each item of the progress test according to the parameters of the blueprint and the content gaps in the item bank. Experience from the Dutch consortium has shown that there are several challenges in maintaining a flow of well-written items.

- Faculty and staff require motivation to frequently contribute questions on a continuing basis. It is often a challenging and demanding task to produce items that are not directly related to a particular unit or course but instead measure the ill-defined end objectives of the programme, and which should be accompanied by a literature reference.

- As a result, test items often have to be rejected because they are too detailed or not sufficiently relevant (van der Vleuten et al. 2004).

- Regular training sessions, updates, author-specific item analysis feedback that shows strengths and areas for improvement, and peer reviews all of which are undertaken in a rigorous and supportive environment (Malau-Aduli & Zimitat 2011) can help to improve item writer motivation and the quality of items.

Training

고품질 MCQ 항목을 쓰는 것은 복잡하고 시간이 많이 걸리는 작업이다. 문항 개발 규칙에 대한 유용한 분류법을 사용할 수 있으며(Haladyna & Downing 1989a,b), 이를 수정하는 데 도움이 되는 조언이 잘 문서화되었다(Case & Swanson 2002; Haladyna et al. 2002). 문항 작성 결함의 빈번한 발생이 경험적으로 발견되었다(Downing 2002; Inchigaro-Green & Downing 2006). 이는 문항 작성자는 좋은 문항 개발을 위하여 지속적이고 주기적인 교육을 필요로 한다는 것을 의미한다. 그래야만 지속적인 개선을 보장할 뿐만 아니라 결함 품목 생산에 따른 품질 관리 점검의 지속적 시간과 비용을 줄일 수 있다.

Writing high quality MCQ items is a complex and time consuming task. A useful taxonomy of item writing rules is available (Haladyna & Downing 1989a,b), and advice to help rectify them has been well documented (Case & Swanson 2002; Haladyna et al. 2002). Frequent occurrences of item writing flaws have been empirically found (Downing 2002; Stagnaro-Green & Downing 2006). This means that item writers require ongoing and periodic training to not only ensure continual improvement in writing quality items but also to help reduce the time and cost of prolonged quality control checks resulting from the production of flawed items.

Relevance

문항의 관련성은 발달시험의 타당성을 손상시킬 수 있는 잠재적인 오류 원인이다. 각 항목은 커리큘럼 목표의 종료를 위해 졸업 시 요구되는 핵심 지식에 따라 관련될 필요가 있다(Koens et al. 2005). 다우닝(2002)은 미래 학습이나 임상 치료를 위해 중요도가 낮은 사소한 질문의 포함이 달성 의학교육 시험에 너무 자주 나타났다고 주장해왔다. 이는 문항 개발자에게 제공된 [관련성의 정의에 대한 불명확한 기준]에서 비롯되었을 수 있다.

The relevance of items for testing a new graduate's knowledge is a potential source of error that can compromise progress test validity. Each item needs to be relevant according to the core knowledge required at graduation to meet end of curriculum objectives (Koens et al. 2005). Downing (2002) has maintained that the inclusion of trivial questions that have a low degree of importance for future learning or clinical care have too often appeared in medical education tests of achievement. This may have resulted from unclear criteria for the definition of relevance to guide item writers.

네덜란드 컨소시엄의 과거 경험에 따르면, 관련성의 정확한 정의에 대한 항목 작성자 간의 합의된 합의를 얻는 것은 상당히 어려울 수 있으며, 개념이 항목 난이도 와 잘못 혼동될 수 있다는 것을 알게 되었다. 결과적으로, 최근에는 항목을 구성하고 검토할 때 항목 작성자 간의 해석의 일관성과 정확성을 높이기 위해 네덜란드 컨소시엄 파트너 간의 합의 전문가 합의가 5가지 관련성 기준을 개발하는 데 사용되었다.

Past experience from the Dutch consortium has found that it can be quite difficult to obtain a consensus agreement among item writers on the precise definition of relevance, and that the concept can be mistakenly confused with item difficulty. As a result, in more recent times consensual expert agreement among Dutch consortium partners has been used to develop five criteria of relevance in order to encourage more consistency and accuracy in its interpretation among item authors when constructing and reviewing items.

다음 사항으로 합의되었다.

- 의학분야에 특화된 지식을 시험한다.

- 준비지식(실제 상황에서 기능하기 위한 전제조건으로 필요한 지식)을 테스트합니다.

- 의학의 성공적 실천에 필요한 중요한 지식이다.

- 고위험성 또는 고위험성 의료 상황의 성공적인 처리와 실질적인 관련성이 있어야 한다.

- 평가하는 지식은 커리큘럼에서 하나 이상의 중요한 개념의 기초를 형성해야 한다(Suwbirth 2011).

It was agreed that the items should

- test knowledge that is specific to the specialty of medicine,

- test ready knowledge (knowledge required as a prerequisite to function in a practical situation),

- be important knowledge which is required for the successful practice of medicine,

- have a practical relevance for the successful handling of high-prevalence or high-risk medical situations, and

- the knowledge should form the basis of one or more important concepts of the curriculum (Schuwirth 2011). \

Item format, guessing and item number

형식 FORMAT

원-베스트 답변, 대안 선택, 참-거짓, 다중 참-거짓, 확장 일치 및 복잡한 다중 선택을 포함하여 여러 가지 객관식 항목 형식이 문헌에서 설명되었다(Case & Swanson 2002; Haladyna et al. 2002).

Several multiple choice item formats have been described in the literature, including the one-best-answer, alternative-choice, true-false, multiple true-false, extended matching and complex multiple choice (Case & Swanson 2002; Haladyna et al. 2002).

네덜란드 컨소시엄 테스트에서 각 품목에 대해 선택된 옵션 수는 2개에서 5개까지 다양하며, 대부분 3개 또는 4개의 옵션이 있는 반면, 페닌슐라 발달시험은 일관되게 5개 옵션 문항을 사용되었다.

- 옵션 번호의 변동은 특정 문제와 관련된 만큼 많은 대안을 구성하고, 항목에 대한 지식이 부족한 학생도 부정확하다고 쉽게 인식되는 덜 적절한 대안을 포함하도록 강요받지 않는 장점이 있다.

- 그러나 Peninsula는 5-옵션 테스트를 일관되게 사용하여 정답이 틀릴 경우 -0.25의 일정한 감산 마크를 제공하므로 자동으로 표시되는 프로그램에서 루빅을 정기적으로 변경할 필요가 없다는 것을 발견했습니다.

In the Dutch consortium test the number of options selected for each item varies between two and five, with most having three or four options while the progress test at Peninsula has consistently used 5-option items.

- The variation in option numbers has the advantage of constructing as many alternatives as are relevant for a particular question, and of not being forced to include less appropriate alternatives that are easily recognised as being incorrect, even by students lacking knowledge of the item.

- However, Peninsula have found that consistently using a 5-option test provides a constant subtracted mark of –0.25 for an incorrect answer thereby removing the need to regularly alter the rubric in programmes that mark automatically.

찍기와 '모름' 보기

GUESSING AND THE USE OF ‘DON’T KNOW’ OPTION

추측에 대한 벌칙과 함께 항목의 대안 중 '모름' 옵션을 사용하는 것은 의과대학 전체에 걸쳐 다양하게 사용되어 왔으며, 결과적으로 기관들 사이의 결과에 유의한 불일치discrepancies에 기여할 수 있다.

- 네덜란드, 독일, 캐나다 컨소시엄의 진행 테스트와 반도에서 진행되는 테스트에서 추측 빈도를 줄이고 점수에 대한 추측의 영향을 줄이기 위해 포함되어 있다.

- 영국과 일부 미국 컨소시엄 테스트에서는 포함되지 않았다. 그것은 또한 혼합된 연구 지원을 받았다. 그들의 계산에서, 짐머만과 윌리엄스(2003)는 추측의 오차가 많은 MCQ의 다른 분산 소스보다 클 수 있다는 것을 발견했다.

- Muijtjens 외 연구진(1999년)은 발달시험이 프로그램의 모든 학생과 커리큘럼 전체에 걸쳐 반복적이고 종방향으로 이루어지기 때문에 "학생들이 시험에서 평가된 모든 목표를 다루지 않았을 것으로 예상하기 때문에 모르는 선택권은 불가피하다"고 주장해왔다. ( 페이지 268)

- Wade 외 연구진(2011)의 최근 연구 결과는 [찍기를 제어하기 위한 방법 사용]을 서포트한다. 그들은 발달시험에 대한 학생들의 인식을 조사했고, 학생들은 발달시험에서 [운과 추측]이 [지식]보다 더 큰 기여를 한다고 믿는다는 것을 발견했다. 그 믿음은 추측하기 위해 벌칙을 사용하지 않는 학교에서 훨씬 더 강했다.

The use of the ‘don’t know’ option among the alternatives of an item in combination with a penalty for guessing has been used variably across medical schools, and as a result, can contribute to significant discrepancies in outcomes between institutions.

- It is included in the progress tests of the Dutch, German and Canadian consortia's and at Peninsula to reduce the frequency of guessing as well as to reduce the influence of guessing on the score.

- However, in the UK and some USA consortia tests it is not included. It has also received mixed research support. From their calculations, Zimmerman and Williams (2003) found that error from guessing could be larger than for other sources of variance for many MCQs.

- Muijtjens et al (1999) have argued that because the progress test measures achievement of the curriculum end-objectives repeatedly and longitudinally throughout the curriculum with all students in the programme, “a don't-know option is inevitable because it expects students not to have covered all the objectives assessed in the test” (p. 268).

- The results of a recent study by Wade et al. (2011) provide empirical support for the use of methods to control for guessing. They examined students’ perceptions of the progress test and found that students believed that luck and guessing were stronger contributors to their success on the progress test than their knowledge. That belief was significantly stronger in a school that did not use a penalty for guessing.

더욱이, '모름' 옵션을 생략하는 것은 [확신에 찬 지식]과 [불확실성]에 대해 동등한 보상을 제공한다는 주장이 제기되었다(Burton 2002). 또한, 모르는 선택권의 사용은 실제 의료행위의 요구조건을 모방하는 방식으로 추측하는 관행을 단념시키면서, 학생들에게 모르는 것을 보여줌으로써 지식의 한계에 대한 척도를 제공한다.

Furthermore, it has been argued that omitting the ‘don’t know’ option and using number correct scoring gives equal reward for uncertainty as for confident knowledge (Burton 2002). Also, the use of the don’t know option provides students with a measure of the limits of their knowledge by showing them what they don’t know, while discouraging the practice of guessing in a way that emulates the requirements of real medical practice (Burton 2002).

'모름' 옵션을 포함하면 성격적으로 [위험 회피적 보기]를 선택하는 학생들을 차별함으로써 측정 오류가 발생한다고 주장하기도 한다. 그러나 수학적 분석에 따르면 이러한 효과는 예방 목적으로 설계되었다고 추측하는 측정 오류에 비해 작다(Espinoza & Gardeazabal 2010). 더 큰 불이익은 프로그램의 초기 연도에 적용될 수 있다. 매우 높은 빈도의 미지의 달성은 예상되기는 하지만, 지식의 진보적 발달과 그에 따른 동기 부여에 대한 신뢰를 떨어뜨리는 원치 않는 부정적인 결과를 가져올 수 있다.

However, some have argued that including the ‘don’t know’ option introduces measurement error by discriminating against those students whose personalities encourage them to adopt a risk-averse response set. However, mathematical analysis has suggested that this effect is small compared with the measurement error of guessing that it is designed to prevent (Espinoza & Gardeazabal 2010). A further disadvantage may apply to the early years of the programme for whom the achievement of a very high frequency of don’t-knows, although to be expected, may have the unwanted negative result of lowering confidence in their progressive development of knowledge and therefore their motivation.

이러한 주장의 개요와 '모름' 옵션의 포함에 대한 찬반 경험적 증거로부터, 옵션을 포함하는 것이 더 효과적일 수 있는 것으로 보일 것이다. 그러나 이러한 결론을 뒷받침할 증거를 제공하기 위해서는 추가 연구가 필요하다.

From this outline of the arguments and empirical evidence for and against the inclusion of the ‘don’t know’ option, it would appear that it may be more efficacious to include the option. However, further research is required to provide evidence to support this conclusion.

ITEM NUMBER

차이가 크다. 네덜란드와 독일의 컨소시엄은 200개, 캐나다, 180개, 그리고 영국의 학교들을 120개 또는 125개 문항을 선정한다.

- 이 변동은 연간 시험 빈도의 함수일 수 있다.

- 그러나 일부 연구는 너무 짧은 테스트는 과소 표현된 내용을 반영할 수 있으므로 시험의 내용 타당성과 추론 정당성에 대한 지원에 이의를 제기하였다(Downing 2002).

- 이와 일관되게, 상당히 많은 품목이 권장되었다(Langer & Swanson, 2010). 항목 번호와 시험 빈도 간의 신뢰성에 대한 상호작용 효과 분석은 아래에 제시되어 있다(아래 섹션 "연도 수준, 시험 빈도 및 시험 크기" 참조).

There is considerable variability in the number of items selected for the test. The Dutch and German consortia select 200, Canada, 180, and schools in the United Kingdom 120 or 125 items.

- This variation may be a function of the test frequency per year.

- However, some research has suggested that tests that are too short can reflect under-represented content, thereby challenging the content validity of the test and support for the legitimacy of its inferences (Downing 2002).

- Consistent with this, a fairly large number of items have been recommended (Langer & Swanson, 2010).

3 문제 은행

3 Item bank

모든 발달시험 시스템은 항목 은행과 관리자가 청사진에 따라 들어오는 항목 및 기존 문제은행을 안전하게 보관, 분류, 확인 및 검토해야 합니다.

All progress test systems require an item bank, and an administrator to securely house, classify, check, and review incoming items and existing stocks in accordance with the blueprint.

정전blackout이나 퇴직retirement 규칙(예: 1년에서 5년)과 관련하여 이전 테스트에서 학생들이 친숙할 수 있는 항목을 만나는 것을 피하기 위한 합의가 필요하다.

Agreement is required in regard to the blackout or retirement rule, for example one to five years, to avoid students encountering an item they may be familiar to them from a previous test.

아이템 작성자와 관리자 모두를 위한 안전하고 잘 작동하는 아이템 뱅크를 위해서는 로컬이든 온라인이든 전용 IT 하드웨어 및 소프트웨어 리소스, 지원 및 조정이 필요합니다. 컨소시엄의 장점은 이러한 약정이 비용 효율적이 된다는 것이다.

Dedicated IT hardware and software resources, support and coordination, whether locally or online, are required for a secure and well-functioning item bank for both the item writer and administrator. An advantage for a consortium is that these arrangements become more cost-effective.

문제은행의 규모는 학년 시험 빈도, 시험 항목 수, 재사용성 정책, 사후시험에서 수험 책자와 답안 제공 여부 등에 영향을 받는다. 이러한 요소들은 은행에 필요한 새로운 항목의 빈도도 결정할 것이다. 예를 들어, 네덜란드 컨소시엄은 [3년 경과 후 아이템 재사용 정책]을 가지고 있다. 즉, 각 시험에 연간 4회 200개 항목이 요구되며, 항목 뱅크는 최소 2400개 항목(3 × 4 × 200)을 포함해야 한다.

The size of the item bank will be influenced by the frequency of the test in the academic year, the number of items in the test, the reusability policy, and whether the students are given the test booklet and answers at post-test. These factors will also determine the frequencies of new items that are required for the bank. As an example, the Dutch consortium has a policy of item reuse after the elapse of three years. This means that with 200 items required for each test four times per year, the item bank needs to contain at least 2400 items (3 × 4 × 200).

4 검토 위원회

4 Review committee and local/central coordinator(s)

문항 확인 및 검토의 반복적 프로세스는 공정 시스템의 중요한 품질 관리 기능입니다. 여기에는 각 항목이

- 현재 문헌에 비추어 최신 상태이고,

- 관련성이 있으며,

- 청사진과 일관성이 있으며,

- 각 항목에 특정 결함이 없는지 점검하는 작업이 포함된다(Haladna et al. 2002).

An iterative process of item checking and review is an important quality control feature of the progress system. This involves checks that each item

- is up-to-date with the current literature,

- is relevant,

- consistent with the blueprint,

- and that each is free of specific item writing flaws (Haladyna et al. 2002).

여기에 설명된 발달시험 프레임워크에서 이러한 점검은 현지 검토 위원회와 컨소시엄에 의해 테스트 건설 단계에서 감독되며, 또한 국가 또는 국제 검토 위원회가 감독한다. 네덜란드 컨소시엄은 4개의 지역 및 1개의 국가 검토 위원회로 구성되며, 각 위원회는 기초, 임상 및 행동 과학 분야에 경험이 있는 약 6명의 위원으로 구성된다.

In the progress test framework described here, these checks are overseen during the test construction phase by a local review committee, and for consortia, also by a national or international review committee. The Dutch consortium comprises four local and one national review committee, each consisting of approximately six members who have backgrounds in the basic, clinical and behavioural sciences.

각 위원회에는 지정된 위원장 및 관련 코디네이터가 있다.

- 문항 작성을 운영하고,

- 품질 검사를 수행하며,

- 위원회가 검토할 품목 은행으로부터 시험을 위한 예비 항목 세트를 구성하고,

- 최종 시험 품목 세트의 편집 검사를 완료하고,

- 시험 책자를 구성한다.

Each of these committees has a designated chairperson and associated coordinator to

- organise the item authoring,

- undertake quality checks,

- construct a preliminary set of items for a test from the item bank for the committee to review,

- complete editorial checks of the final set of test items, and

- construct the test booklet.

시험관리

Test administration

발달시험 프레임워크의 시험 관리 구성요소의 몇 가지 특징은 시험 결과의 결과와 상당히 관련이 있다. 여기에는 시험의 목적, 시험에 포함된 연도 수준, 시험 납품 방법, 그리고 시험 빈도 및 기간이 포함된다. 그림 1은 시험 관리 하위 시스템의 중심 조직 기능으로서 시험 전달 방법을 보여준다.

There are several features of the test administration component of the progress test framework that have significant bearing on the outcome of the test results. These involve the purpose of the test, the year levels included in the test, the test delivery method, and the test frequency and duration. Figure 1 shows the test delivery method as a central organising feature of the test administration subsystem.

시험 목적 Test purpose

발달시험의 목적은 기관 전체에 걸쳐 다양하게 사용된다(형성, 총괄).

- 네덜란드 컨소시엄과 Peninsula에서는 학생들이 다음 연도 수준으로 발전하기 위해 1년 내에 모든 시험 사례의 집계 결과에 기초하여 시험을 통과해야 한다.

- 그러나, 독일과 캐나다의 컨소시엄에서는 학생들의 학습에 대한 피드백을 제공하는 결과에 주안점을 두는 형성적 접근법을 채택한다. 형성적 시험의 선택은 국가 면허 시험과 같은 외부 평가가 존재하거나 내부 등급 정책에 의해 영향을 받는 경우가 많다.

- 네덜란드 컨소시엄은 학생들이 이 항목에 높은 위험도 평가로 대응하도록 유도하고, 이에 따라 깊고 지속적인 학습을 자극하기 위해 종합 접근법을 선정했다. 또한 이 접근 방식에는 학생과 기타 이해 관계자에게 광범위한 피드백을 제공함으로써 형성적인 초점도 포함되어 있습니다(이해 관계자에게 피드백 섹션 참조).

The purpose of the progress test as a formative or summative test is variably used across institutions.

- In the Dutch consortium and at Peninsula it is summative whereby students are required to pass the test, based on the aggregated results of all instances of the test (4) in a year, in order to progress to the next year level.

- However, in the German and Canadian consortia, a formative approach is adopted in which the main focus is on the results providing feedback for the students’ learning. The choice of a formative test is often influenced by the presence of external assessment, such as a national licensing exam, or by internal grading policies.

- The Dutch consortium selected a summative approach in order to encourage students to respond to the items as a high stakes assessment and thereby to stimulate deep and continuous learning. This approach also includes a strong formative focus through the provision of extensive feedback to students and other stakeholders (see section on Feedback to Stakeholders).

어떤 목적이든 시험 피드백의 품질과 세부사항은 영향을 받지 않아야 한다.

Experience shows that whether a combined or singular purpose is chosen, the quality and detail of the test feedback should not be affected.

동기화 테스트

Test synchronicity

컨소시엄 파트너 간의 점수를 벤치마킹하기 위해서는, 한 기관의 모든 학생 코호트에 대해 시험 관리가 같은 날 동시에 이루어지는 종이 또는 컴퓨터 기반 시험인지의 동기화된 시험이 필요하다.

- 네덜란드 컨소시엄은 종이 기반 동기식 테스트를 사용하며 벤치마킹 이점이 단점을 능가한다는 것을 발견했다. 동기화된 시험을 보려고 한다면 물류 및 자원 압력을 생성한다. 이는 어느 정도 컴퓨터 기반 시험에 의해 완화될 수 있다.

- 그러나 컴퓨터 테스트에서도 다른 어려움이 발생한다. 이 배열은 보통 제한된 공간이나 컴퓨터 접근 때문에 학생들이 일괄적으로 시험받아야 한다. 이러한 상황에서 학생 집단 간에 정보가 교환되는 것을 방지하기 위해 동일한 테스트의 여러 버전이 필요하다. 이를 위해서는 아이템 뱅크에서 요구되는 아이템의 수가 크게 증가하거나 아이템을 추출할 수 있는 충분히 큰 아이템 뱅크가 필요하다.

Synchronised testing, whether paper- or computer-based in which test administrations occur on the same day at the same time for all student cohorts in an institution, or with all participating institutions in a consortium, is required in order to benchmark scores among the consortium partners.

- The Dutch consortium uses paper-based synchronised testing and has found the benchmarking benefits to outweigh the disadvantages. Synchronised testing produces logistical and resource pressures which may be alleviated by computer-based testing to some degree.

- However, other difficulties also arise with computer testing. This arrangement usually requires students to be tested in batches because of limited space or computer access. Under these circumstances, several versions of the same test are required to prevent information being exchanged between batches of students. This necessitates either a significant increase in the number of items required in the item bank or a sufficiently large item bank from which to draw items.

네덜란드의 경험은 아이템 제작 과정에서 아이템 생산량이 문제가 될 수 있다는 것을 보여주었다. 또한 테스트 버전은 동일한 난이도를 가져야 하며 제한된 자원을 가진 컨소시엄에게는 어려운 작업이 될 수 있는 엄격한 심리측정학 교정이 필요하다.

The Dutch experience has shown that the volume of item production can become problematic in the item construction process. The versions of the test also need to be of the same difficulty and require stringent psychometric calibration which may be a daunting task for a consortium with limited resources.

동기화된 시험은 구성원들이 서로 1~2주 이내에 시험을 시행하는 독일 컨소시엄(오스트리아 기관을 포함한다)과 같이 형성적 접근법을 선택하는 시스템에서 덜 중요하다. 이런 맥락에서, 시험의 형성적 특성으로 인해 부정행위로 얻을 것이 없다는 것을 의미하고, 학생 개개인의 잠재적인 형성적 이득만을 방해하기 때문이다. 학생들이 부정행위에 대한 동기가 제거되지는 않았지만, 부정행위에 대한 동기는 크게 줄어든다.

Synchronised testing is less important with systems that choose a formative approach, such as the German consortium (which includes Austrian institutions) where members administer the test within one to two weeks of each other. In this context, the motivation for students to cheat, although not removed, is greatly diminished because the formative nature of the test means there is nothing to gain for them by cheating, and only interferes with the potential formative gains for the individual student.

(학생들의 성적 수준에 맞게 시험 문항이 제공되는) Computerised adaptive testing은 이러한 압력을 더 감소시키고 synchronicity 필요성을 제거할 수 있다. 그러나 이 접근법에 따라 다른 제약조건이 발생한다. 예를 들어, 모든 항목은 사전 테스트 및 교정이 필요하며, 이는 항목 작성 요건에 상당한 부담을 줄 수 있다.

Computerised adaptive testing, in which students are administered test questions that are matched to their performance level, may also reduce this pressure further and remove the need for synchronicity. However, other constraints arise with this approach. For example, all items need to be pre-tested and calibrated which can place considerable pressure on item authoring requirements.

연도 수준, 테스트 빈도 및 테스트 크기

Year level, test frequency and test size

일부 변형이 있기는 하지만, 전 세계의 대부분의 학교는 발달시험에 프로그램의 모든 연도 수준을 포함하는 것으로 보인다(Freeman et al. 2010b).

Although there is some variation, it seems that most schools around the world include all year levels of their programme in the progress test (Freeman et al. 2010b).

그러나, 시험을 위해 선택된 항목 수("항목 번호" 위의 하위섹션 참조)와 마찬가지로 학년 내 발달시험의 빈도는 상당히 다양하며, 보통 2회(독일 컨소시엄, (Schauber & Nambers 2010)와 4회(예: 영국의 네덜란드 컨소시엄 및 학교) 사이에 차이가 있다.

However, the frequency of progress testing within the academic year, as with the number of items selected for the test (see subsection above “Item Number”) varies considerably, usually between twice (German consortium, (Schauber & Nouns 2010)) and four times (for example, the Dutch consortium and schools in the UK).

공정시험에서 항목의 빈도와 개수 선택에 대한 정해진 지침은 없으며, 비용과 자원의 가용성과 같은 요소들이 영향력 있는 고려사항이다. 시험 신뢰도 검사는 진행 중인 시험 시스템에서 시험 크기와 빈도 선택을 결정하는 데 도움이 되는 유용하고 중요한 지침이다. 이를 위해, 마스트리히트 대학교 학생들이 프로그램 6년 동안 각각 획득한 2010/2011학년도 4개 진도 시험의 총 점수(수정 점수)를 사용하여 시험당 항목 번호의 신뢰성에 대한 결합된 영향을 검토하는 최근 일반화 분석이 수행되었다.

Although there are no fixed guidelines for choosing the frequency and number of items in the progress test, and factors, such as cost and the availability of resources are influential considerations, the examination of test reliability is a useful and important guide in helping to determine the selection of test size and frequency in a progress test system. To this end, a recent generalizability analysis examining the combined effect on reliability of item number per test and test frequency was undertaken using the total scores (correction scoring) in the four progress tests of the academic year 2010/2011 obtained by Maastricht University students in each of the six years of the programme.

분석 설계에는 p(사람, 즉 학생), m(측정 사건), i:m(측정 사건 내에 내포된 문항)으로 표시된 세 가지 변동 요인이 포함되었습니다. 내포라는 용어는 측정 시마다 다른 항목 집합이 사용됨을 나타냅니다. 사람은 측정의 대상이기 때문에 관심의 분산과 관련이 있다. 측정 발생 시와 측정 발생 시 항목들은 두 개의 면을 나타내며 해당 분산은 측정 오차의 원인이 됩니다. 총 분산 Vtot은 다음과 같이 정의됩니다.

The design of the analysis involved three sources of variation indicated as p (persons, that is, students), m (measurement occasions), and i:m (items nested within measurement occasions). The term nested indicates that per measurement occasion a different set of items is used. Person is the subject of measurement and, hence, is associated with the variance of interest. Measurement occasion and items within measurement occasions represent two facets and the corresponding variances contribute to measurement error. The total variance Vtot is defined as:

여기에서 Vp, Vm, Vpm, Vpm 및 Vpi:m은 측정 시점 내 사람, 측정 시점 내 항목의 주효과, 그리고 측정 시점 내 사람과 항목의 상호작용 영향의 분산 성분을 각각 나타냅니다. 일반화 가능성 계수 G는 다음과 같이 정의된다.

where Vp, Vm, Vi:m, Vpm, and Vpi:m, represent the variance components of the main effects of persons, measurement occasions, and items within measurement occasions, and the interaction effects of persons and measurement occasions, and persons and items within measurement occasions, respectively. The generalisability coefficient G is defined as:

여기서 Nm과 Ni:m은 각각 측정 횟수와 측정 횟수 내의 항목이다.

- 일반화 가능성 분석의 첫 번째 단계인 G 연구에서 위의 분산 성분은 사용 가능한 데이터를 기반으로 추정됩니다.

- 두 번째 단계인 D 연구에서 이러한 분산 추정은 위의 식에서 Nm과 Ni:m에 대한 다양한 가상 값을 대체하여 일반화 가능성 G를 예측하는 데 사용된다.

where nopagenumbers Nm and Ni:m are the numbers of measurement occasions, and items within measurement occasion, respectively.

- In the first step of the generalizability analysis, the G study, the above variance components are estimated on the basis of the available data.

- In the second step, the D study, these variance estimations are used to predict the generalizability G by substituting varying hypothetical values for Nm and Ni:m intheexpression above.

표 1은 총 분산에 대한 다섯 가지 분산 성분의 상대적 기여도를 보여줍니다. 오차항 분산 Vpi:m, 즉 사람과 항목의 교호작용 효과가 훨씬 큰 경우(72%–78%)가 되고, Vi:m, 항목 주효과 분산(20%–27%), Vp, 사람 분산(0.7%–1.5%), 측정 사건의 주효과(0.2%–1.1%), 마지막으로 Vpm이 그 뒤를 이습니다.8%–0.24%).

Table 1 presents the relative contribution of each of the five variance components to the total variance. The error term variance

- Vpi:m, that is, the interaction effect of persons and items, is by far the largest (72%–78%), followed by

- Vi:m, the item main effect variance (20%–27%),

- Vp, the person variance (0.7%–1.5%) Vm, the main effect of measurement occasion (0.2%–1.1%), and finally

- Vpm, the interaction effect of person and measurement occasion (0.08%–0.24%).

Table 1. Percentage of total variance for each variance component in each year level for Maastricht University students Years 1-6 in the academic year 2010/11

표 2는 테스트 주파수(Nm) 및 테스트 크기(Ni:m) 값의 지정된 조합에 대해 계산된 일반화 계수 G에 대한 해당 값을 보여줍니다. 예상대로, 일반적인 패턴은 빈도 및 테스트 크기가 증가함에 따라 테스트 신뢰성이 증가한다는 것을 보여줍니다. 표 2의 결과는 또한 시험에 사용할 수 있는 총 문항의 양이 고정된 경우, 신뢰성이 [시험 크기]보다는 [빈도 증가]에 따라 더 유리해진다는 것을 나타낸다.

- 예를 들어, 표 2의 1년차에 대한 신뢰도 계수는 200개 항목에 대한 두 번의 테스트에서 0.70의 신뢰도를 얻은 반면,

- 100개 항목에 대한 네 번의 테스트는 0.74를 달성한 것을 보여줍니다.

Table 2 shows the corresponding values for the generalizability coefficient G calculated for the indicated combinations of values for test frequency (Nm),andtestsize(Ni:m. As expected, the general pattern shows that test reliability increases with increasing frequency and test size. The results in Table 2 also indicate that, given a fixed total amount of items available for testing in an academic year, reliability becomes more favourable with an increase in the frequency rather than the test size. For example,

- the reliability coefficients for Year 1 in Table 2 show that two tests of 200 items produced a reliability of 0.70,

- while four tests of 100 items achieved 0.74.

이는 G에 대한 방정식을 점검할 때 놀랄 일이 아니다: 항목의 총량을 일정하게 유지하면서 Nm이 증가하면 오차항 Vpi:m/(Nm × Ni:m)는 변하지 않지만 오차항 Vpm/Nm은 감소하므로 신뢰도가 높아질 수 있다. 따라서 신뢰도를 위해 이러한 결과는 다른 방법보다 더 많은 테스트 횟수를 지정하고 더 작은 테스트 크기를 갖는 것이 더 낫다는 것을 시사합니다. 물론 마스트리히트 대학이 이 원칙을 최대한 따르는 것을 막는 비용과 자원 가용성에 대한 실질적인 고려가 있다.

This is not surprising when inspecting the equation for G: when Nm is increased while keeping the total amount of items Nm × Ni:m constant, the error-term Vpi:m/(Nm × Ni:m) does not change, but the error-term Vpm/Nm decreases, allowing the reliability to increase. So, for the sake of reliability these results suggest that it is better to have more test occasions and a smaller test size than the other way around. Of course there are practical considerations of cost and resource availability that prevent Maastricht University from following this principle to its utmost consequence.

Table 2. G coefficients for test size (number of items) by test frequency for Maastricht University students Years 1-6 in the academic year 2010/11

표 2의 왼쪽 상단 패널은 1학년 0.80의 신뢰도를 위해, 네덜란드 컨소시엄이 현재 사용하고 있는 빈도와 시험 크기에 해당하는 학년당 4회, 시험당 200개 항목이 필요하다는 것을 보여준다. 이 빈도와 테스트 크기 역시 학년이 높아지는 경우 0.90보다 큰 신뢰도를 산출합니다(4~6년). 언뜻 보기에 이것은 불필요하게 높아 보일 수 있다. 그러나 특히 하위 도메인 점수에서 학생들에게 신뢰할 수 있는 피드백을 제공하는 것은 네덜란드 컨소시엄 발달시험 시스템의 매우 중요한 목적이었다.

The upper left panel of Table 2 shows that for a reliability level of 0.80 in Year 1, four test occasions per academic year and 200 items per test is required which corresponds to the frequency and test size currently used by the Dutch consortium. This frequency and test size also produces reliabilities greater than 0.90 for the higher years (four to six). At first glance this might seem unnecessarily high. However, providing reliable feedback to students, particularly from sub-domain scores, has been a highly valued purpose of the Dutch consortium progress test system.

이러한 하위 영역(예: 호흡계, 혈액 및 림프계, 소화계)은 일반적으로 각각 25개 미만의 항목으로 테스트에서 표현된다. 25개 항목을 포함하는 시험에 대한 모든 연도에 걸쳐 표 2의 신뢰성 계수를 검사한 결과 하위 영역 점수가 허용 가능한 신뢰도 수준에 도달하기 위해서는 연간 4회의 빈도는 과도하지 않은not overdone 것으로 나타났다. 또한, 네덜란드 컨소시엄의 경험에 따르면, 프로그램의 학년 동안 모든 연도의 빈번한 측정은 학생들의 발달 및 종방향 진행에 대한 신뢰할 수 있는 추적과 모니터링을 극대화하는 데 도움이 된다.

These sub-domains (for example, respiratory system, blood and lymph system, digestive system) are generally represented in the test with less than 25 items each. An inspection of the reliability coefficients in Table 2 across all years for tests containing 25 items demonstrates that in order for sub-domain scores to reach an acceptable level of reliability, a frequency of four occasions per year is not overdone. Furthermore, experience has shown in the Dutch consortium that frequent measurement of all year levels during the academic year of a programme helps maximise the reliable tracking and monitoring of students’ developmental and longitudinal progression.

시험 시간 Test duration

각 테스트를 완료하는 데 허용되는 기간은 전 세계적으로 2.5시간(영국)에서 5시간(NBME, 미국) 사이입니다. 테스트 기간은 [테스트 문항 수]와 [각 문항을 읽는데 필요한 시간]에 따라 크게 달라집니다. 네덜란드 컨소시엄은 학생들이 추측하는 것을 단념시키는 것과 진행 테스트가 속도 테스트가 아니라는 기본 원칙에 부합되는 것 사이에서 균형을 찾는 것이 중요하다는 것을 발견했다. 경험에 따르면 단일 항목의 답변에 허용되는 유용한 시간은 약 75~85초이다. 테스트에 대해 선택한 항목 수는 청사진에 의해 규정되지만, 이 권장 사항을 달성하기 위해서는 테스트가 읽는 데 시간이 오래 걸리는 너무 많은 항목으로 구성되지 않도록 하는 것이 중요합니다.

The duration allowed to complete each test varies worldwide between 2.5 hours (UK) to five hours (NBME, USA). The duration of the test will significantly depend on the number of items in the test and the reading time required for each item. The Dutch consortium has found that it is important to find a balance between discouraging students from guessing and being consistent with the underlying principle that the progress test is not a speeded test. Experience has shown that a useful time permitted for answering a single item is approximately 75–85 seconds. Although the number of items chosen for a test will be prescribed by the blueprint, to achieve this recommendation, it is important to ensure that the test does not consist of too many items that take a lengthy time to read.

결과분석 및 검토

Result analysis and review

발달시험 시스템의 3단계는 시험 결과의 분석과 검토이다.

The third phase of the progress test system involves the analysis and review of the test results.

점수계산방법

Score calculation method

학생의 총 점수는 그것이 계산되는 방식에 의해 크게 영향을 받는다. 사용된 두 가지 주요 점수 계산 방법은 총 점수에 기초한 점수(숫자 수정 점수 또는 수정 점수)이다.

The total score a student achieves on an MCQ test is significantly influenced by the way in which it is calculated. The main two score calculation methods used are scores based on the total score, either

- number correct or

- correction scoring.

수정채점correction scoring 또는 공식채점formula scoring은 숫자 정답 점수 매김을 고려하지 않은 추측에서 발생하는 측정 오류를 제어하기 위해 사용되었다. 학생들이 이러한 형태의 오류 분산에 관여하지 않도록 하기 위해, 네덜란드 컨소시엄은 문제의 옵션 수에 따라 오답에 대한 분수 점수가 올바른 점수에서 감점되는 잘못된 점수에 대해 패널티를 적용한다.

Correction or formula scoring has been used to control for the measurement error arising from guessing that is not taken into account with the number-correct scoring. In order to dissuade students from engaging in this form of error variance, the Dutch consortium applies a penalty for incorrect scores whereby fractional points for incorrect responses, depending on the number of options for the question, are subtracted from the correct score.

추측할 때, 정답을 얻을 확률이 더 작습니다. 예를 들어, 4가지 옵션 질문에 대한 정답을 추정할 확률은 25%이고 오답의 경우 75%입니다. 따라서 공정성을 추구하면서 오답에 대해 감점된 부분점수의 크기를 오답의 수로 나누어 계산한다. 즉, 잘못된 항목의 경우 두 가지 옵션(즉, 1→1)이 있는 항목의 총점에서 1점 만점을 차감하고, 세 가지 옵션 항목의 경우 -0.5(1→2)와 네 가지 옵션 항목의 경우 -0.33(1→3) 및 다섯 가지 옵션 항목의 경우 -0.25(1→4)를 감점한다. 이 방법은 모든 테스트 항목에 '모름' 옵션을 포함시키는 것에 의존하며, 이 옵션에 대한 응답은 0점입니다.

When guessing, the chances of achieving a correct answer are smaller than for choosing an incorrect response. For example, the chance of guessing a correct answer to a four-option question is 25% and for an incorrect answer, 75%. Therefore, in the pursuit of fairness, the size of the deducted fractional score for an incorrect answer is calculated by dividing one by the number of incorrect options. This means that for an incorrect item, a score of one is deducted from the total score for an item with two options (that is, 1÷1), −0.5 (1÷2) for three-option items, −0.33 (1÷3) for four-option items and −0.25 (1÷4) for five-option items. This method relies on the inclusion of the ‘don’t know’ option in all test items, and responses to this option are given a score of 0.

공식 채점에 대한 설득력 있는 주장과 증거가 제공되어 왔다.

- 특히 발달시험의 기본 철학과 일치한다.

- '모름' 옵션은 학생과 교사가 학습 촉진을 위해 지식 격차를 확인하는 데 있어 직접적인 정보를 제공한다.

- 또한 '모름'옵션을 사용하면 [무지의 인정]이 [그냥 찍기]보다 바람직하다는 견해를 강화한다(Tweed & Wilkinson 2009).

- 특히, 능력에 비해 너무 어려운 항목이 많은 아래 학년의 경우에 적절하다(McHarget et al. 2005).

There have been persuasive arguments and evidence provided for formula scoring.

- It is particularly consistent with the underlying philosophy of progress testing.

- The ‘don’t know’ option provides direct information for students and teachers in determining gaps in knowledge in order to promote learning.

- It's use also reinforces the view that the admission of ignorance is preferable to guessing (Tweed & Wilkinson2009), and

- is appropriate for longitudinal tests such as the progress test in which many items are too difficult for the abilities of students in the lower years (McHarg et al.2005).

Formula scoring은 개별 기관(Freeman et al. 2010a)에서 좋은 효과와 함께, 그리고 누적 편차 방법(Muijtjens et al. 2008; Schauber & 명사 2010)과 함께 학교 간의 안정적인 차이를 드러내는 방법으로 사용되어 왔다. 추측으로 인한 오차 분산도 다른 오차 분산 소스보다 큰 것으로 확인되었으며(Zimmerman & Williams 2003), [formula scoring] 점수는 [정답숫자 점수]보다 더 신뢰할 수 있는 것으로 나타났다.

Formula scoring has been used with good effect in individual institutions (Freeman et al. 2010a), and as a method of inter-institutional comparison (Schauber & Nouns 2010) together with the cumulative deviation method (Muijtjens et al. 2008; Schauber & Nouns 2010) to reveal stable between-school differences. Error variance resulting from guessing has also been found to be larger than other sources of error variance (Zimmerman & Williams 2003), and formula scoring has been shown to be more reliable than number-right scoring (Muijtjens et al. 1999; Alnabhan 2002).

그러나 점수 계산 방법에서 formula scoring을 사용하는 것은 한동안 논란이 되어 왔다.

- 예를 들어, 정확한 마이너스 오점에는 시험 응시 태도와 관련된 관련 없는 측정값이 포함되기 때문에 오차 분산을 추가할 수 있다는 주장이 제기되었다(Downing 2003).

- 또한, 어떻게 보면, 한 항목에 대한 벌칙 때문에 다른 항목에서 이미 획득한 점수가 사라지는 것으로 해석되었다.

However, the use of formula scoring in score calculation methods has been a debated issue for some time.

- For instance, it has been argued that it may add error variance because the correct minus incorrect score includes irrelevant measures related to test-taking attitude (Downing 2003).

- Also, in some quarters it has been interpreted that applying a penalty to an item results in the questionable practice of removing a mark already gained from another item.

점수 계산 방법은 쉬운 선택이 아니며 비용과 자원의 가용성의 실용성에 영향을 받을 가능성이 높다. 실제로 [발달시험]에 [[문제가 학생의 능력에 맞게 조정되는 컴퓨터 적응 시험]을 사용할 경우 문제가 완화될 수 있다(Roex & Degryse 2004). 이 접근 방식에서는 추측하는 것이 덜 문제가 되고 '모르겠다'는 옵션의 포함이 불필요해집니다. 이 단계에서는 이 접근법의 유효성을 결정하는 데 도움이 될 수 있는 의학적 발달시험에 대한 컴퓨터 적응 시험 사용을 보고한 발표된 연구가 없다.

The score calculation method is not an easy choice and one that is likely to be influenced by the practicalities of cost and availability of resources. Indeed the issue may be alleviated, if or when computer-adapted testing is used for progress testing in which questions are tailored to the ability of the student (Roex & Degryse 2004). With this approach guessing becomes less of an issue and the inclusion of the ‘don’t know’ option becomes superfluous. At this stage there are no published studies that report the use of computer adaptive testing for a medical progress test that might assist in determining the efficacy of this approach.

표준설정방법

Standard-setting method

합격/불합격 컷 점수 및 기타 점수를 결정하는 표준 설정 방법의 선택은 결과 분석 및 검토 과정의 마지막 단계이다. 일반적으로 컨소시엄의 부담stake이 높을수록 기준설정 요건이 더 까다로워진다. 합격선 점수를 결정하기 위한 진행률 테스트에는 다양한 접근법이 사용되어 왔고, 이를 설명하는 방대한 문헌이 있습니다.

The selection of a standard-setting method to determine pass/fail cut scores and other grades is the final step in the results analysis and review process. It is usually the case that the higher the stakes in the consortium, the stronger the requirements become for standard-setting. Various approaches have been used for progress testing to determine the cut scores

가장 일반적으로 사용되는 두 가지 표준 참조 방법과 준거 참조 방법 사이의 장점이 논란이 되고 있다. 각각은 장점과 단점을 가지고 있으며, 각 결과는 리소스에서 다양한 배출을 초래합니다. Muijjens 외 연구진(1998)은 발달시험 난이도의 변화 때문에 [고정된, 절대 컷오프 점수]를 사용하는 것이 [규준-참조 점수]보다 더 위태롭다는 것을 발견했다.

The merits between norm-referenced and criterion-referenced methods, two of the most commonly used, are controversial. Each has its advantages and disadvantages, and each result in varying drains on resources. Muijtjens et al. (1998) found that because of the variation in progress test difficulty, using a fixed, absolute cut off score was more precarious than norm-referenced scores.

네덜란드와 독일 컨소시엄은 컷 점수를 결정하기 위해 [Norm-referencing] 계산에 의존해 왔다(Muijtjens et al. 2008; Schauber & Nambers 2010). 비록 Angoff 프로세스처럼 [표준을 결정하기 위해 최소한의 능력의 수행에 대한 전문가 판단 간의 합의를 사용하는 방법]이 더 엄격하고 일반적으로 사용되는 방법이 더 바람직하고 방어할 수 있을지 모르나, 매년 각 시험에 대한 절차에 더 높은 비용이 수반되기에, 이 방법을 사용하기 어렵다.

The Dutch and German consortia have relied on norm referencing calculations to determine cut scores (Muijtjens et al. 2008; Schauber & Nouns 2010). Although a more rigorous and commonly used method may be more preferable and defensible, such as the Angoff process (Muijtjens et al. 1998; Verhoeven et al. 1999; Basu et al. 2004) which uses the agreement between expert judgements of a minimally competent performance to determine standards, the higher costs involved in such a procedure for each of the tests per year prevents the use of this method.

표준 참조의 대안이 될 수 있는 흥미로운 표준 설정 변형은 최근 Ricketts 등에 의해 입증되었다. (2009). 그들은 학생 테스트 결과와 새로 자격을 갖춘 의사의 외부 데이터 소스를 포함하는 다수의 내부 소스에 걸쳐 표준 설정 데이터를 삼각 측량하는 유용성을 보여주었다.

An interesting standard-setting variant that may be an alternative to norm referencing is one recently demonstrated by Ricketts et al. (2009). They have shown the usefulness of triangulating standard-setting data across a number of internal sources involving student test results and an external source of data from newly qualified doctors.

학생문항평가

Student item evaluation

네덜란드 발달시험 시스템에서, 학생들은 집에 가져갈 각 시험이 끝날 때 설명 없이 시험 책자와 정답을 제공받아 critical, substantiated 피드백을 제공할 수 있다(Muijtjens et al. 2010). 이것은 두 가지 귀중한 이점을 제공한다.

- 최종적으로 기준을 계산하기 전에 시험 결과의 사후 검토 분석 중 결함 항목의 제거를 지원함으로써 중요한 [품질 관리 메커니즘]을 제공한다.

- 또한 학생들이 지식을 복습, 확인 또는 교정하도록 격려함으로써 학생들의 더 깊은 학습을 장려한다.

In the Dutch progress test system, students are given the test booklet and correct answers without explanation at the completion of each test to take home so that they can provide critical, substantiated feedback (Muijtjens et al. 2010). This provides two valuable advantages.

- It offers an important quality control mechanism by aiding the removal of flawed items during the post-test review analysis of the test results before the final calculation of the standards.

- It also encourages students’ deeper learning by encouraging them to review, confirm or correct knowledge.

발달시험 내용에 대한 [사후 학생 검토]의 학습적 편익이 입증되었지만, 여러 기관에서 일반적인 관행은 아니다.

주로 시험 항목이 비밀로 유지되지 않는다는 단점 때문이다. 그 결과 문제은행의 효용성이 감소한다.

새로운 문항이 필요해짐에 따라 다음 시험에서 문항을 새로 써야하여 자원 수요가 증가하기 때문이다.

Although there are demonstrated learning benefits of student post-test reviews of the progress test content, it is not a common practice among institutions, mainly because of the disadvantage that the test items do not remain secret, thereby reducing the utility of the item bank and placing extra demands on resources from the increased need for new items to be written for each subsequent test iteration.

국내외 의장심사위원회

Local and national/international chair review committee

내용 타당성 및 발달시험의 신뢰성을 높이기 위한 중요한 원칙은 [시험 항목의 시험 후 전문가 품질 관리 검토서]를 제공하는 것이다. 이는 "전문가의 권고사항과 해당 권고사항에 대한 조치를 포함하여 이 검토 과정을 증명할 수 있는 과정 책임자의 능력이 내용타당성 보장의 핵심 요소"라는 권고사항과 일치한다(Bridge et al. 2003, 페이지 415).

An important principle to enhance content validity and reliability of progress testing is the provision of expert, post-test quality control reviews of test items. This is consistent with the recommendation that “the ability of a course director to demonstrate this review process, including the recommendations of the experts and the actions taken on those recommendations, is a key factor in assuring content validity” (Bridge et al. 2003, p. 415).

시험 후 검토 위원회는 모든 문항을 검토하고, 합의에 따라 최종 분석에 포함하거나 철회할 항목을 결정하여, 합격/불합격 기준을 결정한다. 또한 성과가 좋지 않은 문항을 식별하여 문제은행의 변경 또는 거절을 위해 항목 검토 위원회에 피드백을 제공할 수 있습니다. 이 정보는 또한 프레임워크의 피드백 절차의 일부로 문항 작성자에게 전달될 수 있습니다.

The post-test review committee(s) can review all items, and by consensus decide which items will be included in or withdrawn from the final analyses to determine the pass/fail standard. They can also identify questions that have not performed well and feed them back to the item review committee for change or rejection from the bank. This information can also be passed to the item author as part of the feedback procedures of the framework.

심사 위원회 구성원 구성시, [newly qualified doctor]와 정기적으로 업무를 함께하는 의사를 검토 패널에 포함시켜, 커리큘럼의 종료 시점에 요구되는 지식 수준, 즉 [newly qualified doctor]의 지식 수준을 측정하는 발달시험 원칙과 더욱 밀접하게 일치시킬 수 있다.

An adaption of the review committee membership can be to include doctors in the review panel who regularly work with newly qualified doctors, thereby more closely matching the progress test principle of measuring the knowledge level required at the end point of a curriculum, that is, of a newly qualified doctor.

이해 관계자에 대한 피드백

Feedback to stakeholders

발달시험의 기본 원칙은 더 깊은 학습을 돕기 위해 학생들에게 [발달적 및 종적 피드백]을 제공하는 효용이다. 또한 시험 결과는 항목 작성자, 교사, 교수진 및 진도 시험 개요 위원회에 귀중한 품질 관리 정보를 제공할 수 있다.

An underlying principle of the progress test is its utility in providing developmental and longitudinal feedback to students in order to aid deeper learning. The test results can also offer valuable quality control information for item authors, teachers, faculty, and the progress test overview committee.

학생들

Students

네덜란드 컨소시엄의 학생 결과에 대한 자세한 피드백은 ProF 시스템의 그래픽 질의 기반 온라인 정보를 통해 제공된다(Muijtjens et al. 2010). 그림 2는 네덜란드 컨소시엄(화이트라인)의 같은 해 모든 동료와 비교한 마스트리히트 대학 프로그램 6학년 학생의 24회 연속 측정 순간(연간 4회)에 걸쳐 보정 점수(다크라인)를 사용한 총 점수의 ProF 피드백의 예를 보여준다.

Detailed feedback of student results in the Dutch consortium is provided through graphical, query-based online information from the ProF system (Muijtjens et al. 2010). Figure 2 shows an example of the ProF feedback of total scores using correction scoring (dark line) across 24 consecutive measurement moments (four per year across the 6-year program) for a student in Year 6 of the Maastricht University program compared with all peers in the same year in the Dutch consortium (white line).

Figure 2. Longitudinal view of total scores on 24 consecutive measurement moments for a Maastricht University student compared with all peers from universities in the Dutch consortium.

네덜란드 컨소시엄의 파트너인 마스트리히트 대학교는 [학생들이 더 깊이 있는 학습을 돕기 위해] [그들의 진행 점수를 더 효과적으로 검토하도록 격려하기 위해] [멘토와의 의무적인 탐색과 반성]을 통해 학생들에게 더 많은 발판을 제공하고자 최근 교육적인 움직임을 보이고 있다.

Recent educational moves have been made by Maastricht University, a partner of the Dutch consortium, to provide more scaffolding for students through the mandatory exploration and reflection on their scores with their mentor to encourage them to more effectively examine their progress scores in order to aid deeper learning.

항목 작성자, 교사, 교수 및 개요 위원회

Item author, teacher and faculty and overview committee

또한 발달시험 점수는 품질 관리 메커니즘을 강화하기 위해 발달시험 시스템의 전반적인 기능에 대한 책임이 있는 항목 작성자, 프로그램의 교사, 교수 및 개요 위원회의 중요한 정보 출처이다. 예를 들어,

- 여러 시험에 걸쳐 구성한 특정 항목에 대한 신뢰성 점수를 문항 작성자에게 제공하는 것은 항목 작성자가 자신의 장점을 결정하고 약점을 인식하고 해결하는 데 도움이 되는 유용한 정보가 될 수 있다.

- 피드백은 다음에 관한 교사들의 진단, 예후 또는 교정 개입에 도움이된다.

- 교육과정 개발 및 교직원의 quality assurance 을 지원

- 관리위원회Overview committee의 발달시험 시스템의 개선을 가이드

Progress test scores are also an important source of information for item authors, teachers in the programme, faculty and the overview committee who has responsibility for the overall functioning of the progress test system in order to foster quality control mechanisms. For example,

- providing the item authors with reliability scores for the specific items they constructed over several tests can be useful information in assisting them to determine their strengths and help recognise and address their weaknesses.

- Feedback is also useful to teachers to assist with diagnostic, prognostic or remedial interventions,

- for curriculum development and quality assurance for faculty, and

- for guiding improvements in the progress test system for the overview committee.

결론 Conclusions

네덜란드 컨소시엄은 25년 역사를 통해 개선된 방법과 접근법이 개발 또는 연구됨에 따라 프레임워크의 다양한 측면을 몇 차례 변형시켰다. 이는 개선된 품질 관리 메커니즘을 유지하는 강력하고 체계적인 프레임워크를 유지하는 데 도움이 되었다. 새로운 학교로서, 페닌슐라는 10년간의 발달시험 역사 (Freeman & Ricketts 2010)에서 가장 좋은 증거를 도출할 수 있었고, 그 결과 비교적 안정적인 형식이 되었다. 그러나 의료 교육의 변화하는 환경을 반영하기 위한 피드백 방법 및 표준 설정 공식의 적응과 같은 변화가 일어났다.

Over its 25 year history, the Dutch consortium has proceeded through several transformations of various aspects of the framework as improved methods and approaches have been developed or researched. This has helped to maintain a robust and systemic framework within which to maintain improved quality control mechanisms. As a new school, Peninsula was able to draw on best evidence in its 10 year history of progress testing (Freeman & Ricketts 2010) resulting in a relatively stable format. However changes have occurred, such as increasing feedback methods and adaptations of standard setting formulae to reflect the moving environment of medical education.

이번 분석에 따르면, 만족스러운 수준의 타당성과 신뢰성을 촉진하도록 보장하려면, 발달시험의 구현과 유지보수를 위한 기관의 헌신과 가용자원이 필요하다는 것을 보여준다.

- 품질 시스템의 기본 요건은 커리큘럼이 mature함에 따라 [블루프린트의 개발 및 업데이트]가 필요하다는 것을 보여주며,

- 학제 간, 맥락화된, 관련성 높은 문항을 생성하기 위해 [지속적인 문항 작성 훈련]을 제공하기 위한 상당한 노력이 필요하다.

- [결과의 분석 및 검토]에는 몇 가지 품질 관리 점검이 필요하며,

- [이해관계자에 대한 피드백]은 분석과 모니터링을 필요로 하며,

- [소프트웨어와 하드웨어]에 대한 자금 투자와 서포트에 대한 헌신은 성공적인 운영의 중요한 특징이다.

The present analysis of the framework also shows that its implementation and maintenance requires an institutional commitment and the availability of resources to ensure it promotes satisfactory levels of test validity and reliability.

- The basic requirements of a quality system show that a blueprint requires development and updating by reviewers as curricula mature, and

- considerable efforts are required to provide ongoing item writing training in order to produce interdisciplinary, contextualised and relevant items (Vantini & Benini 2008).

- The analysis and review of results requires several quality control checks, feedback to stakeholders requires analysis and monitoring, and

- a commitment to software and hardware funding and support are important features of a successful operation.

Med Teach. 2012;34(9):683-97.

doi: 10.3109/0142159X.2012.704437.

A systemic framework for the progress test: strengths, constraints and issues: AMEE Guide No. 71

William Wrigley 1, Cees P M van der Vleuten, Adrian Freeman, Arno Muijtjens

Affiliations collapse

Affiliation

- 1Department of Educational Development and Research, Maastricht University, The Netherlands.

- PMID: 22905655

Abstract

There has been increasing use and significance of progress testing in medical education. It is used in many ways and with several formats to reflect the variety of curricula and assessment purposes. These developments have occurred alongside a recognised sensitivity for error variance inherent in multiple choice tests from which challenges to its validity and reliability have arisen. This Guide presents a generic, systemic framework to help identify and explore improvements in the quality and defensibility of progress test data. The framework draws on the combined experience of the Dutch consortium, an individual medical school in the United Kingdom, and the bulk of the progress test literature to date. It embeds progress testing as a quality-controlled assessment tool for improving learning, teaching and the demonstration of educational standards. The paper describes strengths, highlights constraints and explores issues for improvement. These may assist in the establishment of potential or new progress testing in medical education programmes. They can also guide the evaluation and improvement of existing programmes.

'Articles (Medical Education) > 평가법 (Portfolio 등)' 카테고리의 다른 글

| 3학년 학생의 임상수행능력평가와 학생과 평가자 성별의 관계(Acad Med, 2017) (0) | 2021.07.28 |

|---|---|

| 공정하게 만들기: 학습자와 평가자의 공정한 평가에 대한 관점 (Med Educ, 2021) (0) | 2021.07.17 |

| 발달시험 활용(Perspect Med Educ, 2012) (0) | 2021.04.25 |

| 의과대학에서 발달시험: 네덜란드의 경험 (Perspect Med Educ, 2016) (0) | 2021.04.25 |

| 의학교육에서 평가의 역사(Adv Health Sci Educ Theory Pract, 2020) (0) | 2021.02.03 |