성과 프레임워크를 평가 프레임워크로 번역하기: 타당도에 대한 함의(Med Educ, 2020)

Translating outcome frameworks to assessment programmes: Implications for validity

Walter Tavares1 | Paula Rowland1 | Damon Dagnone2 | Laura A. McEwen2 |

Stephen Billett3 | Matthew Sibbald4

1 소개

1 INTRODUCTION

역량 기반 의료 교육(CBME)의 핵심 프로세스는 [어떻게 교육자가 임상 역량을 평가하는지]이다. [성과]와 [역량]은 임상의가 독립적으로 실습할 수 있도록 하기 위해 [보유하고 입증해야 하는 실천의 특징]을 설명하는 역할을 한다. 예를 들어, '신뢰할 수 있는 전문적 활동'(EPA)은 훈련생 개발에 필수적인 연습의 특징을 포착하고 독립적으로 연습할 준비를 보장하기 위한 개인 수준의 역량을 포함하는 기술 업무이다. 교육자는 복잡한 구성의 표현이나 특정 결과의 달성을 용이하게 하고 교육생 준비 상태에 관한 종합적 결정을 알리기 위한 최선의 평가 전략 조합을 개발, 선택 및 계획해야 한다. 그러나 개인과 조직이 이러한 [성과 목록]을 [평가 계획]으로 [번역translate]하는 과정에서 이 복잡한 과제의 과제가 명백해진다. 성과 프레임워크가 '번역'되는 과정에서 (성과 프레임워크에서 평가 계획을 생성하는 능동적 프로세스를 의미함) 여러 가지 불명확한 영향, 가정 및 문제가 있는 번역은 [평가의 어떤 근본적 원칙과 일치하지 않을 수 있습니다]. 그것은 바로 평가의 [타당성]이다.

A key process within competency-based medical education (CBME) is how educators structure assessment of clinical competence.1 Outcomes and competencies serve to describe features of practice that clinicians must possess and demonstrate in order to be permitted to practise independently. For example, ‘entrustable professional activities’ (EPAs) are descriptive work tasks that include person-level competencies intended to capture features of practice essential in developing trainees and ensure their readiness to practise independently.2 Educators are tasked with developing, selecting and planning the best combination of assessment strategies to facilitate representation of the complex constructs or achievement of specific outcomes, and to inform summative decisions regarding trainee readiness. However, the challenge of this complex task becomes apparent as individuals and organisations translate these lists of outcomes into assessment plans.3 As outcome frameworks are ‘translated’ – referred to in this case as the active process of generating assessment plans from outcome frameworks – a number of unarticulated influences, assumptions and problematic translations may create misalignments with a foundational tenet of assessment: assessment validity.

평가 계획의 설계는 일반적으로 핵심 기능core function에 초점을 맞춘다. 그러다보면 더 넓은 범위의 성과 프레임워크를 수용하거나, 이러한 계획에 대한 의사결정을 형성에 미치는 영향의 가변성을 고려하지 않게 된다.

- 예를 들어, 척도scale 개발은 종종 [항목, 차원, 자극, 활동을 식별하는 것]으로 시작한다. 이것들이 평가 대상 구인contruct의 표현representation을 집합적으로 지원한다고 여긴다. 다른 평가 설계 특징들은 맥락 특이성을 극복하고, 평가자 경향을 식별 및 조정하고, 데이터의 다양한 점들의 집합의 가치, 서술적 또는 철학적 위치의 가치를 고려하는 기능적 필요성에 초점을 맞추었다.

그러나 [성과 프레임워크]를 [평가 계획]으로 [변환translate]하는 [상류 프로세스]뿐만 아니라, [영향의 유형, 역할 및 임팩트는 무엇이고], [누가 그러한 영향을 발생시키고] [왜 발생하는지] 등은 일반적으로 기존 프레임워크에서 명시적으로 설명되지 않았다. 따라서 이러한 영향을 식별하고 탐색하는 방법에 대한 명확한 지침이 없으면, 평가 타당성(즉, 데이터의 신뢰성과 방어성)이 훼손될 수 있다.

The design of assessment plans has typically focused on core features, without having to accommodate large outcome frameworks or taking into consideration the variable impact of influences that may be shaping decisions about those plans.4-6

- For example, scale development often begins with identifying items or dimensions, stimuli or activities that collectively support representation of the construct to be assessed.7 Other assessment design features have focused on the functional need to overcome context specificity,8 to identify and then adjust for rater tendencies,9 and to consider the value of assembling diverse points of data,10 and the value of narratives11 or philosophical positions.12

However, the upstream process of translating outcomes frameworks to assessment plans, as well as the type, role and impact of influences, who generates those influences and why, have generally not been explicitly featured in existing frameworks. Assessment validity (i.e. trustworthiness and defensibility of the data) may therefore be undermined without clear guidance on how to identify and navigate these influences.

CBME 맥락에서 [평가 설계]의 [사회학적 및 사회문화적 설명accounts]을 사용하면, [성과 프레임워크에서 평가 계획으로의 변환translation]에 유용한 정보를 제공할 수 있다. 유사한 이론적 접근법들이 보건직 교육, 고등 교육, 학습 도구로서의 표준과 표준화의 용도 변경, 전문적 학습의 평가 관행에서의 활동을 탐구하기 위해 사용되어 왔다. [Callon의 번역 이론]은 한 일련의 관행(예: 결과 프레임워크 생성)에서 다른 일련의 관행(예: 평가 계획 생성)으로 번역하는 과정을 이해하고 설명하는 한 가지 방법입니다. 캘런의 번역 이론은 [번역 행위]가 단지 [인지적 행위]가 아니라, [사회적, 정치적, 물질적 행위]임을 시사한다.

Using sociological and sociocultural accounts of assessment designs in a CBME context can inform the translation from outcome frameworks to assessment plans.13 Similar theoretical approaches have been used to explore activities in health professions education, in higher education, in repurposing standards and standardisation as learning tools, and in practices of assessment of professional learning.14-16 Callon's theory of translation17 is one way to understand and explain processes involved in translating from one set of practices (e.g. creating outcome frameworks) to another (e.g. creating assessment plans). Callon's theory of translation suggests that the act of translation is not just a cognitive exercise, but also social, political and material acts.17

하나의 맥락 또는 형태(예: 결과 프레임워크)에 존재하는 아이디어를 다른 개념(예: 평가 계획 및 그 구현 및 사용)으로 변환translate하려면,

- 개인이나 집단은 그들의 아이디어와 다른 맥락과 관련된 이슈들 사이의 적합성에 대해 다른 사람들을 설득해야 한다.

- 또한 제안된 조치가 바람직하고 적절한 해결책이라는 것을 다른 사람들에게 납득시켜야 한다.

- 이 과정을 통해 개인은 또한 다른 사람을 물질적 행위, 관련 행위자(즉, 사람, 그룹 및 위원회뿐 아니라, 학습 플랫폼 및 기술과 같은 물질적 객체까지)가 원하는 활동에 지속적으로 참여하도록 하고, 상충적 요구는 줄이며, 피할 수 없는 논란을 관리해야 한다.

이러한 [업스트림 프로세스]는 프로세스 중에 보이지 않을 수 있으며, 항상 타당성이 우선되는 것도 아니며, 평가 계획이 작성된 시간에 의해 불변할 수 있습니다.

To translate an idea existing in one context or form (e.g. outcome frameworks) to another (e.g. assessment plans and their implementation and use),

- individuals or groups must convince others of the fit between their idea and issues related to that other context.

- They must also convince others that the proposed action is a desired and appropriate solution.

- Throughout this process, individuals must also enroll others in material acts, strategise to keep involved actors (i.e. people, groups and committees, but also material objects such as learning platforms and technologies) engaged in the desired activity and reduce competing demands, and manage any inevitable controversies.17

These upstream processes may be invisible during the process, not always prioritising validity, and immutable by the time assessment plans have been created.

이러한 관점에서 CBME는 [성과 프레임워크에서 평가 계획으로 이동]할 때, 평가 과학에 대한 새로운 도전을 제기한다. 내용과 맥락에 대한 통제를 행사할 수 있는 평가 설계(예: 필기 시험 및 OSCE)와 달리, CBME와 직장 기반 평가(WBA)의 맥락은 교육 및 커리큘럼 설계에서 새로운 개념이 아닌 다양한 경쟁 상황 요인을 수용해야 할 수 있다. 예를 들어, 빌렛은 직장 커리큘럼이 직장 및 배우의 능력과 이해관계, 그리고 그 안에서 그들의 책임에 따라 결정된다는 것을 증명했다. 평가에 적용했을 때, 상류 번역 활동upstream translational activities에 대한 초점은 평가 설계 외부의 기능이 관련성이 있으며 일단 평가 계획이 작업장에서 제정되면 예상된 사건 이상으로 확장된다는 것을 시사한다. 역사적으로 평가 과학은 타당성에 대한 다른 위협(위에서 설명한 바와 같이) 대신 이러한 특징들을 강조하지 않았다. 그들의 강조점을 고려할 때, 사회학적, 사회문화적 이론(예: 칼론의 번역 이론)은 이러한 특징들을 시야에 가져오는데 도움을 준다.

Viewed in this way, CBME invites a new challenge for assessment science when moving from outcome frameworks to assessment plans. Unlike assessment designs that exist where control over content and context can be exercised (e.g. written tests and OSCEs), the context of CBME and workplace-based assessments (WBA) may require accommodating a range of competing situational factors,18 a concept that is not new in education and curricular design.19, 20 For example, Billet demonstrated that the workplace curriculum is subject to the affordances and interests of the workplace and actors and their responsibilities within it.20 Applied to assessment, the focus on upstream translational activities suggests features external to assessment design are relevant and extend beyond anticipated events once assessment plans are enacted in the workplace. Historically, assessment science has de-emphasised these features in place of other threats to validity (as described above).21 Given their emphases, sociological and sociocultural theories (e.g. Callon's theory of translation) help to bring these features into view.

우리가 [번역 과정]을 잘 이해하고 설명할 수 있다면, 효과적인 성과 기반 교육과 타당한 평가 프로그램을 발전시킬 가능성이 있다. 예를 들어 역량 위원회가 [고부담 평가를 구성하거나 학습자가 개발 전략을 구성하기 위해 사용하는 데이터]는 생성된 데이터의 신뢰성과 방어성에 따라 달라진다. 이를 잘 수행하면, 특히 직장 기반 맥락에서 평가 커뮤니티에 도전하고, 번역 활동이나 타당성 평가의 영향을 종종 무시하는 다양한 접근 방식(예: 평가자, 도구 및 교수진에 집중)을 자극한다.

If we can understand and illustrate the translational process well, there is a potential to advance effective outcome-based education and valid assessment programmes. For instance, the data on which competence committees structure high-stakes assessment, or learners use to structure developmental strategies, are dependent on the trustworthiness and defensibility of the data generated. Doing this well, particularly in workplace-based contexts, challenges the assessment community and stimulates diverse approaches (e.g. focusing on raters, tools and faculty development) that often neglect translational activities or evaluation of their impact on validity.

따라서 본 연구에서는 캐나다 대학의 대학원 의학 교육(PGME)에서 무엇이 결과 프레임워크를 형성적이고 종합적인 평가 계획으로 [번역translation]하는지, 구체적으로 어떻게 어떤 도구와 프로세스가 구축되었는지, 그리고 왜 역량 위원회가 데이터를 사용할 것인지 물었다. 또한, 이러한 프로세스는 어떻게 정당화되거나 평가됩니까? 우리는 번역이 인지적, 실제적, 사회적, 정치적 활동이라는 관점에서 이 작업을 배치했지만, 특히 개인에 대한 총괄적 결정(예: 역량 위원회에서 사용하기 위한)의 정점에 기여할 때 타당성도 고려해야 한다. 우리는 타당성을 위협할 수 있는 긴장과 과제를 완화하기 위한 최적화 전략과 방법을 식별하고 조명하는 것을 목표로 했다. Callon의 번역 이론과 Kane의 유효성 및 검증 프레임워크가 관련된 경우를 포함하여 결과 프레임워크를 사용할 때 평가 설계의 단순화된 프로세스에 대한 설명은 그림 1을 참조하십시오.

Therefore, in this study we asked

- what shapes the translation of outcome frameworks to formative and summative assessment plans in postgraduate medical education (PGME) in Canadian universities,

- specifically how and what tools and processes were built and why, the data from which would be used by competence committees.

- Also, how are these processes justified or evaluated?

We positioned this work with a view that translations are cognitive, practical, social and political activities, but that validity should also be considered, particularly when contributing to the culmination of summative decisions about individuals (e.g. for use by competence committees). We aimed to identify and illuminate optimising strategies and ways of mitigating tensions and challenges that may threaten validity; see Figure 1 for an illustration of a simplified process of assessment design when using outcome frameworks, including where Callon's theory of translation17 and Kane's validity and validation framework21 are relevant.

2 방법

2 METHOD

2.1 연구 개요

2.1 Study overview

우리는 [실제 또는 계획된 평가 전략]뿐만 아니라, [평가-기반 번역 활동]에 중점을 두고 PGME 프로그램의 개별 대표자(예: 프로그램 감독), 평가 위원회 및/또는 CBME 구현 위원회와 심층 반구조화된 인터뷰로 구성된 정성적 연구를 수행했다. 인터뷰는 분석을 위해 기록되고 기록되었으며, 여기에는 [지시된directed 내용 분석]에 의해 안내된 방법이 포함되었다. 우리는 Callon의 번역 이론과 Kane의 유효성 프레임워크를 모두 사용하여 작업을 안내했다.

- Callon의 번역 이론(위에서 설명한)은 번역 프로세스의 구체적인 dynamics에 주의를 기울이고, 인터뷰 가이드의 구조를 형성하는 데 사용되었다. 번역 과정이 어떻게 제정되는지에 대한 이러한 이론은 특히 관련된 다양한 사람, 그룹 및 기관(즉, 학술, 전문, 임상, 규제 및 일선)의 CBME 수행에 대한 우리의 관찰과 잘 일치한다.

- 케인의 타당성 프레임워크는 평가 프로세스에서 생성된 데이터에 기초한 추론을 뒷받침하는 증거의 문제로서 타당성을 강조하는 반면, validation은 평가 프로세스에서 가정을 식별하고 테스트하는 프로세스를 포함한다.

We conducted a qualitative study comprising in-depth semi-structured interviews with individual representatives of PGME programmes (e.g. programme directors), assessment committees and/or CBME implementation committees, focusing on their assessment-based translational activities as well as actual or planned evaluation strategies. Interviews were recorded and transcribed for analysis, which involved methods guided by directed content analysis.22 We used both Callon's theory of translation and Kane's validity framework to guide our work.

- Callon's theory of translation (described above) was used to direct our attention to specific dynamics of the translation process and to shape the structure of our interview guide. This theorisation of how translational processes are enacted aligned well with our observations of the undertaking of CBME, in particular the various people, groups and institutions (i.e. academic, professional, clinical, regulatory and frontline) involved.

- Kane's validity framework emphasises validity as a matter of evidence in support of inferences based on data generated in an assessment process, whereas validation involves the process of identifying and testing assumptions in the assessment process.

우리는 이 유연한 argument-based framework를 사용하여 분석에서 주의를 기울이며 평가 타당성을 위한 번역 프로세스의 가능한 의미를 도출했다. 2018년 5월 토론토 대학교에서 윤리적인 승인을 받았다(프로토콜 #8333). 이 연구와 관련된 현장으로부터 추가적인 윤리적 승인을 얻었다.

We used this flexible argument-based framework to direct our attention in the analysis, drawing out possible implications of the translation process for assessment validity. Ethical approval was provided by the University of Toronto in May 2018 (Protocol #8333). Additional ethical approvals were obtained from the sites involved in this study.

2.2 설정, 샘플링, 정보제공

2.2 Setting, sampling and informants

이 연구는 캐나다 왕립 의사 및 외과의사 대학(RCPS)의 시행 및 인가 지침에 따라 CBME를 이행해야 하는 의무가 있는 세 개의 캐나다 대학 PGME 프로그램에서 수행되었다. 3개 기관을 선정함으로써 CBME의 평가에 대한 가변적variable 접근 방식을 표집 및 반영하고, 개념적 전이 가능성을 탐색하고, 질적 엔드 포인트(예: 정보력information power)를 촉진하려는 우리의 의도가 촉진되었다. 세 기관 모두 CBME의 구현에 참여했지만, 그들의 프로그램은 뚜렷한 구조와 프로세스를 가지고 있고, 개발, 구현 및 평가 단계에 있으며, 서로 다른 문화적 또는 교육적 맥락에 있다. 모두 CBME 구현 리드leads를 가지고 있었으며 교육, 평가 및 프로그램 평가 전문가와 접촉할 수 있었다. 우리는 [성과 프레임워크]를 출발점으로 하여, 평가 계획 개발에 참여한 것으로 확인된 프로그램 책임자 또는 그 대표자 및/또는 위원회 구성원을 모집하기 위해 목적적이고 최대 변동 표본 추출 전략을 사용했다. 우리의 모집 전략에는 PGME 리더십에 의해 연구팀이 이용할 수 있는 내부 목록을 사용하여 잠재적 제보자에게 이메일로 연락하는 것이 포함되었습니다. 우리는 프로그램 감독 수준에서 시작해서 평가 위원회 구성원을 포함하도록 확장했다.

This study took place within three Canadian university PGME programmes, which had mandates to implement CBME under the implementation and accreditation guidelines of the Royal College of Physicians and Surgeons of Canada (RCPS). Selecting three institutions facilitated our intention to sample and reflect variable approaches to assessment in CBME, to explore conceptual transferability and to promote qualitative end points (e.g. information power). All three institutions were involved in the implementation of CBME but their programmes have distinct structures and processes, were at different development, implementation and evaluation stages, and in dissimilar cultural or educational contexts. All had CBME implementation leads and had access to education, assessment and programme evaluation experts. We used purposeful and maximum variation sampling strategies to recruit programme directors or their delegates and/or committee members from various specialties who identified as having participated in the development of assessment plans using outcome frameworks as a starting point.23 Our recruitment strategy involved contacting potential informants by e-mail using internal lists made available to the research team by PGME leadership. We began at the programme director level then expanded to include assessment committee members.

2.3 인터뷰 가이드

2.3 Interview guide

개념적 틀을 통해 우리는 인터뷰 가이드를 세 가지 주요 목표 영역으로 구성했다.

- (i) 평가 프로그램 개발의 설명 및 상황 파악(예: EPA의 사용 방법, EPA의 사용 방법, 기타 비 EPA 평가의 사용, EPA와 비 EPA의 실행 방법)

- (ii) 성과 프레임워크를 특정 평가 계획으로 변환하는 것과 관련된 현재의 의사 결정 관행을 포함하여 번역translation 프로세스의 탐구 (예: 의사 결정 방법, 평가 계획 수립에 관여한 기타 작업, 계획 또는 이행 과정에서 어떤 변경 또는 과정 수정이 이루어졌는가)

- (iii) 평가 계획의 퀄리티와 타당성을 지원하는 프로그램 평가 활동 또는 계획(예: 구현과 관련된 공식 또는 비공식 평가 활동, 평가 의사 결정의 엄격함을 보장하기 위해 만들어진 계획 및 고려 사항)에 대한 언급

우리는 번역과 평가 과정의 다양한 순간을 탐구하기 위해 프롬프트와 함께 개방형 질문을 사용했다. 또한 인터뷰 가이드가 반복적으로 진화할 수 있도록 허용하고 정보원으로부터 사회 인구학적 세부 사항을 수집했다.

Informed by our conceptual framing, we organised our interview guide into three main target areas:

- (i) descriptions and contextualisation of assessment programme development (e.g. how EPAs are being used, how decisions are being made about how EPAs will be used, the use of other non-EPA assessments, and how EPAs and non-EPAs are put into practice);

- (ii) exploration of the translation process, including current decision-making practices related to the translation of outcome frameworks into specific assessment plans (e.g. how decisions were made, other work that was involved in launching assessment plans, and what shifts or course corrections were made in the process of planning or implementation); and

- (iii) accounts of programme evaluation activities or plans that would support the quality and validity of the assessment plans (e.g. formal or informal evaluation activities related to implementation, and plans made and considerations taken to ensure the rigour of assessment decision making).

We used open-ended questions with prompts to explore the various moments in the translation and evaluation processes. We also allowed the interview guide to evolve iteratively and collected sociodemographic details from informants.

2.4 데이터 수집

2.4 Data collection

면접은 정성적 연구면접 교육을 받은 연구조교와 연구팀 구성원(WT, PR, MS)이 맡았다. 면접관은 제보자의 기관에 따라 결정되었으며, 잠재적인 갈등이나 인식된 갈등을 회피하고, 면접관과 제보자의 가용성 등을 고려하여 결정되었다. 인터뷰는 직접 또는 전화를 통해 이루어졌으며, 음성녹음 및 문자 그대로 녹음되었다. 이러한 transcript는 정확성을 검사하여 정성 분석 소프트웨어(HyperRESOURCETM)에 업로드되었습니다. 우리는 우리의 연구 목표를 더 잘 다루고 명확화, 발산과 수렴의 실마리를 찾기 위해 샘플링과 인터뷰를 수정하기 위해 채용, 데이터 수집, 분석 및 팀 회의의 주기적이고 반복적인 과정을 계속했습니다. 이 과정은 저자들이 분석이 세 가지 엄격한 기준에 적합하다는 데 동의할 때까지 계속되었다.

- (i) 이론적인 주장이 경험적 자료에 근거하는지 확인할 수 있는 충분한 깊이가 있었다.

- (ii) 제기되는 주장은 개념적 타당성을 가지고 있다.

- (iii) 해당 주장이 더 광범위한 학술 공동체와 관련이 있었다.

Interviews were conducted by a research assistant trained in qualitative research interviewing and members of the research team (WT, PR and MS). The interviewer was decided based on the informant's institution, to avoid potential or perceived conflicts, and availability of the interviewer and informant. Interviews were conducted in person or via telephone, audio-recorded and transcribed verbatim. These transcripts were checked for accuracy and uploaded into qualitative analysis software (HyperRESEARCHTM). We continued in a cyclical and iterative process of recruitment, data collection, analysis and team meetings to allow our sampling and interviews to be modified to better address our research aims and to seek threads of clarification, divergence or convergence. This process continued until the authors agreed the analysis fitted three criteria of rigour:

- (i) there was sufficient depth to ensure the theoretical claims being made were grounded in empirical material,

- (ii) the claims being made held conceptual plausibility and

- (iii) the claims had relevance to a broader academic community.24

2.5 분석전략

2.5 Analytical strategy

우리의 분석 전략은 위에서 설명한 개념적 프레임워크에 의해 안내될 수 있도록 [유도된direted 콘텐츠 분석]을 포함했다. CBME와 일관되게, 우리는 우리의 정보원이 형성적 목적을 위해 평가를 구조화하고 있다고 가정했지만, 생성된 데이터는 데이터를 생성과 해석에 어느 정도의 타당성 증거를 의무화하면서, 총괄적 의사 결정에도 사용될 것이다. 우리의 의도는 타당성과 관련된 번역 문제를 고려하는 것이었으므로, 우리는 평가 계획의 개발 및 제정에서 억제되지 않은 가정이 존재할 수 있는 곳에 민감하게 반응하기 위해 케인의 프레임워크를 사용했다.

Our analytical strategy comprised directed content analysis,22 which allowed us to be guided by our conceptual frameworks as described above. Consistent with CBME, we assumed that our informants were structuring assessments for formative purposes, but that data generated would also be used for summative decisions, obligating a degree of validity evidence in both generating and interpreting data. Given that our intention was to consider translational issues regarding validity, we used Kane's framework to sensitise ourselves to where unchecked assumptions may exist in the development and enactment of assessment plans.

정확성을 확인한 후, 연구팀 구성원들은 데이터 세트 전체에 대한 일반적인 인상을 얻기 위해 먼저 대본을 읽었다. 우리는 우리의 개념적 프레임워크가 우리의 데이터 읽기 및 코딩에 정보를 제공할 수 있도록 했다. 우리의 개념적 틀과 철학적 위치를 사용하여, 두 번째 읽기는 지시적 콘텐츠 분석과 일치하는 개방 코딩과 분석적 메모 작성을 포함했다. 개방 코딩에 이어, 우리는 데이터 세트, 다양한 상황 및 우리의 개념 프레임워크에 걸쳐 체계적으로 주제를 탐구하기 위해 축 코딩(즉, 링크 설정)에 관여했다. 연구팀의 구성원들은 중간 분석, 인터뷰 가이드의 개정, 분석과 위치의 삼각측량에 대해 논의하기 위해 정기적으로 만났다.

After confirming accuracy, research team members first read the transcripts to garner a general impression of the dataset as a whole. We allowed our conceptual frameworks to inform our reading and coding of the data. Using our conceptual framing and philosophical positions, the second reading involved open coding and analytical memo taking, consistent with directed content analysis.22 Following the open coding, we engaged in axial coding (i.e. establishing linkages) to systematically explore themes across the dataset, various situations and our conceptual framework. Members of the research team met regularly to discuss interim analyses, revisions to the interview guide and triangulation of analyses and positions.

2.6 연구자의 입장

2.6 Researcher stance

모든 녹취록은 세 명의 연구팀 구성원에 의해 검토되고 코딩되었으며, 각각은 서로 다르지만 중복되는 개념적 또는 철학적 위치에서 데이터에 접근했다. 여기에는 임상, 교육, 구현, 사회학적 및 타당성 관점에서 정보를 제공하는 관점이 포함되었다. 이러한 다양한 기본 렌즈를 통해 가능한 상황별 실제 의미와 함께 번역 활동과 관련된 다양한 기능을 고려할 수 있었다. 또한, 모든 연구자들은 CBME 맥락에서 평가와 관련된 다양한 활동과 관련하여 서로 다른 위치를 가지고 있음에도 불구하고 구성주의자 또는 해석적 입장을 채택했다.

- MS는 번역 과정에 참여하는 연구자이자 프로그램 감독이다.

- WT는 번역 과정에서 프로그램을 지원하는 역할을 하는 평가 과학자이다.

- PR은 직장에서 전문적인 학습에 관심이 있는 연구원이다.

All transcripts were reviewed and coded by three research team members, each approaching the data from different, but overlapping, conceptual or philosophical positions. These included views informed by clinical, educational, implementation, sociological and validity perspectives. These diverse underlying lenses allowed us to consider the various features associated with translational activities, along with possible contextualised practical implications. Further, all researchers adopted a constructivist or interpretive stance despite having different locations in relation to the various activities associated with assessment in a CBME context.

- MS is a researcher and programme director involved in the translational process.

- WT is an assessment scientist with a role in supporting programmes in their translational processes.

- PR is a researcher with an interest in professional learning in workplaces.

우리는 스스로를 '관심 없음dis-interested'으로 여겼는데, 이는 우리가 어떤 접근 방식을 지지하거나 반대하지 않고도 번역 프로세스와 평가 타당성에 대한 잠재적인 의미를 연구할 수 있다는 것을 의미하며, 단지 번역을 하는 사람들의 관점을 목격할 뿐이다. 우리는 타당성(또는 일반적으로 정당성 또는 평가 활동)이 평가 설계 및 계획에서 내재된 고려 사항이라는 기본 가정을 가지고 이 작업에 접근했다. 그러나, 우리는 또한 많은 사람들이 동등한 관심사로 신뢰성에 초점을 맞추기 때문에, 이것이 모든 관련자들에게 보편적으로 적용되는 원칙은 아닐 수 있다는 것을 인정한다.

We considered ourselves as ‘dis-interested’,25 meaning we could study the translational process and its potential implications for assessment validity without advocacy for or against any approach, but simply witnessing the perspective of those doing the translation. We approached this work with the underlying assumption that validity (or justification or assessment activities in general) is an inherent consideration in assessment designs and planning. However, we also recognise that this may not be a universally held principle for all involved, as many focus on reliability as an equal concern.

3 결과

3 RESULTS

캐나다 3개 대학에 걸쳐 15개의 서로 다른 PGME 프로그램의 여성 16명과 남성 8명을 대상으로 평균 50분 동안 총 24건의 인터뷰가 실시되었으며(12회, 7회, 5회 인터뷰) 이를 통해 데이터 수집 전략에 명시된 엄격성rigour과 적용 범위coverage 수준을 달성할 수 있었다. 모든 인터뷰 대상자는 지역 또는 국가에서 개발한 결과 프레임워크에서 평가 계획을 수립했다. 프로그램은 평가 프로그램을 수립할 때 [전혀 지원과 투입이 없는 것(즉, 홀로 활동하는 프로그램 감독)]에서부터, [평가 위원회와 교육 및 평가 과학자에 대한 접근성]에 이르기까지 지역적인 투입과 지원의 정도가 다양했다. 또한, 모든 인터뷰 대상자는 인증 기관의 지원을 받고 있으며, 평가 계획에 의해 생성된 평가 데이터가 진행, 승진 및 종합 의사결정에 사용될 역량 위원회를 설립했다고 보고했다. 인터뷰 대상자 중 일부는 이 연구와 관련된 두 가지 이상의 역할을 맡았는데, 예를 들어 프로그램 감독일 뿐만 아니라 역량 위원회나 평가 위원회의 직책을 맡고 있다.

A total of 24 interviews averaging 50 minutes were conducted with16 women and 8 men from 15 different PGME programmes across the three Canadian universities (12, seven and five interviews), which allowed us to achieve the levels of rigour and coverage specified in our data collection strategy. All interviewees had developed assessment plans from outcome frameworks that had been developed locally or nationally. The programmes varied in the degree of local input and support they had in establishing assessment programmes, from none at all (i.e. programme directors working independently) to access to assessment committees, and education and assessment scientists. Also, all interviewees reported having support of the accreditation body and had established competence committees for which the assessment data generated by their assessment plans would be used for progress, promotion and summative decisions. Some of the interviewees held more than one role relevant to this study, for example holding a position on competence committees or assessment committees, in addition to being a programme director.

여기에 제시된 연구 결과는 [성과 프레임워크]에서 [평가 계획 및 타당성 확인 기회]로 전환하는 과정과 결과를 다룬다. 이러한 움직임은 프로그램 관련자(예: 개인, 그룹 또는 조직)가 다음 목표를 달성하기 위해 이미 수립되었거나 중간 성과 프레임워크(여기서는 전문의의 역량을 의미함)에 대해 평가 계획을 준비하거나 제정할 때 발생한다. 이 섹션에서는 성과 프레임워크 번역 담당자와의 논의를 통해, 이 프로세스가 평가 타당성을 어렵게 하거나 불확실하게 하거나 강조하지 않는 상황에서 어떻게 생성되고 발생하는지와 관련된 결과를 제공합니다. 이제 우리는 [자원이 제한된 환경]에서 타당성이 어떻게 다른 CBME 관련 우선 순위와 경쟁하고 협상되는지에 대해 논의한다.

The findings presented here address the process and consequence of moving from outcome frameworks to assessment plans and opportunities for validity. This movement occurs as those involved in programmes (e.g. individuals, groups or organisations) prepare for or enact assessment plans against an already established or interim outcome framework that intends – in this case – to represent competence of specialist physicians. Through discussions with those responsible for the translation of outcome frameworks, this section provides findings related to how this process creates and takes place in a context that make assessment validity difficult, uncertain or de-emphasised. We now discuss how validity must compete and be negotiated with other CBME-related priorities in resource-limited environments.

3.1 좋은 평가를 위해 필요하지만 불완전한 구성으로 결과 프레임워크를 포지셔닝한다.

3.1 Positioning outcomes frameworks as necessary for good assessment but also as an incomplete construct

개인, 위원회 또는 그룹 및 조직은 결과 프레임워크와 평가 타당성 사이의 적합성fit을 확립하는 데 성공했다. 즉, 주어진 전문분야에 대한 임상역량의 구성은 [성과 및 EPA의 수집]에 의해 정의될 수 있다(이러한 정의가 타당성의 요건이다). 또한, 이러한 [artefacts 성취에 대한 증거]를 축적하는 것은 [진보, 성취 또는 준비에 대한 방어가능한 결정을 내려야 하는 '문제']를 해결한다. 성과 프레임워크가 평가 항목 또는 영역으로 적합한지에 대한 이러한 관점은 [권위 있는 그룹에 의해 간접적으로(또는 때로는 직접적으로) 통보]되었으며, 이는 [행위자가 템플릿 평가 도구를 신뢰해야만 한다는 것]을 나타내며, 종종 번역이 거의 또는 전혀 없었다. 이러한 [신뢰]를 보여주는 인용구는 다음과 같습니다.

Individuals, committees or groups, and organisations have been successful in establishing a fit between outcome frameworks and assessment validity, to the extent that their connections were not challenged by the informants in this study; that is, the construct of clinical competence for a given specialty could be defined – a requirement for validity – by the collection of outcomes and EPAs. Also, accumulating evidence of the achievement of these artefacts solves the ‘problem’ of having to make defensible decisions about progress, achievement or readiness. The use of outcomes was necessary for good assessment in CBME. This view of the suitability of outcomes frameworks as assessment items or domains was informed by authoritative groups indirectly (or sometimes directly), indicating that actors should trust in template assessment tools, often with little or no translation at all. Illustrative quotations informing this trust are:

우리는 기본적으로 EPA의 기초가 EPA의 말 그대로와 이정표가 될 것이다. 주석 섹션이 하단에 있고 모든 상황별 변수가 위의 드롭다운 메뉴에 있습니다. (21)

We basically translate, essentially verbatim, the basis of the EPA … would be the EPA verbatim and the milestones verbatim. With the comment section at the bottom, and all the contextual variables, in dropdown menus above. (21)제 말은 - [인정 기관]이 결정한 것은 아니라고 생각합니다. 왜냐하면 그것은 전국의 프로그램 책임자를 포함하는 [전문] 작업 그룹의 모든 사람들의 합의이기 때문입니다. (P11)

I mean – I'd say it wasn't decided by [accreditation body] because I would say it was the consensus of all of the people in that [specialty] working group, which includes program directors across the country …. (P11)

이러한 방식으로, (번역이 거의 없거나 전혀 없는) EPA가 평가 도구 항목을 구성하도록 움직이는 평가 도구로서의 결과 컬렉션은 존중되어야 하며 신뢰된다고 간주된다. 그러나 행위자(예: 프로그램 감독 및 평가 위원회)는 이러한 평가 계획에 대한 직접적인 권한 없이 수행enrolling하고 있었다. 이처럼 [재량권이 없는 것]도 수용되었고, 때로는 그룹(예: 사용자, 인가자 및 시행자) 간의 어려운 협상도 이루어졌다. 결과적으로, 이 협상은 확립된 도구를 집행한다는 것이 타당성에 무엇을 의미할 수 있는지에 대한 일부 대체된 책무성과 불확실성과 관련되었다. 평가 구축 방법과 과거 평가(즉, CBME 구현 이전의 평가)를 유지하는 옵션에서 유연성이 있음에도 불구하고, 타당성 문제는 권고안을 만드는 사람들에게 맡겨졌다entrusted.

In this way, collections of outcomes as assessment tools, that is moving EPAs to make up items on assessment tools with very little or no translation at all, are held to be inviolate and relied upon. However, actors (e.g. programme directors and assessment committees) were enrolling in these assessment plans without direct authority over them. This lack of discretion was both accepted and, at times, a difficult negotiation between groups (e.g. users, accreditors and implementers). As a result, this negotiation was associated with some displaced accountability and uncertainty regarding what the enactment of established tools might mean for validity. Issues of validity were often entrusted to those making the recommendations, despite flexibility in how assessments can be built and the option of maintaining historical assessments (i.e. those prior to implementation of CBME).

또한, 비록 타당성이 종종 [의도된 구인intended construct]으로 시작되지만, [성과 프레임워크]는 이 역할에 대해 불완전한 것으로 식별되었다. 정보제공자는 변환된 결과 체계를 보완할 필요성을 설명하면서, 예를 들어, [구인을 정의하는 방법]에 대한 일부 불확실성을 제안하였다.

Further, although validity often begins with an intended construct, outcome frameworks were identified as incomplete for this role. Informants described the need to supplement translated outcome frameworks, suggesting some uncertainty in how constructs are to be defined, for example:

P13: 우리는 그것을 다른 양동이라고 부릅니다. 모든 것이 EPA에 속하는 것도 아니고 모든 것이 EPA가 가능한 것도 아닙니다. 그래서 EPA에 깔끔하게 들어맞지 않는 다른 많은 것들이 여전히 존재합니다. 그래서 어떻게 여러분이 정말로 중요한 정보를 포착할 수 있을까요? [전문]은 그것을 특별한 소스라고 불렀습니다. 하지만 그것은 [EPA]가 모든 것이 아닌 것입니다. 의사는 단지 EPA가 아닙니다. 그리고 거기에는 깔끔하게 접히지 않은 것들이 많이 있었습니다.

P13: We call it the other bucket. You know not everything belongs in an EPA or, you know … not everything is EPA-able. And so there’s still lots of other things that people do that don’t neatly fit into EPAs, and so how do you still capture that information which is really important … [specialty] called it the special sauce … But it’s [EPAs] are not the be-all and end-all. Physicians aren’t only EPAs. And there was lots of stuff that didn’t fold neatly into there.

연구참여자들은 [번역된 성과 프레임워크]나 [결과 프레임워크 자체]가 [평가 프레임워크로의 번역에 한계가 있음]을 나타내는 것처럼 보였다. 따라서 많은 정보 제공자들은 EPA를 기존 교육 내 평가 시스템에 통합하는 것을 선호하면서 이전의 평가 도구(예: 360 평가, 서면 시험 및 OSCE)를 포기하는 것을 꺼린다고 보고했다.

Informants seemed to be indicating that translated outcome frameworks had limitations either in the outcome framework itself or in its translation to assessment frameworks. As such, many informants reported being reluctant to abandon their previous assessment tools (e.g. 360 assessments, written examinations and OSCEs), preferring to integrate EPAs into a pre-existing system of in-training assessments.

3.2 평가 계획에 대한 경쟁적 영향요인과의 협상

3.2 Negotiating through competing influences on assessment plans

평가 계획은 CBME의 많은 기능 중 하나이며, 따라서 결과 프레임워크에서 평가 계획으로 이동하는 데에는 타당성 외에 다수의 영향력자(예: 행위자 및 상황 요인)가 포함되며, 구현(예: 변경 관리 포함), 인가 및 기술로 광범위하게 분류된다. 이것은 경쟁적인 요구나 긴장을 가진 활동의 흐름으로 이어졌다. 즉, 이러한 영향력 요인들은 의도적이든 의도적이든 자신의 입장을 강화하거나 타인의 입장을 약화시키고, 타당성은 번역 과정에서 핵심 인플루언서가 아니라 많은 요소 중 하나로 표현된다.

Assessment plans are one of many features in CBME and so moving from outcome framework to assessment plans involved a number of influencers (e.g. actors and situational factors), other than validity, broadly grouped as implementation (i.e. including change management), accreditation and technology. This led to streams of activities with competing demands or tensions; that is, these influencers intentionally and unintentionally strengthen their own or weaken others’ positions and validity is represented not as the core influencer in the translation process, but as one among many.

[구현]은 의도된 원칙의 달성을 용이하게 하는 방식으로 CBME를 제정해야 하는 필요성을 말하며(예: 교육생이 EPA를 달성할 수 있는 기회를 제공하고 학습자 진행 또는 어려움에 처한 사람들을 식별한다), 이것이 제정되거나 우선순위가 매겨지는 방법은 관련자의 선택이다. [달성해야 할 활동으로서 CBME를 이행해야 하는 의무]는 때때로 타당성을 배제하지는 않더라도, 타당성보다 더 높은 우선순위를 갖는다. 구현에는 다음과 같이 교육자의 전환과 참여에 대한 인식이 포함되었으며, 이러한 전환과 참여shift and buy-in 역시 어떻게 우선순위가 매겨져야 하는지가 포함되었습니다.

Implementation refers to the need to enact CBME in a way that facilitates achievement of intended principles (e.g. provide trainees with opportunities to achieve EPAs, and identify learner progress or those in difficulty), and how this is enacted or prioritised is a choice for those involved. This obligation to implement CBME as an activity to be accomplished is enacted sometimes not to the exclusion of validity, but as a higher priority. At times implementation involved a recognition of the shift and buy-in of educators that would be required and how this too must be prioritised, as illustrated below:

P15: … 저는 단지 물건들을 밖으로 내보내고 사람들에게 무언가를 시키기 위해 초기 작업을 했습니다. 왜냐하면 저는 근본적으로 우리가 마감일이 있고 이것을 실행해야만 한다고 생각했기 때문입니다. 저는 사람들이 이것을 하도록 어떻게 하면 할 수 있을까에 대한 매우 실용적인 관점에서 보고 있었습니다. 어떻게 하면 사람들을 buy-in할 수 있을까요? 어떻게 하면 그들이 하기 쉽게 만들 수 있을까요? 제가 생각하기에 이것은 정말 중요한 특징입니다. 왜냐하면 만약 여러분이 투박하고 못생기고 사람들에게 말을 걸지 않는다면, 그들은 그것을 사용하지 않을 것이고, 그들은 그것을 사용하지 않을 것이고, 그들은 그것을 잘 하지 못할 것이기 때문입니다.

P15: … I did some initial work just to get stuff out there and get people doing something. Because I just fundamentally thought, because we had the deadline and we had to get this implemented … I was looking at it from a very pragmatic point of view of how can I get people to do this? How can I get people to buy in? How can I make it so that it's easy for them to do? Which I think is a really important feature because if you roll out a system that is clunky and ugly and doesn't speak to people and they don't feel it's relevant, they're not gonna use it, and they're not gonna do it, or they're gonna do it poorly.

이러한 [실제적 문제]는 평가 계획을 집행하는 데 큰 영향을 미치는 것으로 보입니다. 구현 결정은 때때로 또는 일정 기간 동안만 유효성과 긴장된 상태로 존재할 수 있습니다.

These real-world issues appear to be strong influences on those enacting assessment plans. Implementation decisions can exist in tension with – even if only at times or for a period of time –validity.

[Accreditation]이란, 의사결정에 영향을 미치며, 인증 요건을 준수할 책임을 말하며, 당시에는 많은 사람들이 여전히 유동적이고 불확실하며 항상 또는 반드시 유효하지는 않은 것으로 인식되었다. 인가에 대한 이러한 초점은 다음과 같이 평가 계획에 대해 인증기관이 제공한 지침의 균형잡기, 의존 또는 준수를 의미한다.

Accreditation, as an influence on decision making, refers to the responsibility to comply with accreditation requirements, which at the time for many were perceived to still be fluid, uncertain and not always or necessarily a validity issue. This focus on accreditation meant balancing, relying on or complying with the guidance provided by the accreditor for assessment plans, as illustrated here:

P22: 우리 기관의 어느 누구도 부정행위를 저지르고 그렇게 독특한 일을 하기를 바라지 않았다고 생각합니다. 우리가 [인정자]가 제안한 것에 대해 근본적인 이견이 있다는 것은 아닙니다. 사실 우리는 이것이 아마도 좋은 전략일 것이라는 데 동의합니다. 하지만 최고의 연습과 평가에 대한 지식과 진보에 대한 지식이 풍부할 뿐입니다. 그래서 저는 인증을 받았기 때문에 해야 할 일이 있다고 생각합니다. [평가의 best practice에 대해 알고 있는 것]을 기반으로 평가를 하는 것이 옳은 일이기 때문입니다.

P22: … I don't think anyone in our institution was hoping to go rogue and do um something that unique … not that we have a fundamental disagreement with what the [accreditor] was suggesting, in fact we agree … it's probably, you know, a good strategy, makes sense … but there's just being knowledgeable around the scholarship [and] progress on best practices and assessment. So I think there's what you have to do because you're being accredited and then there's what you should do because it's the right thing to do based on what you know about best practices in assessment.

다음 인용문에 기술된 바와 같이, 인증을 지원하기 위해 행동하는 많은 이들이 행위자가 평가 계획을 진행하는 방법에 영향을 미쳤다.

Many of those acting to support accreditation served to influence how actors proceeded with assessment plans, as depicted in the following quotation:

P22: 창의력을 발휘할 수 있는 여지는 아마도 조금 좁아졌을 것입니다. 모든 종류의 커리큘럼과 평가설계는 이제 인증기관과 관련 전문위원회에게 맡겨졌습니다. 그리고 우리는 단지 프로그램들을 문서로서 [인정 기관]에서 나오는 것을 가리키고 있습니다. 그리고 그것들은 여러분이 사용하게 될 도구들입니다.

P22: The latitude for creativity is, is probably a little narrower and the whole kind of curriculum and assessment design, has now just fallen back to the [accreditation body] and the relevant specialty committees. And we're just sort of pointing programs back to what's coming out of the [accreditation body] as documents and those are the tools that you're going to be using.

[규제 요구]에 대해 외부에서 제시되는 선언문을 준수해야 하는 강력하고 중요한 제도적 의무가 있지만, 이로 인해 일부 [재량권이 제한]되거나, [타당성 함의에 주의를 기울일 필요]가 있다는 우려가 수반된다.

There is a strong and important institutional imperative to comply with externally derived statements for regulatory needs, yet an accompanying concern that this may restrict some discretion or need to attend to validity implications.

[테크놀로지]는, 구현 및 인증과 밀접하게 연결되어있고, 평가 프로세스를 온라인으로 전환하려는 광범위한 의도를 의미합니다. 이 경우, 평가 도구와 보고는 테크놀로지적 능력에 의해 제한되었고, 이는 종종 타당성에 관한 고려사항보다 평가가 어떻게 제정되는지에 대한 더 강력한 결정 요인이 되었다.

Technology, closely linked to both implementation and accreditation, refers to the widespread intention to have assessment processes moved on-line. In this instance, assessment tools and reporting were limited to technological capabilities and this often was a more powerful determinant of how assessments were enacted than considerations regarding validity, as illustrated below:

P18: 우리는 프로그램들이 질문으로서 이정표를 사용하지 않는 EPA 평가 도구를 설계할 수 있는 시스템을 가지고 있었습니다. 하지만 백그라운드에서, 우리는 시스템이 관련된 이정표에 사용된 질문을 매핑할 수 있도록 프로그래밍할 것입니다. 몇 가지 프로그램에서는 괜찮았지만, 우리가 좀 더 지역적으로 런칭하기 시작하면서 프로그래밍과 사용자 지정이 필요하다는 것이 명백해졌습니다. 음, 지속 불가능하고, 사실, 압도적일 것입니다. 그래서, 음, 그래서 우리는 IT 시스템이 아니라 우리가 사용하던 시스템을 바꿔야 했습니다.

P18: We had a system that would allow programs to design an EPA assessment tool that didn't use the milestones as the questions. But then in the background, we would program the system to be able to map the questions that were used to the relevant milestones. And that was okay for a couple of programs, but once we started to launch more local, it became very obvious that the programming and customization required to do that, was going to be, um, unsustainable, and in fact, overwhelming. So, um, so we had to change the system we were using, not the IT system.

이 경우, 물리적 제약 조건(특정 테크놀로지)이 평가 계획을 집행하는 자의 대응 및 재량에 대한 옵션 범위와 잠재성을 제한합니다. 따라서 이러한 제약조건은 [제도적 상황] 내에서 [어떤 평가접근법과 관행을 운영할 수 있는지]에 강한 영향을 미친다. 이것은 타당성을 구성할 수 있는 것으로 확장된다.

In this case, a physical constraint – a particular technology – limits the range of options and potential for responses and discretion by those enacting assessment plans. Such constraints, therefore, have a strong influence on what assessment approaches and practices can be enacted within the constraints of an institutional setting. This extends to what can constitute validity.

3.3 위험, 불확실 또는 가정된 위치 결정 유효성

3.3 Positioning validity as threatened, uncertain or assumed

우리는 평가 계획의 번역 및 제정에서 확인되지 않은 가정이 있을 수 있는 곳과 격차가 있을 수 있는 곳을 구성하기 위해 케인의 타당성 프레임워크를 사용하여 의사 결정 프로세스를 조사했다. 타당성 위협은 번역 프로세스(예: 표준화된 도구 개발 및 사용, 다목적 결과)와 평가 계획 제정(예: 이벤트에 대한 액세스, 평가 및 학습자 행동, 작업장 비용) 모두에서 나타난다.

We examined decision-making processes using Kane’s validity framework to organise where unchecked assumptions may be in the translation into and enactment of assessment plans, as well as where gaps may be. Validity threats emerge in both

- the translation process (e.g. developing and using standardised tools, and multi-purposing outcomes) and

- the enactment of assessment plans (e.g. access to events, rater and learner behaviours, and workplace affordances).

타당성 프레임워크는 (위에서 설명한) 구성 표현 문제 외에도 타당성 주장 생성을 지원하는 기회로서 기능하는 [확인되지 않은 가정]을 탐색할 수 있는 기회를 제공한다. 구현의 결과로 본질적으로 존재하는 데이터로 많은 가정을 해결할 수 있다. 그러나, 아래에 예시된 바와 같이, 많은 정보제공자들은 타당성 증거를 검토할 [준비]가 되어 있지 않거나, [능력]을 갖추고 있지 않으며, [기회]를 이용할 수 없거나, 타당성 증거의 생성에 대한 [관심]이 아직 우선시되지 않았다고 보고하였다.

In addition to issues of construct representation (described above), validity frameworks provide an opportunity to explore unchecked assumptions that serve as opportunities to support the generation of validity claims. Many assumptions can be addressed with data that inherently exist as a result of the implementation. However, as illustrated below, many informants reported being unprepared or ill-equipped to examine validity evidence, and that opportunities have not been available or attention to generating evidence of validity has not yet been prioritised:

P15: 여러 해 동안, 그것은 단지 그것을 완성하고, [발매일]까지 여러분이 가질 수 있는 것을 얻는 것이었습니다. 그게 더 나을 수 있을까? 물론이야. 정말 알기가 어려운 것 같고, 그것이 사실 우리가 지금 고군분투하고 있는 것입니다. 이것들을 어떻게 측정합니까? 몰라. 이것은 도전이자 고군분투입니다. 어떻게 대답해야 할지 모르겠습니다. [평가 계획을 평가하는 방법에 대한 질문 참조] 당신이 그렇게 해줄 수 있으면 좋겠어요. 어떻게 평가해야 할지 정말 알고 싶어요. 효과가 있다고 생각하지만 연구해서 효과를 입증하는 건 정말 어려워요

P15: For many years, it was just get it done, get something out there that you can have going by [launch date]. Could it be better? Of course. I think it's really hard to know, and that's actually what we are struggling with now. How do you measure these things? I don't know. This is a challenge and a struggle … I'm not sure how to answer that [referring to a question on how assessment plans are evaluated]. Hopefully you can do that for me. I would really like to know how to evaluate it, 'cause I think it's working, but I find it's really hard to, um, to study and prove its working.P18: 음, 우리가 하지 않은 것은, 음, 이 모든 것이 얼마나 타당한지를 알아내기 위한 어떤 것이든 디자인하거나 인식하려고 시도한 것입니다. 아시다시피, 이 부분은 항상 얼마나 어려울지 모릅니다. 그리고 우리는 그런 면에서 다른 누구보다도 앞서 있지 않습니다.

P18: Um, what we haven't done is really, uh, attempted to design or recognize anything that would sort of get at how valid any of this is … you know, always how difficult, that aspect of it's gonna be, and we're no further ahead than anybody else, in that way.

[평가 계획을 평가하려는 이러한 도전]은 구현 노력에 대한 평가를 계획하거나 구현한 조직이 거의 없기 때문에 복잡해 보였다. 많은 이들이 이를 평가 시스템의 필수적인 부분이 아닌 시행 후 제도적 과정으로 대학원 학과에 미루었다.

This challenge of attempting to evaluate assessment plans seemed to be complicated by how few organisations had either planned or implemented an evaluation of their implementation efforts. Many deferred this to postgraduate departments, as an institutional process after implementation, rather than an integral part of the assessment system.

타당성의 display는 '여러 기관들'에 걸쳐 분포되어 있으며, 타당성에 대한 argument는 제대로 개발되지 않았다. 타당성에 대한 책무는 다른 우선순위에 따르는 동안 대체되거나 축소되거나 제쳐진다. 책무는 종종 둘 이상에게 위임된다. 많은 대리인들이 어느 정도의 방어 가능성이나 타당성을 추론하는 데 사용되며, 종종 모범 사례에 근거한다.

Displays of validity are distributed across ‘institutions’, leaving validity arguments poorly developed if at all. Accountabilities for validity are either displaced, reduced or put aside while other priorities are attended to. Accountabilities are often delegated in more than one direction. A number of surrogates are reported to be used to infer some degree of defensibility or validity, often rooted in best practices:

P15: 우리의 역량 위원회는 여러 번 만났고, 우리는 데이터를 살펴봤고, 트렌드를 살펴봤다고 말할 수 있습니다. 우린... 그들은 잘 지내고 있어. 제대로 된 평가를 받고 있는 것처럼요 우리는 그들이 다양한 임상 상황에서 광범위한 평가자를 확보하도록 확실히 하고 있습니다. 그래서 저는 우리가 의도했던 대로 CBD(설계상 능력, 인증 기관의 역량 기반 교육)의 과정을 거치고 있다고 생각합니다. 그리고 그것은 여러 면에서 성공의 표시입니다. 비록 학자의 관점에서 볼 때, 여러분은 우리가 그것을 비밀로 하고 그들이 잘 하고 있다고 말하고 그들을 발전시키고 있다고 말할 수 있지만, 저는 모르겠습니다.

P15: I can say our competence committee has met multiple times, and we've looked at the data; we've looked at the trends. We're – they're doing okay. Like they're getting the right number of assessments done. We're making sure that they're getting a breadth of assessors in different clinical situations. So I feel like we're going through the process of CBD [competency by design, the accreditation body’s version of competency-based education] the way it's intended to be going. And that in many ways is a marker of success. Although from a scholarly point of view you could say we're – well, maybe we're just sweeping it under the rug and saying that they're doing okay and advancing them … I don't know.P20: 나는 그들이 더 일찍 발견했다고 생각한다. 우리는 문제가 더 일찍 나타나고 있다는 것을 듣고 있습니다. 그리고 좀 더 많은 평가를 내리면서 그 대화가 주목을 받게 된 것 같아요

P20: I think they are finding things out earlier. We're hearing that, that problems are emerging earlier. Um, and I think with more assessments, um, I think it's just brought that conversation up to the forefront.

요약하자면, 결과를 번역할 때 [타당성에 대한 우려]는 일차적인 요구 사항이 아니었다. 기껏해야, 대리지표surrogates에 근거하거나, 평가의 체계적 부재로 입증되는 추가 가정 시험이나 타당성 검사 없이 transfer될 수 있다고 가정했다. 말하자면, 많은 사람들에게, 시행 단계였기 때문에 아직 광범위한 타당성 평가는 가능하지 않았다. 그러나 이러한 맥락에서 타당성이 강조되지 않거나 대체되었다. 구성표현은 EPA 또는 EPA의 역량을 넘어서는 것을 의미했고, 위협은 번역 후 계획에 나타났으며, 이들 중 상당수는 역량 위원회나 프로그래밍 평가의 사용을 통해 완화되는 것으로 가정되었다. 이러한 문제의 많은 결과로, 역량 위원회에 대해 생성된 데이터와 관련된 타당성 증거가 (그저 있다고) 가정되거나, 확인되지 않으며, 불확실한 책무성을 가질 수 있다.

표 1은 주요 요점과 이론적 및 실제적 시사점을 포함한 결과 요약을 제공합니다.

In summary, concerns about validity were not the primary imperative when translating outcomes. At best, it remained assumed, based on surrogates or that it could be transferred without further testing of assumptions or validation as evidenced by the systematic absence of evaluations. To be fair, for many, extensive evaluation of validity was not yet a possibility due to the stage of implementation. However, validity was de-emphasised or displaced in these contexts as well. Construct representation meant reaching beyond EPAs or their competencies, and threats appeared in plans following translations, many of which were assumed to be mitigated through competence committees or use of programmatic assessments. As a result of many of these issues, validity evidence associated with the data generated for competence committees may be assumed, unchecked and have uncertain accountabilities.

Table 1 gives a summary of findings, with key points and theoretical and practical implications.

4 토론

4 DISCUSSION

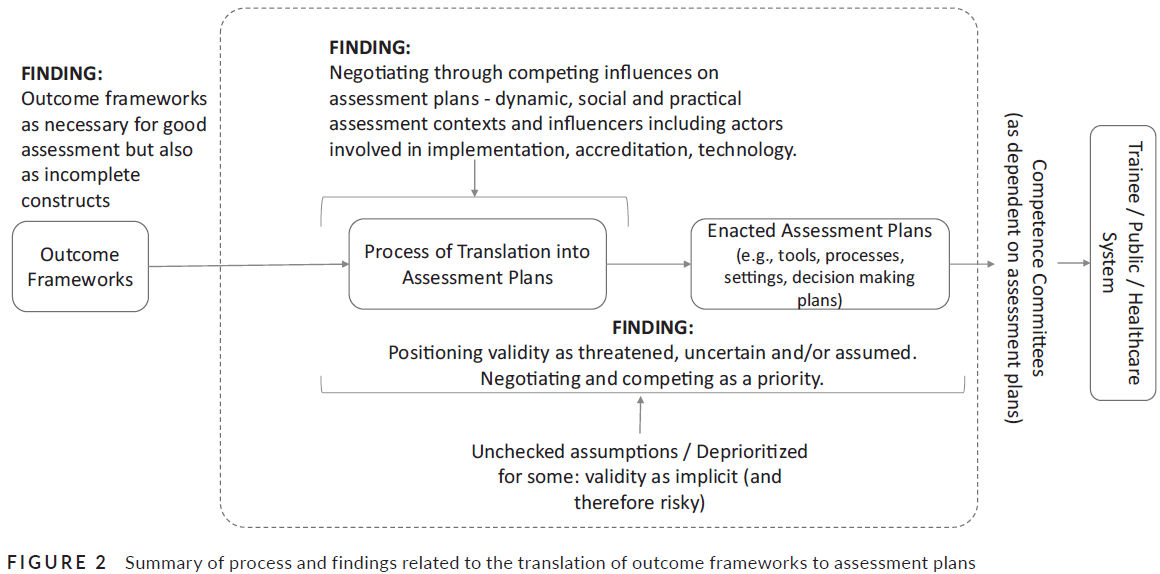

역량 기반 의학교육은 교육과정 전략을 지원하는 일련의 교육목표와 비지도 실습에 대한 훈련생 준비에 관한 의사결정을 지원하기 위한 평가계획을 알리는 역할을 한다.26 이러한 맥락에서 평가계획의 구조화에는 종종 경쟁적 사실에 대한 결과 프레임워크의 번역이 포함된다.자신도 모르게 타당성을 주장하는 사람들을 위협할 수 있는 비틀림 교육생에 대한 의사결정이 궁극적으로 이루어지는 데이터는 암묵적으로 또는 방치될 경우 교육생, 기관, 환자 및 일반인에게 중요한 다운스트림 영향을 미칠 수 있다. 본 연구에서는 캐나다 3개 대학의 CBME 리더들을 인터뷰하여 결과 프레임워크에서 형성 및 종합 평가 계획까지의 번역 과정을 탐구하였다. 우리의 결과는

- (i) 평가 프레임워크으로 성과를 사용하는 것은, 좋은 평가를 위해 필요하지만, 불완전한 구성이기도 하다.

- (ii) 구현, 인증, 테크놀로지 등을 포함하여, 평가 계획의 핵심 인플루언서로서 타당성을 대체하는 경쟁적 요소를 가진 여러 사회적 및 실제 협상이 있다.

- (iii) 검증되지 않은 다수의 가정과 대리인에 대한 의존으로 인해, 타당성이 위협적이고 불확실하며 가정된 것으로 존재한다(이러한 결과의 예시는 그림 2 참조).

Competency-based medical education serves to inform a set of educational aims supporting curriculum strategies and also assessment plans intended to support decisions regarding trainee readiness for unsupervised practice.26 The structuring of assessment plans in this context often includes the translation of outcome frameworks against competing factors that may unknowingly threaten validity claims. Left implicit or unattended to, the data on which decisions are ultimately made about trainees may be undermined, with significant downstream implications for trainees, institutions, patients and the public. In this study, we explored the translation process from outcome framework to formative and summative assessment plans by interviewing CBME leaders within three universities in Canada. Our results suggest

- (i) using outcomes for assessment frameworks is necessary for good assessment but it is also an incomplete construct;

- (ii) there are a number of social and practical negotiations with competing factors that displace validity as a core influencer in assessment planning, including implementation, accreditation and technology;

- (iii) validity exists as threatened, uncertain and assumed due to a number of unchecked assumptions and reliance on surrogates (see Figure 2 for an illustration of these findings).

CBME 맥락에서 [평가 계획]은 [번역 프로세스]를 통과하는 [성과 프레임워크]에서 시작되며, 이 조사는 이 조사에 포함된 세 대학에 걸쳐 전략과 정도가 다르다. 다른 이들은 결과 프레임워크가 어떻게 평가 프레임워크로 깔끔하게 번역되지 않을 수 있는지를 설명했다. 일부 설명은 도구 또는 준비되지 않은 교수진의 품질에 초점을 맞추었거나, 결과 프레임워크가 사회적으로 구성되었거나 역량에 대한 보다 기초적인 개념화와 잘 정렬되지 않았기 때문에 결과 프레임워크로 시작하는 것이 개념적으로 결함이 있다는 것이다. 성과 프레임워크에서 평가 계획으로 이동할 때, Callon의 번역 이론은 많은 추가적인 메커니즘이 관련될 수 있음을 시사한다. 이 연구의 결과는 번역 과정이 (Callon이 시사하는 바와 같이) 사회적, 실제적 또는 물질적, 이론적, 정치적 맥락에서 전개되고, 새로운 과정이 최종적인 평가 계획을 형성한다는 것을 시사한다.

Assessment planning in a CBME context begins with outcome frameworks that pass through a translational process, which varies in strategies and degree across the three universities included in this investigation. Others have described how outcome frameworks may not translate neatly into assessment frameworks.3, 27, 28 Some explanations have focused on the quality of the tools or unprepared faculty members29, or that it is conceptually flawed to start with outcome frameworks because they are socially constructed or poorly aligned with more grounded conceptualisations of competence.3, 27 When moving from an outcome framework to assessment plans, Callon's theory of translations suggests a number of additional mechanisms may be relevant.17 The findings of this study suggest that the translational process unfolds (as Callon would suggest) in social, practical or material, theoretical and political contexts and the emergent process shapes eventual assessment plans.

[사회적 조건]의 역할은 이전에 CBME를 포함한 교육적 맥락에서 강조되었다. 예를 들어, 연구자들은 교육적 성과를 명시하고, 그러한 성과를 달성하기 위한 의도적인 계획을 갖는 것의 중요성을 인정하지만, 맥락과 참여 행위자들이 어떻게 매우 다른 것을 만들어낼 수 있는지를 보여주었다. 즉, [기초적인 교육 원칙]은, 교과목표와 경쟁하는 맥락적(즉, 사회적 및 실제적) 특징의 결과로 인해서 이전, 변형 또는 폐기될 수 있다. 결과적으로, 무어는 커리큘럼을 경험적이고, 새로우며, 진화하고, 경쟁적인 우선 순위를 가진 현실 세계의 일부로서, [정적이며 성문화되고 무균적으로 계획된 과정이 아니라고] 설명했다. 이 연구의 결과는 유사한 방식으로 번역 활동과 평가 계획도 보장되거나 확실한 것보다 유효성을 더 의도적으로 남기는 많은 영향(즉, 행위자와 기관의 견해와 우선순위)에 영향을 받기 쉽다는 것을 시사한다.

The role of social conditions has been highlighted before in educational contexts, including CBME.18 For instance, researchers acknowledge the importance of specifying educational outcomes and having intentional plans to achieve those outcomes, but demonstrate how contexts and participating actors can create something very different;19 that is, underlying educational principles may be transferred, transformed or abandoned as a result of contextual (i.e. social and practical) features that are in competition with curricular goals.30, 31 As a result, Moore described the curriculum as experienced, emergent and evolving, as part of the real world with competing priorities and not as a static codified and sterile planned process.32 The results of this study suggest that in an analogous way, translational activities and assessment plans are also susceptible to a number of influences (i.e. views and priorities of actors and institutions) that leave validity more intended than guaranteed or certain.

또한 본 연구에서 우리는 타당성에 대한 위협에 대해 학습한 동시에, 이러한 위협을 완화하려는 (테스트되지 않은) 시도를 식별하였다. 예를 들어, 성과 프레임워크는 현재 형태로는 [불완전하거나 불충분한 구성]으로 식별되었다. 이것은 성과 프레임워크가 어떻게 평가 프레임워크로 깔끔하게 번역되지 않을 수 있는지에 대한 Lurie의 이전 주장을 뒷받침할 수 있다. 추가적인 과정이 필요했고 역량에 대한 방어가능한 주장을 뒷받침하는 것도 포함되었다. 교수진 및 학습자 행동과 같은 [점수 매기기 위협], 또는 충분한 품질 또는 양으로 임상 이벤트에 접근하는 어려움과 같은 [일반화 위협]은 이를 완화하려는 시도(예: 교수 개발 및 시뮬레이션을 보완하여 사용)가 존재했다. 하지만 타당성에 미치는 영향은 여전히 존재있다.

Further, in our study, we learned of threats to validity while also identifying (untested) attempts to mitigate these threats. For example, outcome frameworks were identified as incomplete or as an insufficient construct in their current form. This may support Lurie's earlier arguments regarding how outcome frameworks may not translate neatly into assessment frameworks.3, 27, 28 Additional processes were necessary and included supporting defensible claims regarding competence. Scoring threats, such as faculty member and learner behaviours, or generalisation threats, such as difficulty accessing clinical events in sufficient quality or quantity, are being met with attempts to mitigate them (e.g. faculty development and use of simulation as a supplement) but remain largely assumed in regards to impact on validity.

예를 들어, 교육 기관의 평가 관행이 신뢰성을 시험하고 지원하는 방식으로 이러한 상황을 통제할 수 없기 때문에 임상 실습에서 이루어지는 판단과 결정에서 발생하는 [평가 관행에 대한 신뢰성과 관련된 다양한 문제]가 있다. '외삽 근거' 또는 '함의 근거' 를 포함한 다른 추론은 아직 실행의 초점도 아니었고, 명시적으로 계획되지도 않았다. 가정 검토와 구조 유효성 주장을 포함하는 계획은 다른 경쟁 우선 순위 대신 강조되지 않거나 고려되지 않으며, 타당성이 가정되거나 대리인에게 귀속되기 때문이다. (예: 완료된 평가 수 및 문제 있는 학습자 식별)

For instance, there are a range of issues associated with the reliability of assessment practices that arise from judgements and decisions being made in clinical practice as these circumstances cannot be controlled in the way that assessment practices in educational institutions can be to try and support reliability. Other inferences including ‘extrapolation’ or ‘implications’ evidence had not yet been an actioned focus nor explicitly planned. Plans to include examination of assumptions and to structure validity arguments are de-emphasised or not considered in place of other competing priorities,21 or because validity is assumed or attributed to surrogates (e.g. number of assessments completed and identification of learners in trouble).

의료 교육의 평가 과학자와 교육자는 평가 계획에서 핵심 인플루언서로서 타당성을 위치시키지 않는 이러한 종류의 영향과 굳이 논쟁할 필요가 없었을 것이다. 공통 가이드라인에서는 실행 가능성, 비용 또는 수용 가능성을 넘어 [계획 또는 평가 과정에서 (평가 타당성을 경쟁하는) 다른 사회적 영향을 고려하는 방법]을 강조하지 않을 수도 있다. 그러나 타당성이나 타당화는 (경험적이고 논리적 과정만큼이나) 사회적 과정이며, 맥락, 행위자, 제도에 의해 형성될 수 있다. 예를 들어, 이 연구에서 우리는 다른 이해관계자의 이익(예: 구현, 인가 및 기술)과 일치하기를 원하거나 필요로 하며, 책임의 대체 및 기타 중요한 영향이 평가 설계를 형성하고 있다는 것을 발견했다.

Assessment scientists and educators in medical education have perhaps not had to contend with these kinds of influences that do not position validity as the core influencer in assessment planning. Common guidelines may de-emphasise how to consider other social influences that compete with assessment validity in the planning or evaluation process, beyond feasibility, cost or acceptability.6, 33, 34 But validity or validation may be as much a social process (we mean this to be distinct from a social accountability35) as an empirical and logical one, that is shaped by context, actors and institutions. In this study we found, for example, wanting or needing to align with the interests of other stakeholders (e.g. implementation, accreditation and technology), displacing of accountabilities and other material influences were shaping assessment designs.

이것은 항상 또는 반드시 타당성에 대한 최고의 기회를 제공하는것은 아니었다. [평가 계획]은 단순히 [평가 과학]이 아니고, [사회적 상호작용과 협상에 관한 것]이 된다. 그렇다면 CBME와 같은 복잡한 개입에 서 있는 이해당사자들 사이에서 [평가가 단지 여럿 우선 순위 중 하나에 불과할 때], 이제 평가 설계를 어떻게 해야 하는지 물어야 한다. 새로운 actor가 번역 과정에 등록될 때마다, 그들은 잠재적으로 번역 과정을 방해할 수 있고, 우리가 경쟁하는 모든 의무들이 어떻게 해결되어야 하는지 알아내도록 강요한다. 따라서 [평가 지침]은 이러한 문제에 대해 더 자세히 설명하기 위해 재구성될 필요가 있다. 이는 타협compromise하기 위해서가 아니라, 이러한 문제가 발생할 때 충분한 타당성 주장이 만들어질 수 있도록 보장하기 위해서이다. 이러한 과제를 고려할 때, 또한 문제가 있는 타협을 피하기 위해, 특히 타협이 필요한 경우, 유효성 및 검증에 충분한 공간을 제공해야 할 수 있다. 그때까지 타당성은 ['베스트 프랙티스'의 적용과 대리자surrogate의 사용]을 가지고 존재한다고 가정assumed되거나, 책무성을 대체함으로써 가정될 수 있다(즉, 타당성은 '그들'의 책임이다).

This was not always, or necessarily, in ways that would provide the best opportunities for validity. Assessment planning becomes additionally about social interactions and negotiations than just pure assessment science. An implication then is to ask what should we now make of assessment designs when assessment is but one priority among many across stakeholders with standing in a complex intervention like CBME? Every time a new actor is enrolled into the translation process, they can potentially disrupt it, obligating us to figure out how any competing imperatives are to be addressed. Assessment guidelines, therefore, may need to be reframed to account further for these issues, not to compromise on but to ensure sufficient validity arguments can be made when these issues arise. In light of these challenges but also to avoid problematic compromises, validity and validation may need to be given sufficient space, especially when compromises are necessary. Until then validity may remain assumed using the application of ‘best practices’ and the use of surrogates, or by displacing accountabilities (i.e. validity is a ‘they’ responsibility).

4.1 제한사항

4.1 Limitations

이 연구는 한계라는 맥락에서 고려되어야 한다. 첫째, 우리의 샘플은 세 개의 캐나다 대학을 나타내며 우리는 이러한 맥락의 위치적 성격을 인식한다. 다른 정성 연구와 마찬가지로, 본 연구의 목적은 개념적 전이성을 갖는 것이며 경험적 일반성을 제시하지 않는다. 둘째, 캐나다에서 비교적 초기 CBME의 상태를 고려할 때, 시스템은 항소나 실패를 통한 유효성 주장의 시험이나 시간의 이점을 갖지 못했을 수 있으며, 따라서 여전히 성숙할 수 있다. 우리는 이 연구가 특정한 순간을 포착한다는 것을 인정한다. 이 연구를 이렇게 일찍 수행한 우리의 의도는 이러한 유효성 고려사항을 조기에 자극하는 것이었다.

This study should be considered in the context of its limitations. First, our sample represents three Canadian universities and we recognise the situated nature of this context. As with other qualitative studies, our intention with this study is to have conceptual transferability and we do not suggest empirical generalisability. Second, given the relatively early status of CBME in Canada, the system may not have had the advantage of time or testing of validity arguments through appeals or failures, and may therefore still mature. We recognise that this study captures a particular moment in time. Our intention in conducting this study, this early, was to stimulate these validity considerations at an early stage.

5 결론 및 향후 방향

5 CONCLUSIONS AND FUTURE DIRECTIONS

CBME는 [성과 프레임워크]에서 시작하여 교육, 학습 및 평가로 광범위하게 그룹화된 많은 활동으로 변환되는 복잡한 개입이다. 이러한 [번역 프로세스]는 평가 관점에서 평가 과학자, 기관 및 교육자에게 새로운 과제를 제공하는 [복잡한 사회 및 실제 환경]에서 발생합니다. 이러한 환경으로 인해, 평가 설계의 핵심 인플루언서로서 타당성은 도전에 직면했다. 이해관계자들의 다른 관심사(도입, 인증, 테크놀로지)와 맥락적 요인(타당화 기회에 대한 평가절하 및 접근성 낮음)이 작동하고, 그 결과 타당성 검사가 프로세스에서 항상 우선시되지 않거나, 심지어 실현 가능하지도 않게 된다. 타당성과 타당화는 공간을 두고 경쟁하기 위해 고군분투하거나, 최소한 이 시점에서 강조되지 않거나, 대체되거나, 그냥 가정될 수 있다.

Competency-based medical education is a complex intervention that begins with an outcome framework, which is then translated into many activities broadly grouped as teaching, learning and assessment. This translational process takes place in a complex social and practical environment that, from an assessment perspective, provides new challenges for assessment scientists, institutions and educators. This environment is challenging validity as a core influencer in assessment designs. Other stakeholder interests (e.g. implementation, accreditation and technology) and contextual features such as the (de)valuing of and access to validation opportunities, are at play, which assigns validity a unique and certainly not always prioritised or even feasible assignment in the process. Validity and validation struggle to compete for space or may be de-emphasised, displaced or just assumed, at least at this point.

결과적으로, 확인되지 않은 위협과 의도된 완화 전략(예: 일부 교수진 개발 또는 대량의 데이터 추구)이 검증을 받기 보다는, 타당성에 영향을 미칠 것이라고 그저 가정되며, 그 결과 타당도는 생성하기 어려운 것, 암묵적인 것, 위기에 놓은 것이 되었다.

- CBME의 평가 기능을 구현할 때 학습자 또는 후보, 공공, 환자 및 기관에 상당한 다운스트림 영향을 미치면서 평가가 관련되고 준비 상태 또는 역량에 대한 의사결정에 기여하는 경우, 타당성 및 타당화가 우선시되거나 더 많은 지위를 부여해야 할 수 있다.

- 둘째, 미래 연구는 프로세스와 그 잠재적 영향에 대한 보다 포괄적인 이해를 제공하기 위해 여러 관점(즉, 교육생의 관점 및 역량 위원회 구성원의 관점)에서 검색해야 한다.

- 마지막으로, CBME의 컨텍스트는 연구자들이 컨텍스트의 복잡성을 설명하는 방법을 제안하게 하고 있다.

As a result, there are some unchecked threats and intended mitigation strategies (e.g. some faculty development, or seeking large amounts of data) are more assumed in terms of their impact on validity than tested, leaving validity arguments difficult to create, implicit and risky.

- Moving forward, first where assessment is involved and contributes to decisions about readiness or competence, with significant downstream effects for the learner or candidate, public, patients and institutions, validity and validation may need to be prioritised or given more standing when implementing assessment features of CBME.

- Second, future research from multiple perspectives (i.e. perspectives of trainees and perspectives of members of competence committees) is necessary to provide an even more comprehensive understanding of these processes and their potential effects.

- Finally, the context of CBME is causing researchers to propose ways of accounting for the complexity of context.30, 36

따라서, 이렇듯 [번역은 언제나 협상을 수반]하므로, 평가 연구자는 [의료 및 보건 분야의 평가가 구현되고 제정되어야 하는 맥락적 현실]에서 [어떻게 타당성 프레임워크를 설명할 것인가]를 탐색하고 보고해야 할 필요가 있다. CBME 계획 및 구현의 맥락에서 이러한 번역 프로세스를 설명할 때, 이러한 문제를 무시하거나 경쟁하기 보다는, [의도적으로 통합하는 방향]으로의 전환하는 것이 전략을 최적화하는 방법일 수 있고, 타당성을 위협할 수 있는 긴장과 도전을 완화하는 방법이 될 수 있다. 이것은 또한 평가나 타당성 과학의 영역 내에서 아직 완전히 인식되지 않은 다른 형태의 사회과학으로부터 새로운 협력, 협업의 새로운 형태, 그리고 새로운 통찰력을 요구할 수 있다. 그 전까지는, 번역 프로세스는 암묵적인 상태로 남을 것이고, CBME에서 평가 프로그램의 타당성은 위험한 상태로 남을 것이다.

Therefore, in a similar way, because translations involve negotiations, assessment researchers may need to explore and report on how validity frameworks are to account for the contextual realities in which assessment in medical and health professions is to be implemented and enacted. In explicating these translational processes in the context of CBME planning and implementation, shifts toward intentionally integrating these issues, rather than ignoring or competing against them, may be a way of optimising strategies and a way of mitigating tensions and challenges that may threaten validity. This may also require new partnerships, new forms of collaboration and new insights from other forms of social science that have not yet been fully appreciated within the domain of assessment or validity science. Until then, translational processes may remain implicit and validity of assessment programmes in CBME risky.

Translating outcome frameworks to assessment programmes: Implications for validity

PMID: 32614480

DOI: 10.1111/medu.14287

Abstract

Objectives: Competency-based medical education (CBME) requires that educators structure assessment of clinical competence using outcome frameworks. Although these frameworks may serve some outcomes well (e.g. represent eventual practice), translating these into workplace-based assessment plans may undermine validity and, therefore, trustworthiness of assessment decisions due to a number of competing factors that may not always be visible or their impact knowable. Explored here is the translation process from outcome framework to formative and summative assessment plans in postgraduate medical education (PGME) in three Canadian universities.

Methods: We conducted a qualitative study involving in-depth semi-structured interviews with leaders of PGME programmes involved in assessment and/or CBME implementation, with a focus on their assessment-based translational activities and evaluation strategies. Interviews were informed by Callon's theory of translation. Our analytical strategy involved directed content analysis, allowing us to be guided by Kane's validity framework, whilst still participating in open coding and analytical memo taking. We then engaged in axial coding to systematically explore themes across the dataset, various situations and our conceptual framework.

Results: Twenty-four interviews were conducted involving 15 specialties across three universities. Our results suggest: (i) using outcomes frameworks for assessment is necessary for good assessment but are also viewed as incomplete constructs; (ii) there are a number of social and practical negotiations with competing factors that displace validity as a core influencer in assessment planning, including implementation, accreditation and technology; and (iii) validity exists as threatened, uncertain and assumed due to a number of unchecked assumptions and reliance on surrogates.

Conclusions: Translational processes in CBME involve negotiating with numerous influencing actors and institutions that, from an assessment perspective, provide challenges for assessment scientists, institutions and educators to contend with. These processes are challenging validity as a core element of assessment designs. Educators must reconcile these influences when preparing for or structuring validity arguments.

© 2020 John Wiley & Sons Ltd and The Association for the Study of Medical Education.

'Articles (Medical Education) > 교육과정 개발&평가' 카테고리의 다른 글

| 의대생들에게 어떻게 가르치는지를 가르치기: 스코핑 리뷰(Teach Learn Med. 2022) (0) | 2022.08.24 |

|---|---|

| 교육과정 혁신의 촉매로서 학생: 변화 관리 프레임워크 (Med Teach, 2020) (0) | 2022.08.06 |

| 프로그램 이론에 따른 CBME 개입의 과정과 성과 평가 (J Eval Clin Pract. 2020) (0) | 2022.06.18 |

| 역량중심의학교육(CBME)의 개선-지향 평가를 위한 12가지 팁(Med Teach, 2020) (0) | 2022.06.18 |

| 환경-정규화: 맥락 속 혁신의 수명을 평가하기 (Acad Med, 2021) (0) | 2022.06.14 |