보건의료전문직 교육의 평가 - 성과 측정은 충분한가? (Med Educ, 2022)

Evaluation in health professions education—Is measuring outcomes enough?

Louise M. Allen1 | Margaret Hay1 | Claire Palermo2

1 | 소개

1 | INTRODUCTION

평가 프로세스는 프로그램의 개발, 구현 및 결과에 대한 정보를 수집, 분류 및 해석하는 것을 목표로 한다. 평가는 다양한 목적이 있다. 여기에는 다음이 포함될 수 있다

- 시행 전에 프로그램의 타당성 판단,

- 프로그램이 의도한 대로 구현되었는지 판단,

- 프로그램의 영향측정 (개인을 중심으로 다양한 수준에서 또는 모집단 수준에서 훨씬 더 광범위한 수준일 수 있음),

- 프로그램 성과로 이어지는 메커니즘을 이해.

Evaluation processes aim to collect, sort and interpret information about the development, implementation and outcomes of programmes.1 Evaluations can have a range of goals. These may include

- determining the feasibility of a programme prior to implementation,

- determining if a programme was implemented as intended,

- measuring the effects of a programme (this can be at a variety of levels, focusing on individuals, or much broader at the population level) and

- understanding the mechanisms that lead to programme outcomes.1,2

건강 직업 교육(HPE)에서 평가는 필수적이다. 이를 통해 개입의 내용과 전달을 개선하고, HPE의 장단기 영향을 평가하고, 자금 할당에 대한 결정을 내릴 수 있습니다. 이상적으로 평가는 다음의 두 가지를 모두 의미한다.

- 프로그램 결과와 영향을 측정하는 것(성과 평가)

- 프로그램 평가로 이어지는 기본 프로세스를 이해하는 것(프로그램 평가)

Evaluation in health professions education (HPE) is essential. It allows us to improve the content and delivery of interventions, to assess a range of short and long-term impacts of HPE, and to make decisions on the allocation of funding. Ideally, evaluation refers to not only

- measuring programme outcomes and impacts (outcome evaluation), but also

- understanding the underlying processes that lead to them (programme evaluation).

HPE 연구에서, 엄격하고 이론을 활용하는 보다 강력한 접근법으로 향하는 경향이 증가하고 있다. 평가에 있어서, 이것은 [평가를 가이드하는 프레임워크 또는 모델을 사용하는 것]으로 해석된다. 다양한 평가 모델이 HPE에서 사용됩니다. 여기에는 다음이 있다.

- 성과 평가 모델(많이 인용된 커크패트릭 모델 및 건강 또는 HPE 설정에 대한 다양한 수정모델)

- 현실주의 평가와 같은 어떤 성과가 발생한 방법과 이유를 이해하는 것을 목표로 하는 보다 엄격한 프로그램 평가 모델(CIPP, 이론 중심 평가, 기여 분석, 계층 분석, 그리고 RE-AIM 프레임워크.)

Increasingly in HPE research, there has been a trend towards more robust approaches that are rigorous, and utilise theory.3,4 For evaluation, this has translated to the use of frameworks or models to guide evaluation. A range of evaluation models are used in HPE. These include

- outcome evaluation models such as the heavily cited Kirkpatrick Model5,6 and its various modifications specifically for the health or HPE settings,7–17 as well as

- more rigorous programme evaluation models that aim to understand how and why outcomes have occurred such as realist evaluation; Context, Input, Process and Product (CIPP) evaluation; theory-driven evaluation; contribution analysis; layered analysis; and the RE-AIM framework.

HPE에서 성과평가 모델의 사용은 점점 더 대중화되고 있다. 아마도 단순성 때문일 것이다. 그러나 복잡한 HPE 환경에서 결과 평가 모델을 사용하는 것에 대한 출판된 주의사항, 프로그램이 어떻게 그리고 왜 작동했는지에 초점을 맞추는 것을 넘어서야 한다는 요구, 결과 평가 모델에 대한 수많은 비판에도 불구하고, 그 사용은 계속 증가해 왔다.

The use of outcome evaluation models in HPE is becoming increasingly popular, perhaps due to their simplicity. However, despite published cautions of the use of outcome evaluation models in the complex HPE environment,18,19 calls to move beyond focusing on outcomes (did it work) to how and why programmes worked and what else happened,20 and a number of criticisms of outcome evaluation models,18,21–29 their use has continued to increase.

이 기사에서는 [성과 평가]와 [프로그램 평가]의 차이를 살펴본다. 우리는 광범위한 수용과 사용을 고려할 때 특히 커크패트릭 모델에 초점을 맞추어 결과 평가 모델의 사용을 검토하고 비판하며, 결과가 어떻게 그리고 왜 발생하는지를 이해하는 데 도움이 되는 평가 모델의 사용을 옹호하는 것을 목표로 한다.

In this article, we explore the difference between outcome evaluation and programme evaluation. We aim to review and critique the use of outcome evaluation models, with a particular focus on the Kirkpatrick Model given its wide acceptance and use, and advocate for the use of evaluation models that help us understand how and why outcomes are occurring.

2 | 프로그램 평가와 비교한 결과 평가 개요

2 | BRIEF OVERVIEW OF OUTCOME EVALUATION COMPARED WITH PROGRAMME EVALUATION

이름에서 알 수 있듯이, 성과 평가는 주어진 개입의 결과나 영향에 초점을 맞추고 '그것이 효과가 있었는가?'라는 질문에 답하려고 한다. 30 성과 평가는 일반적으로 적용하기가 쉽고 결과를 분류하는 복잡한 방법을 제공하는 인기 있는 커크패트릭 모델과 같은 분류법에 의해 안내된다. 실무에서, 이것은 종종 개입의 효과를 결정하는 것을 목적으로 하는 평가로 귀결되는데, 여기서 그 효과는 [미리 결정된 결과가 달성되었는지]를 결정함으로써 입증된다.20

As the name suggests, outcome evaluation focuses on the outcomes or impacts of a given intervention and seek to answer the question ‘Did it work?’30 Outcome evaluations are usually guided by a taxonomy, such as the popular Kirkpatrick Model, which is easy to apply and provides an uncomplicated way to classify outcomes.20,25 In practice, this often results in evaluations aimed at determining the effectiveness of an intervention, where effectiveness is demonstrated by determining if predetermined outcomes have been achieved.20

성과 평가는 특정 개입이 원하는 효과를 얻었는지에 대한 중요한 정보를 제공할 수 있지만, 교육 개입의 복잡한 성격과 결과, 장기적 결과 및 의도하지 않은 결과로 이어지는 프로세스를 무시하는 경향이 있다. 교육개입 연구의 대다수가 큰 차이를 보이지 않는 이유일 것이다.

While outcome evaluations can provide important information about if a specific intervention had the desired effect, they tend to neglect the complex nature of educational interventions and the processes that lead to outcomes, longer term outcomes and unintended outcomes. This is likely the reason that the vast majority of studies of educational interventions show no significant differences.30

반면 프로그램 평가는 '그것이 작동했는가?'를 넘어 '어떻게, 왜 작동했는가?'에 대답하는 것을 추구한다. 프로그램 평가는 [프로그램 성과] 외에 [프로그램의 설계 및 구현]과 관련이 있다.26 프로그램 평가의 목적은 '프로그램 내부와 외부 모두에서 프로그램 결과의 변동 원인을 식별하는 동시에, 이러한 변화의 출처(소스) 또는 성과 자체의 타당성을 판단하는 것'이다.따라서 HPE 연구의 초점이 되는 [복잡한 개입과 복잡한 시스템]을 평가하는 데 사용하는 것이 더 적절한 접근법이다. HPE에서 결과 평가의 사용이 매우 보편적이기 때문에, 다음 절에서는 HPE에서의 결과 평가의 사용에 대한 검토를 제공한다.

Programme evaluation on the other hand seeks to go beyond answering ‘Did it work?’ to ‘How and why did it work?’. Programme evaluation is concerned with the design and implementation of the programme, in addition to the programme outcomes.26 The aim of programme evaluation is ‘to identify the sources of variation in program outcomes both from within and outside the program, while determining whether these sources of variation or even the outcome itself are desirable or undesirable’ (p. 289).26 It is therefore a more appropriate approach to use in evaluating the complex interventions and systems that are usually the focus of HPE research. As the use of outcome evaluation is so prevalent in HPE, the following section provides a review of the use of outcome evaluations in HPE.

3 | HPE의 결과평가 모델 사용에 대한 비판적 검토 - KirkPatrick 모델 예시

3 | A CRITICAL REVIEW OF USING OUTCOME EVALUATION MODELS IN HPE— THE KIRKPATRICK MODEL EXAMPLE

3.1 | 커크패트릭 모델 개요

3.1 | Overview of the Kirkpatrick Model

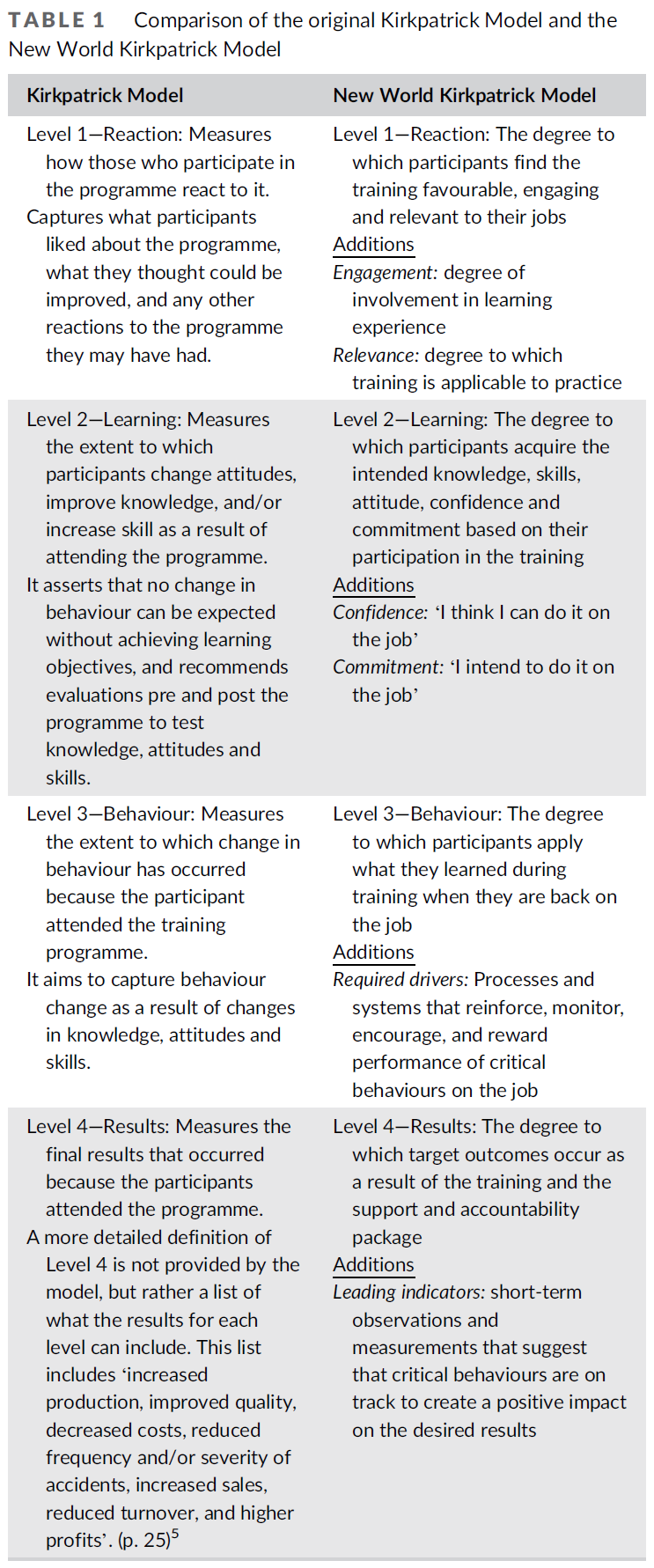

위에서 언급한 바와 같이, 커크패트릭 모델은 HPE의 평가에 널리 사용되어 왔습니다. 의대생, 레지던트 및 의사의 시뮬레이션, 간호 시뮬레이션, 전문가 간 학습, 지속적인 전문 개발, 온라인 학습 및 커리큘럼 평가를 포함한 다양한 교육 프로그램을 평가하는 데 사용되어 왔다. 이 모델은 1959년과 1960년 도널드 커크패트릭이 4개의 기사로 된 시리즈로 처음 발표했는데, 이는 인간관계 교육 책임자들이 평가 노력을 높일 수 있도록 지침을 제공하는 것을 목표로 했다. [뉴 월드 커크패트릭 모델]은 원래 커크패트릭 모델을 기반으로 제작되었으며 도널드 커크패트릭의 아들과 며느리(제임스 커크패트릭과 웬디 커크패트릭)가 2008년부터 2010년 사이에 모델을 현대화하기 위해 개발했다. 오리지널 및 뉴월드 커크패트릭 모델의 요약과 비교는 표 1에서 볼 수 있다. 궁극적으로 오리지널 모델과 뉴월드 모델은 모두 참여, 태도, 지식 및 기술, 행동 변화 및 전반적인 프로그램 결과에 초점을 맞춘 4단계 결과 평가 모델이다. 모델의 기원은 모델이 어떻게 개발되었는지에 대한 설명이나 커크패트릭의 출판물 또는 박사학위 논문의 이론적 또는 과학적 토대에 대한 언급이 없는 실용주의적인 것으로 보인다.

As mentioned above, the Kirkpatrick Model has been widely used in evaluation in HPE. It has been used to evaluate a range of education programmes including simulation in medical students, residents and physicians31–33; simulation in nursing34,35; interprofessional learning36; continuing professional development37–39; online learning40; and curriculum evaluation.41,42 The model was first published by Donald Kirkpatrick as a series of four articles in 1959 and 1960,43–46 which aimed to provide guidance to human relations training directors to increase their evaluation efforts. The New World Kirkpatrick Model builds on the original Kirkpatrick Model and was developed by Donald Kirkpatrick's son and daughter in law (James and Wendy Kirkpatrick) to modernise the model, sometime between 2008 and 2010.6,47 A summary and comparison of the original and New World Kirkpatrick Models can be seen in Table 1. Ultimately, both the original and the New World Model are four-level outcome evaluation models that focus on participation; attitudes, knowledge and skills; behaviour change; and overall programme results. The origins of the model are likely pragmatic, with no description of how the model was developed or reference to theoretical or scientific underpinnings of the model in any of Kirkpatrick's publications,5,6,43-46,48 or in his PhD.

3.2 | HPE에서 Kirkpatrick 모델의 사용

3.2 | Use of the Kirkpatrick Model in HPE

커크패트릭 모델은 HPE 평가에 널리 사용되어 왔다. HPE에서 Kirkpatrick 모델의 사용에 대한 개요를 얻기 위해 다음 검색자를 사용하여 네 개의 데이터베이스(OVID medline, Scopus, CINAHL 및 Pubmed)에 대한 체계적인 문헌 검색을 2020년 6월에 수행했다.

The Kirkpatrick Model has been used widely in the evaluation of HPE. To obtain an overview of the use of the Kirkpatrick Model in HPE, a systematic literature search of four databases (OVID medline, Scopus, CINAHL and Pubmed) was conducted in June 2020 using the following searchers:

1. ('의학교육' 또는 '건강교수*교육') 및 커크패트릭

1. (‘medical education’ OR ‘health prof* education’) AND Kirkpatrick

2. 평가 및 커크패트릭

2. Evaluation AND Kirkpatrick

검색에 적용된 날짜 범위가 없습니다. 반환된 모든 논문의 제목과 요약은 HPE 설정에서 Kirkpatrick Model을 추상적으로 참조하는 경우 선별되어 포함되었다. 이어 주요 의료교육 관련 기사가 빠지지 않도록 하기 위해 '커크패트릭(Kirkpatrick)'이라는 용어를 사용하여 HPE 저널(학술지, 의학교육지, BMC의학교육지, 보건과학교육지, 의료교육의 진보 및 관점)을 손으로 검색했다. 연구 또는 개입, 평가, 데이터 수집 또는 데이터 분석의 설계에서 Kirkpatrick 모델을 사용합니다.

No date range was applied to the search. Titles and abstracts of all returned papers were screened and included if the abstract referenced use of the Kirkpatrick Model in an HPE setting. Following this, to make sure no major articles were missed key medical education and HPE journals (Academic Medicine, Medical Education, Medical Teacher, BMC Medical Education, Advances in Health Science Education and Perspectives on Medical Education) were hand searched using the term ‘Kirkpatrick’ with all full texts searched for reference to the use of the Kirkpatrick Model in the design of the research or intervention, evaluation, data collection or data analysis.

이 조사는 커크패트릭 모델을 이용한 603개의 연구를 반환했다. 이 중 2000년 이전에 발표된 것은 3건(0.5%)에 불과해 HPE에서 커크패트릭 모델이 지난 20년 동안 주로 사용되었음을 알 수 있다. 커크패트릭 모델 사용은 2000년 이후 꾸준히 증가해 2018년(65편)과 2019년(110편) 사이에 69% 증가에 해당하는 가장 큰 증가폭을 보였다(그림 1). 표준화된 평가의 커크패트릭 방법, 커크패트릭의 이론, 검증된 커크패트릭의 모델, 커크패트릭의 평가 피라미드의 계층적 모델, 커크패트릭의 4단계 평가의 이론적 프레임워크, 복잡한 열차 평가를 위한 커크패트릭 프레임워크를 포함한 많은 용어들이 커크패트릭 모델을 언급하기 위해 사용됩니다.개입, 커크패트릭 커리큘럼 평가 프레임워크 및 커크패트릭 계층 구조.

The search returned 603 studies that utilised the Kirkpatrick Model in some way. Of these, only three (0.5%) were published prior to 2000, showing that the use of the Kirkpatrick Model in HPE has largely occurred in the last 20 years. Since 2000, the use of the Kirkpatrick Model has steadily increased, with the largest increase seen between 2018 (65 papers) and 2019 (110), which equates to a 69% increase (Figure 1). Many terms are used to refer to the Kirkpatrick Model, including the Kirkpatrick method of standardised evaluation, Kirkpatrick's theory, the validated Kirkpatrick's model, Kirkpatrick's hierarchical model of evaluation pyramid, the theoretical framework of Kirkpatrick's four levels of evaluation, Kirkpatrick framework for evaluating complex training interventions, the Kirkpatrick curriculum evaluation framework and the Kirkpatrick hierarchy.

커크패트릭 모델을 지칭하는 데 사용되는 이 용어는 일관성이 없으며 이론적 프레임워크 또는 검증된 모델이라는 오해를 증가시킨다.

This terminology used to refer to the Kirkpatrick Model is inconsistent and increases the misconception that it is a theoretical framework or validated model.

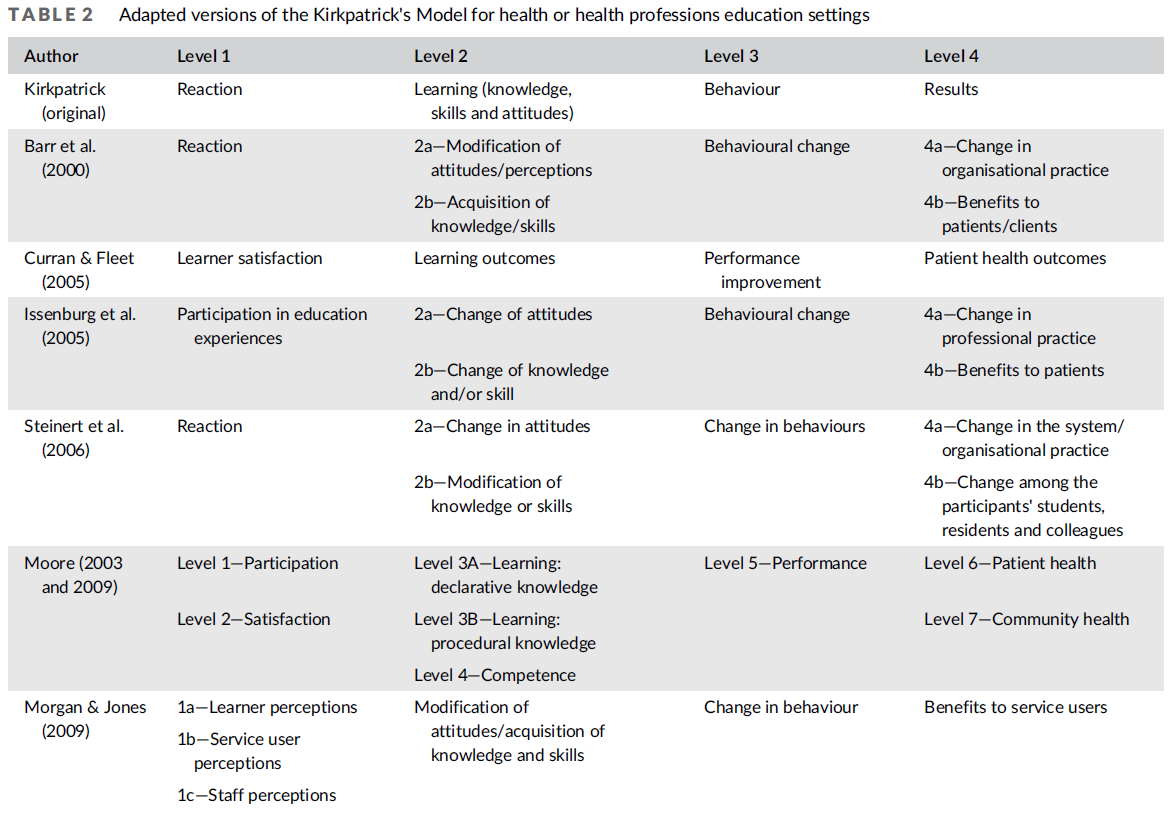

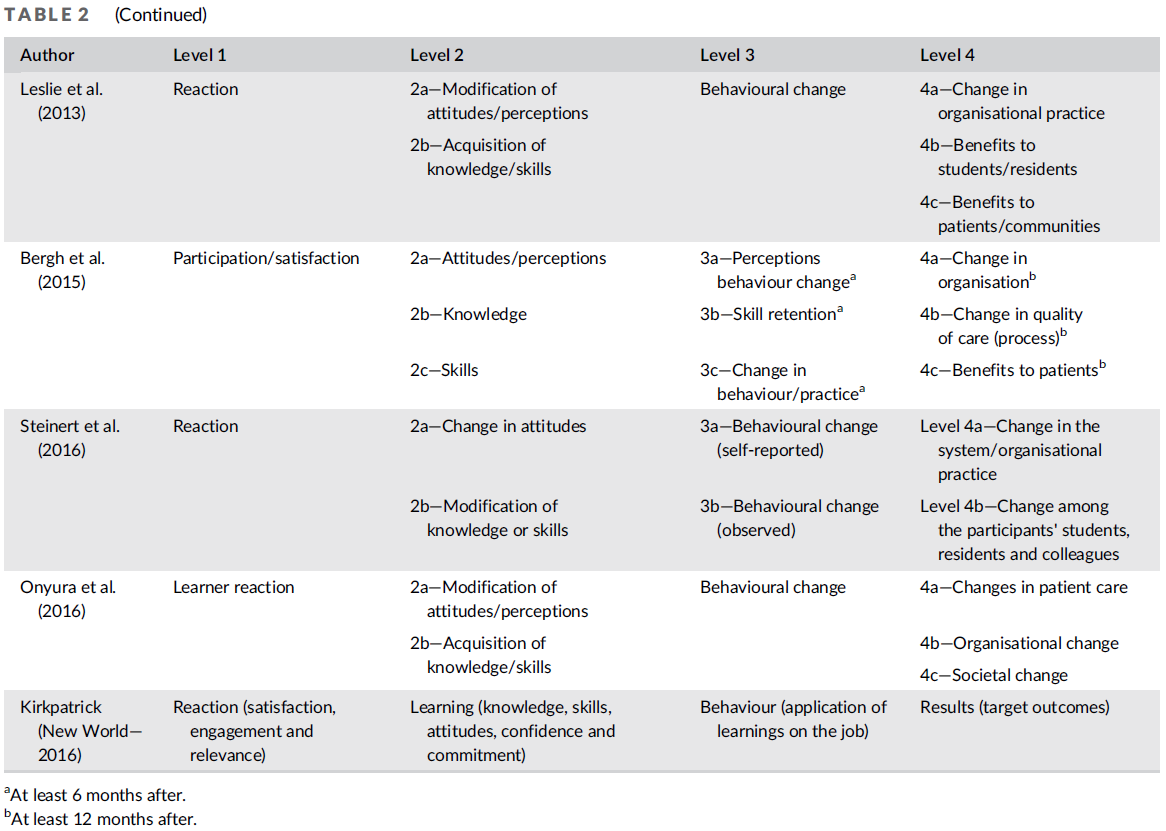

위에서 검색한 많은 연구는 오리지널 Kirkpatrick 모델을 사용합니다. 앞서 언급했듯이, 건강 또는 HPE 설정을 위해 특별히 만들어진 모델의 많은 개조도 있었다. 이러한 수정된 버전의 커크패트릭 모델의 요약은 표 2에서 볼 수 있다. 대부분의 경우, 이러한 수정된 버전은 원래 모델과 동일한 4단계 구조를 유지하고 있으며, 레벨이 어떻게 구성되는지에 대해서는 약간의 차이가 있다. 이러한 수정된 버전의 커크패트릭 모델 간의 주요 차이점은 레벨 4(결과)를 나타내는 방식이 다르다는 것입니다. 수정된 버전마다 다양한 조합을 사용하고 있다.

- 조직 관행의 변화,

- 환자 또는 서비스 사용자에 대한 혜택,

- 전문직 관행의 변화,

- 의료의 질의 변화,

- 학생과 교육생의 변화,

- 동료 간의 변화,

- 지역사회에 대한 혜택 및 사회 변화

A number of the studies returned in the above search use the original Kirkpatrick Model. As mentioned previously, there have also been a number of adaptations of the model created specifically for the health or HPE settings. A summary of these modified versions of the Kirkpatrick Model can be seen in Table 2. For the most part, these modified versions retain the same four-level structure as the original model, with some variations as to how the levels are structured. The main difference between these modified versions of the Kirkpatrick Model is the different ways they represent Level 4 (results). The various modifications look at various combinations of

- change in organisational practice,

- benefits to patients or service users,

- change in professional practice,

- change in quality of care,

- change among students and trainees,

- change among colleagues,

- benefits to the community and societal changes.

보건 및 HPE 분야에 더 특화된 이러한 많은 각색에도 불구하고 2020년에 발표된 55개 논문 중 오직 6개(11%)만이 이러한 수정된 버전 중 하나를 사용하고 있으며, 그 해에 발표된 논문의 대부분은 원래의 커크패트릭 모델 버전(n = 35, 64%)을 참조하고 있고, 7개(13%)만이 '뉴월드' 버전을 참조하고 있다. 또한 2020년에 발표된 55개의 논문이 커크패트릭 모델(또는 각색 버전 중 하나)을 어떻게 사용했는지 살펴보면, 커크패트릭 모델이 프로그램 개발에 사용된다는 보고가 거의 없으며, 그 중 1개 논문(1.8%)만이 그렇게 하고 있다. 이것은 [개입의 설계에 사용되어야 한다]는 모델의 핵심 원칙 중 하나와 모순된다. 모델의 일관되지 않은 적용이 분명히 있으며, 이는 결과의 일반화를 문제시한다.

Despite these many adaptations that are more specific to the health and HPE fields, of the 55 papers published in 2020, only six (11%) use one of these modified versions, with the majority of papers published that year referencing a version of the original Kirkpatrick Model (n = 35, 64%), and only seven (13%) referencing the ‘New World’ version. Furthermore, when looking at how the 55 papers published in 2020 used the Kirkpatrick Model (or one of the adapted versions), it is seldom reported that the Kirkpatrick Model is used in the development of programmes, with only one paper (1.8%) doing so. This contradicts one of the key principles of the model, which states that it should be used in intervention design. There is clearly an inconsistent application of the model, which make generalisations of findings problematic.

보건 분야의 교육 개입을 평가하는 데 사용될 뿐만 아니라, 커크패트릭 모델은 의료 교육에서 일반적으로 사용되는 품질 평가 도구인 MERSQI(의료 교육 연구 품질 기구)의 일부를 형성한다. 2007년에는 실험, 준실험, 관측 연구의 품질을 측정하기 위해 MERSQI가 개발되었다. MERSQI의 내용은 '… 연구 저자들 간의 연구 품질 및 비판적 토론과 도구 개정에 대한 보고서의 종합적인 문헌 검토에 의해 결정된다'(1003쪽). 커크패트릭 모델은 MERSQI의 10번 문항이며, 환자 또는 건강 결과가 가장 높고 만족도 및 태도 결과가 가장 낮은 점수 기반 시스템을 사용하여 결과를 분류한다.

In addition to being used to evaluate educational interventions in the health professions, the Kirkpatrick Model also forms part of a commonly used quality assessment tool in medical education, the Medical Education Research Study Quality Instrument (MERSQI). In 2007, the MERSQI was developed to measure the quality of experimental, quasi-experimental and observational studies.49 The content of the MERSQI was ‘… determined by a comprehensive literature review of reports on research quality and critical discussion and instrument revision among the study authors’ (p. 1003).49 The Kirkpatrick Model forms item 10 of the MERSQI, which classifies outcomes using a points based system where patient or health outcomes score the highest and satisfaction and attitude outcomes score the lowest.

세계보건기구(WHO)도 훈련 평가 가이드의 기초로 커크패트릭 모델을 채택했다. 그리고 커크패트릭 모델의 수정된 버전은 BEME(Best Evidence Medical Education)에 의해 채택되었으며 검토 코딩 시트의 일부를 형성한다. 코딩 시트는 의도된 결과와 의도되지 않은 결과를 고려하는 것을 포함하지만, 이러한 결과는 연구자들이 그들의 평가에서 의도하지 않은 결과를 고려할 때에만 포착할 수 있다. BEME 검토 프레임워크는 앞서 언급한 바와 같이 교육 개입의 영향을 분류하거나 분류하는 데 도움이 되는 커크패트릭 모델을 주로 사용한다.BEME 검토자들은 커크패트릭 모델을 품질 지표로서가 아니라 근거를 정리organize하기 위해 사용한다.51 그러나, 어떤 리뷰는 커크패트릭 모델을 위계로 언급하여 상위 수준의 중요성을 암시하는 반면, 어떤 리뷰들은 인과관계나 위계질서가 가정되지 않는다고 말한다. 또한 일부 BEME 리뷰에서는 연구의 질을 평가하기 위해 MERSQI를 사용하기도 하는데, 위에서 언급한 것처럼 MERSQI의 구성 요소 중 하나가 커크패트릭 모델이다.

The World Health Organisation (WHO) also adopted the Kirkpatrick Model as the basis for their training evaluation guide.50 And a modified version of the Kirkpatrick Model has been adopted by the Best Evidence Medical Education (BEME) and forms part of their review coding sheet. The coding sheet does include considering intended and unintended outcomes, but these can only be captured when researchers consider unintended outcomes in their evaluations. The BEME review framework largely uses the Kirkpatrick Model to aid in classifying or categorising impacts of educational interventions, as has been previously stated—BEME reviewers use the Kirkpatrick Model to organise evidence, rather than as a quality indicator.51 However, there is some inconsistency in its use, with some reviews referring to the Kirkpatrick Model as a hierarchy, implying increasing importance with increasing levels,10,52–63 whereas others state that no causality or hierarchy are assumed. Furthermore, some BEME reviews use the MERSQI to assess study quality, and as mentioned above, one component of the MERSQI is the Kirkpatrick Model.

MERSQI, BEME 및 WHO가 커크패트릭 모델을 사용하는 것은 커크패트릭 모델이 프로그램 평가의 gold standard라는 믿음이나 오해에 기여한다. 따라서 커크패트릭 모델을 MERSQI, BEME, WHO의 일부로 사용하는 것은 재고될 필요가 있다. 더 높은 수준의 커크패트릭 모델을 품질 지표로 사용하는 것은 커크패트릭 자신이 레벨이 계층 구조로 간주되어서는 안 된다고 언급하면서 부적절하다.

The use of the Kirkpatrick Model by the MERSQI, BEME and WHO contribute to the myth or misconception that the Kirkpatrick Model is the gold standard for programme evaluation. As such, the use of the Kirkpatrick Model as part of the MERSQI, BEME and WHO needs to be reconsidered. Using the higher levels of the Kirkpatrick Model as an indicator of quality is inappropriate with Kirkpatrick himself stating that the levels should not be considered a hierarchy.

3.3 | Kirkpatrick 모델의 비판

3.3 | Critiques of the Kirkpatrick Model

커크패트릭 모델이 HPE 평가에 널리 사용되는 것은 분명하지만, HPE 분야에 대해 내외부에서 모델에 대한 많은 비판이 있었다. 다음 단락은 모델에 대한 주요 비판 사항을 간략하게 요약한 것입니다.

- 첫째, 모델은 성과에 중점을 두기 때문에 훈련 성과에 영향을 미칠 수 있는 개인 및 환경 요소를 고려하지 못한다. 성과에 영향을 미치는 근본적인 메커니즘을 탐구하는 것을 허용하지 않는다. 게다가, 집중의 결과는 단기적이고 수량화 가능한 결과입니다. 장기적으로는 수준 3과 수준 4에서 예상되는 것과 같은 복잡한 결과를 평가하기 어려우며, 수준 1과 수준 2가 수준 3과 4보다 더 자주 측정된다는 사실이 이를 증명한다.

- 둘째, 이 모형은 수준 사이에 양의 인과 관계가 있다고 가정합니다. 즉, 호의적인 반응이 학습 향상에 기여하여 행동 변화와 긍정적인 프로그램 결과로 이어진다. 하지만, 배우는 것은 불편하고 좌절감을 주지만 여전히 배움으로 이어질 수 있습니다. 게다가, 학습을 실천으로 옮기는 우리의 능력에 영향을 미치는 많은 요인들이 있습니다. 이와 같이 긍정적인 인과 관계를 가정할 수 없다.

- 셋째, 높은 레벨의 성과일수록 중요하다는 가정이 있습니다. 이는 반드시 그런 것은 아니며 평가의 목적에 따라 달라진다. 만약 평가가 교육 개입의 내용과 전달을 개선하는 것을 목표로 한다면, 레벨 1의 결과는 매우 유용할 것입니다. 평가가 실제로 스킬의 이행을 측정하는 것을 목표로 한다면, 레벨 3 결과가 가장 유용할 것입니다.

- 마지막으로, 커크패트릭 모델은 교육 개입의 의도된 결과에 초점을 맞추고, 모델에 의해 분류되지 않은 영향과 의도하지 않은 영향을 무시한다.

While the Kirkpatrick Model is clearly widely in used in HPE evaluation, there have been a number of criticisms of the model, both within and external to the field of HPE.18,21–29 The following paragraph provides a brief summary of the major criticisms of the model.

- First, the model is outcomes focused, and as such, it fails to consider individual and environmental factors that can impact training outcomes.22–26 It does not allow for the underlying mechanisms that influence outcomes to be explored.23–26 Furthermore, the outcomes of focus are short-term, quantifiable outcomes. Longer term, complex outcomes, such as those expected in Level 3 and Level 4 are challenging to evaluate, evidenced by the fact that Levels 1 and 2 are measured more frequently than Levels 3 and 4.11,16,18

- Second, the model assumes that there are positive causal linkages between the levels. That is, that favourable reactions contribute to greater learning, leading to behaviour change and positive programme results. However, learning can be uncomfortable and frustrating yet still lead to learning. In addition, there are many factors that affect our ability to transfer learning to practice. As such, positive causal linkages cannot be assumed.

- Third, there is an assumption that the higher the level, the more important the outcome. This is not necessarily the case and depends on the objective of the evaluation. If the evaluation is aiming to improve the content and delivery of the education intervention, then Level 1 outcomes will be highly useful. If the evaluation is aiming to measure the implementation of a skill in practice, then Level 3 outcomes will be most useful.

- Finally, the Kirkpatrick Model focuses on intended outcomes of the educational intervention, neglecting impacts not categorised by the model as well as unintended impacts:

"결과 X는 의도한 대로 이루어졌는가, 그렇지 않은가?" "이 개입의 결과는 무엇이었는가?" 임상에 비교한다면, (커크패트릭 모델은) 신약에 대해서 부작용은 빼고 의도된 효과만을 측정하는 임상시험이 될 것이다. (p. 100)64

“Was outcome X achieved as intended, or not?” rather than “What were the outcomes of this intervention?” A clinical parallel would be a clinical trial that measured only the intended effects of a new drug and not its side-effects. (p. 100)64

이 비평들은 커크패트릭의 아들이 커크패트릭 모델을 신세계 커크패트릭 모델로 개정하기 전에 출판되었다. 이러한 문제들 중 일부는 뉴월드 모델에서 다루어지지만, 몇 가지 짧은 의견들이 남아 있다.

- 모델은 여전히 훈련 프로그램의 [의도하지 않은 성과를 다루지 못하기] 때문에 가치있는 임팩트가 포착되지 않을 가능성이 있다.

- 레벨 3에 필요한 동인을 포함하면 평가자가 변화 가능자enablers를 고려하도록 유도하지만, 변화에 대한 장벽barriers은 거의 강조하지 않으며, 이것이 종종 학습이 실천으로 이전되지 않는 이유이다.

- 모델은 여전히 학습 성과에 영향을 미칠 수 있는 [사회 규범, 정치적 영향, 교육 정책 및 학습에 대한 미디어의 역할]과 같은 개인 외부의 광범위한 요소를 고려할 수 없다.

- 무엇보다 오리지널이든 뉴월드든 커크패트릭 모델의 일부로 명확하게 표현되지 않지만 매우 중요한 임팩트에 해당하는 것들이 있다. 예를 들어, 연결, 네트워크 및 커뮤니티의 개발, 그리고 정체성(또는 정체성) 등은 보건 전문가들에게 점점 더 중요한 것으로 나타나고 있다. 그러나 커크패트릭 모델은 연결의 강화 또는 개발, 그리고 정체성을 교육 개입의 중요한 영향으로서 인식하지 못한다.

These critiques were published before the revision of the Kirkpatrick Model to the New World Kirkpatrick Model by Kirkpatrick's son. While some of these issues are addressed in the New World Model, there remain a number of short comings.

- The model still fails to address unintended outcomes of training programmes, as such there is the potential that valuable impacts are not being captured.

- The inclusion of required drivers in Level 3 prompts evaluators to consider enablers to change but places little emphasis on barriers to change, which are often why transfer of learning to practice does not occur.

- There is no capacity of the model to consider broader factors outside the individual that may be influencing learning outcomes, such as social norms, political influences, education policy and the role of media on learning.

- Furthermore, there is a range of important impacts that are not clearly articulated as part of the original, or New World Kirkpatrick Model. For example, the development of connections, networks and, a community; and identity (or identities) are being shown to be increasingly important to health professionals.65-67 Yet, the Kirkpatrick Model fails to recognise the strengthening or development of connections, and identity as important impacts of educational interventions.

4 | 결과 평가만으로는 충분하지 않음—결과 평가를 넘어 프로그램 평가로 넘어가는 방법

4 | OUTCOME EVALUATION IS NOT ENOUGH—HOW TO MOVE BEYOND OUTCOME EVALUATION TO PROGRAMME EVALUATION

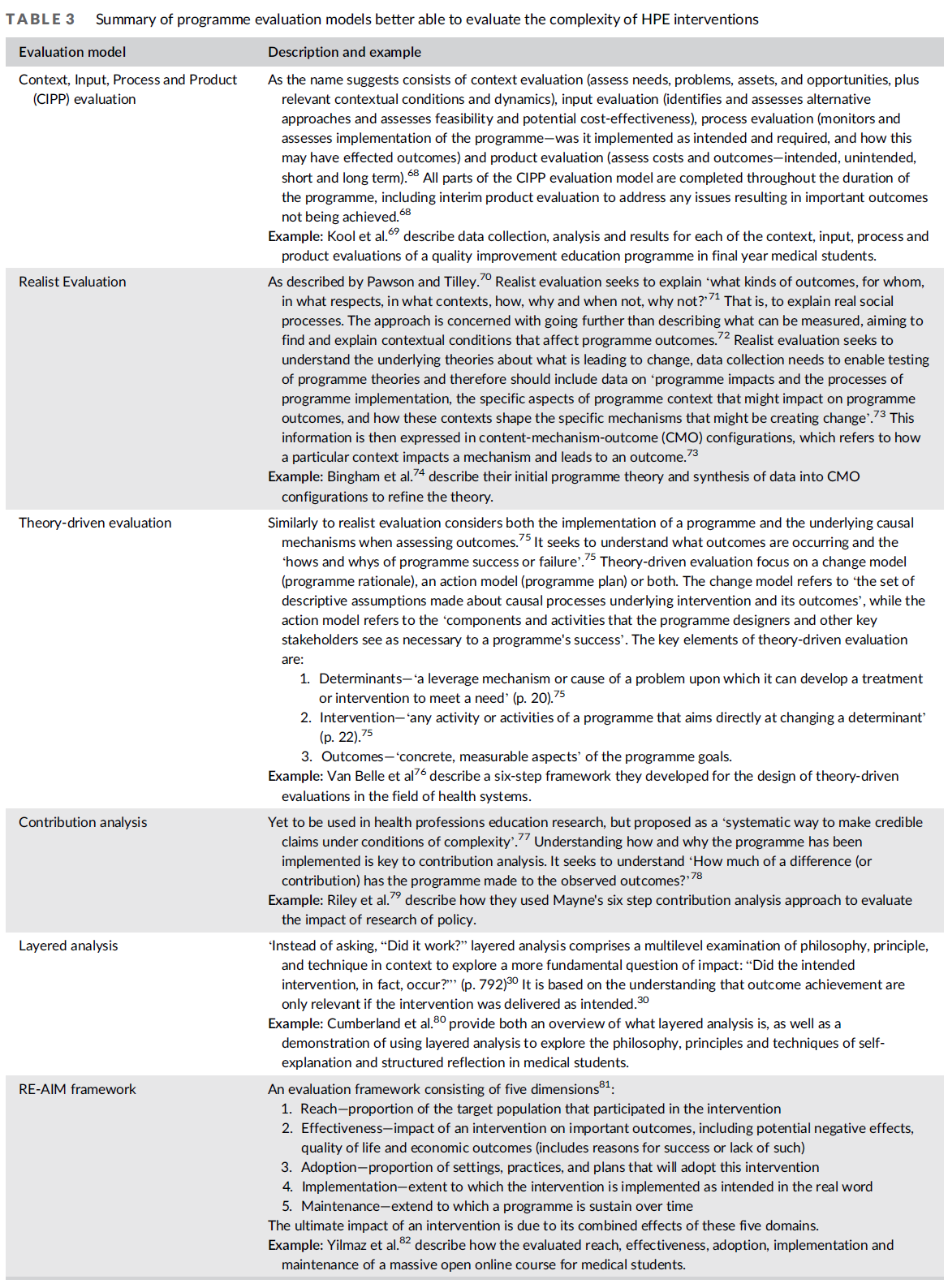

성과 평가 모델이 수많은 이유로 프로그램 평가의 황금 표준이 되어서는 안 된다는 것은 커크패트릭 모델의 예로부터 명백하다. 우리는 연구자와 평가자 모두에게 미리 결정된 결과에 초점을 맞추고 결과가 발생하는 방법과 이유를 탐구하지 못하는 결과 평가에서 벗어나 HPE 개입의 복잡성을 포착할 수 있는 프로그램 평가 모델로 이동할 수 있는 권한을 부여해야 한다. HPE에서 사용할 수 있는 많은 다른 평가 모델이 있지만, Kirkpatrick 모델보다 덜 자주 사용되지만 HPE에서 발생하는 복잡한 프로세스를 평가하는 데 더 적합하다. 표 3은 의도하지 않은 결과, 프로그램 구현 및 영향이 발생하는 방법 및 이유를 탐색할 수 있는 능력을 위해 선택된 6개의 모델을 요약한 것이다. 표 3은 각 모델에 대한 설명과 이 모델을 잘 사용한 연구의 예를 보여줍니다. 예시는 존재하는 HPE 또는 존재하지 않는 다른 건강 관련 분야에서 도출되었다.

It is clear from the example of the Kirkpatrick Model that outcome evaluation models should not be the gold standard for programme evaluation for a myriad of reasons. We need to empower both researchers and evaluators to move away from outcome evaluation that focuses on predetermined outcomes and fails to explore how and why the outcomes occur, to programme evaluation models that are capable of capturing the complexities of HPE interventions. There are a number of other evaluation models that can be used in HPE, that while used less frequently than the Kirkpatrick Model, are better placed to evaluate the complex processes that occur in HPE. Table 3 presents a summary of six of these models, which were chosen for their ability to explore unintended outcomes, programme implementation, as well and how and why impacts occur. Table 3 includes a description of each model and an example of research that has used the model well. Examples have been drawn from HPE where they exist, or from other health-related fields where they do not.

컨텍스트, 입력, 프로세스 및 제품(CIPP) 평가

Context, Input, Process and Product (CIPP) evaluation

이름에서 알 수 있듯이 다음으로 구성된다.

- 컨텍스트 평가(평가 요구, 문제, 자산 및 기회, 관련 컨텍스트 조건 및 역학),

- 투입 평가(대안 접근 방식을 식별 및 평가하고 타당성 및 잠재적 비용 효과 평가),

- 프로세스 평가(모니터 및 프로그램의 구현 평가: 의도와 요구대로 구현되었는지, 그리고 이것이 결과에 어떤 영향을 미칠 수 있는지),

- 산출 평가(비용과 성과의 평가 - 의도하거나 의도하지 않은 것, 단기 및 장기).68

As the name suggests consists of

- context evaluation (assess needs, problems, assets, and opportunities, plus relevant contextual conditions and dynamics),

- input evaluation (identifies and assesses alternative approaches and assesses feasibility and potential cost-effectiveness),

- process evaluation (monitors and assesses implementation of the programme—was it implemented as intended and required, and how this may have effected outcomes) and

- product evaluation (assess costs and outcomes—intended, unintended, short and long term).68

CIPP 평가모형의 모든 부분은 프로그램 기간 동안 완료되며, 여기에는 중요한 성과를 달성하지 못할 때의 문제를 해결하기 위한 중간 산출 평가도 포함한다.

All parts of the CIPP evaluation model are completed throughout the duration of the programme, including interim product evaluation to address any issues resulting in important outcomes not being achieved.68

현실주의 평가

Realist Evaluation

Pawson과 Tilley에 의해 기술된 바와 같이, 70 현실주의 평가는 '누구를 위해, 어떤 맥락에서, 어떻게, 왜 그리고 언제, 왜 그렇지 않은가'를 설명하고자 한다. 즉, 실제 사회 과정real social process을 설명하는 것입니다. 이 접근방식은 단순히 측정 가능한 것을 설명하는 것에 그치지 않으며, 프로그램 성과에 영향을 미치는 상황적 조건을 찾고 설명하는 것을 목표로 한다. 현실주의 평가는 [무엇이 변화를 가져오는지에 대한 기저 이론]을 이해하고자 하며, 데이터 수집은 프로그램 이론의 테스트를 가능하게 할 필요가 있으므로 '프로그램 영향과 프로그램 구현 프로세스, 프로그램 결과에 영향을 미칠 수 있는 프로그램 컨텍스트의 특정 측면 및 어떻게 특정 컨텍스트가 변화를 유발하는 특정 메커니즘을 형성하는지'에 대한 데이터를 포함해야 한다. 그런 다음 이 정보는 특정 컨텍스트가 메커니즘에 영향을 미치고 결과로 이어지는 방법을 나타내는 CMO(Content-Mechanism-outcome) 구성으로 표현된다.

As described by Pawson and Tilley.70 Realist evaluation seeks to explain ‘what kinds of outcomes, for whom, in what respects, in what contexts, how, why and when not, why not?’71 That is, to explain real social processes. The approach is concerned with going further than describing what can be measured, aiming to find and explain contextual conditions that affect programme outcomes.72 Realist evaluation seeks to understand the underlying theories about what is leading to change, data collection needs to enable testing of programme theories and therefore should include data on ‘programme impacts and the processes of programme implementation, the specific aspects of programme context that might impact on programme outcomes, and how these contexts shape the specific mechanisms that might be creating change’.73 This information is then expressed in content-mechanism-outcome (CMO) configurations, which refers to how a particular context impacts a mechanism and leads to an outcome.73

이론 중심 평가

Theory-driven evaluation

현실주의 평가와 유사하게, 결과를 평가할 때 프로그램의 구현과 근본적인 인과 메커니즘 모두를 고려한다. 75 이론 중심 평가는 변화 모델(프로그램 근거), 실행 모델(프로그램 계획) 또는 두 가지 모두에 초점을 맞춘다.

- 변화모델은 '개입과 성과의 근간을 이루는 인과적 과정에 관한 일군의 서술적 가정'을 언급하는 반면,

- 실행모델은 '프로그램 설계자와 기타 주요 이해관계자가 프로그램의 성공에 필요하다고 생각하는 구성요소 및 활동'을 언급한다.

Similarly to realist evaluation considers both the implementation of a programme and the underlying causal mechanisms when assessing outcomes.75 It seeks to understand what outcomes are occurring and the ‘hows and whys of programme success or failure’.75 Theory-driven evaluation focus on a change model (programme rationale), an action model (programme plan) or both.

- The change model refers to ‘the set of descriptive assumptions made about causal processes underlying intervention and its outcomes’, while

- the action model refers to the ‘components and activities that the programme designers and other key stakeholders see as necessary to a programme's success’.

이론 중심 평가의 핵심 요소는 다음과 같다.

The key elements of theory-driven evaluation are:

1. 결정 요인—'니즈 충족을 위해 치료나 개입을 개발하게 하는 레버리지 메커니즘 또는 문제의 원인'(20페이지)

1. Determinants—‘a leverage mechanism or cause of a problem upon which it can develop a treatment or intervention to meet a need’ (p. 20).75

2. 개입—'결정요인에 대한 직접적 변화를 목표로 하는 프로그램의 모든 활동'

2. Intervention—‘any activity or activities of a programme that aims directly at changing a determinant’ (p. 22).75

3. 결과—프로그램 목표의 '구체적이고 측정 가능한 측면'

3. Outcomes—‘concrete, measurable aspects’ of the programme goals.

기여도분석

Contribution analysis

그러나 보건 전문직 교육 연구에 사용되지는 않았지만, '복잡한 조건에서 신뢰할 수 있는 주장을 하는 체계적인 방법'으로 제안되었다.77 프로그램이 구현된 방법과 이유를 이해하는 것이 기여 분석의 핵심이다. 그것은 '프로그램이 관찰된 결과에 얼마나 많은 차이(또는 기여)를 가져왔는가?'를 이해하고자 한다.

Yet to be used in health professions education research, but proposed as a ‘systematic way to make credible claims under conditions of complexity’.77 Understanding how and why the programme has been implemented is key to contribution analysis. It seeks to understand ‘How much of a difference (or contribution) has the programme made to the observed outcomes?’78

레이어드 분석

Layered analysis

'그것이 효과가 있었느냐'는 질문 대신, 계층 분석은 영향의 보다 근본적인 질문을 탐구하기 위해 철학, 원리, 기법에 대한 다층적 검사를 포함한다: "의도된 개입이, "실제로", 일어났는가?" (792쪽)30 성과 달성은 '개입이 오직 의도한 대로 전달되었을 경우에만' relevant한 것이다"는 이해에 기초한다

‘Instead of asking, “Did it work?” layered analysis comprises a multilevel examination of philosophy, principle, and technique in context to explore a more fundamental question of impact: “Did the intended intervention, in fact, occur?”’ (p. 792)30 It is based on the understanding that outcome achievement are only relevant if the intervention was delivered as intended.30

RE-AIM 프레임워크

RE-AIM framework

5개 차원으로 구성된 평가 프레임워크81:

1. 도달 범위—개입에 참여한 목표 인구의 비율

2. 효과—잠재적인 부정적 영향, 삶의 질 및 경제적 결과를 포함한 중요한 결과에 대한 개입의 영향(성공 또는 실패에 대한 이유 포함)

3. 채택—이 개입을 채택할 설정, 관행 및 계획의 비율

4. 구현—실제 단어에서 의도한 대로 개입이 구현되는 범위

5. 유지보수—시간이 지남에 따라 프로그램이 지속되는 범위

개입의 궁극적인 영향은 이 5개 영역의 결합 효과 때문이다.

An evaluation framework consisting of five dimensions81:

1. Reach—proportion of the target population that participated in the intervention

2. Effectiveness—impact of an intervention on important outcomes, including potential negative effects, quality of life and economic outcomes (includes reasons for success or lack of such)

3. Adoption—proportion of settings, practices, and plans that will adopt this intervention

4. Implementation—extent to which the intervention is implemented as intended in the real word

5. Maintenance—extend to which a programme is sustain over time

The ultimate impact of an intervention is due to its combined effects of these five domains.

이러한 모델은 성과 평가보다 더 복잡하고 시간 소모가 클 수 있으며, 이는 모델을 덜 자주 사용하는 이유에 기여하는 요인일 가능성이 높다. 그러나, 우리는 HPE의 복잡한 개입과 함께 작업하며, 이러한 모델들은 개입 결과와 그것들이 어떻게 그리고 왜 일어나거나 일어나지 않는지를 더 잘 이해할 수 있는 다른 것들 중에서 [내부 및 외부 요인, 의도하지 않은 결과, 이론 및 프로그램 구현]을 모두 고려할 수 있게 한다. 이러한 유형의 프로그램 평가 접근방식을 사용하지 않고는 개입이 의도한 대로 구현되었는지 확신할 수 없으며 개입이 성공했는지 또는 실패했는지 설명할 수 없다.

These models are more complex and can be more time consuming than outcome evaluations, which is likely a contributing factor to why they are used less frequently. However, we work with complex interventions in HPE, and these models allow us to consider both internal and external factors, unintended outcomes, theory and programme implementation, among other things that enable greater understanding of intervention outcomes and how and why they do and do not occur. Without using these types of programme evaluation approaches, we cannot be sure that interventions have been implemented as intended, nor can we explain why interventions have, or have not, been successful.

그림 2와 같이 이러한 프로그램 평가 모델 중 일부의 사용이 증가하는 추세로 서서히 변화하고 있다. 이 수치는 위에서 설명한 4개의 데이터베이스와 6개의 저널에 대한 체계적인 문헌 검색을 반복하여 생성되었지만 커크패트릭 대신 6개의 프로그램 평가 모델의 이름을 사용하여 생성되었다. 2020년 6월 9일까지 HPE에 603개의 출판물이 있었던 커크패트릭 모델과 비교하면, 6개의 프로그램 평가 모델은 2021년 8월 16일까지 57개의 출판물이 있다. 57개의 출판물 중 56개가 그림 2에 나타나 있으며, 2000년 이전에 발표된 논문은 단 1개뿐이어서 그림에 포함되지 않았다. 이러한 모델들의 느린 사용 증가에도 불구하고, 커크패트릭 모델의 사용은 여전히 상당히 높으며 그림 1에서 볼 수 있듯이 훨씬 더 빠른 속도로 성장하고 있다.

There is a slow shift to the increasing use of some of these programme evaluation models, as shown in Figure 2. The figure was generated by repeating the systematic literature search of four databases and the six journals described above but using the names of the six programme evaluation models in the place of Kirkpatrick. Compared with the Kirkpatrick Model, which up until 9 June 2020 had 603 publications in HPE, the six programme evaluation models have 57 publications up until 16 August 2021. Fifty-six of the 57 publications are depicted in Figure 2, with only one paper published prior to 2000 and hence not included in the figure. Despite this slow increase in the use of these models, the use of the Kirkpatrick Model is still substantially higher and continues to grow at a much faster rate as demonstrated in Figure 1.

우리는 Kirkpatrick 모델을 사용하여 수행된 것과 같은 결과 평가가 금본위제라는 이 신화를 불식시키고 프로그램이 의도대로 전달되는지, 결과가 어떻게 그리고 왜 발생하는지를 이해하는 데 도움이 되는 프로그램 평가 접근법의 사용을 옹호하기 위해 WHO, MERSQI, BEME 및 보건 및 HPE의 다른 리더가 필요하다.표 3에 기술된 것과 같은 프로그램 평가 접근방식을 사용할 경우, 평가를 위한 계획을 조기에 수행하는 것이 필수적이다. 그것을 사후적인 생각이나 개입의 마지막에 일어나는 것으로 생각하기보다는 HPE 개입을 설계하고 실행하는 과정으로 연계할 필요가 있다.

We need WHO, MERSQI, BEME and other leaders in health and HPE to dispel this myth that outcome evaluations such as those done using the Kirkpatrick Model are the gold standard and to advocate for the use of programme evaluation approaches that help us understand if programmes are being delivered as intended, as well as how and why outcomes are occurring. When using programme evaluation approaches such as those described in Table 3, it is imperative that planning for evaluation is done early. Rather than thinking of it as an afterthought, or something that happens at the end of an intervention, it needs to be interwoven into the processes of designing and implementing HPE interventions.

doi: 10.1111/medu.14654. Epub 2021 Sep 16.

Evaluation in health professions education-Is measuring outcomes enough?

PMID: 34463357

DOI: 10.1111/medu.14654

Abstract

Introduction: In an effort to increase the rigour of evaluation in health professions education (HPE), a range of evaluation approaches are used. These largely focus on outcome evaluation as opposed to programme evaluation. We aim to review and critique the use of outcome evaluation models, using the Kirkpatrick Model as an example given its wide acceptance and use, and advocate for the use of programme evaluation models that help us understand how and why outcomes are occurring.

Methods: We systematically searched OVID medline, Scopus, CINAHL and Pubmed, and hand searched six leading HPE journals to provide an overview of the use of the Kirkpatrick Model as well as a range of programme evaluation models in HPE. In addition to this, we synthesised the existing critiques of the Kirkpatrick Model as an example of outcome evaluation, to highlight the limitations of such models.

Results: The use of the Kirkpatrick Model in HPE is widespread and increasing; however, studies focus on categorising outcomes, rather than explaining how and why they occur. The main criticisms of the model are as follows: it is outcomes focused and fails to consider factors that can impact training outcomes; it assumes positive casual linkages between the levels; there is an assumption that the higher-level outcomes are more important; and unintended impacts are not considered. The use of the Kirkpatrick Model by the MERSQI, BEME and WHO contribute to the myth that the Kirkpatrick Model is the gold standard for programme evaluation.

Discussion: Moving forward, evaluations of HPE interventions must shift from focusing largely on measuring outcomes of interventions with little consideration for how and why these outcomes are occurring to programme evaluation that investigates what contributes to these outcomes. Other models that facilitate the evaluation of the complex processes that occur in HPE should be used instead of Kirkpatrick's.

© 2021 Association for the Study of Medical Education and John Wiley & Sons Ltd.

'Articles (Medical Education) > 교육과정 개발&평가' 카테고리의 다른 글

| 의사소통, 학습, 평가: 디지털 학습 환경의 차원 탐색(Med Teach, 2019) (0) | 2022.03.18 |

|---|---|

| 인식론, 문화, 정의, 권력: 의학 훈련을 위한 비-생물과학적 지식(Med Educ, 2017) (0) | 2022.02.24 |

| 역량을 넘어: 의학교육의 전인적 관점을 향하여 (Med Educ, 2022) (0) | 2022.01.07 |

| 시스템 기반 의료 다시 생각하기: 졸업후교육의 구조적 역량, 건강 형평성, 사회적 책임(Acad Med, 2020) (0) | 2021.12.12 |

| 의학교육에서 학술연구경험에 대한 실재주의적 리뷰 (Med Educ, 2020) (0) | 2021.12.10 |